java基础02

java基础02

# MySQL高级主题-Java面试题

之前两篇文章带你了解了 MySQL 的基础语法和 MySQL 的进阶内容,那么这篇文章我们来了解一下 MySQL 中的高级内容。

事务控制和锁定语句

我们知道,MyISAM 和 MEMORY 存储引擎支持表级锁定(table-level locking),InnoDB 存储引擎支持行级锁定(row-level locking),BDB 存储引擎支持页级锁定(page-level locking)。各个锁定级别的特点如下

页级锁:销和加锁时间界于表锁和行锁之间;会出现死锁;锁定粒度界于表锁和行锁之间,并发度一般

表级锁:表级锁是对整张表进行加锁,MyISAM 和 MEMORY 主要支持表级锁,表级锁加锁快,不会出现死锁,锁的粒度比较粗,并发度最低

行级锁:行级锁可以说是 MySQL 中粒度最细的一种锁了,InnoDB 支持行级锁,行级锁容易发生死锁,并发度比较好,同时锁的开销也比较大。

MySQL 默认情况下支持表级锁定和行级锁定。但是在某些情况下需要手动控制事务以确保整个事务的完整性,下面我们就来探讨一下事务控制。但是在探讨事务控制之前我们先来认识一下两个锁定语句

锁定语句

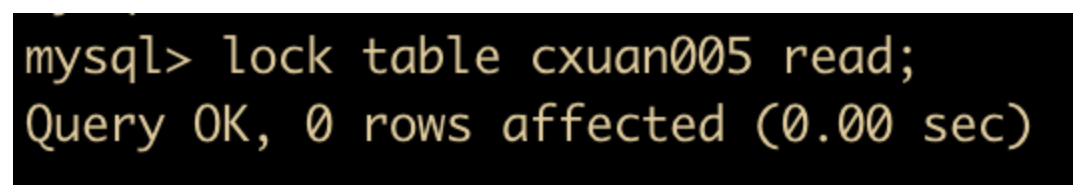

MySQL 的锁定语句主要有两个 Lock 和 unLock,Lock Tables 可用于锁定当前线程的表,就跟 Java 语法中的 Lock 锁的用法是一样的,如果表锁定,意味着其他线程不能再操作表,直到锁定被释放为止。如下图所示

lock table cxuan005 read;

我们锁定了 cxuan005 的 read 锁,然后这时我们再进行一次查询,看看是否能够执行这条语句

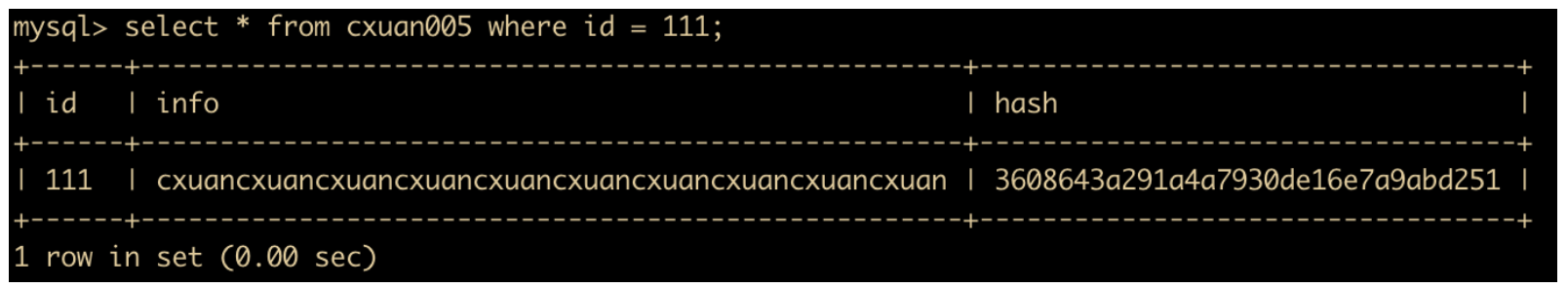

select * from cxuan005 where id = 111;

可以看到,在进行 read 锁定了,我们仍旧能够执行查询语句。

现在我们另外起一个窗口,相当于另起了一个线程来进行查询操作。

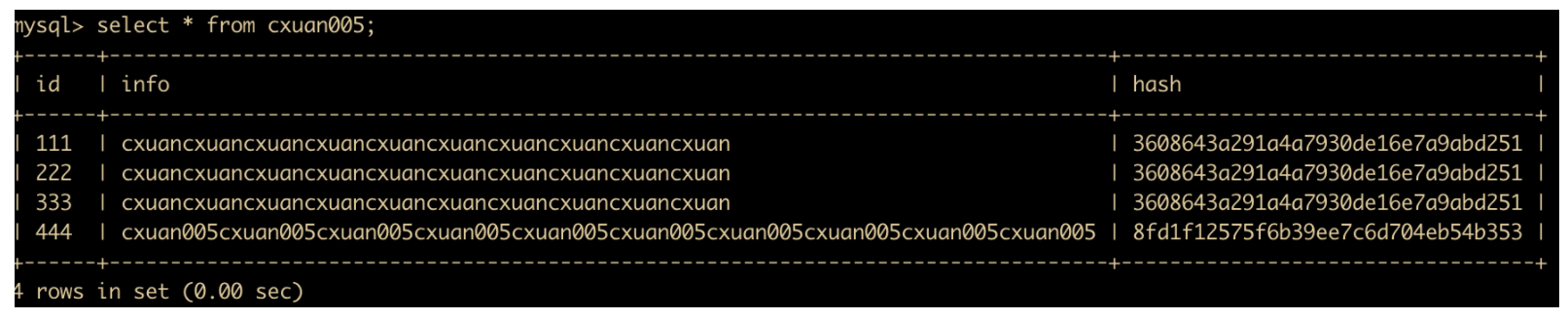

select * from cxuan005;

这是第二个窗口执行查询的结果,可以看到,在一个线程执行 read 锁定后,其他线程仍然可以进行表的查询操作。

那么第二个线程能否执行更新操作呢?我们来看一下

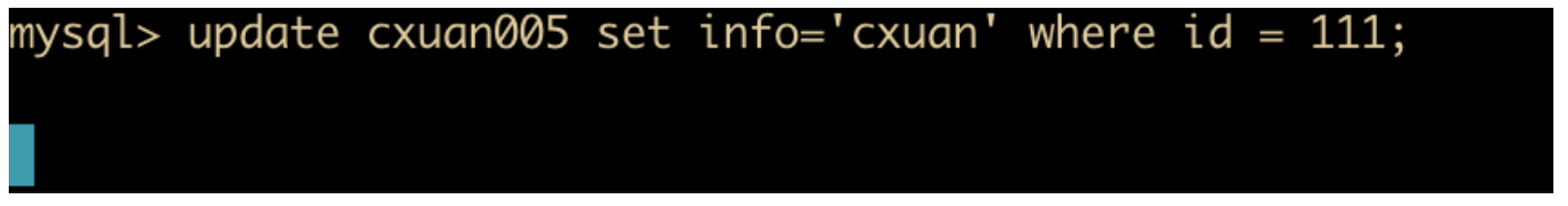

update cxuan005 set info='cxuan' where id = 111;

发生了什么?怎么没有提示结果呢?其实这个情况下表示 cxuan005 已经被加上了 read 锁,由于当前线程不是持有锁的线程,所以当前线程无法执行更新。

解锁语句

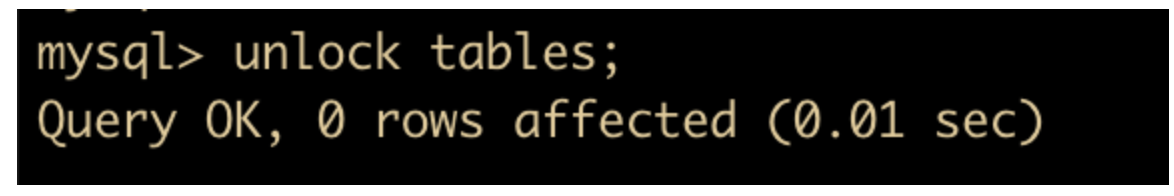

现在我们把窗口切换成持有 read 锁的线程,来进行 read 锁的解锁

unlock tables;

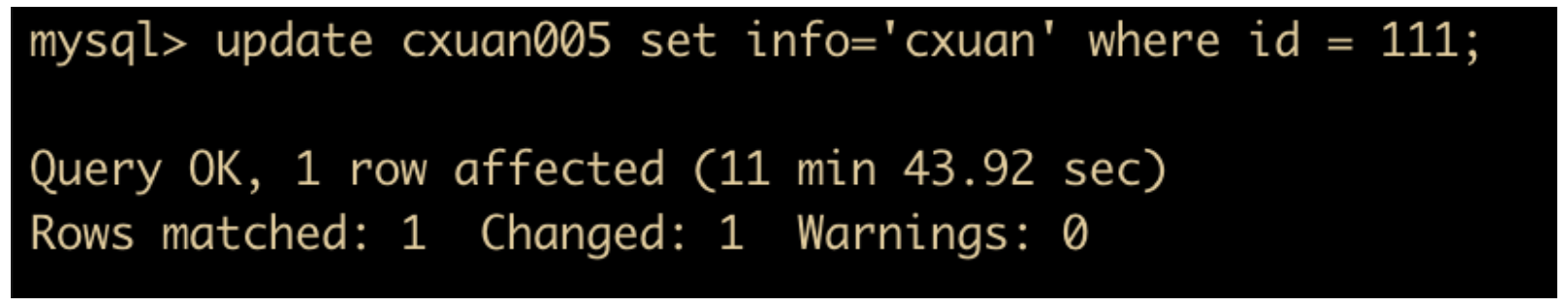

在解锁完成前,进行更新的线程会一直等待,直到解锁完成后,才会进行更新。我们可以看一下更新线程的结果。

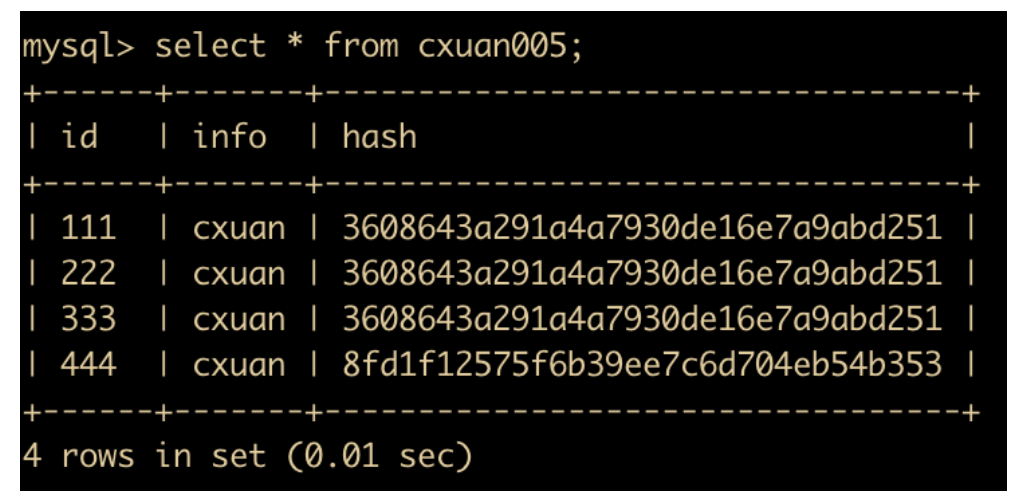

可以看到,线程已经更新完毕,我们看一下更新的结果

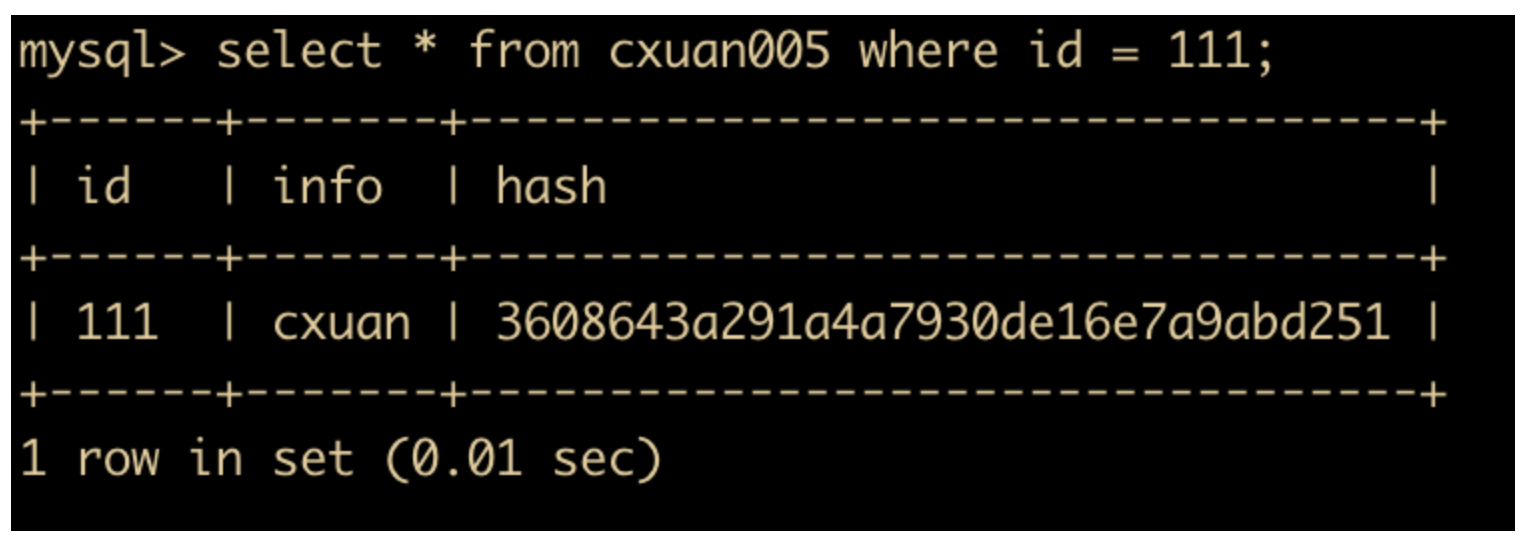

select * from cxuan005 where id = 111;

如上图所示,id = 111 的值已经被更新成了 cxuan。

事务控制

事务(Transaction) 是访问和更新数据库的基本执行单元,一个事务中可能会包含多个 SQL 语句,事务中的这些 SQL 语句要么都执行,要么都不执行,而 MySQL 它是一个关系型数据库,它自然也是支持事务的。事务同时也是区分关系型数据库和非关系型数据库的一个重要的方面。

在 MySQL 事务中,主要涉及的语法包含 SET AUTOCOMMIT、START TRANSACTION、COMMIT 和 ROLLBACK 等。

自动提交

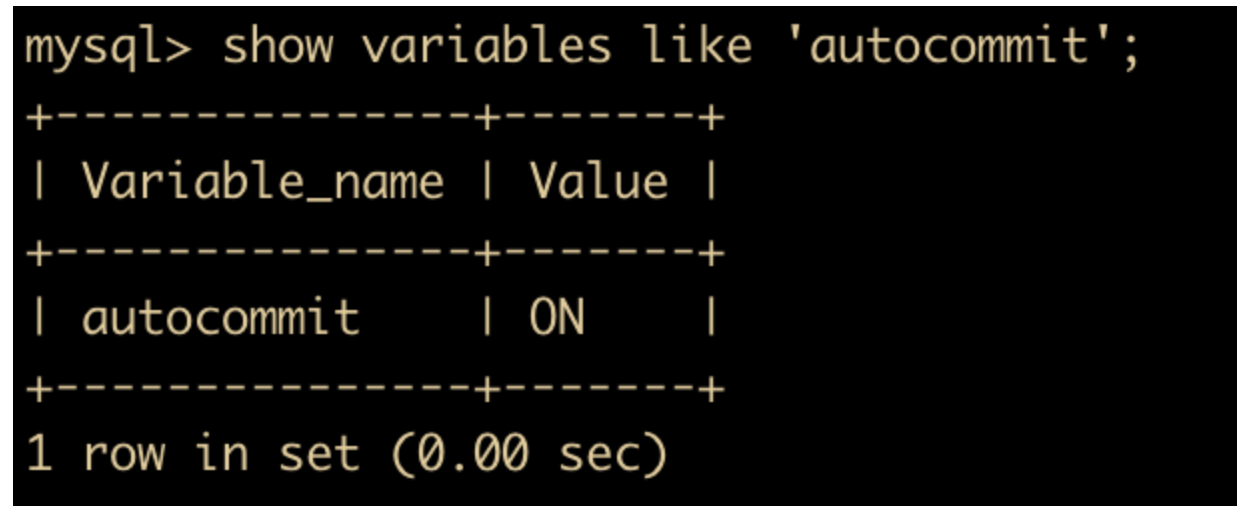

在 MySQL 中,事务默认是自动提交(Autocommit)的,如下所示

show variables like 'autocommit';

在自动提交的模式下,每个 SQL 语句都会当作一个事务执行提交操作,例如我们上面使用的更新语句

update cxuan005 set info='cxuan' where id = 111;

如果想要关闭数据库的自动提交应该怎么做呢?

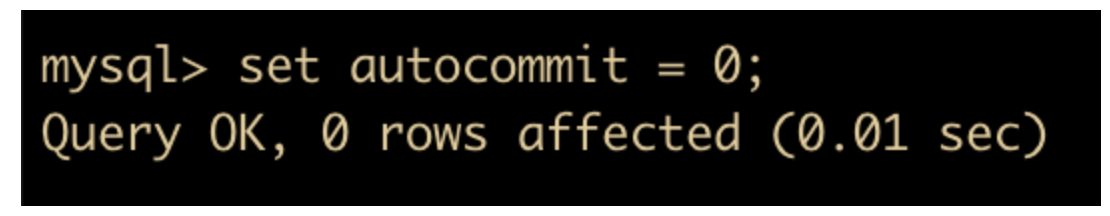

其实,MySQL 是可以关闭自动提交的,你可以执行

set autocommit = 0;

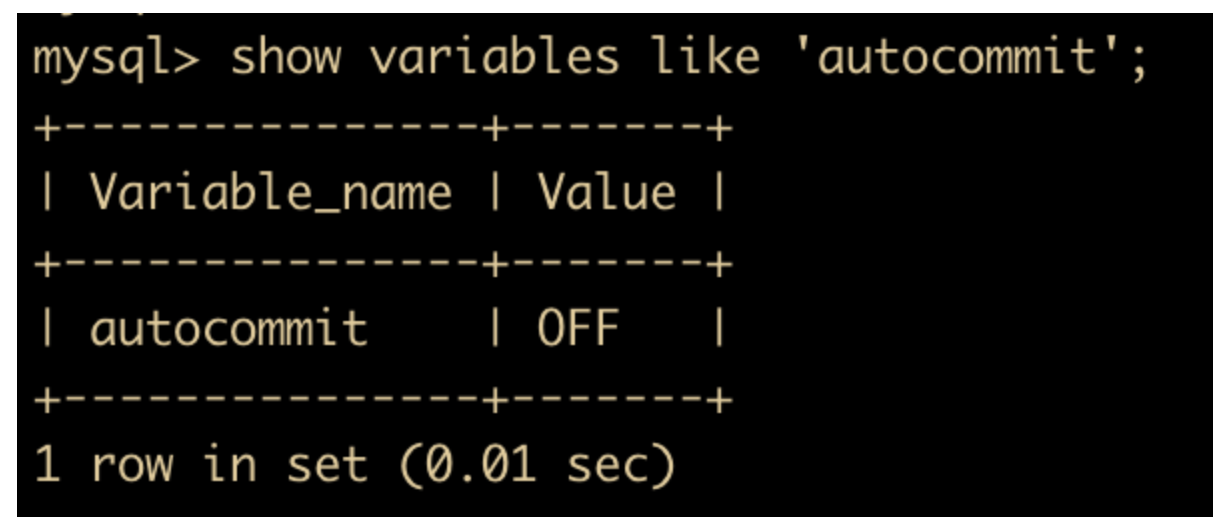

然后我们再看一下自动提交是否关闭了,再次执行一下 show variables like ‘autocommit’ 语句

可以看到,自动提交已经关闭了,再次执行

set autocommit = 1;

会再次开启自动提交。

这里注意一下特殊操作。

在 MySQL 中,存在一些特殊的命令,如果在事务中执行了这些命令,会马上强制执行 commit 提交事务;比如 DDL 语句(create table/drop table/alter/table)、lock tables 语句等等。

不过,常用的 select、insert、update 和 delete命令,都不会强制提交事务。

手动提交

如果需要手动 commit 和 rollback 的话,就需要明确的事务控制语句了。

典型的 MySQL 事务操作如下

start transaction; ... # 一条或者多条语句 commit;

上面代码中的 start transaction 就是事务的开始语句,编写 SQL 后会调用 commit 提交事务,然后将事务统一执行,如果 SQL 语句出现错误会自动调用 Rollback 进行回滚。

下面我们就通过示例来演示一下 MySQL 的事务,同样的,我们需要启动两个窗口来演示,为了便于区分,我们使用 mysql01 和 mysql02 来命名。

我们用 start transaction 命令启动一个事务,然后再 cxuan005 表中插入一条数据,此时 mysql02 不做任何操作。涉及的 SQL 语句如下。

start transaction;

然后执行

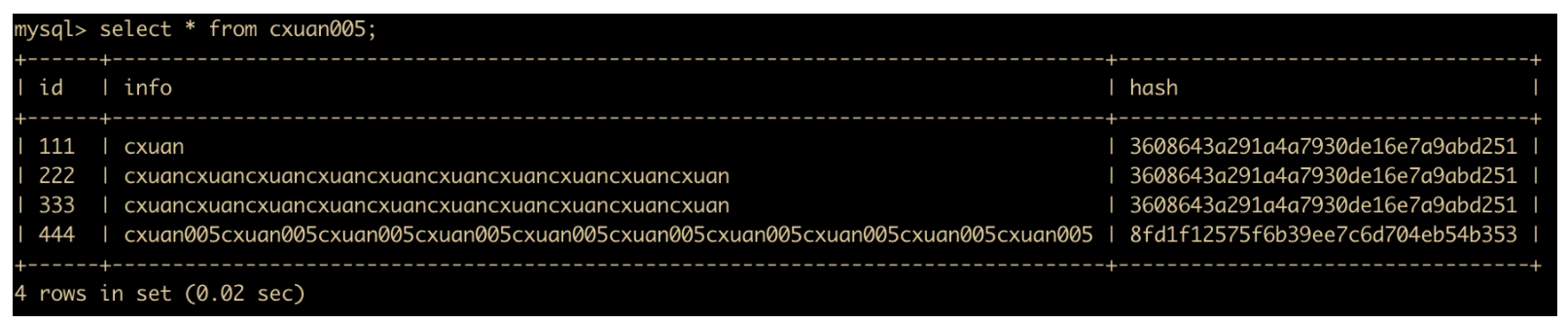

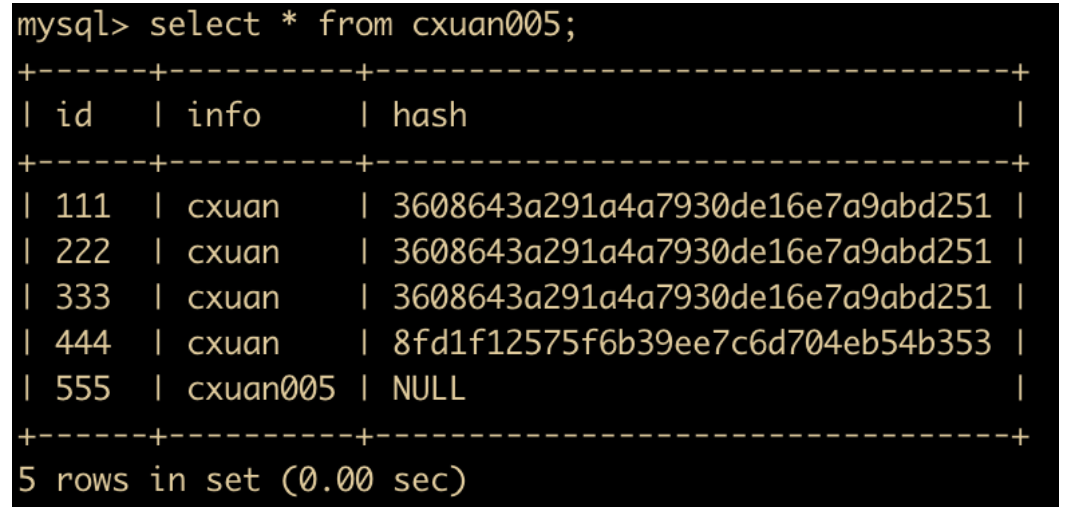

select * from cxuan005;

查询一下 cxuan005 中的数据

嗯。。。很多长度太长了,现在我们把所有的 info 数据都更新为 cxuan 。

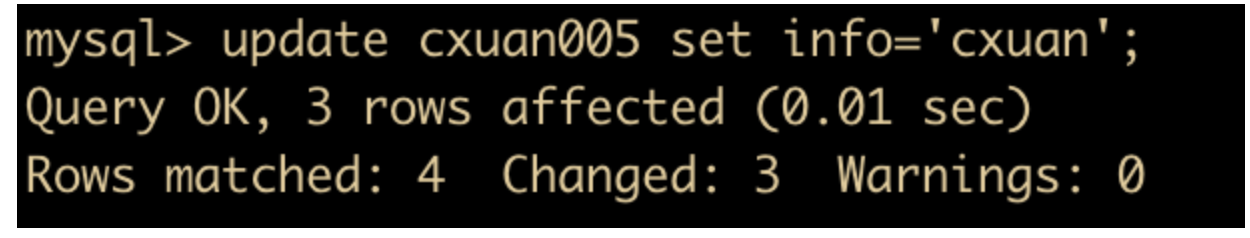

update cxuan005 set info='cxuan';

更新完毕后,我们先不提交事务,分别在 mysql01 和 mysql02 中进行查询,发现只有 mysql01 窗口中的查询已经生效,而 mysql02 中还是更新前的数据

现在我们在 mysql01 中 commit 当前事务,然后在 mysql02 中查询,发现数据已经被修改了。

除了 commit 之外,MySQL 中还有 commit and chain 命令,这个命令会提交当前事务并且重新开启一个新的事务。如下代码所示

start transaction; # 开启一个新的事务 insert into cxuan005(id,info) values (555,'cxuan005'); # 插入一条数据 commit and chain; # 提交当前事务并重新开启一个事务

上面是一个事务操作,在 commit and chain 键入后,我们可以再次执行 SQL 语句

update cxuan005 set info = 'cxuan' where id = 555; commit;

然后再次查询

select * from cxuan005;

执行后,可以发现,我们仅仅使用了一个 start transaction 命令就执行了两次事务操作。

如果在手动提交的事务中,你发现有一条 SQL 语句写的不正确或者有其他原因需要回滚,那么此时你就会用到 rollback 语句,它会回滚当前事务,相当于什么也没发生。如下代码所示。

start transaction; delete from cxuan005 where id = 555; rollback;

这里

切忌一点:delete 删除语句一定要加 where ,不加 where 语句的删除就是耍流氓。

在同一个事务操作中,最好使用相同存储引擎的表,如果使用不同存储引擎的表后,rollback 语句会对非事务类型的表进行特别处理,因此 commit 、rollback 只能对事务类型的表进行提交和回滚。

我们提交的事务一般都会被记录到二进制的日志中,但是如果一个事务中包含非事务类型的表,那么回滚操作也会被记录到二进制日志中,以确保非事务类型的表可以被复制到从数据库中。

这里解释一下什么是事务表和非事务表

事务表和非事务表

事务表故名思义就是支持事务的表,支不支持事务和 MySQL 的存储类型有关,一般情况下,InnoDB 存储引擎的表是支持事务的,关于 InnoDB 的知识,我们会在后面详细介绍。

非事务表相应的就是不支持事务的表,在 MySQL 中,存储引擎 MyISAM 是不支持事务的,非事务表的特点是不支持回滚。

对于回滚的话,还要讲一点就是 SAVEPOINT,它能指定事务回滚的一部分,但是不能指定事务提交的一部分。 SAVEPOINT 可以指定多个,在满足不同条件的同时,回滚不同的 SAVEPOINT。需要注意的是,如果定义了两个相同名称的 SAVEPOINT,则后面定义的 SAVEPOINT 会覆盖之前的定义。如果 SAVEPOINT 不再需要的话,可以通过 RELEASE SAVEPOINT 来进行删除。删除后的 SAVEPOINT 不能再执行 ROLLBACK TO SAVEPOINT 命令。

我们通过一个示例来进行模拟不同的 SAVEPOINT

首先先启动一个事务 ,向 cxuan005 中插入一条数据,然后进行查询,那么是可以查询到这条记录的

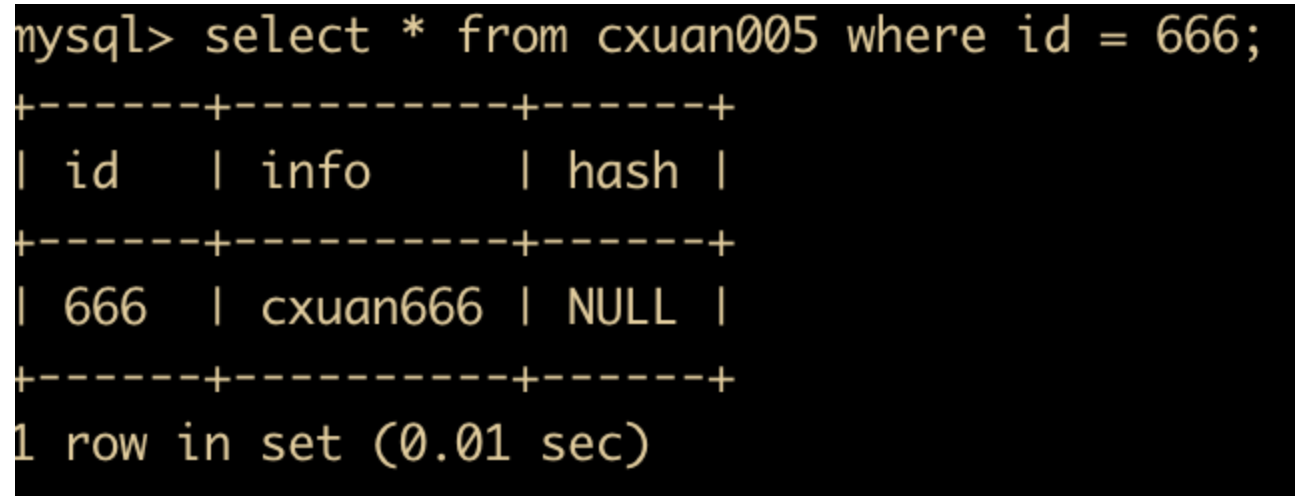

start transaction; insert into cxuan005(id,info) values(666,'cxuan666'); select * from cxuan005 where id = 666;

查询之后的记录如下

然后我们定义一个 SAVEPOINT,如下所示

savepoint test;

然后继续插入一条记录

insert into cxuan005(id,info) values(777,'cxuan777');

此时就可以查询到两条新增记录了,id 是 666 和 777 的记录。

select * from cxuan005 where id = 777;

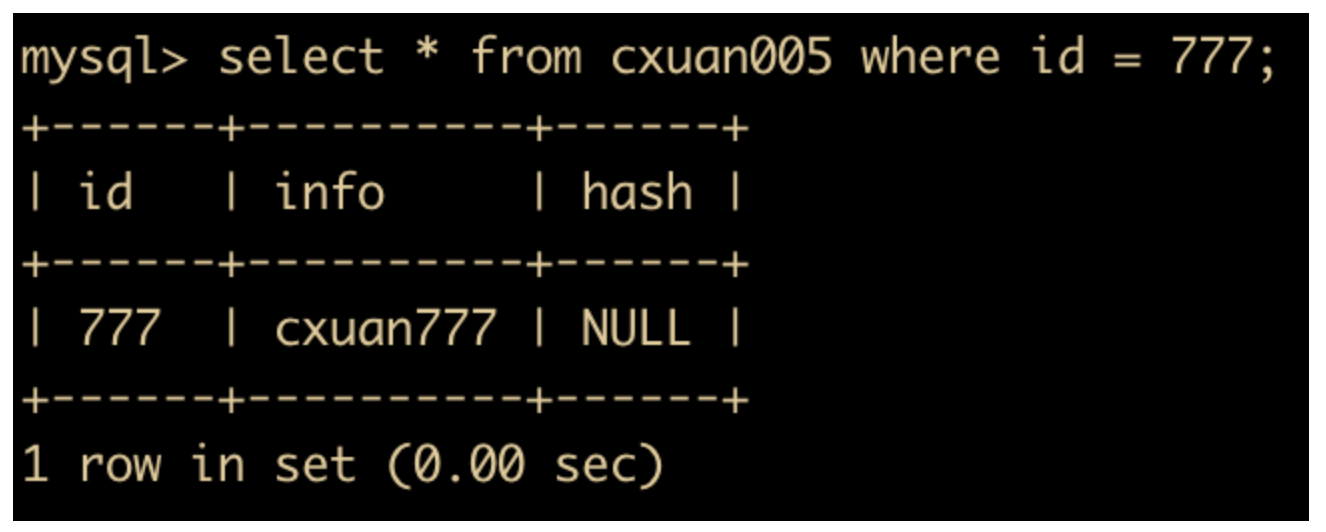

那么我们可以回滚到刚刚定义的 SAVEPOINT

rollback to savepoint test;

再次查询 cxuan005 这个表,可以看到,只有 id=666 的这条记录插入进来了,说明 id=777 这条记录已经被回滚了。

此时我们看到的都是 mysql01 中事务还没有提交前的状态,所以这时候 mysql02 中执行查询操作是看不到 666 这条记录的。

然后我们在 mysql01 中执行 commit 操作,那么此时在 mysql02 中就可以查询到这条记录了。

SQL 安全问题

SQL 安全问题应该是我们程序员比较忽视的一个地方了。日常开发中,我们一般只会关心 SQL 能不能解决我们的业务问题,能不能把数据查出来,而对于 SQL 问题,我们一般都认为这是 DBA 的活,其实我们 CRUD 程序员也应该了解一下 SQL 的安全问题。

SQL 注入简介

SQL 注入就是利用某些数据库的外部接口将用户数据插入到实际的 SQL 中,从而达到入侵数据库的目的。SQL 注入是一种常见的网络攻击的方式,它不是利用操作系统的 BUG 来实现攻击的。SQL 主要是针对程序员编写时的疏忽来入侵的。

SQL 注入攻击有很大的危害,攻击者可以利用它读取、修改或者删除数据库内的数据,获取数据库中的用户名和密码,甚至获得数据库管理员的权限。并且 SQL 注入一般比较难以防范。

SQL Mode

MySQL 可以运行在不同的 SQL Mode 模式下,不同的 SQL Mode 定义了不同的 SQL 语法,数据校验规则,这样就能够在不同的环境中使用 MySQL ,下面我们就来介绍一下 SQL Mode。

SQL Mode 解决问题

SQL Mode 可以解决下面这几种问题

- 通过设置 SQL Mode,可以完成不同严格程度的数据校验,有效保障数据的准确性。

- 设置 SQL Mode 为

ANSI模式,来保证大多数 SQL 符合标准的 SQL 语法,这样应用在不同数据库的迁移中,不需要对 SQL 进行较大的改变 - 数据在不同数据库的迁移中,通过改变 SQL Mode 能够更方便的进行迁移。

下面我们就通过示例来演示一下 SQL Mode 用法

我们可以通过

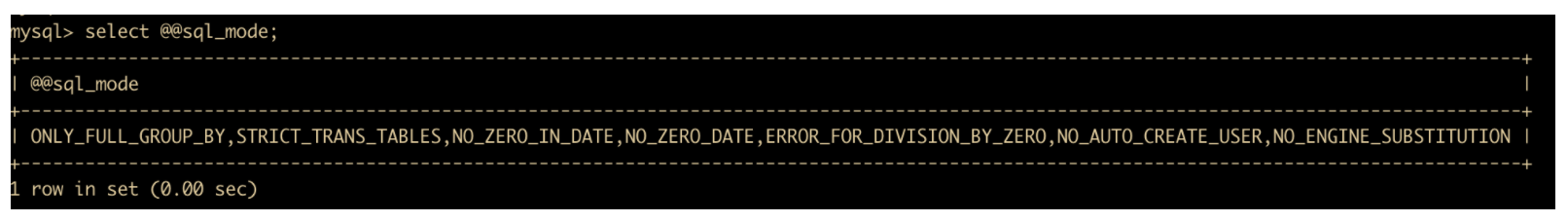

select @@sql_mode;

来查看默认的 SQL Mode,如下是我的数据库所支持的 SQL Mode

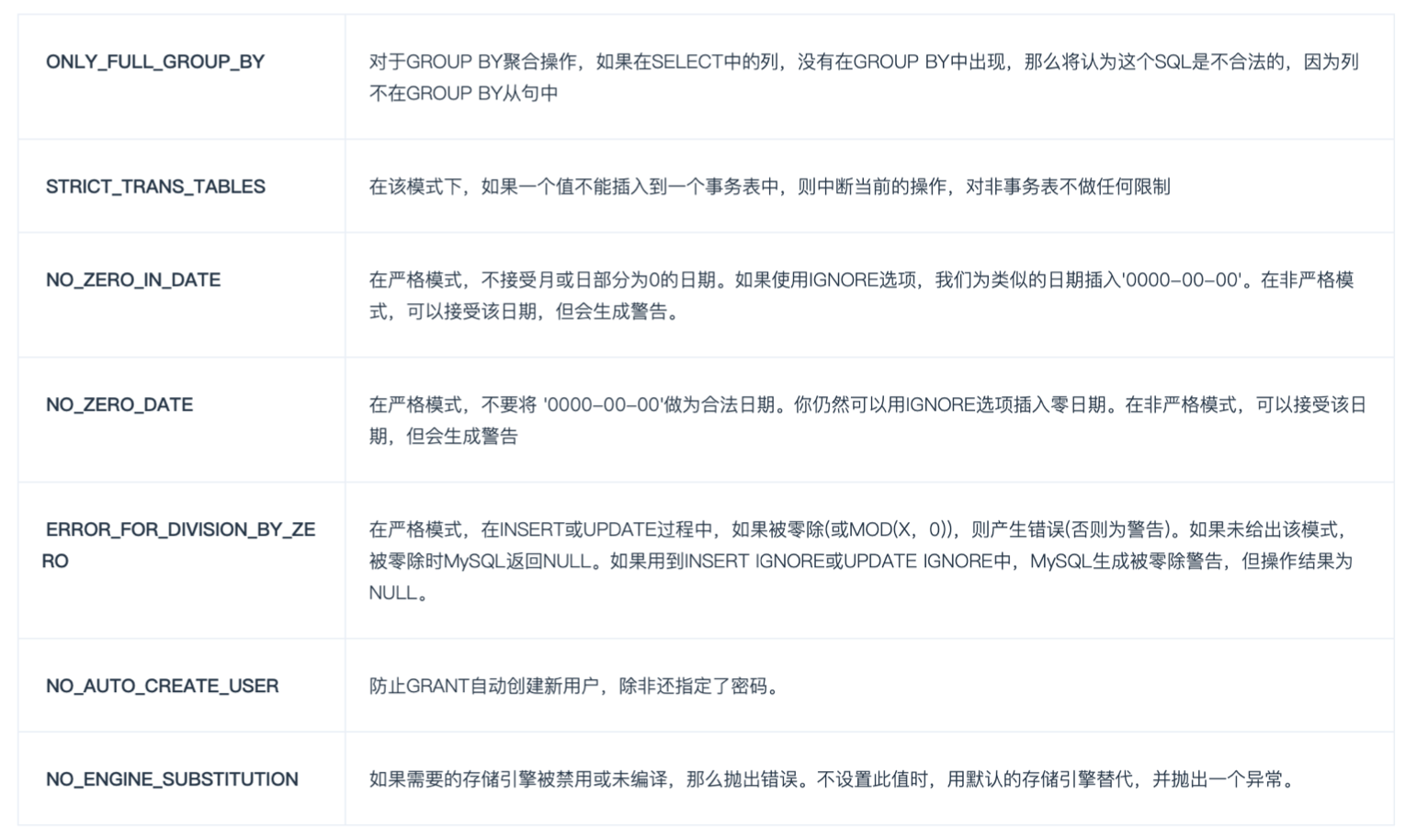

涉及到很多 SQL Mode,下面是这些 SQL Mode 的解释

ONLY_FULL_GROUP_BY:这个模式会对 GROUP BY 进行合法性检查,对于 GROUP BY 操作,如果在SELECT 中的列,没有在 GROUP BY 中出现,那么将认为这个 SQL 是不合法的,因为列不在 GROUP BY 从句中

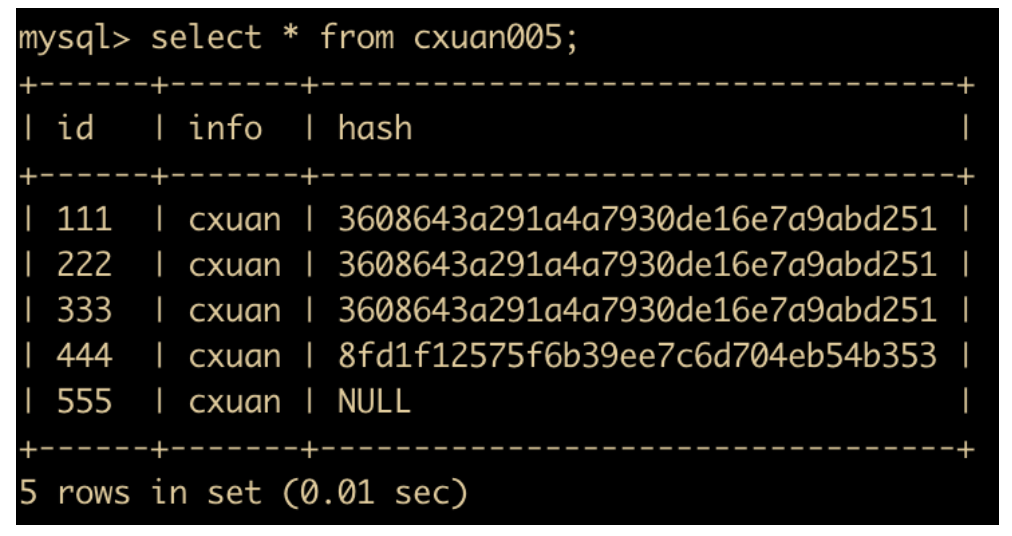

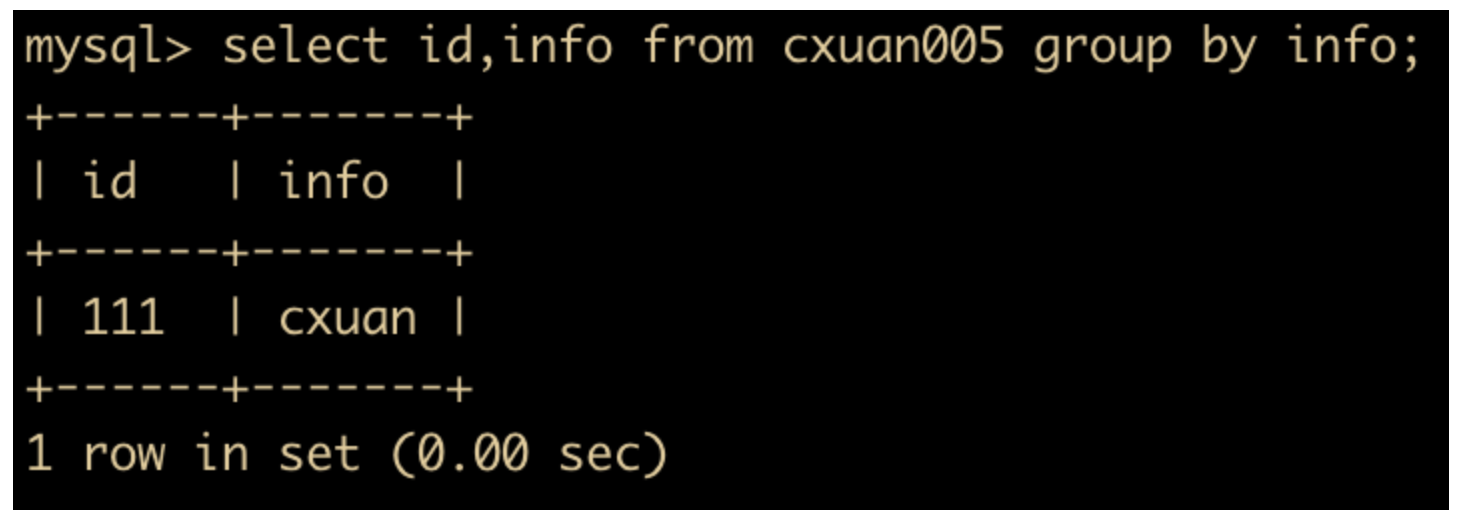

同样举个例子,我们现在查询一下 cxuan005 的 id 和 info 字段。

select id,info from cxuan005;

这样是可以运行的

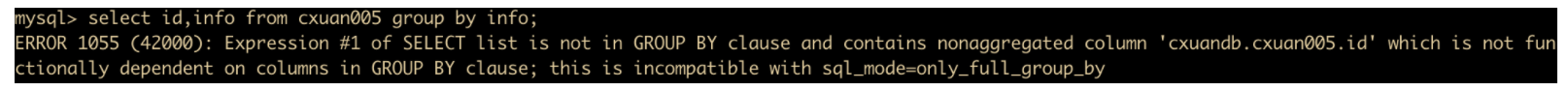

然后我们使用 GROUP BY 字句进行分组,这里只对 info 进行分组,我们看一下会出现什么情况

select id,info from cxuan005 group by info;

我们可以从错误原因中看到,这条 SQL 语句是不符合 ONLY_FULL_GROUP_BY 的这条 SQL Mode 的。因为我们只对 info 进行分组了,没有对 id 进行分组,我们把 SQL 语句改成如下形式

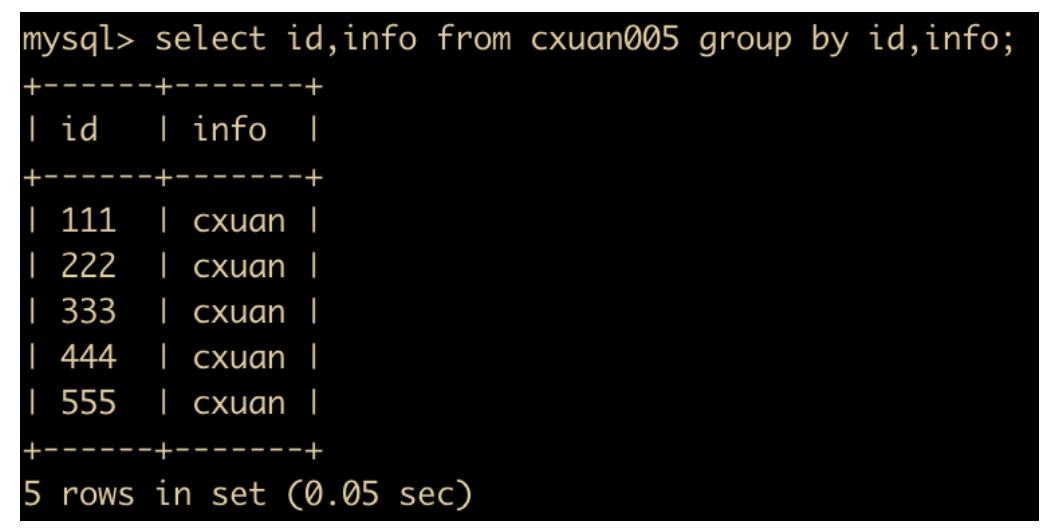

select id,info from cxuan005 group by id,info;

这样 SQL 就能正确执行了。

当然,我们也可以删除 sql_mode = ONLY_FULL_GROUP_BY 的这条 Mode,可以使用

SET sql_mode=(SELECT REPLACE(@@sql_mode,'ONLY_FULL_GROUP_BY',''));

来进行删除,删除后我们使用分组语句就可以放飞自我了。

select id,info from cxuan005 group by info;

但是这种做法只是暂时的修改,我们可以修改配置文件 my.ini 中的 sql_mode= STRICT_TRANS_TABLES,NO_ZERO_IN_DATE,NO_ZERO_DATE,ERROR_FOR_DIVISION_BY_ZERO,NO_AUTO_CREATE_USER,NO_ENGINE_SUBSTITUTION

STRICT_TRANS_TABLES:这就是严格模式,在这个模式下会对数据进行严格的校验,错误数据不能插入,报error 错误。如果不能将给定的值插入到事务表中,则放弃该语句。对于非事务表,如果值出现在单行语句或多行语句的第1行,则放弃该语句。

当使用 innodb 存储引擎表时,考虑使用 innodb_strict_mode 模式的 sql_mode,它能增量额外的错误检测功能。

NO_ZERO_IN_DATE:这个模式影响着日期中的月份和天数是否可以为 0(注意年份是非 0 的),这个模式也取决于严格模式是否被启用。如果这个模式未启用,那么日期中的零部分被允许并且插入没有警告。如果这个模式启用,那么日期中的零部分插入被作为 0000-00-00 并且产生一个警告。

这个模式需要注意下,如果启用的话,需要 STRICT_TRANS_TABLES 和 NO_ZERO_IN_DATE 同时启用,否则不起作用,也就是

set session sql_mode='STRICT_TRANS_TABLES,NO_ZERO_IN_DATE';

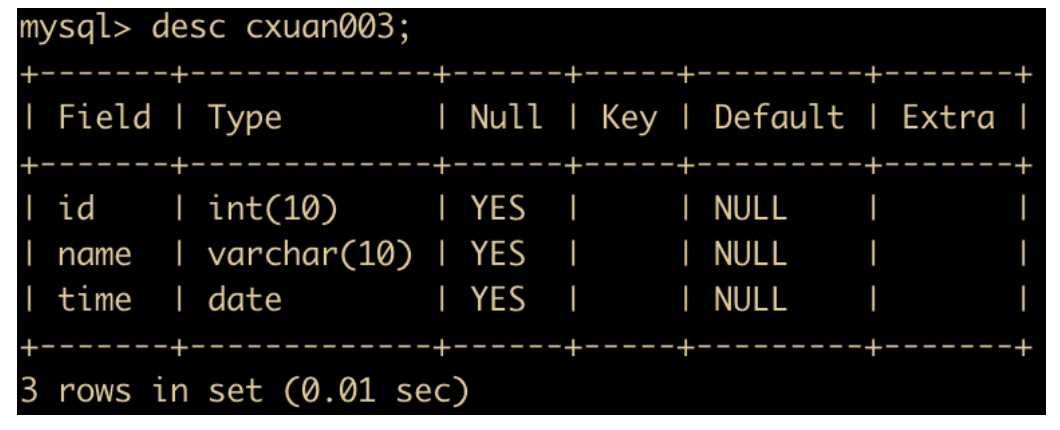

然后我们换表了,使用 cxuan003 这张表,表结构如下

我们主要测试日期的使用,在 cxuan003 中插入一条日期为 0000-00-00 的数据

insert into cxuan003 values(111,'study','0000-00-00');

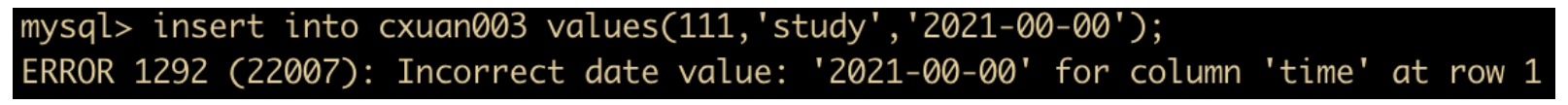

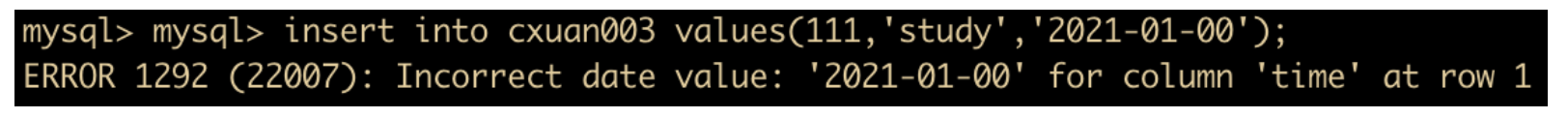

发现能够执行成功,但是把年月日各自变为 0 之后再进行插入,则会插入失败。

insert into cxuan003 values(111,'study','2021-00-00');

insert into cxuan003 values(111,'study','2021-01-00');

这些组合有很多,我这里就不再细致演示了,读者可以自行测试。

如果要插入 0000-00-00 这样的数据,必须设置 NO_ZERO_IN_DATE 和 NO_ZERO_DATE。

ERROR_FOR_DIVISION_BY_ZERO:如果这个模式未启用,那么零除操作将会插入空值并且不会产生警告;如果这个模式启用,零除操作插入空值并产生警告;如果这个模式和严格模式都启用,零除从操作将会产生一个错误。

NO_AUTO_CREATE_USER:禁止使用 grant 语句自动创建用户,除非认证信息被指定。

NO_ENGINE_SUBSTITUTION:此模式指定当执行 create 语句或者 alter 语句指定的存储引擎没有启用或者没有编译时,控制默认存储引擎的自动切换。默认是启用状态的。

SQL Mode 三种作用域

SQL Mode 按作用区域和时间可分为 3。个级别,分别是会话级别,全局级别,配置(永久生效)级别。

我们上面使用的 SQL Mode 都是 会话级别,会话级别就是当前窗口域有效。它的设置方式是

set @@session.sql_mode='xx_mode' set session sql_mode='xx_mode'

全局域就是当前会话关闭不失效,但是在 MySQL 重启后失效。它的设置方式是

set global sql_mode='xx_mode'; set @@global.sql_mode='xx_mode';

配置域就是在 vi /etc/my.cnf 里面添加

[mysqld] sql-mode = "xx_mode"

配置域在保存退出后,重启服务器,即可永久生效。

SQL 正则表达式

正则表达式相信大家应该都用过,不过你在 MySQL 中用过正则表达式吗?下面我们就来聊一聊 SQL 中的正则表达式。

正则表达式(Regular Expression) 是指一个用来描述或者匹配字符串的句法规则。正则表达式通常用来检索和替换某个文本中的文本内容。很多语言都支持正则表达式,MySQL 同样也不例外,MySQL 利用 REGEXP 命令提供给用户扩展的正则表达式功能。下面是 MySQL 中正则表达式的一些规则。

下面来演示一下正则表达式的用法

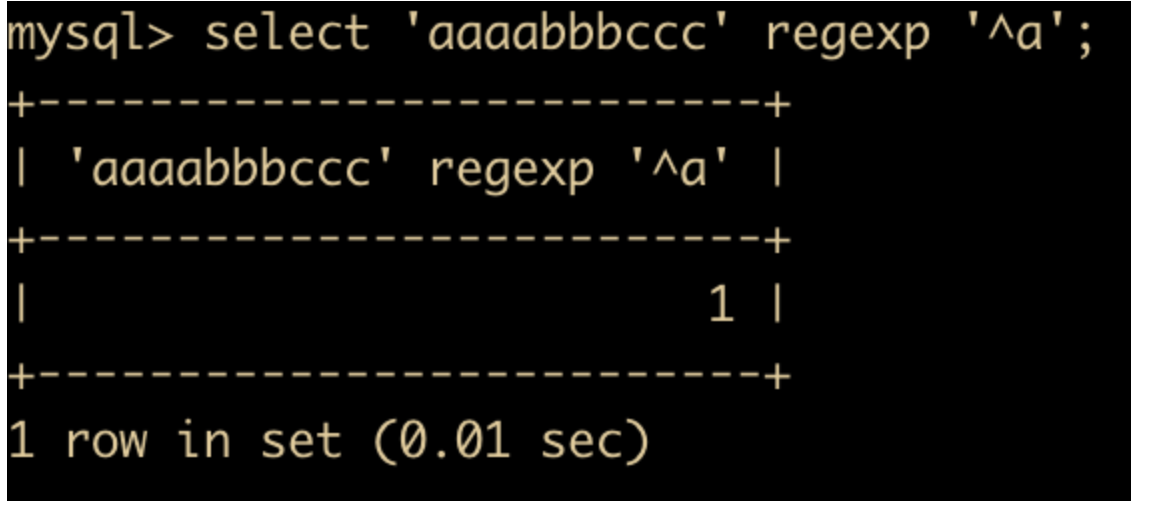

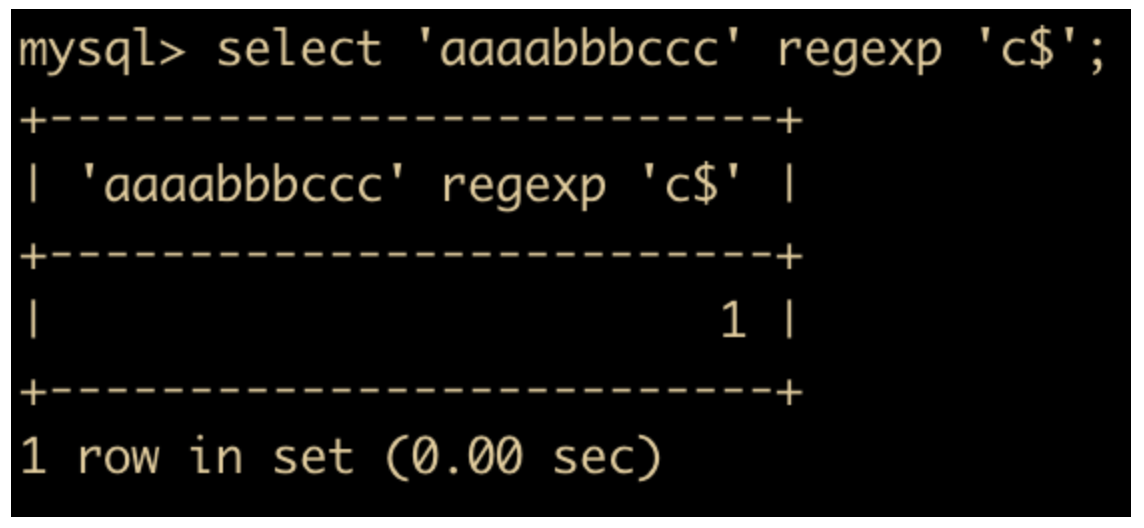

^在字符串的开始进行匹配,根据返回的结果来判断是否匹配,1 = 匹配,0 = 不匹配。下面尝试匹配字符串aaaabbbccc是否以字符串a为开始select 'aaaabbbccc' regexp '^a';

同样的,

$会在末尾处进行匹配,如下所示select 'aaaabbbccc' regexp 'c$';

.匹配单个任意字符select 'berska' regexp '.s', 'zara' regexp '.a';

[...]表示匹配括号内的任意字符,示例如下select 'whosyourdaddy' regexp '[abc]';

[^...]匹配括号内不包含的任意字符,和[...]是相反的,如果有任何匹配不上,返回 0 ,全部匹配上返回 1。select 'x' regexp '[^xyz]';

n*表示匹配零个或者多个 n 字符串,如下select 'aabbcc' regexp 'd*';

没有 d 出现也可以返回 1 ,因为 * 表示 0 或者多个。

n+表示匹配 1 个或者 n 个字符串select 'aabbcc' regexp 'd+';

n?的用法和 n+ 类似,只不过 n? 可以匹配空串

常见 SQL 技巧

RAND() 函数

大多数数据库都会提供产生随机数的函数,通过这些函数可以产生随机数,也可以使用从数据库表中抽取随机产生的记录,这对统计分析来说很有用。

在 MySQL 中,通常使用 RAND() 函数来产生随机数。RAND() 和 ORDER BY 组合完成数据抽取功能,如下所示。

我们新建一张表用于数据检索。

CREATE TABLE `clerk_Info` ( `id` int(11) NOT NULL, `name` varchar(255) DEFAULT NULL, `salary` decimal(10,2) DEFAULT NULL, `companyId` int(10) DEFAULT NULL, PRIMARY KEY (`id`) ) ENGINE=InnoDB DEFAULT CHARSET=latin1

然后插入一些数据,插入完成后的数据如下。

然后我们可以使用 RAND() 函数进行随机检索数据行

select * from clerk_info order by rand();

检索完成后的数据如下

多次查询后发现每次检索的数据顺序都是随机的。

这个函数多用于随机抽样,比如选取一定数量的样本在进行随机排序,需要用到 limit 关键字。

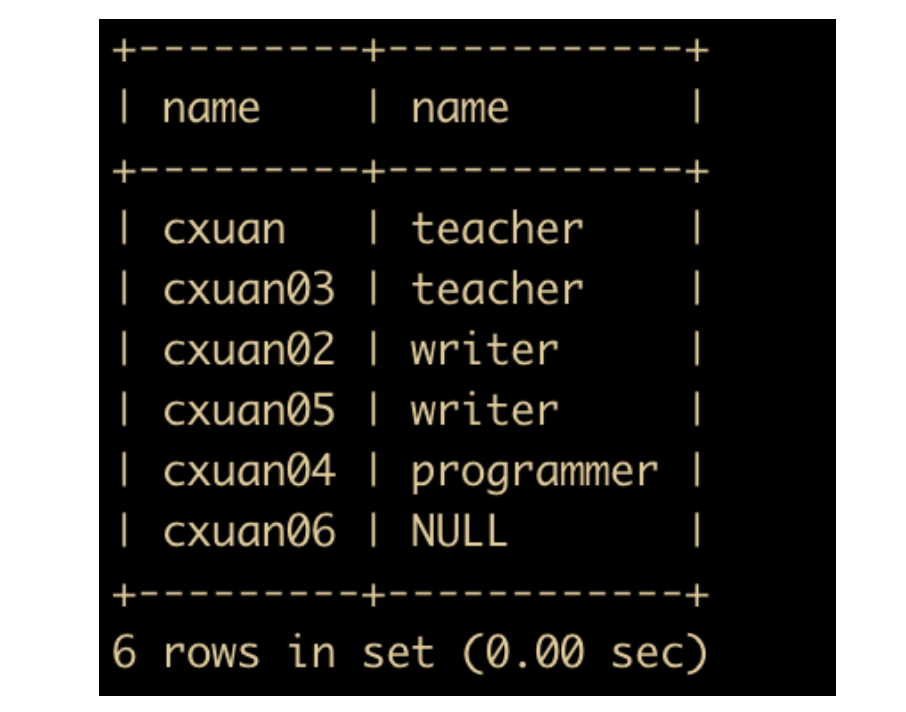

GROUP BY + WITH ROLLUP

我们经常使用 GROUP BY 语句,但是你用过 GROUP BY 和 WITH ROLLUP 一起使用的吗?使用 GROUP BY 和 WITH ROLLUP 字句可以检索出更多的分组集合信息。

我们仍旧对 clerk_info 表进行操作,我们对 name 和 salary 进行分组统计工资总数。

select name,sum(salary) from clerk_info group by name with rollup;

可以看到上面的表按照 name 进行分组,然后再对 money 进行统计。

也就是说 GROUP BY 语句执行完成后可以满足用户想要的任何一个分组以及分组组合的聚合信息值。

这里需要注意一点,不能同时使用 ORDER BY 字句对结果进行排序,ROLLUP 和 ORDER BY 是互斥的。

数据库名、表名大小写问题

在 MySQL 中,数据库中的每个表至少对应数据库目录中的一个文件,当然这取决于存储引擎的实现了。不同的操作系统对大小写的敏感性决定了数据库和表名的大小写的敏感性。在 UNIX 操作系统中是对大小写敏感的,因此数据库名和表名也是具有敏感性的,而到了 Windows 则不存在敏感性问题,因为 Windows 操作系统本身对大小写不敏感。列、索引、触发器在任何平台上都对大小写不敏感。

在 MySQL 中,数据库名和表名是由 lower_case_tables_name 系统变量决定的。可以在启动 mysqld 时设置这个系统变量。下面是 lower_case_tables_name 的值。

如果只在一个平台上使用 MySQL 的话,通常不需要修改 lower_case_tables_name 变量。如果想要在不同系统系统之间迁移表就会涉及到大小写问题,因为 UNIX 中 clerk_info 和 CLERK_INFO 被认为是两个不同的表,而 Windows 中则认为是一个。在 UNIX 中使用 lower_case_tables_name=0, 而在 Windows 中使用lower_case_tables_name=2,这样可以保留数据库名和表名的大小写,但是不能保证所有的 SQL 查询中使用的表名和数据库名的大小写相同。如果 SQL 语句中没有正确引用数据库名和表名的大小写,那么虽然在 Windows 中能正确执行,但是如果将查询转移到 UNIX 中,大小写不正确,将会导致查询失败。

外键问题

这里需要注意一个问题,InnoDB 存储引擎是支持外键的,而 MyISAM 存储引擎是不支持外键的,因此在 MyISAM 中设置外键会不起作用。

MySQL 常用函数

下面我们来了解一下 MySQL 函数,MySQL 函数也是我们日常开发过程中经常使用的,选用合适的函数能够提高我们的开发效率,下面我们就来一起认识一下这些函数

字符串函数

字符串函数是最常用的一种函数了,MySQL 也是支持很多种字符串函数,下面是 MySQL 支持的字符串函数表

| 函数 | 功能 |

|---|---|

| LOWER | 将字符串所有字符变为小写 |

| UPPER | 将字符串所有字符变为大写 |

| CONCAT | 进行字符串拼接 |

| LEFT | 返回字符串最左边的字符 |

| RIGHT | 返回字符串最右边的字符 |

| INSERT | 字符串替换 |

| LTRIM | 去掉字符串左边的空格 |

| RTRIM | 去掉字符串右边的空格 |

| REPEAT | 返回重复的结果 |

| TRIM | 去掉字符串行尾和行头的空格 |

| SUBSTRING | 返回指定的字符串 |

| LPAD | 用字符串对最左边进行填充 |

| RPAD | 用字符串对最右边进行填充 |

| STRCMP | 比较字符串 s1 和 s2 |

| REPLACE | 进行字符串替换 |

下面通过具体的示例演示一下每个函数的用法

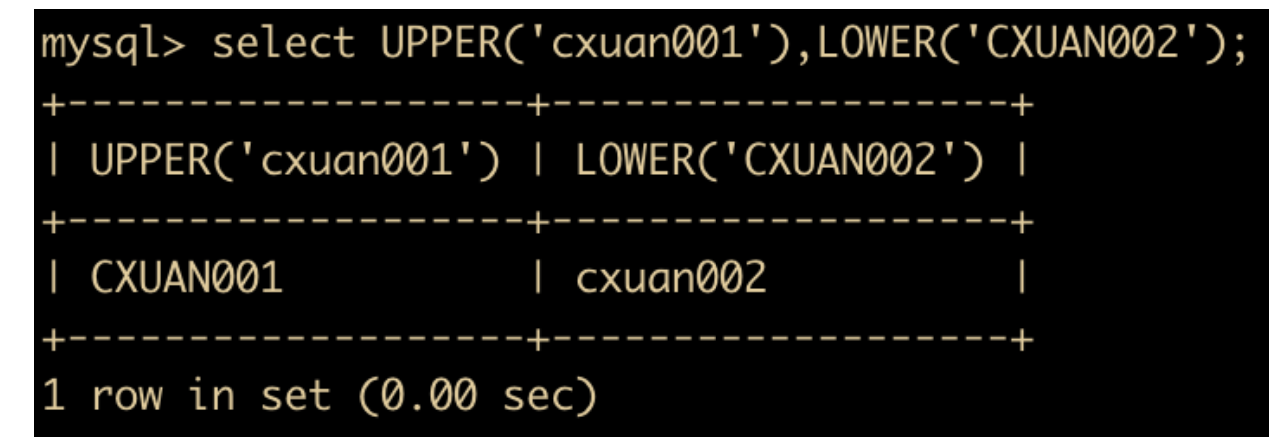

- LOWER(str) 和 UPPER(str) 函数:用于转换大小写

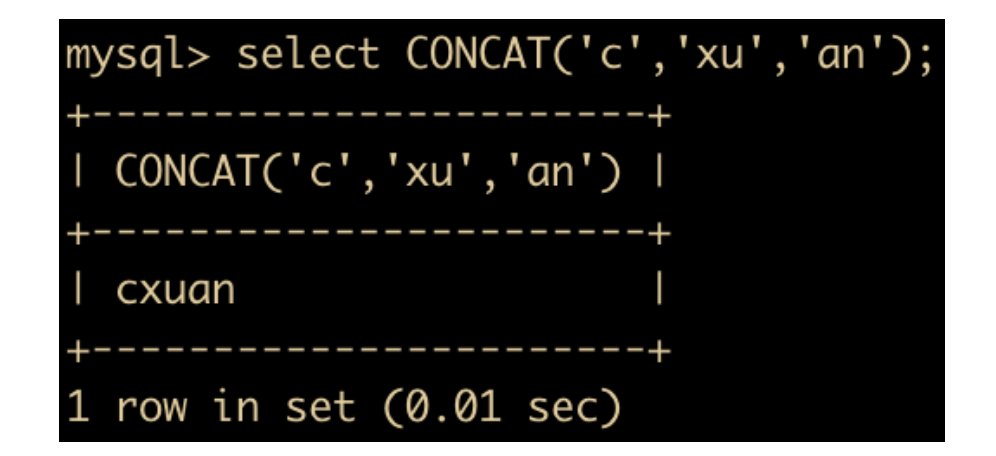

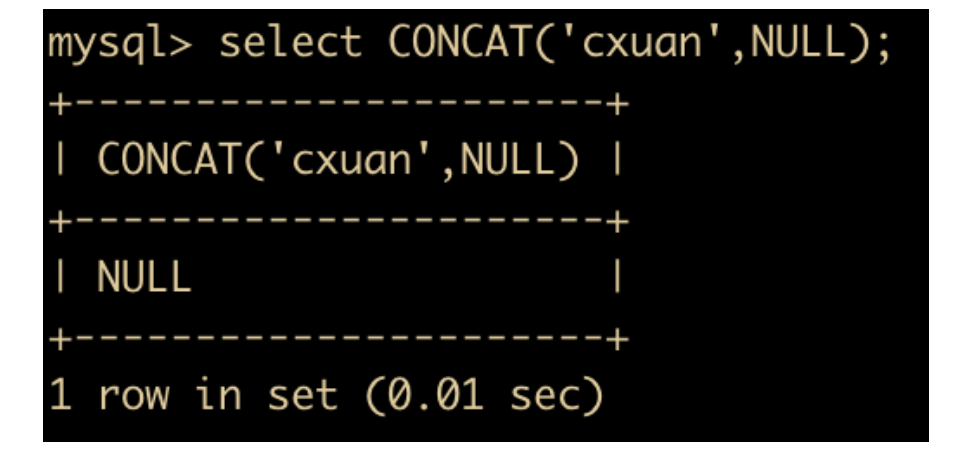

- CONCAT(s1,s2 … sn) :把传入的参数拼接成一个字符串

上面把 c xu an 拼接成为了一个字符串,另外需要注意一点,任何和 NULL 进行字符串拼接的结果都是 NULL。

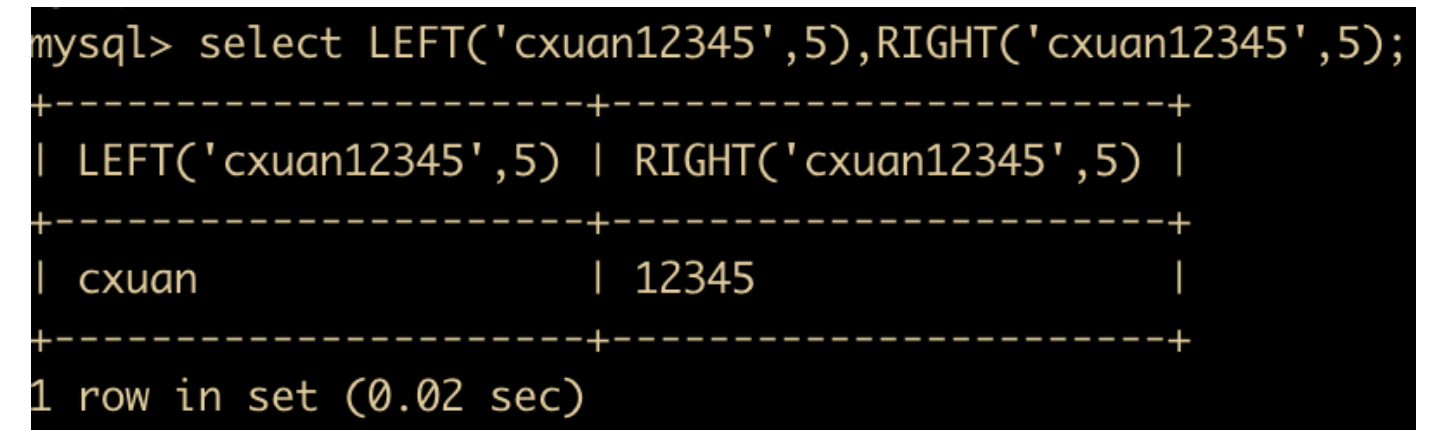

- LEFT(str,x) 和 RIGHT(str,x) 函数:分别返回字符串最左边的 x 个字符和最右边的 x 个字符。如果第二个参数是 NULL,那么将不会返回任何字符串

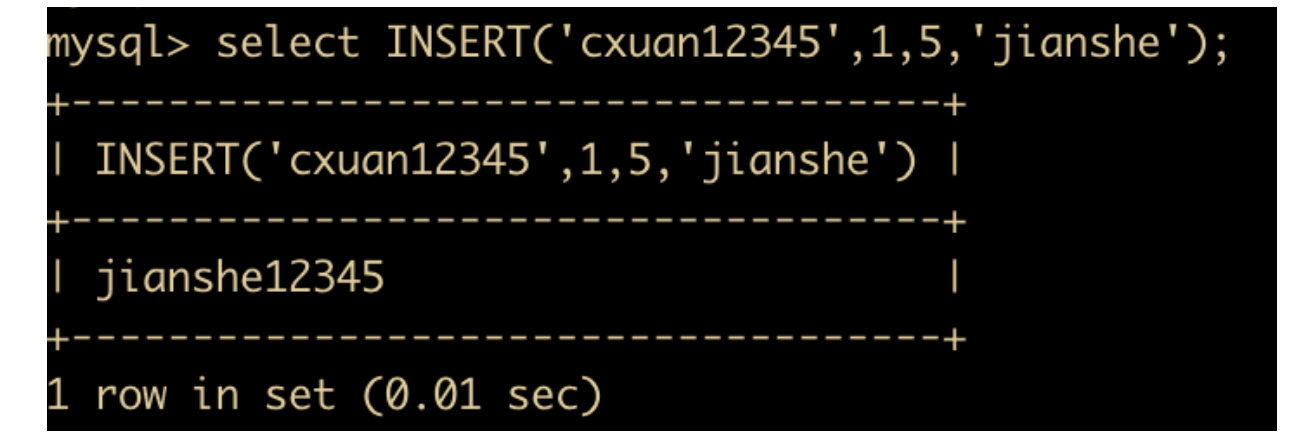

- INSERT(str,x,y,instr) : 将字符串 str 从指定 x 的位置开始, 取 y 个长度的字串替换为 instr。

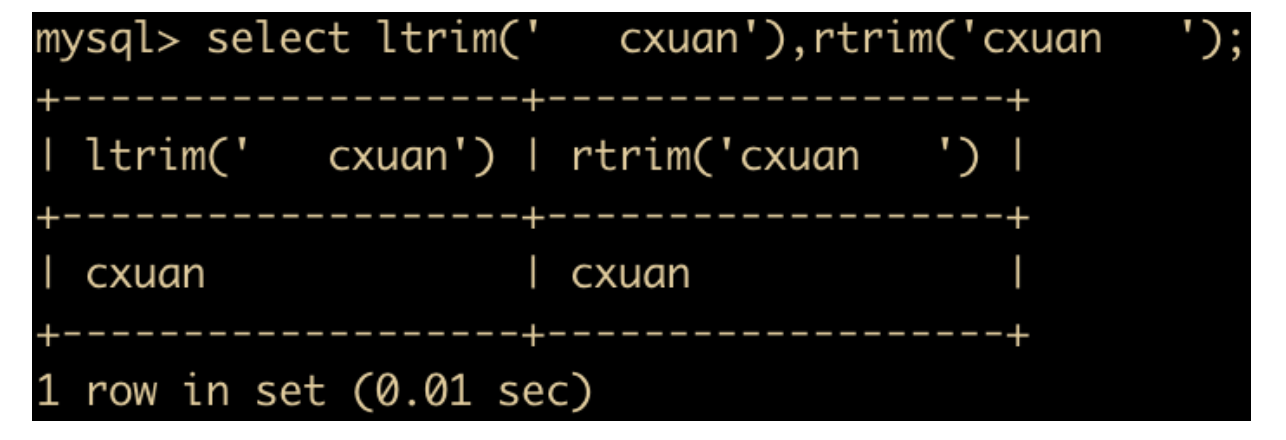

- LTRIM(str) 和 RTRIM(str) 分别表示去掉字符串 str 左侧和右侧的空格

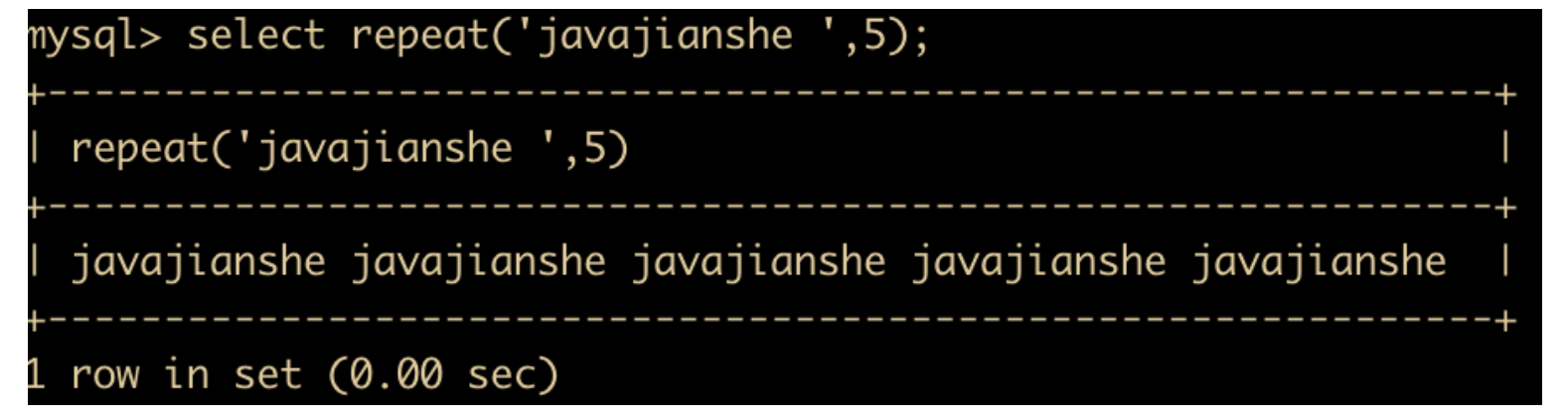

- REPEAT(str,x) 函数:返回 str 重复 x 次的结果

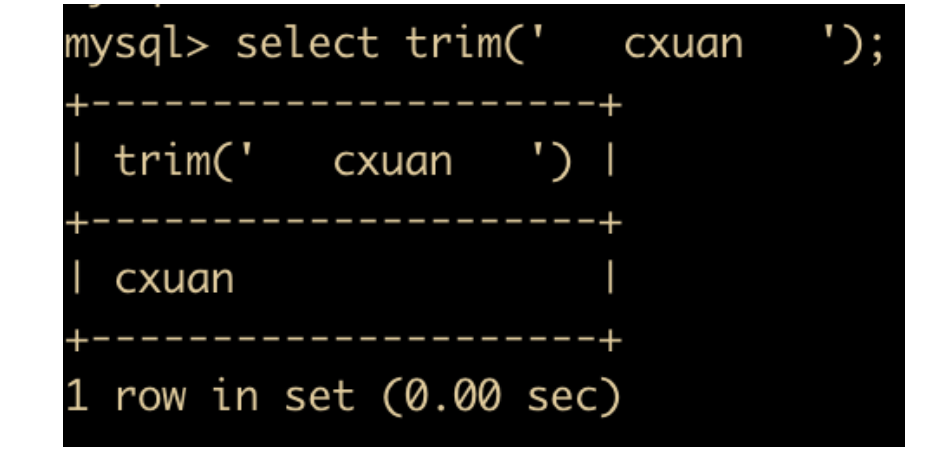

- TRIM(str) 函数:用于去掉目标字符串的空格

- SUBSTRING(str,x,y) 函数:返回从字符串 str 中第 x 位置起 y 个字符长度的字符串

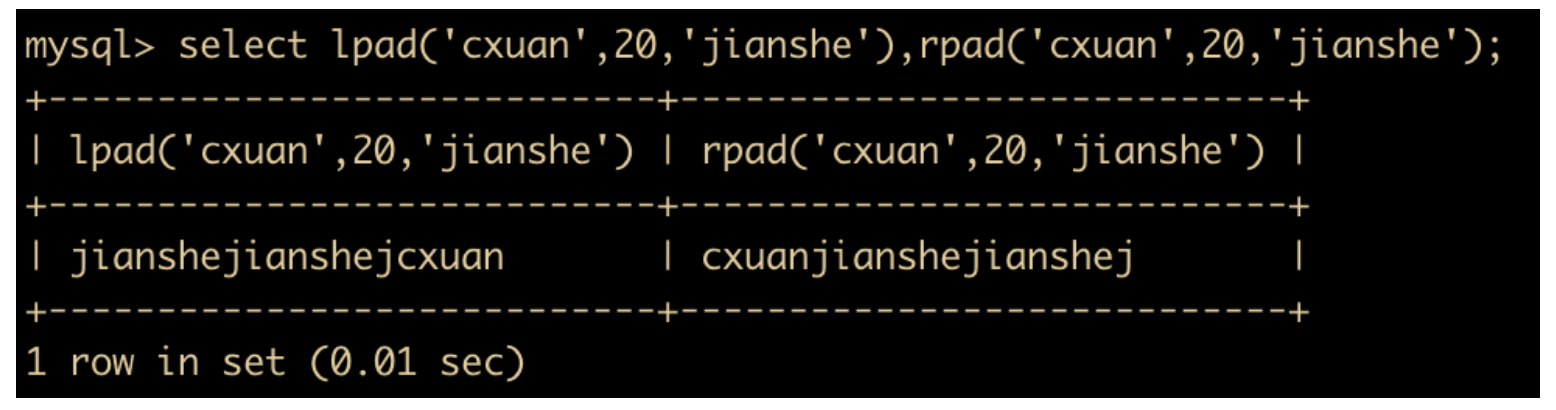

- LPAD(str,n,pad) 和 RPAD(str,n,pad) 函数:用字符串 pad 对 str 左边和右边进行填充,直到长度为 n 个字符长度

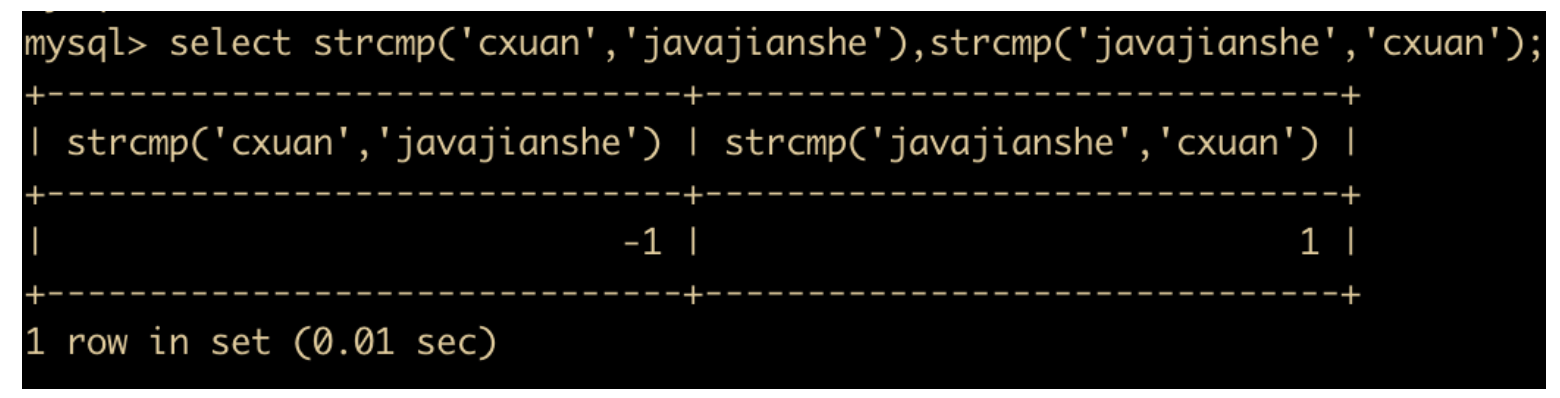

- STRCMP(s1,s2) 用于比较字符串 s1 和 s2 的 ASCII 值大小。如果 s1 < s2,则返回 -1;如果 s1 = s2 ,返回 0 ;如果 s1 > s2 ,返回 1。

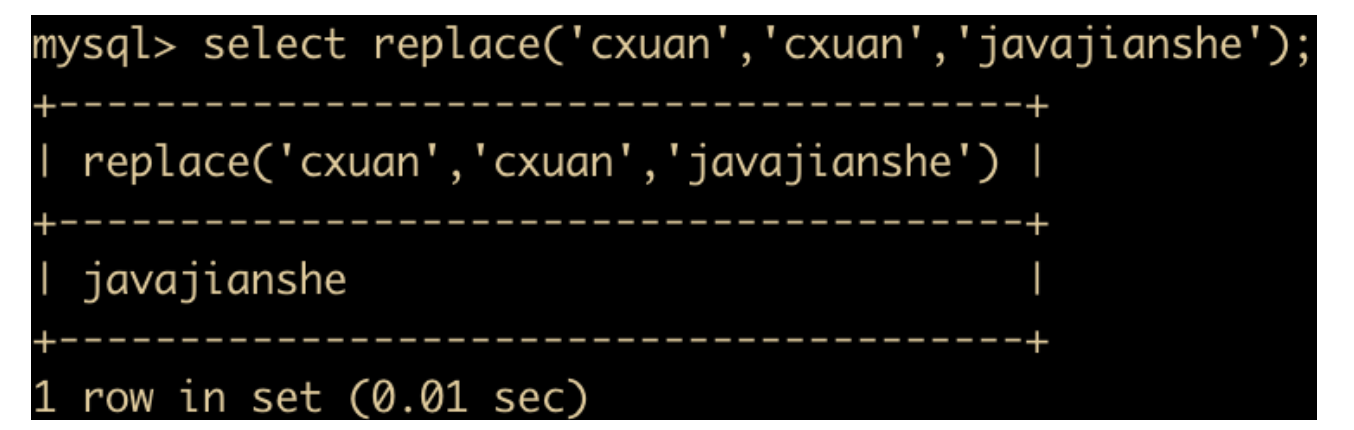

- REPLACE(str,a,b) : 用字符串 b 替换字符串 str 种所有出现的字符串 a

数值函数

MySQL 支持数值函数,这些函数能够处理很多数值运算。下面我们一起来学习一下 MySQL 中的数值函数,下面是所有的数值函数

| 函数 | 功能 |

|---|---|

| ABS | 返回绝对值 |

| CEIL | 返回大于某个值的最大整数值 |

| MOD | 返回模 |

| ROUND | 四舍五入 |

| FLOOR | 返回小于某个值的最大整数值 |

| TRUNCATE | 返回数字截断小数的结果 |

| RAND | 返回 0 – 1 的随机值 |

下面我们还是以实践为主来聊一聊这些用法

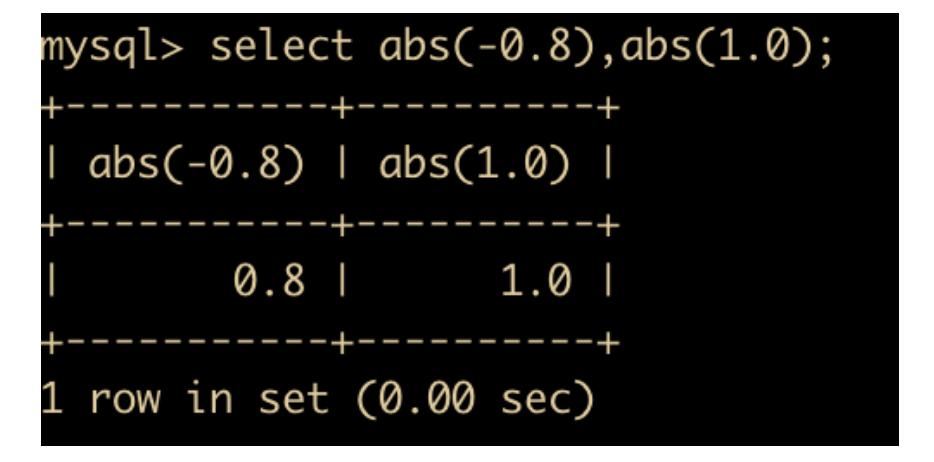

- ABS(x) 函数:返回 x 的绝对值

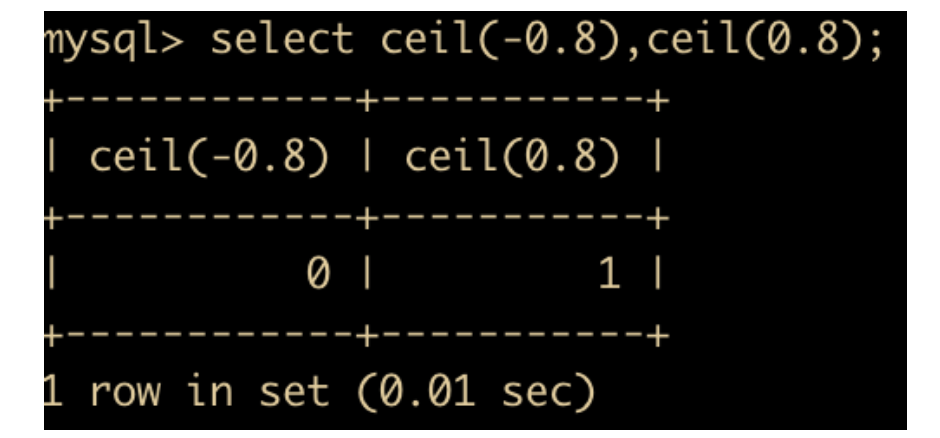

- CEIL(x) 函数: 返回大于 x 的整数

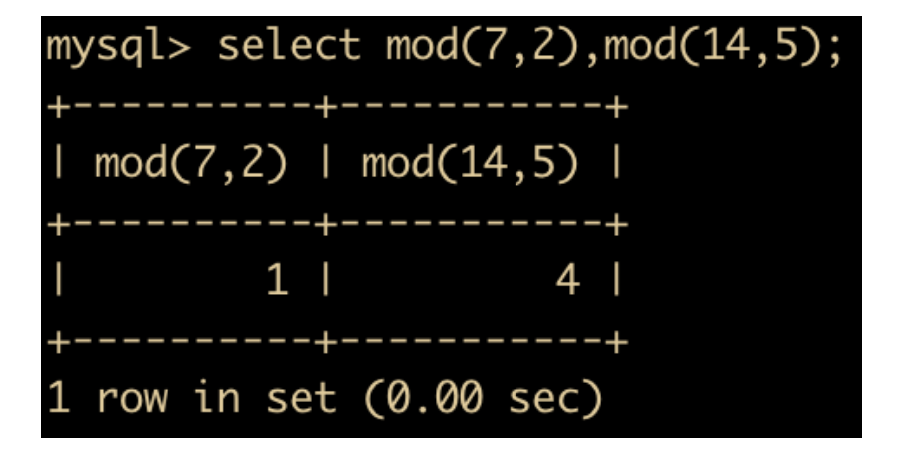

- MOD(x,y),对 x 和 y 进行取模操作

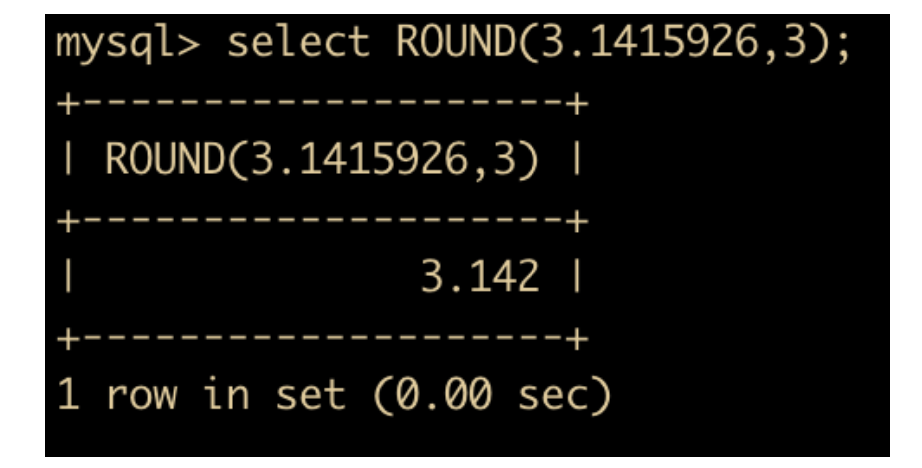

- ROUND(x,y) 返回 x 四舍五入后保留 y 位小数的值;如果是整数,那么 y 位就是 0 ;如果不指定 y ,那么 y 默认也是 0 。

- FLOOR(x) : 返回小于 x 的最大整数,用法与 CEIL 相反

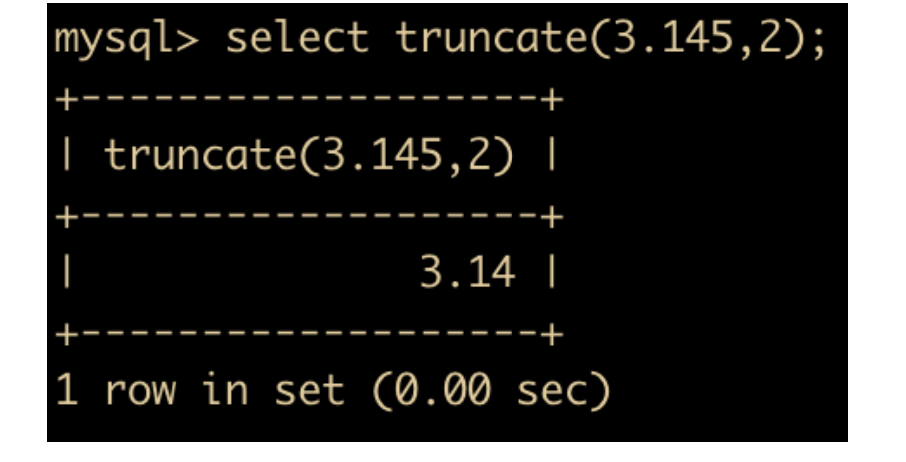

- TRUNCATE(x,y): 返回数字 x 截断为 y 位小数的结果, TRUNCATE 知识截断,并不是四舍五入。

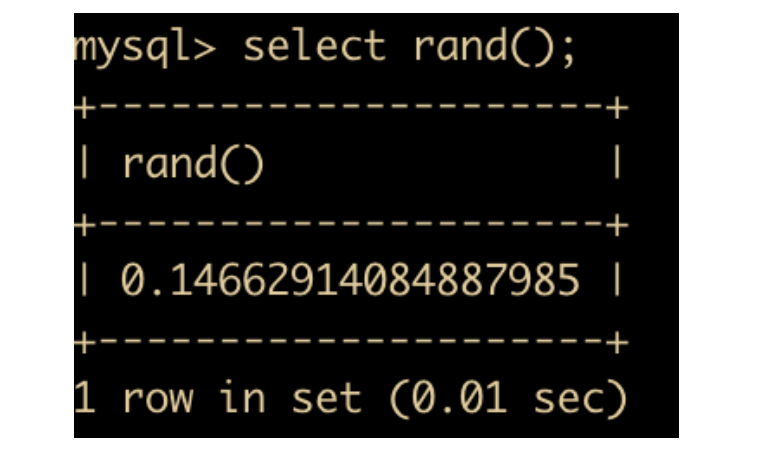

- RAND() :返回 0 到 1 的随机值

日期和时间函数

日期和时间函数也是 MySQL 中非常重要的一部分,下面我们就来一起认识一下这些函数

| 函数 | 功能 |

|---|---|

| NOW | 返回当前的日期和时间 |

| WEEK | 返回一年中的第几周 |

| YEAR | 返回日期的年份 |

| HOUR | 返回小时值 |

| MINUTE | 返回分钟值 |

| MONTHNAME | 返回月份名 |

| CURDATE | 返回当前日期 |

| CURTIME | 返回当前时间 |

| UNIX_TIMESTAMP | 返回日期 UNIX 时间戳 |

| DATE_FORMAT | 返回按照字符串格式化的日期 |

| FROM_UNIXTIME | 返回 UNIX 时间戳的日期值 |

| DATE_ADD | 返回日期时间 + 上一个时间间隔 |

| DATEDIFF | 返回起始时间和结束时间之间的天数 |

下面结合示例来讲解一下每个函数的使用

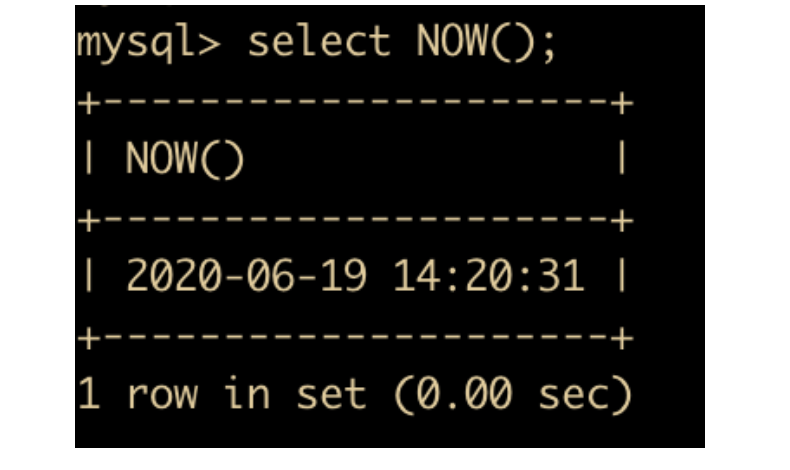

- NOW(): 返回当前的日期和时间

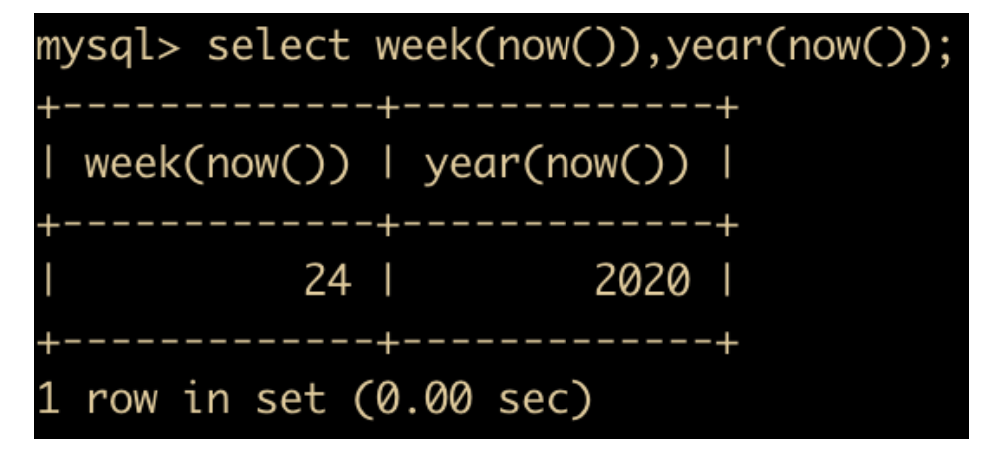

- WEEK(DATE) 和 YEAR(DATE) :前者返回的是一年中的第几周,后者返回的是给定日期的哪一年

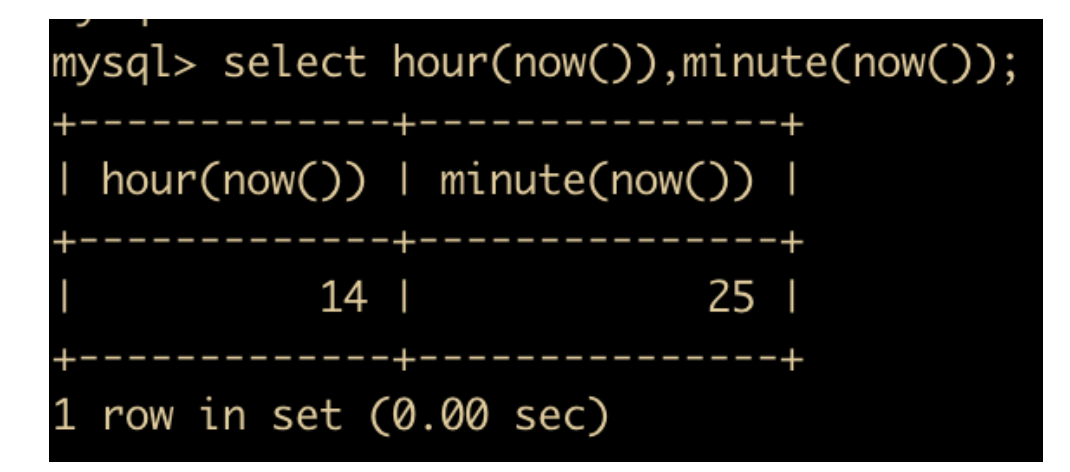

- HOUR(time) 和 MINUTE(time) : 返回给定时间的小时,后者返回给定时间的分钟

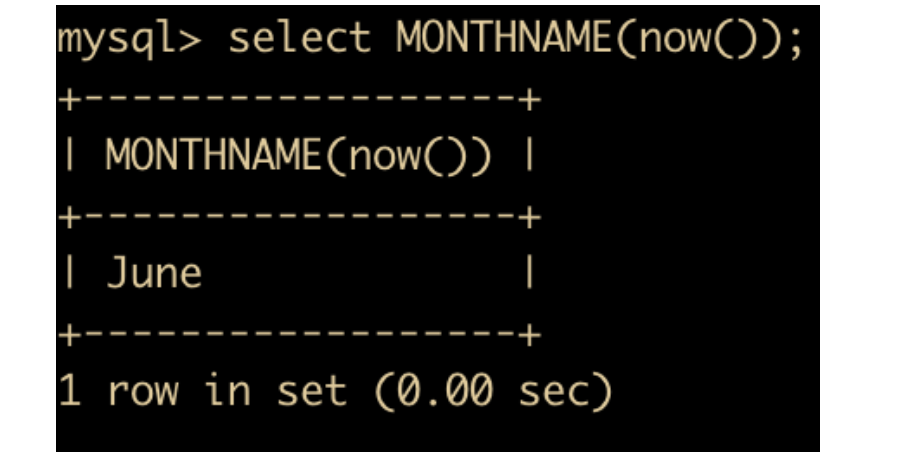

- MONTHNAME(date) 函数:返回 date 的英文月份

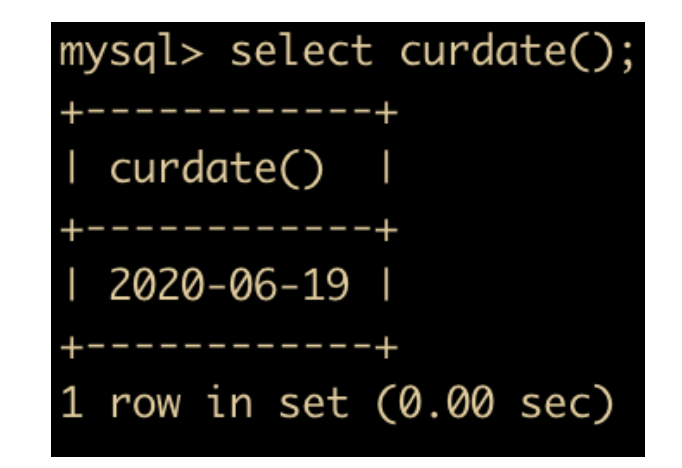

- CURDATE() 函数:返回当前日期,只包含年月日

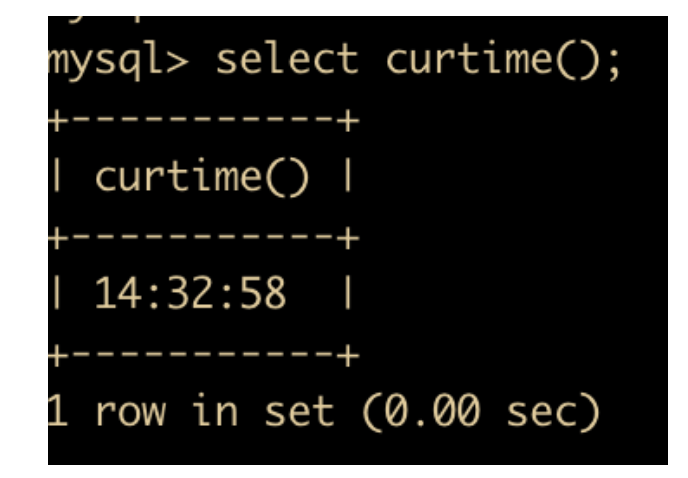

- CURTIME() 函数:返回当前时间,只包含时分秒

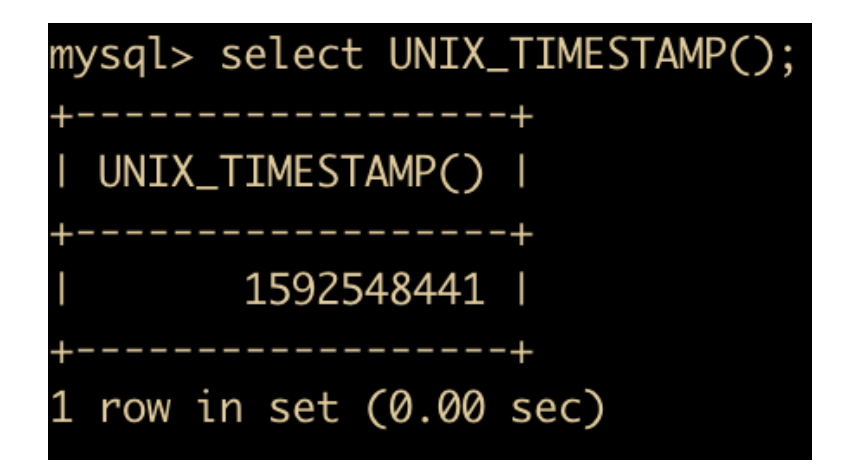

- UNIX_TIMESTAMP(date) : 返回 UNIX 的时间戳

- FROM_UNIXTIME(date) : 返回 UNIXTIME 时间戳的日期值,和 UNIX_TIMESTAMP 相反

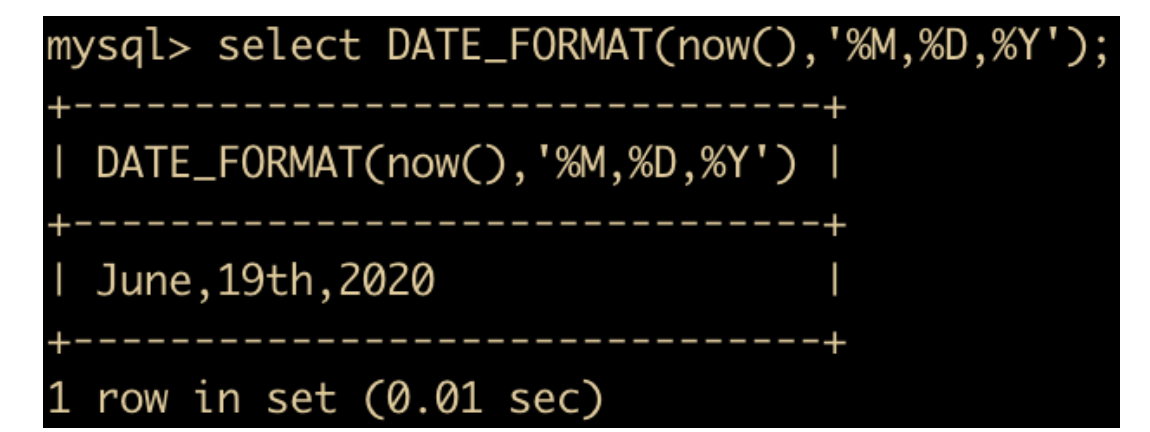

- DATE_FORMAT(date,fmt) 函数:按照字符串 fmt 对 date 进行格式化,格式化后按照指定日期格式显示

具体的日期格式可以参考这篇文章 https://blog.csdn.net/weixin_38703170/article/details/82177837

我们演示一下将当前日期显示为年月日的这种形式,使用的日期格式是 %M %D %Y。

- DATE_ADD(date, interval, expr type) 函数:返回与所给日期 date 相差 interval 时间段的日期

interval 表示间隔类型的关键字,expr 是表达式,这个表达式对应后面的类型,type 是间隔类型,MySQL 提供了 13 种时间间隔类型

| 表达式类型 | 描述 | 格式 |

|---|---|---|

| YEAR | 年 | YY |

| MONTH | 月 | MM |

| DAY | 日 | DD |

| HOUR | 小时 | hh |

| MINUTE | 分 | mm |

| SECOND | 秒 | ss |

| YEAR_MONTH | 年和月 | YY-MM |

| DAY_HOUR | 日和小时 | DD hh |

| DAY_MINUTE | 日和分钟 | DD hh : mm |

| DAY_SECOND | 日和秒 | DD hh :mm :ss |

| HOUR_MINUTE | 小时和分 | hh:mm |

| HOUR_SECOND | 小时和秒 | hh:ss |

| MINUTE_SECOND | 分钟和秒 | mm:ss |

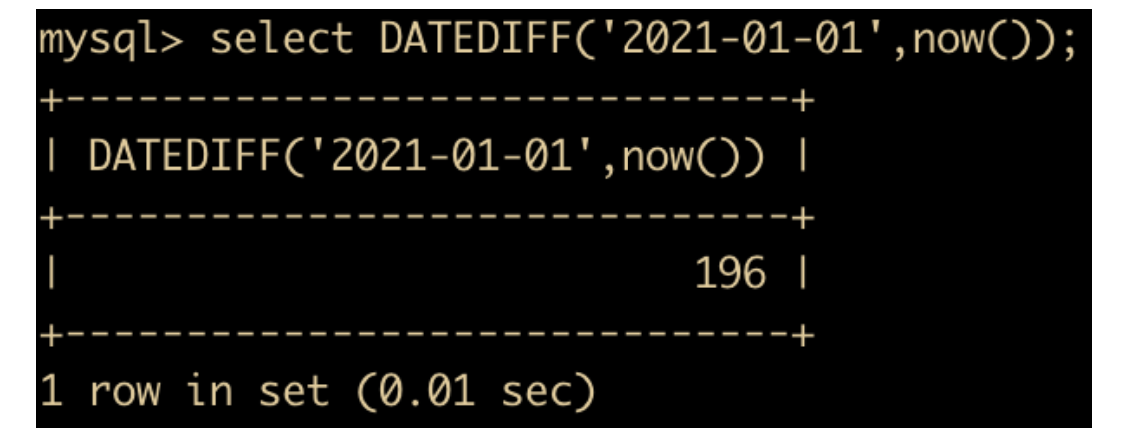

- DATE_DIFF(date1, date2) 用来计算两个日期之间相差的天数

查看离 2021 – 01 – 01 还有多少天

流程函数

流程函数也是很常用的一类函数,用户可以使用这类函数在 SQL 中实现条件选择。这样做能够提高查询效率。下表列出了这些流程函数

| 函数 | 功能 |

|---|---|

| IF(value,t f) | 如果 value 是真,返回 t;否则返回 f |

| IFNULL(value1,value2) | 如果 value1 不为 NULL,返回 value1,否则返回 value2。 |

| CASE WHEN[value1] THEN[result1] …ELSE[default] END | 如果 value1 是真,返回 result1,否则返回 default |

| CASE[expr] WHEN[value1] THEN [result1]… ELSE[default] END | 如果 expr 等于 value1, 返回 result1, 否则返回 default |

其他函数

除了我们介绍过的字符串函数、日期和时间函数、流程函数,还有一些函数并不属于上面三类函数,它们是

| 函数 | 功能 |

|---|---|

| VERSION | 返回当前数据库的版本 |

| DATABASE | 返回当前数据库名 |

| USER | 返回当前登陆用户名 |

| PASSWORD | 返回字符串的加密版本 |

| MD5 | 返回 MD5 值 |

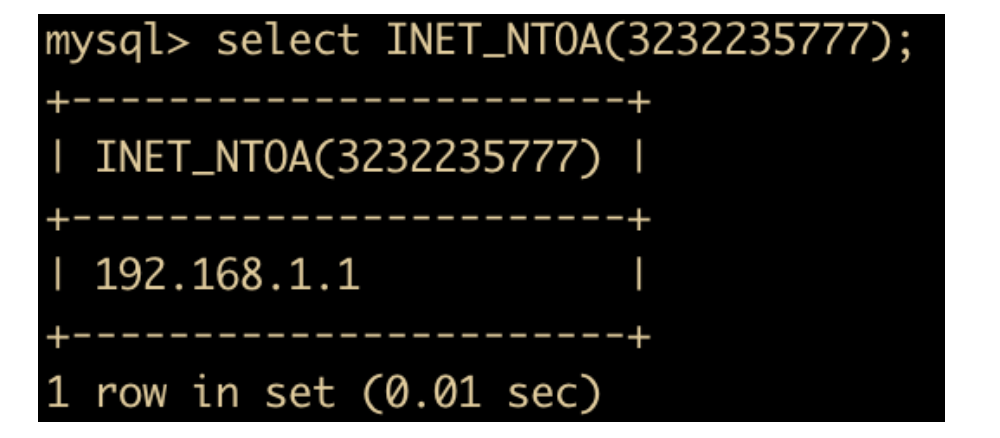

| INET_ATON(IP) | 返回 IP 地址的数字表示 |

| INET_NTOA(num) | 返回数字代表的 IP 地址 |

下面来看一下具体的使用

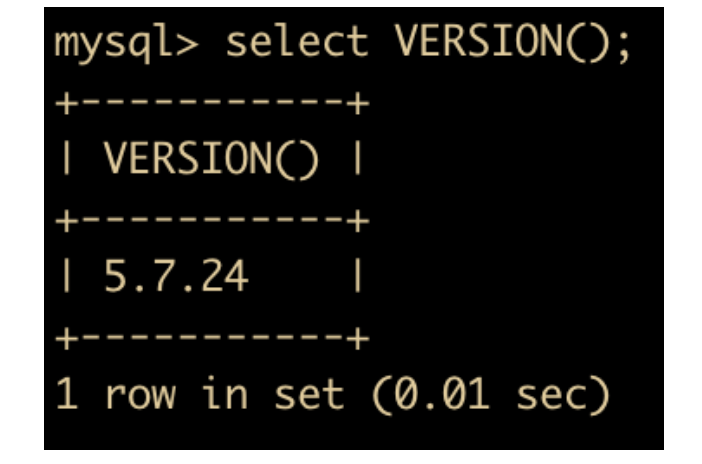

- VERSION: 返回当前数据库版本

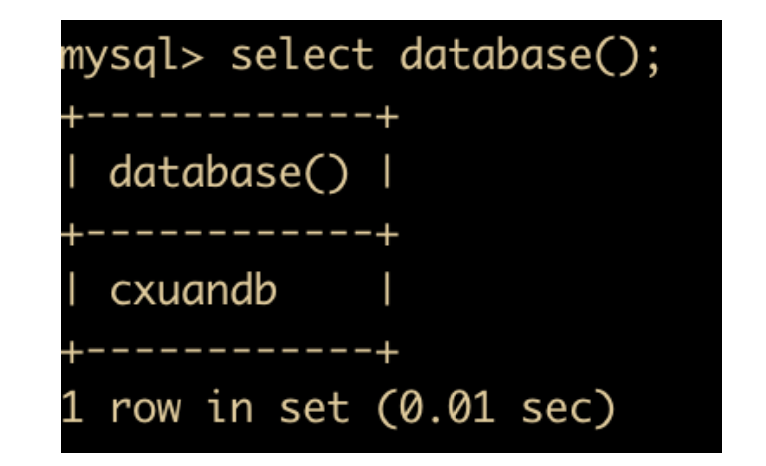

- DATABASE: 返回当前的数据库名

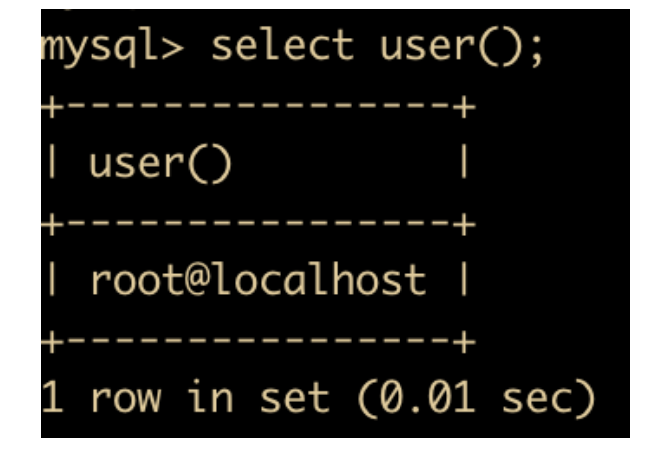

- USER : 返回当前登录用户名

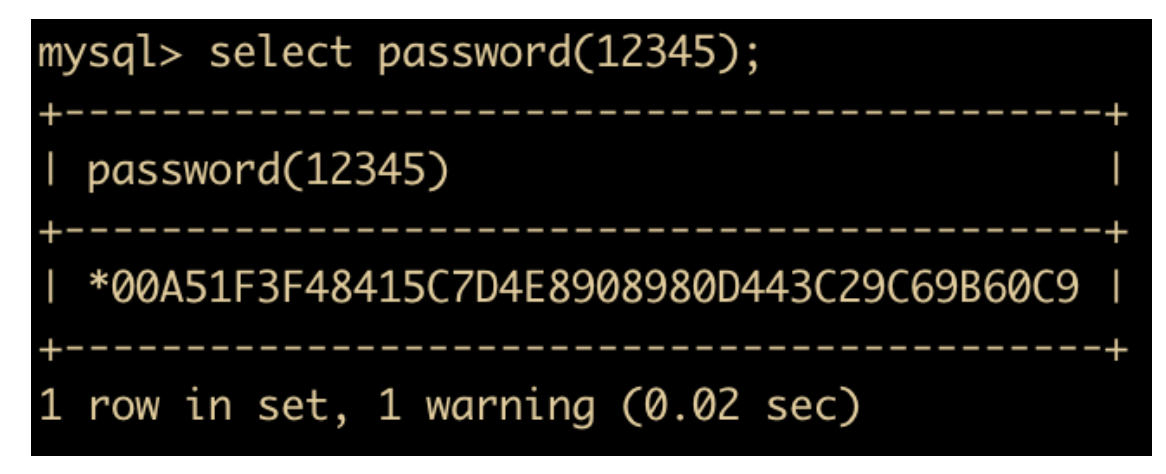

- PASSWORD(str) : 返回字符串的加密版本,例如

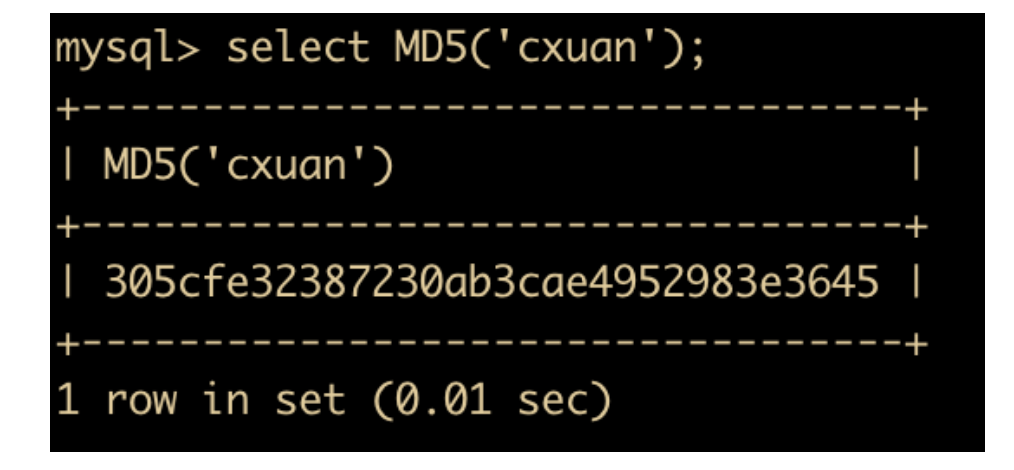

- MD5(str) 函数:返回字符串 str 的 MD5 值

- INET_ATON(IP): 返回 IP 的网络字节序列

- INET_NTOA(num)函数:返回网络字节序列代表的 IP 地址,与 INET_ATON 相对

总结

这篇文章我带你手把手撸了一波 MySQL 的高级内容,其实说高级也不一定真的高级或者说难,其实就是区分不同梯度的东西。

# MySQL开发-Java面试题

我们在 MySQL 入门篇主要介绍了基本的 SQL 命令、数据类型和函数,在局部以上知识后,你就可以进行 MySQL 的开发工作了,但是如果要成为一个合格的开发人员,你还要具备一些更高级的技能,下面我们就来探讨一下 MySQL 都需要哪些高级的技能

MySQL 存储引擎

存储引擎概述

数据库最核心的一点就是用来存储数据,数据存储就避免不了和磁盘打交道。那么数据以哪种方式进行存储,如何存储是存储的关键所在。所以存储引擎就相当于是数据存储的发动机,来驱动数据在磁盘层面进行存储。

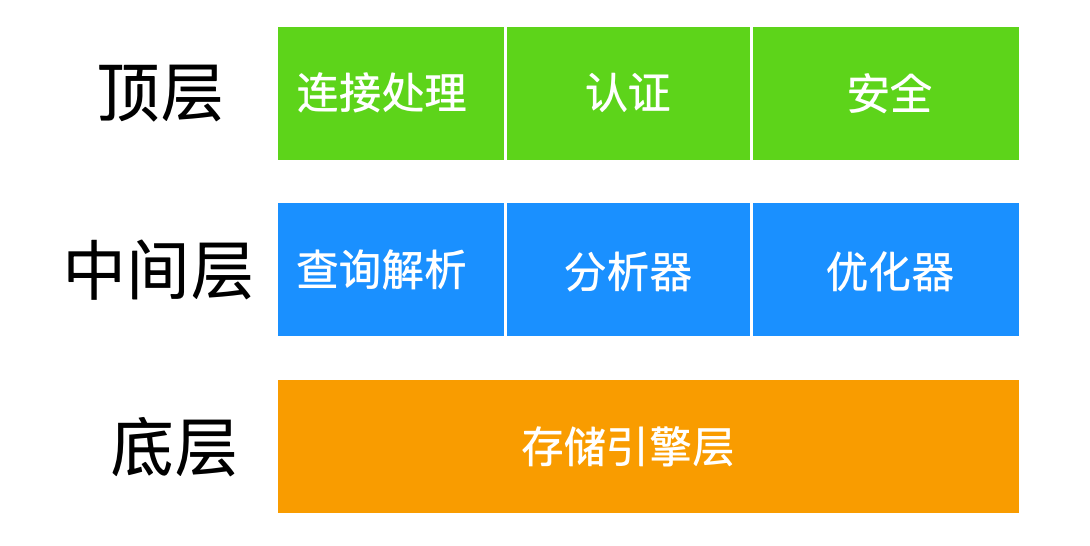

MySQL 的架构可以按照三层模式来理解

存储引擎也是 MySQL 的组建,它是一种软件,它所能做的和支持的功能主要有

- 并发

- 支持事务

- 完整性约束

- 物理存储

- 支持索引

- 性能帮助

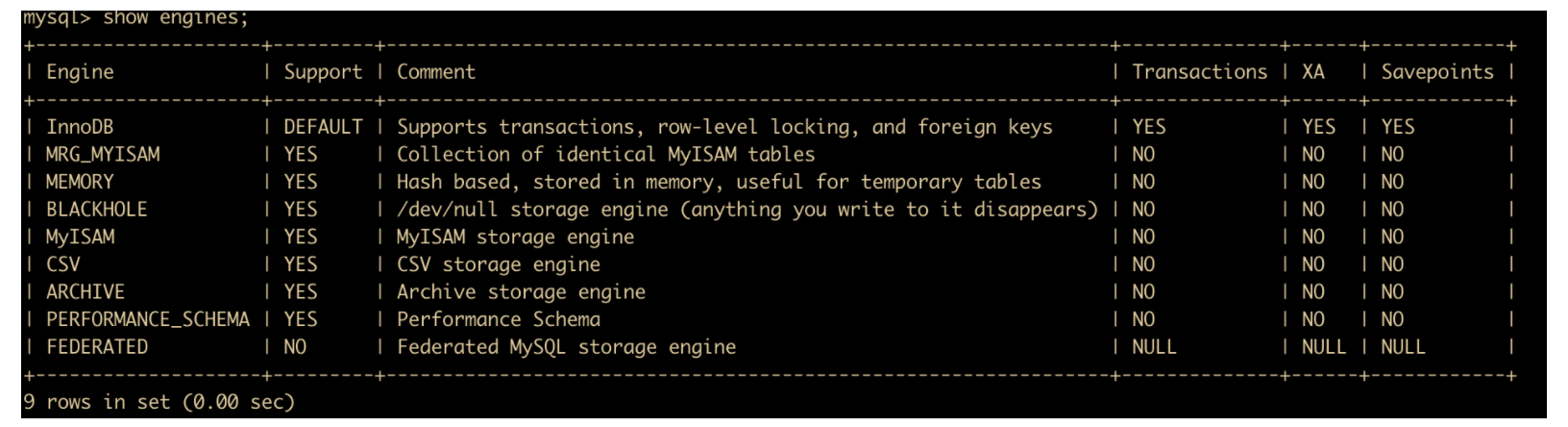

MySQL 默认支持多种存储引擎,来适用不同数据库应用,用户可以根据需要选择合适的存储引擎,下面是 MySQL 支持的存储引擎

- MyISAM

- InnoDB

- BDB

- MEMORY

- MERGE

- EXAMPLE

- NDB Cluster

- ARCHIVE

- CSV

- BLACKHOLE

- FEDERATED

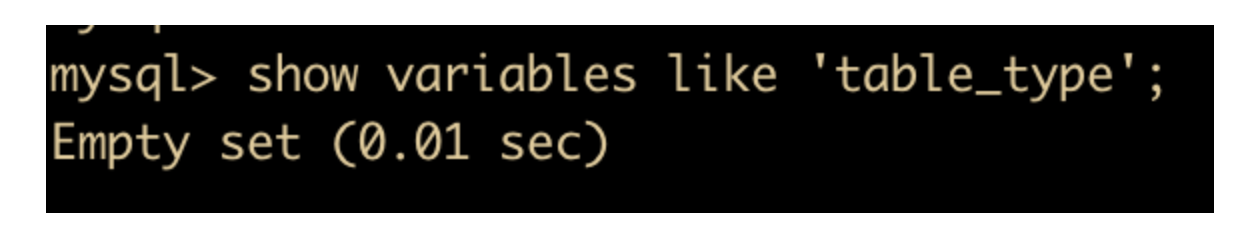

默认情况下,如果创建表不指定存储引擎,会使用默认的存储引擎,如果要修改默认的存储引擎,那么就可以在参数文件中设置 default-table-type,能够查看当前的存储引擎

show variables like 'table_type';

奇怪,为什么没有了呢?网上求证一下,在 5.5.3 取消了这个参数

可以通过下面两种方法查询当前数据库支持的存储引擎

show engines \g

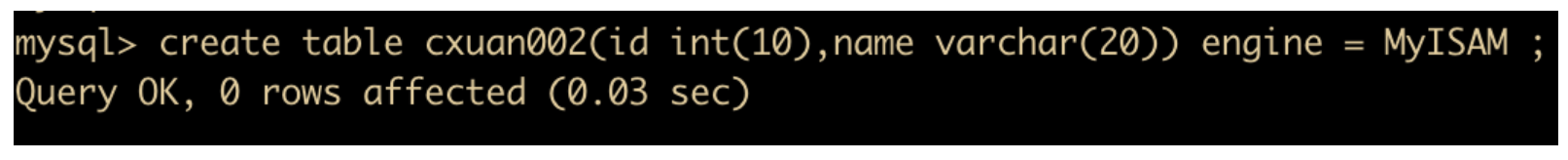

在创建新表的时候,可以通过增加 ENGINE 关键字设置新建表的存储引擎。

create table cxuan002(id int(10),name varchar(20)) engine = MyISAM;

上图我们指定了 MyISAM 的存储引擎。

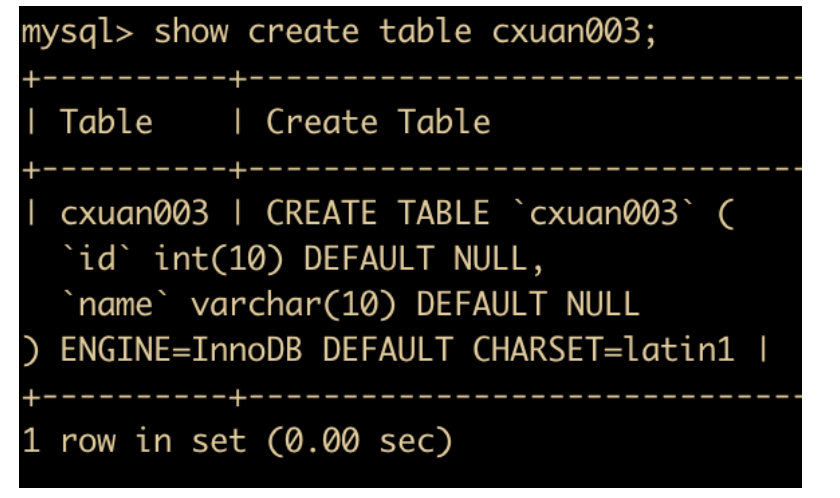

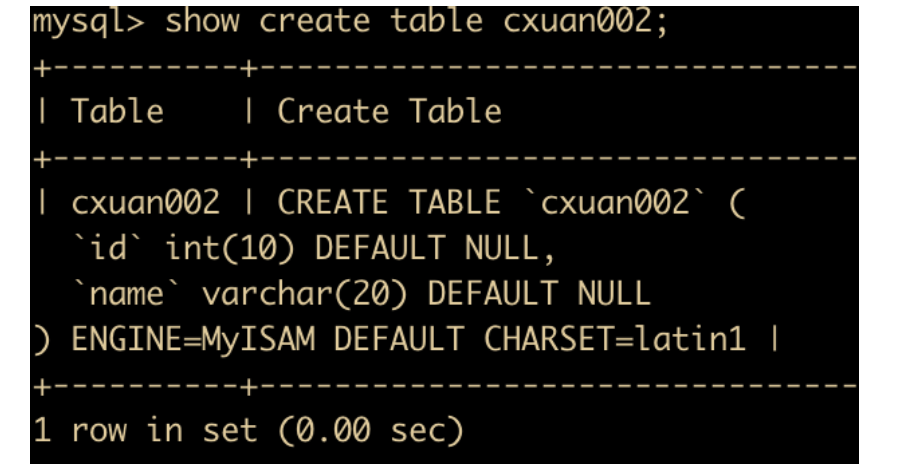

如果你不知道表的存储引擎怎么办?你可以通过 show create table 来查看

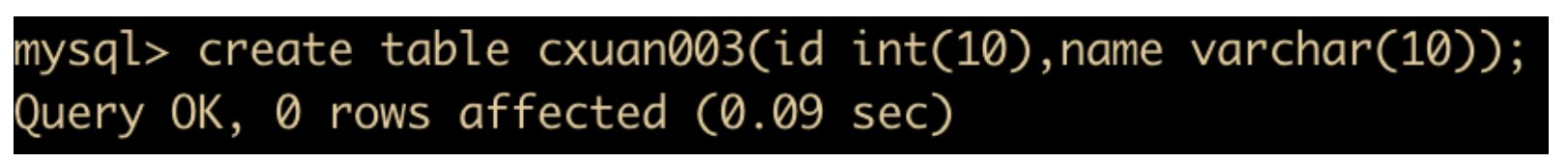

如果不指定存储引擎的话,从MySQL 5.1 版本之后,MySQL 的默认内置存储引擎已经是 InnoDB了。建一张表看一下

如上图所示,我们没有指定默认的存储引擎,下面查看一下表

可以看到,默认的存储引擎是 InnoDB。

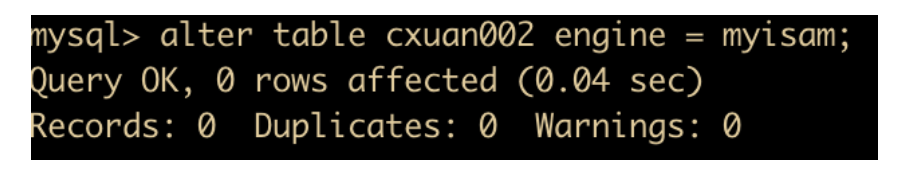

如果你的存储引擎想要更换,可以使用

alter table cxuan003 engine = myisam;

来更换,更换完成后回显示 0 rows affected ,但其实已经操作成功

我们使用 show create table 查看一下表的 sql 就知道

存储引擎特性

下面会介绍几个常用的存储引擎以及它的基本特性,这些存储引擎是 MyISAM、InnoDB、MEMORY 和 MERGE

MyISAM

在 5.1 版本之前,MyISAM 是 MySQL 的默认存储引擎,MyISAM 并发性比较差,使用的场景比较少,主要特点是

不支持

事务操作,ACID 的特性也就不存在了,这一设计是为了性能和效率考虑的。不支持

外键操作,如果强行增加外键,MySQL 不会报错,只不过外键不起作用。MyISAM 默认的锁粒度是

表级锁,所以并发性能比较差,加锁比较快,锁冲突比较少,不太容易发生死锁的情况。MyISAM 会在磁盘上存储三个文件,文件名和表名相同,扩展名分别是

.frm(存储表定义)、.MYD(MYData,存储数据)、MYI(MyIndex,存储索引)。这里需要特别注意的是 MyISAM 只缓存索引文件,并不缓存数据文件。MyISAM 支持的索引类型有

全局索引(Full-Text)、B-Tree 索引、R-Tree 索引Full-Text 索引:它的出现是为了解决针对文本的模糊查询效率较低的问题。

B-Tree 索引:所有的索引节点都按照平衡树的数据结构来存储,所有的索引数据节点都在叶节点

R-Tree索引:它的存储方式和 B-Tree 索引有一些区别,主要设计用于存储空间和多维数据的字段做索引,目前的 MySQL 版本仅支持 geometry 类型的字段作索引,相对于 BTREE,RTREE 的优势在于范围查找。

数据库所在主机如果宕机,MyISAM 的数据文件容易损坏,而且难以恢复。

增删改查性能方面:SELECT 性能较高,适用于查询较多的情况

InnoDB

自从 MySQL 5.1 之后,默认的存储引擎变成了 InnoDB 存储引擎,相对于 MyISAM,InnoDB 存储引擎有了较大的改变,它的主要特点是

- 支持事务操作,具有事务 ACID 隔离特性,默认的隔离级别是

可重复读(repetable-read)、通过MVCC(并发版本控制)来实现的。能够解决脏读和不可重复读的问题。 - InnoDB 支持外键操作。

- InnoDB 默认的锁粒度

行级锁,并发性能比较好,会发生死锁的情况。 - 和 MyISAM 一样的是,InnoDB 存储引擎也有

.frm文件存储表结构定义,但是不同的是,InnoDB 的表数据与索引数据是存储在一起的,都位于 B+ 数的叶子节点上,而 MyISAM 的表数据和索引数据是分开的。 - InnoDB 有安全的日志文件,这个日志文件用于恢复因数据库崩溃或其他情况导致的数据丢失问题,保证数据的一致性。

- InnoDB 和 MyISAM 支持的索引类型相同,但具体实现因为文件结构的不同有很大差异。

- 增删改查性能方面,果执行大量的增删改操作,推荐使用 InnoDB 存储引擎,它在删除操作时是对行删除,不会重建表。

MEMORY

MEMORY 存储引擎使用存在内存中的内容来创建表。每个 MEMORY 表实际只对应一个磁盘文件,格式是 .frm。 MEMORY 类型的表访问速度很快,因为其数据是存放在内存中。默认使用 HASH 索引。

MERGE

MERGE 存储引擎是一组 MyISAM 表的组合,MERGE 表本身没有数据,对 MERGE 类型的表进行查询、更新、删除的操作,实际上是对内部的 MyISAM 表进行的。MERGE 表在磁盘上保留两个文件,一个是 .frm 文件存储表定义、一个是 .MRG 文件存储 MERGE 表的组成等。

选择合适的存储引擎

在实际开发过程中,我们往往会根据应用特点选择合适的存储引擎。

- MyISAM:如果应用程序通常以检索为主,只有少量的插入、更新和删除操作,并且对事物的完整性、并发程度不是很高的话,通常建议选择 MyISAM 存储引擎。

- InnoDB:如果使用到外键、需要并发程度较高,数据一致性要求较高,那么通常选择 InnoDB 引擎,一般互联网大厂对并发和数据完整性要求较高,所以一般都使用 InnoDB 存储引擎。

- MEMORY:MEMORY 存储引擎将所有数据保存在内存中,在需要快速定位下能够提供及其迅速的访问。MEMORY 通常用于更新不太频繁的小表,用于快速访问取得结果。

- MERGE:MERGE 的内部是使用 MyISAM 表,MERGE 表的优点在于可以突破对单个 MyISAM 表大小的限制,并且通过将不同的表分布在多个磁盘上, 可以有效地改善 MERGE 表的访问效率。

选择合适的数据类型

我们会经常遇见的一个问题就是,在建表时如何选择合适的数据类型,通常选择合适的数据类型能够提高性能、减少不必要的麻烦,下面我们就来一起探讨一下,如何选择合适的数据类型。

CHAR 和 VARCHAR 的选择

char 和 varchar 是我们经常要用到的两个存储字符串的数据类型,char 一般存储定长的字符串,它属于固定长度的字符类型,比如下面

| 值 | char(5) | 存储字节 |

|---|---|---|

| ” | ‘ ‘ | 5个字节 |

| ‘cx’ | ‘cx ‘ | 5个字节 |

| ‘cxuan’ | ‘cxuan’ | 5个字节 |

| ‘cxuan007’ | ‘cxuan’ | 5个字节 |

可以看到,不管你的值写的是什么,一旦指定了 char 字符的长度,如果你的字符串长度不够指定字符的长度的话,那么就用空格来填补,如果超过字符串长度的话,只存储指定字符长度的字符。

这里注意一点:如果 MySQL 使用了非

严格模式的话,上面表格最后一行是可以存储的。如果 MySQL 使用了严格模式的话,那么表格上面最后一行存储会报错。

如果使用了 varchar 字符类型,我们来看一下例子

| 值 | varchar(5) | 存储字节 |

|---|---|---|

| ” | ” | 1个字节 |

| ‘cx’ | ‘cx ‘ | 3个字节 |

| ‘cxuan’ | ‘cxuan’ | 6个字节 |

| ‘cxuan007’ | ‘cxuan’ | 6个字节 |

可以看到,如果使用 varchar 的话,那么存储的字节将根据实际的值进行存储。你可能会疑惑为什么 varchar 的长度是 5 ,但是却需要存储 3 个字节或者 6 个字节,这是因为使用 varchar 数据类型进行存储时,默认会在最后增加一个字符串长度,占用1个字节(如果列声明的长度超过255,则使用两个字节)。varchar 不会填充空余的字符串。

一般使用 char 来存储定长的字符串,比如身份证号、手机号、邮箱等;使用 varchar 来存储不定长的字符串。由于 char 长度是固定的,所以它的处理速度要比 VARCHAR 快很多,但是缺点是浪费存储空间,但是随着 MySQL 版本的不断演进,varchar 数据类型的性能也在不断改进和提高,所以在许多应用中,VARCHAR 类型更多的被使用。

在 MySQL 中,不同的存储引擎对 CHAR 和 VARCHAR 的使用原则也有不同

- MyISAM:建议使用固定长度的数据列替代可变长度的数据列,也就是 CHAR

- MEMORY:使用固定长度进行处理、CHAR 和 VARCHAR 都会被当作 CHAR 处理

- InnoDB:建议使用 VARCHAR 类型

TEXT 与 BLOB

一般在保存较少的文本的时候,我们会选择 CHAR 和 VARCHAR,在保存大数据量的文本时,我们往往选择 TEXT 和 BLOB;TEXT 和 BLOB 的主要差别是 BLOB 能够保存二进制数据;而 TEXT 只能保存字符数据,TEXT 往下细分有

- TEXT

- MEDIUMTEXT

- LONGTEXT

BLOB 往下细分有

- BLOB

- MEDIUMBLOB

- LONGBLOB

三种,它们最主要的区别就是存储文本长度不同和存储字节不同,用户应该根据实际情况选择满足需求的最小存储类型,下面主要对 BLOB 和 TEXT 存在一些问题进行介绍

TEXT 和 BLOB 在删除数据后会存在一些性能上的问题,为了提高性能,建议使用 OPTIMIZE TABLE 功能对表进行碎片整理。

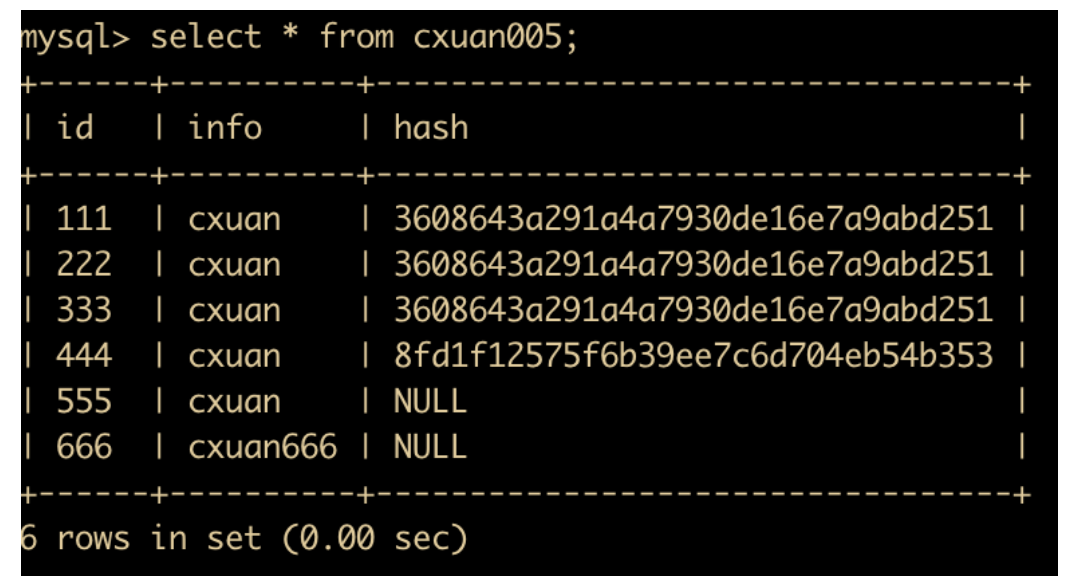

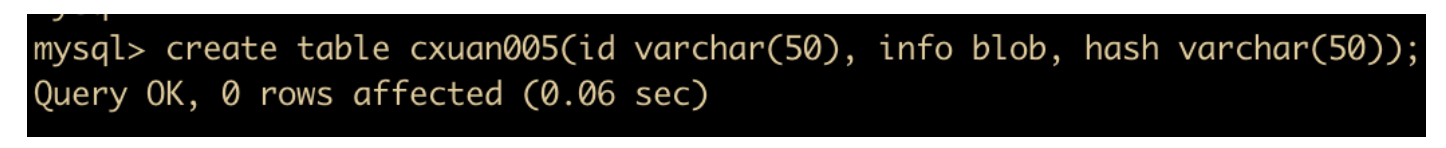

也可以使用合成索引来提高文本字段(BLOB 和 TEXT)的查询性能。合成索引就是根据大文本(BLOB 和 TEXT)字段的内容建立一个散列值,把这个值存在对应列中,这样就能够根据散列值查找到对应的数据行。一般使用散列算法比如 md5() 和 SHA1() ,如果散列算法生成的字符串带有尾部空格,就不要把它们存在 CHAR 和 VARCHAR 中,下面我们就来看一下这种使用方式

首先创建一张表,表中记录 blob 字段和 hash 值

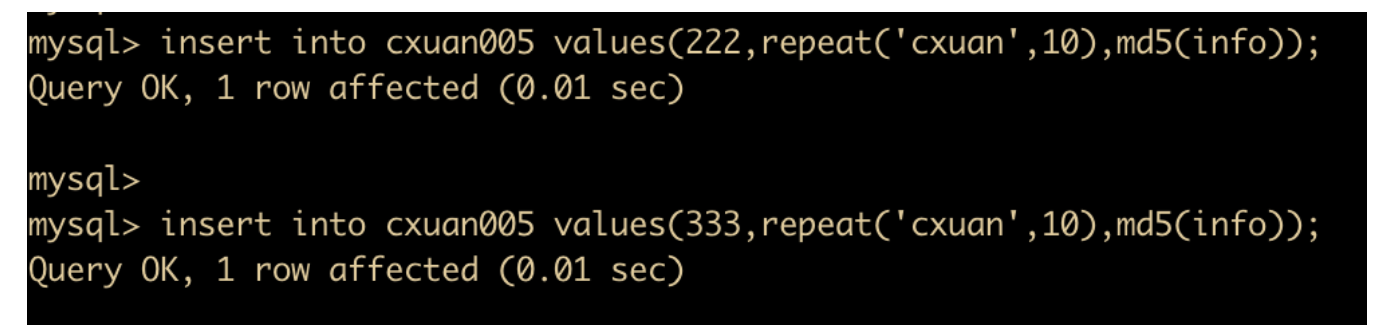

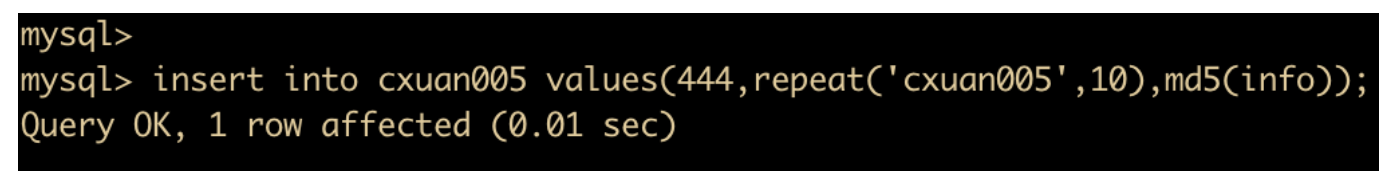

向 cxuan005 中插入数据,其中 hash 值作为 info 的散列值。

然后再插入两条数据

插入一条 info 为 cxuan005 的数据

如果想要查询 info 为 cxuan005 的数据,可以通过查询 hash 列来进行查询

这是合成索引的例子,如果要对 BLOB 进行模糊查询的话,就要使用前缀索引。

其他优化 BLOB 和 TEXT 的方式:

- 非必要的时候不要检索 BLOB 和 TEXT 索引

- 把 BLOB 或 TEXT 列分离到单独的表中。

浮点数和定点数的选择

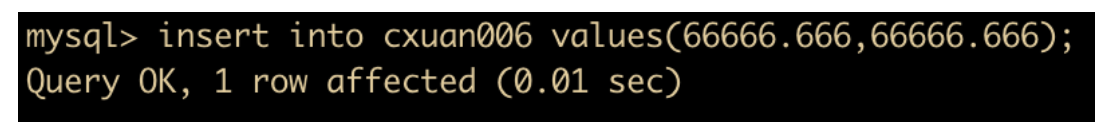

浮点数指的就是含有小数的值,浮点数插入到指定列中超过指定精度后,浮点数会四舍五入,MySQL 中的浮点数指的就是 float 和 double,定点数指的是 decimal,定点数能够更加精确的保存和显示数据。下面通过一个示例讲解一下浮点数精确性问题

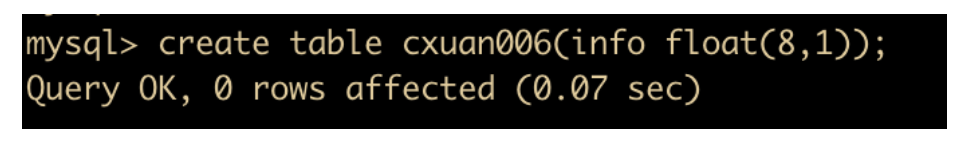

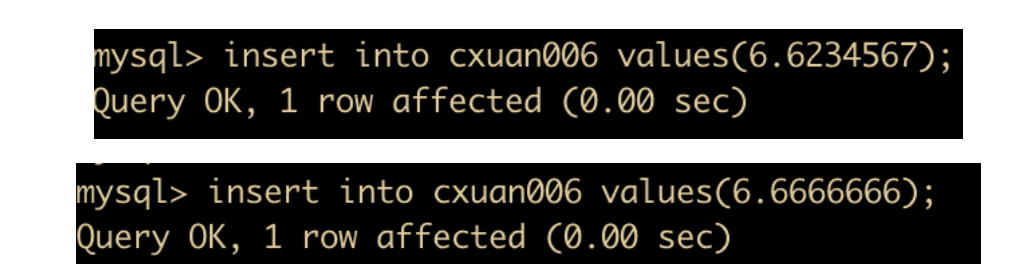

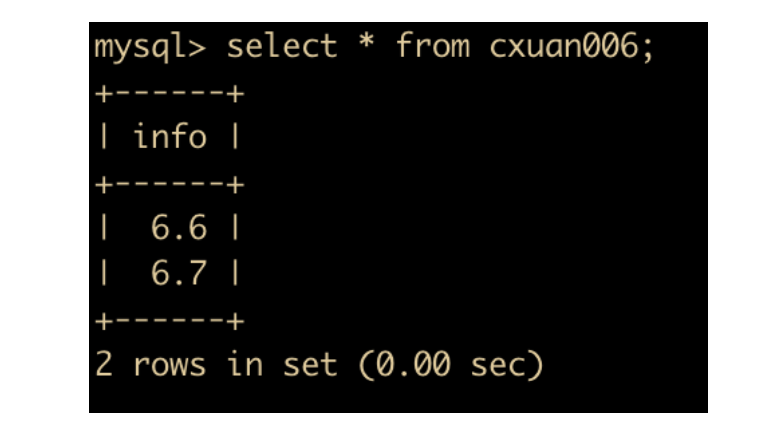

首先创建一个表 cxuan006 ,只为了测试浮点数问题,所以这里我们选择的数据类型是 float

然后分别插入两条数据

然后执行查询,可以看到查询出来的两条数据执行的舍入不同

为了清晰的看清楚浮点数与定点数的精度问题,再来看一个例子

先修改 cxuan006 的两个字段为相同的长度和小数位数

然后插入两条数据

执行查询操作,可以发现,浮点数相较于定点数来说,会产生误差

日期类型选择

在 MySQL 中,用来表示日期类型的有 DATE、TIME、DATETIME、TIMESTAMP,在

这篇文中介绍过了日期类型的区别,我们这里就不再阐述了。下面主要介绍一下选择

- TIMESTAMP 和时区相关,更能反映当前时间,如果记录的日期需要让不同时区的人使用,最好使用 TIMESTAMP。

- DATE 用于表示年月日,如果实际应用值需要保存年月日的话就可以使用 DATE。

- TIME 用于表示时分秒,如果实际应用值需要保存时分秒的话就可以使用 TIME。

- YEAR 用于表示年份,YEAR 有 2 位(最好使用4位)和 4 位格式的年。 默认是4位。如果实际应用只保存年份,那么用 1 bytes 保存 YEAR 类型完全可以。不但能够节约存储空间,还能提高表的操作效率。

MySQL 字符集

下面来认识一下 MySQL 字符集,简单来说字符集就是一套文字符号和编码、比较规则的集合。1960 年美国标准化组织 ANSI 发布了第一个计算机字符集,就是著名的 ASCII(American Standard Code for Information Interchange) 。自从 ASCII 编码后,每个国家、国际组织都研究了一套自己的字符集,比如 ISO-8859-1、GBK 等。

但是每个国家都使用自己的字符集为移植性带来了很大的困难。所以,为了统一字符编码,国际标准化组织(ISO) 指定了统一的字符标准 – Unicode 编码,它容纳了几乎所有的字符编码。下面是一些常见的字符编码

| 字符集 | 是否定长 | 编码方式 |

|---|---|---|

| ASCII | 是 | 单字节 7 位编码 |

| ISO-8859-1 | 是 | 单字节 8 位编码 |

| GBK | 是 | 双字节编码 |

| UTF-8 | 否 | 1 – 4 字节编码 |

| UTF-16 | 否 | 2 字节或 4 字节编码 |

| UTF-32 | 是 | 4 字节编码 |

对数据库来说,字符集是很重要的,因为数据库存储的数据大多数都是各种文字,字符集对数据库的存储、性能、系统的移植来说都非常重要。

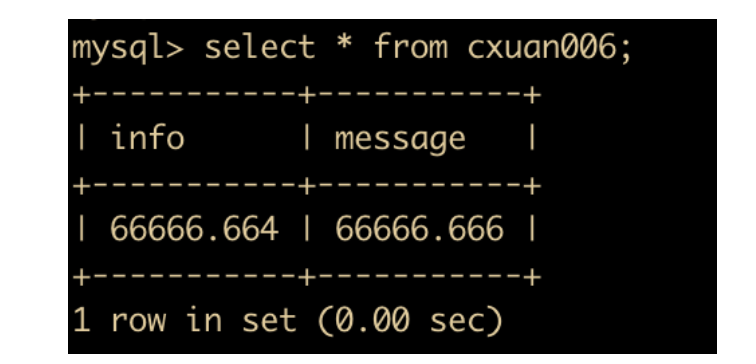

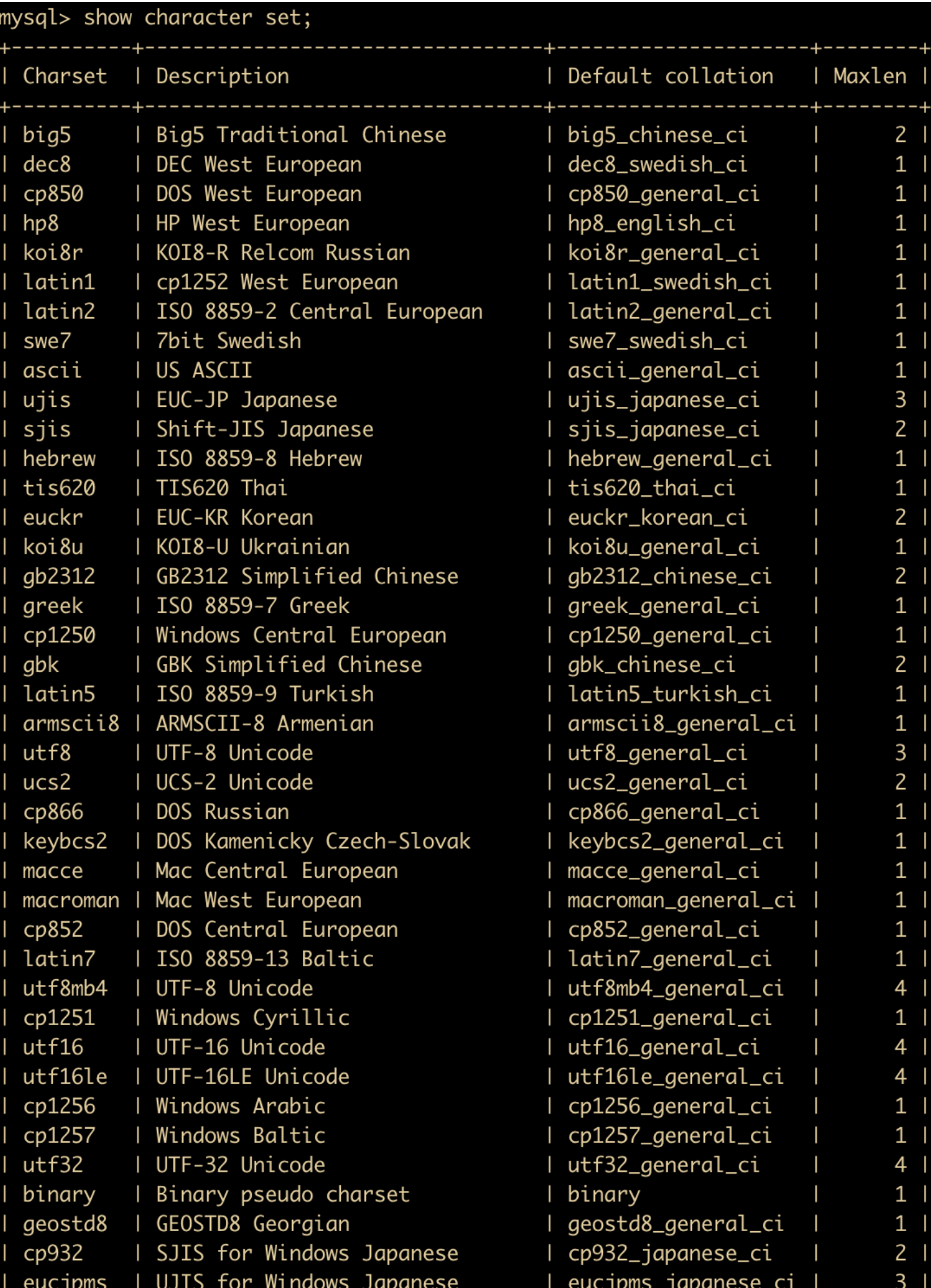

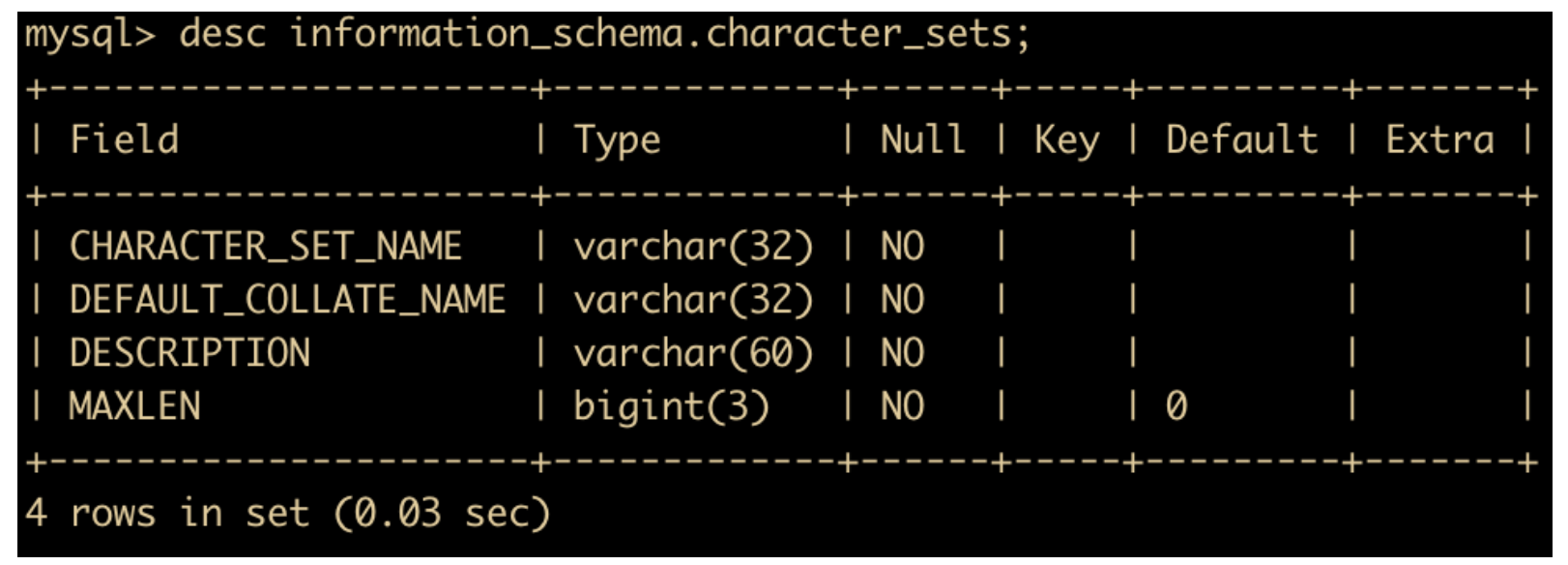

MySQL 支持多种字符集,可以使用 show character set; 来查看所有可用的字符集

或者使用

select character_set_name, default_collate_name, description, maxlen from information_schema.character_sets;

来查看。

使用 information_schema.character_set 来查看字符集和校对规则。

# MySQL优化-Java面试题

一般传统互联网公司很少接触到 SQL 优化问题,其原因是数据量小,大部分厂商的数据库性能能够满足日常的业务需求,所以不需要进行 SQL 优化,但是随着应用程序的不断变大,数据量的激增,数据库自身的性能跟不上了,此时就需要从 SQL 自身角度来进行优化,这也是我们这篇文章所讨论的。

SQL 优化步骤

当面对一个需要优化的 SQL 时,我们有哪几种排查思路呢?

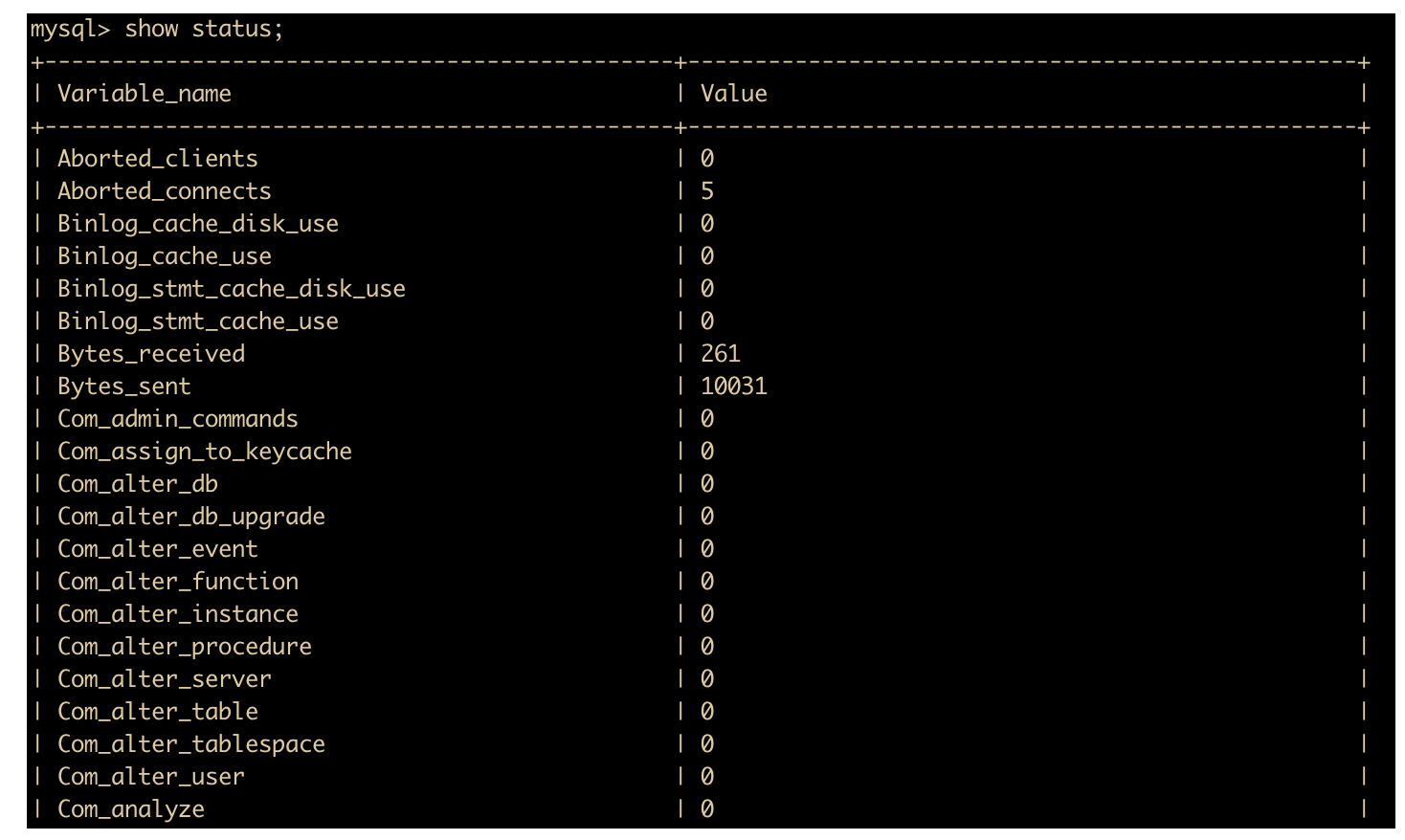

通过 show status 命令了解 SQL 执行次数

首先,我们可以使用 show status 命令查看服务器状态信息。show status 命令会显示每个服务器变量 variable_name 和 value,状态变量是只读的。如果使用 SQL 命令,可以使用 like 或者 where 条件来限制结果。like 可以对变量名做标准模式匹配。

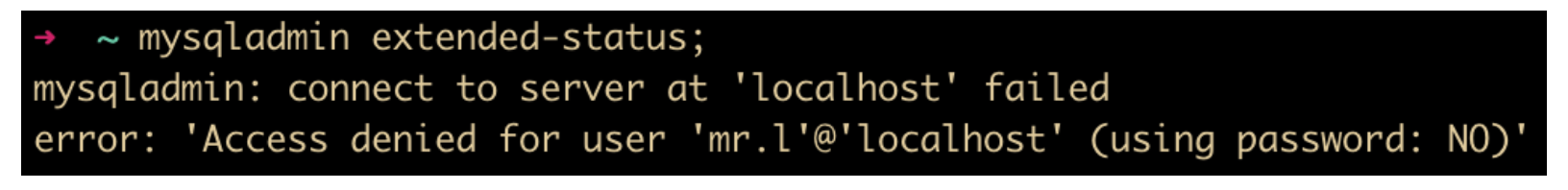

图我没有截全,下面还有很多变量,读者可以自己尝试一下。也可以在操作系统上使用 mysqladmin extended-status 命令来获取这些消息。

但是我执行 mysqladmin extended-status 后,出现这个错误。

应该是我没有输入密码的原因,使用 mysqladmin -P3306 -uroot -p -h127.0.0.1 -r -i 1 extended-status 后,问题解决。

这里需要注意一下 show status 命令中可以添加统计结果的级别,这个级别有两个

- session 级: 默认当前链接的统计结果

- global 级:自数据库上次启动到现在的统计结果

如果不指定统计结果级别的话,默认使用 session 级别。

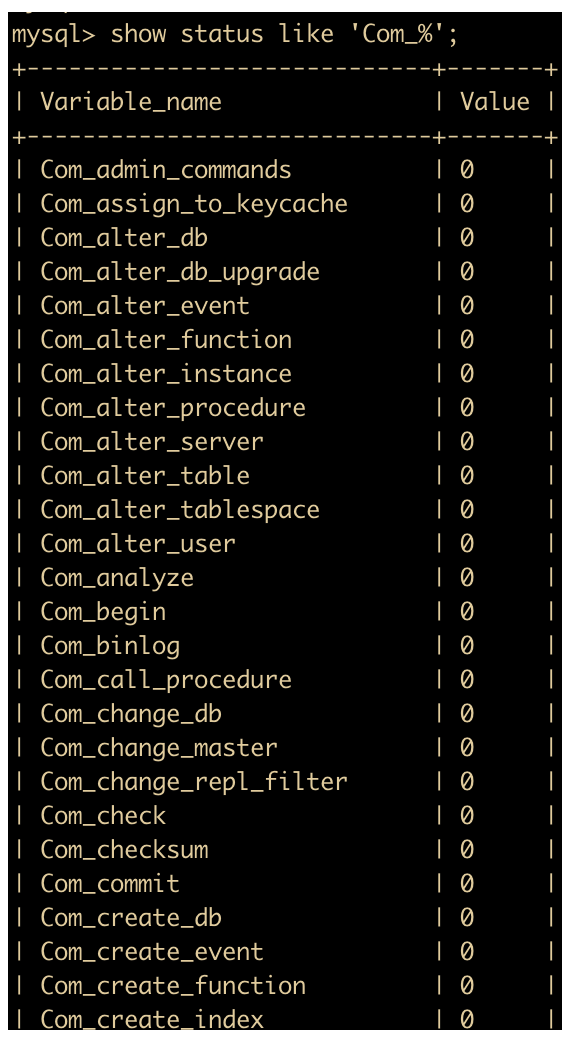

对于 show status 查询出来的统计结果,有两类参数需要注意下,一类是以 Com_ 为开头的参数,一类是以 Innodb_ 为开头的参数。

下面是 Com_ 为开头的参数,参数很多,我同样没有截全。

Com_xxx 表示的是每个 xxx 语句执行的次数,我们通常关心的是 select 、insert 、update、delete 语句的执行次数,即

- Com_select:执行 select 操作的次数,一次查询会使结果 + 1。

- Com_insert:执行 INSERT 操作的次数,对于批量插入的 INSERT 操作,只累加一次。

- Com_update:执行 UPDATE 操作的次数。

- Com_delete:执行 DELETE 操作的次数。

以 Innodb_ 为开头的参数主要有

- Innodb_rows_read:执行 select 查询返回的行数。

- Innodb_rows_inserted:执行 INSERT 操作插入的行数。

- Innodb_rows_updated:执行 UPDATE 操作更新的行数。

- Innodb_rows_deleted:执行 DELETE 操作删除的行数。

通过上面这些参数执行结果的统计,我们能够大致了解到当前数据库是以更新(包括插入、删除)为主还是查询为主。

除此之外,还有一些其他参数用于了解数据库的基本情况。

- Connections:查询 MySQL 数据库的连接次数,这个次数是不管连接是否成功都算上。

- Uptime:服务器的工作时间。

- Slow_queries:满查询次数。

- Threads_connected:查看当前打开的连接的数量。

下面这个博客汇总了几乎所有 show status 的参数,可以当作参考手册。

https://blog.csdn.net/ayay_870621/article/details/88633092

定位执行效率较低的 SQL

定位执行效率比较慢的 SQL 语句,一般有两种方式

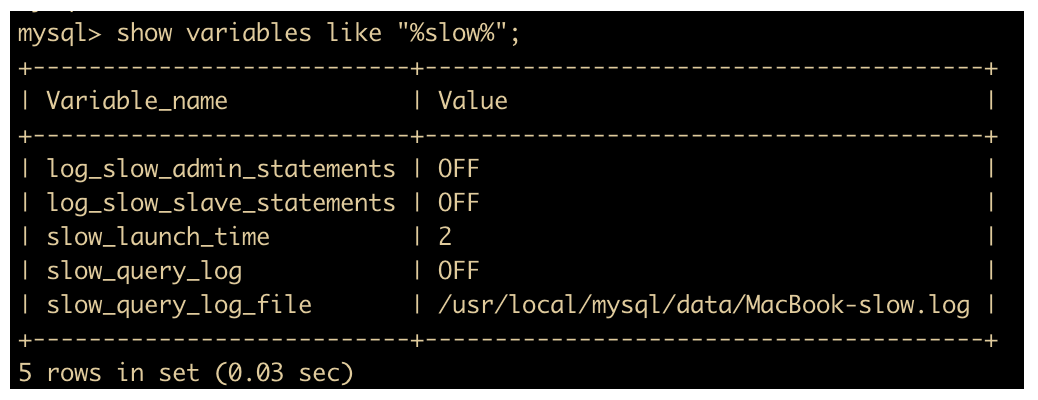

- 可以通过慢查询日志来定位哪些执行效率较低的 SQL 语句。

MySQL 中提供了一个慢查询的日志记录功能,可以把查询 SQL 语句时间大于多少秒的语句写入慢查询日志,日常维护中可以通过慢查询日志的记录信息快速准确地判断问题所在。用 –log-slow-queries 选项启动时,mysqld 会写一个包含所有执行时间超过 long_query_time 秒的 SQL 语句的日志文件,通过查看这个日志文件定位效率较低的 SQL 。

比如我们可以在 my.cnf 中添加如下代码,然后退出重启 MySQL。

log-slow-queries = /tmp/mysql-slow.log long_query_time = 2

通常我们设置最长的查询时间是 2 秒,表示查询时间超过 2 秒就记录了,通常情况下 2 秒就够了,然而对于很多 WEB 应用来说,2 秒时间还是比较长的。

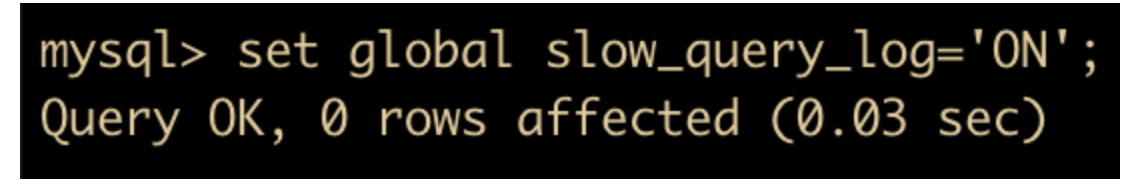

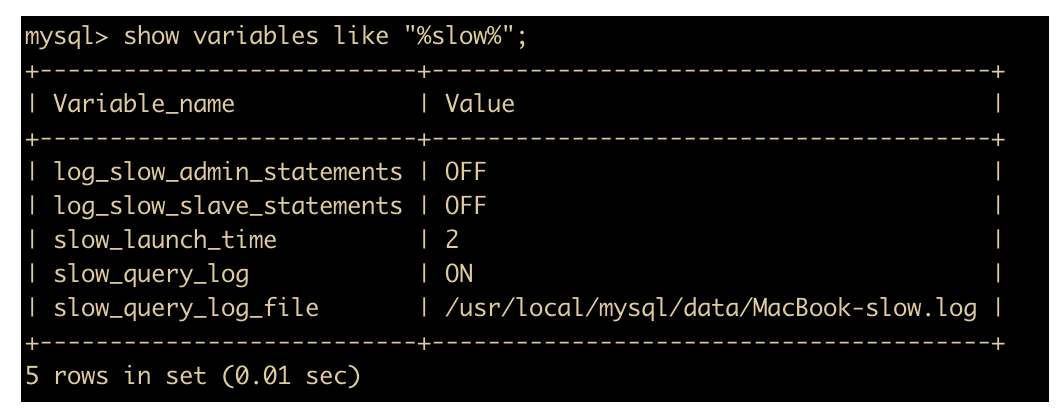

也可以通过命令来开启:

我们先查询 MySQL 慢查询日志是否开启

show variables like "%slow%";

启用慢查询日志

set global slow_query_log='ON';

然后再次查询慢查询是否开启

如图所示,我们已经开启了慢查询日志。

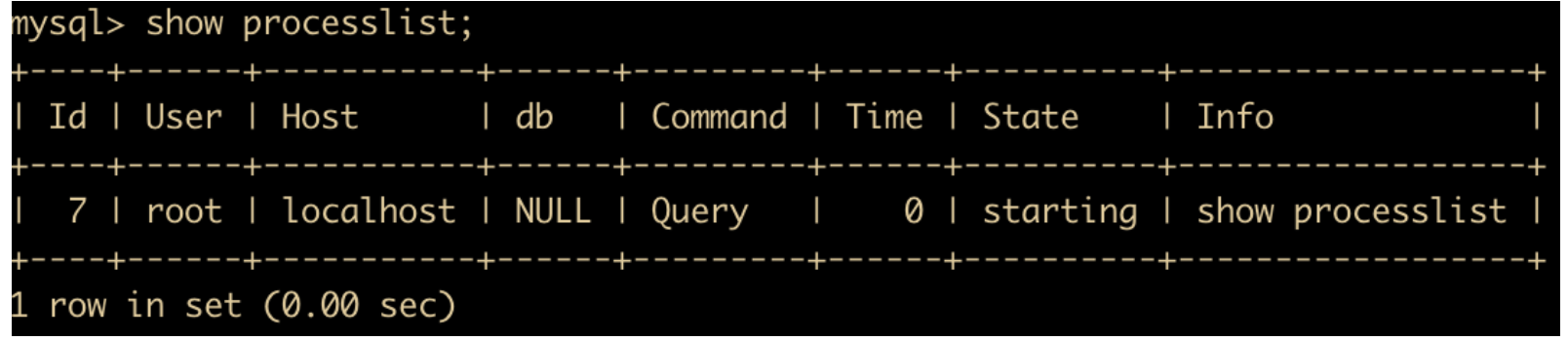

慢查询日志会在查询结束以后才记录,所以在应用反应执行效率出现问题的时候慢查询日志并不能定位问题,此时应该使用 show processlist 命令查看当前 MySQL 正在进行的线程。包括线程的状态、是否锁表等,可以实时的查看 SQL 执行情况。同样,使用mysqladmin processlist语句也能得到此信息。

下面就来解释一下各个字段对应的概念

- Id :Id 就是一个标示,在我们使用 kill 命令杀死进程的时候很有用,比如 kill 进程号。

- User:显示当前的用户,如果不是 root,这个命令就只显示你权限范围内的 SQL 语句。

- Host:显示 IP ,用于追踪问题

- Db:显示这个进程目前连接的是哪个数据库,为 null 是还没有 select 数据库。

- Command:显示当前连接锁执行的命令,一般有三种:查询 query,休眠 sleep,连接 connect。

- Time:这个状态持续的时间,单位是秒

- State:显示当前 SQL 语句的状态,非常重要,下面会具体解释。

- Info:显示这个 SQL 语句。

State 列非常重要,关于这个列的内容比较多,读者可以参考一下这篇文章

https://blog.csdn.net/weixin_34357436/article/details/91768402

这里面涉及线程的状态、是否锁表等选项,可以实时的查看 SQL 的执行情况,同时对一些锁表进行优化。

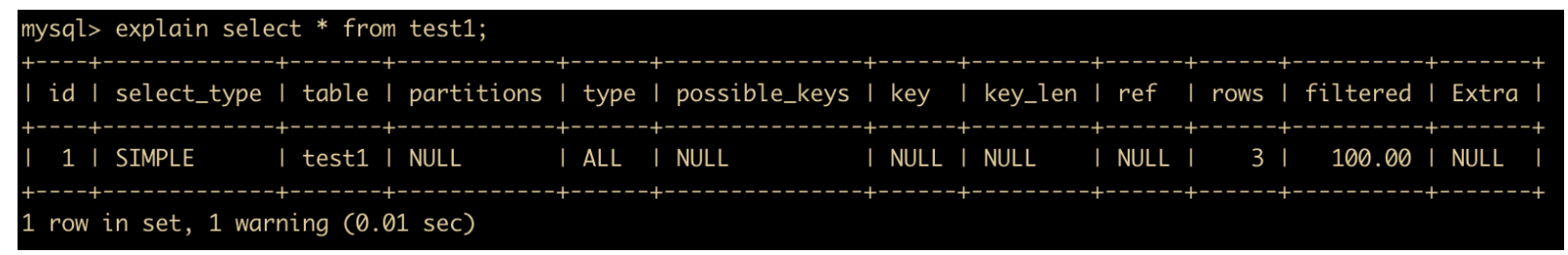

通过 EXPLAIN 命令分析 SQL 的执行计划

通过以上步骤查询到效率低的 SQL 语句后,可以通过 EXPLAIN 或者 DESC 命令获取 MySQL 如何执行 SELECT 语句的信息,包括在 SELECT 语句执行过程中表如何连接和连接的顺序。

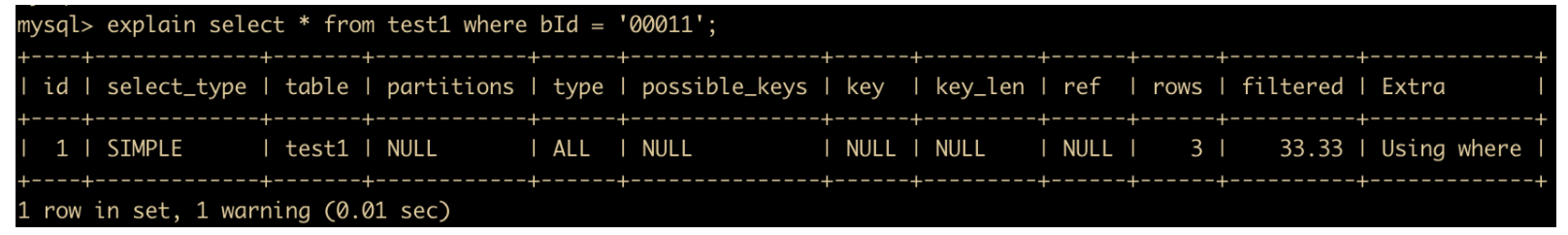

比如我们使用下面这条 SQL 语句来分析一下执行计划

explain select * from test1;

上表中涉及内容如下

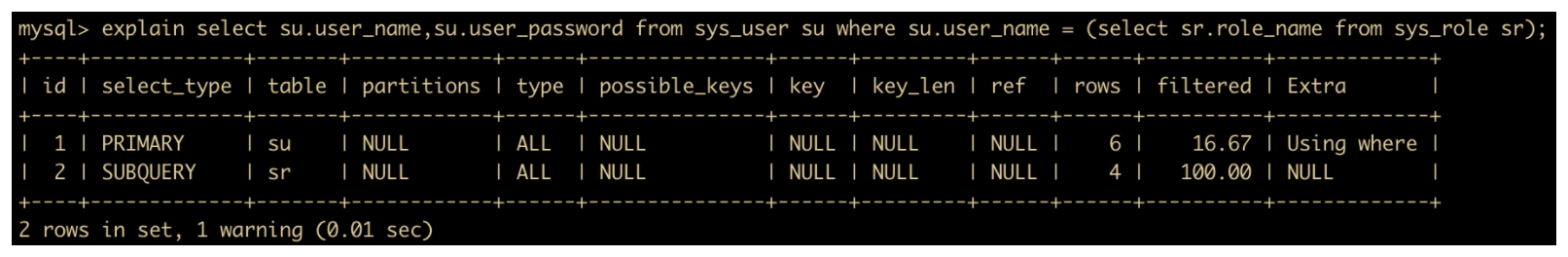

- select_type:表示常见的 SELECT 类型,常见的有 SIMPLE,SIMPLE 表示的是简单的 SQL 语句,不包括 UNION 或者子查询操作,比如下面这段就是 SIMPLE 类型。

PRIMARY ,查询中最外层的 SELECT(如两表做 UNION 或者存在子查询的外层的表操作为 PRIMARY,内层的操作为 UNION),比如下面这段子查询。

UNION,在 UNION 操作中,查询中处于内层的 SELECT(内层的 SELECT 语句与外层的 SELECT 语句没有依赖关系时)。

SUBQUERY:子查询中首个SELECT(如果有多个子查询存在),如我们上面的查询语句,子查询第一个是 sr(sys_role)表,所以它的 select_type 是 SUBQUERY。

table ,这个选项表示输出结果集的表。

type,这个选项表示表的连接类型,这个选项很有深入研究的价值,因为很多 SQL 的调优都是围绕 type 来讲的,但是这篇文章我们主要围绕优化方式来展开的,type 这个字段我们暂时作为了解,这篇文章不过多深入。

type 这个字段会牵扯到连接的性能,它的不同类型的性能由好到差分别是

system :表中仅有一条数据时,该表的查询就像查询常量表一样。

const :当表中只有一条记录匹配时,比如使用了表主键(primary key)或者表唯一索引(unique index)进行查询。

eq-ref :表示多表连接时使用表主键或者表唯一索引,比如

select A.text, B.text where A.ID = B.ID

这个查询语句,对于 A 表中的每一个 ID 行,B 表中都只能有唯一的 B.Id 来进行匹配时。

ref :这个类型不如上面的 eq-ref 快,因为它表示的是因为对于表 A 中扫描的每一行,表 C 中有几个可能的行,C.ID 不是唯一的。

ref_or_null :与 ref 类似,只不过这个选项包含对 NULL 的查询。

index_merge :查询语句使用了两个以上的索引,比如经常在有 and 和 or 关键字出现的场景,但是在由于读取索引过多导致其性能有可能还不如 range(后面说)。

unique_subquery :这个选项经常用在 in 关键字后面,子查询带有 where 关键字的子查询中,用 sql 来表示就是这样

value IN (SELECT primary_key FROM single_table WHERE some_expr)

range :索引范围查询,常见于使用 =,<>,>,>=,<,<=,IS NULL,<=>,BETWEEN,IN() 或者 like 等运算符的查询中。

index :索引全表扫描,把索引从头到尾扫一遍。

all : 这个我们接触的最多了,就是全表查询,select * from xxx ,性能最差。

上面就是 type 内容的大致解释,关于 type 我们经常会在 SQL 调优的环节使用 explain 分析其类型,然后改进查询方式,越靠近 system 其查询效率越高,越靠近 all 其查询效率越低。

- possible_keys :表示查询时,可能使用的索引。

- key :表示实际使用的索引。

- key_len :索引字段的长度。

- rows :扫描行的数量。

- filtered :通过查询条件查询出来的 SQL 数量占用总行数的比例。

- extra :执行情况的描述。

通过上面的分析,我们可以大致确定 SQL 效率低的原因,一种非常有效的提升 SQL 查询效率的方式就是使用索引,接下来我会讲解一下如何使用索引提高查询效率。

索引

索引是数据库优化中最常用也是最重要的手段,通过使用不同的索引可以解决大多数 SQL 性能问题,也是面试经常会问到的优化方式,围绕着索引,面试官能让你造出火箭来,所以总结一点就是索引非常非常重!要!不只是使用,你还要懂其原!理!

索引介绍

索引的目的就是用于快速查找某一列的数据,对相关数据列使用索引能够大大提高查询操作的性能。不使用索引,MySQL 必须从第一条记录开始读完整个表,直到找出相关的行,表越大查询数据所花费的时间就越多。如果表中查询的列有索引,MySQL 能够快速到达一个位置去搜索数据文件,而不必查看所有数据,那么将会节省很大一部分时间。

索引分类

先来了解一下索引都有哪些分类。

全局索引(FULLTEXT):全局索引,目前只有 MyISAM 引擎支持全局索引,它的出现是为了解决针对文本的模糊查询效率较低的问题,并且只限于 CHAR、VARCHAR 和 TEXT 列。哈希索引(HASH):哈希索引是 MySQL 中用到的唯一 key-value 键值对的数据结构,很适合作为索引。HASH 索引具有一次定位的好处,不需要像树那样逐个节点查找,但是这种查找适合应用于查找单个键的情况,对于范围查找,HASH 索引的性能就会很低。默认情况下,MEMORY 存储引擎使用 HASH 索引,但也支持 BTREE 索引。B-Tree 索引:B 就是 Balance 的意思,BTree 是一种平衡树,它有很多变种,最常见的就是 B+ Tree,它被 MySQL 广泛使用。R-Tree 索引:R-Tree 在 MySQL 很少使用,仅支持 geometry 数据类型,支持该类型的存储引擎只有MyISAM、BDb、InnoDb、NDb、Archive几种,相对于 B-Tree 来说,R-Tree 的优势在于范围查找。

从逻辑上来对 MySQL 进行分类,主要分为下面这几种

普通索引:普通索引是最基础的索引类型,它没有任何限制 。创建方式如下

create index normal_index on cxuan003(id);

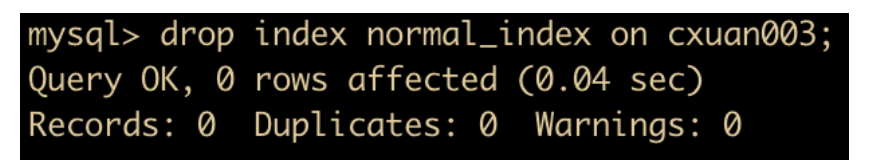

删除方式

drop index normal_index on cxuan003;

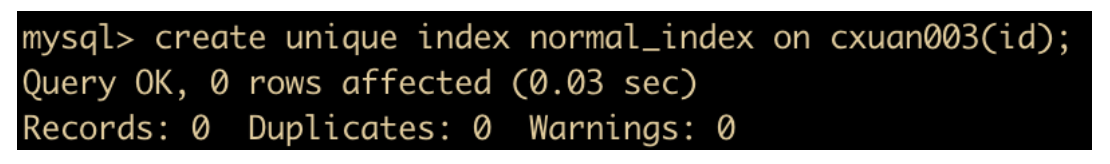

唯一索引:唯一索引列的值必须唯一,允许有空值,如果是组合索引,则列值的组合必须唯一,创建方式如下

create unique index normal_index on cxuan003(id);

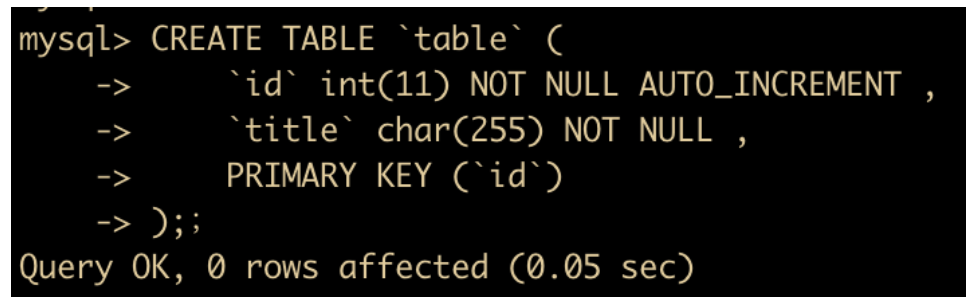

主键索引:是一种特殊的索引,一个表只能有一个主键,不允许有空值。一般是在建表的时候同时创建主键索引。

CREATE TABLE

table(idint(11) NOT NULL AUTO_INCREMENT ,titlechar(255) NOT NULL , PRIMARY KEY (id) )

组合索引:指多个字段上创建的索引,只有在查询条件中使用了创建索引时的第一个字段,索引才会被使用。使用组合索引时遵循最左前缀原则,下面我们就会创建组合索引。

全文索引:主要用来查找文本中的关键字,而不是直接与索引中的值相比较,目前只有 char、varchar,text 列上可以创建全文索引,创建表的适合添加全文索引

CREATE TABLE

table(idint(11) NOT NULL AUTO_INCREMENT ,titlechar(255) CHARACTER NOT NULL ,contenttext CHARACTER NULL ,timeint(10) NULL DEFAULT NULL , PRIMARY KEY (id), FULLTEXT (content) );当然也可以直接创建全局索引

CREATE FULLTEXT INDEX index_content ON article(content)

索引使用

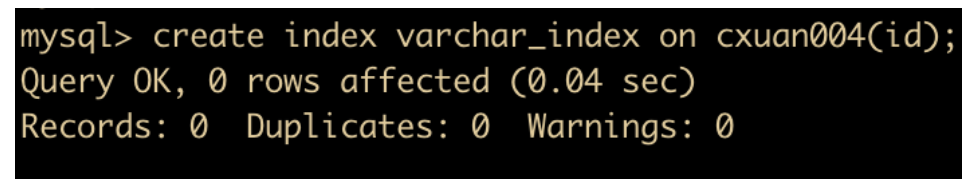

索引可以在创建表的时候进行创建,也可以单独创建,下面我们采用单独创建的方式,我们在 cxuan004 上创建前缀索引

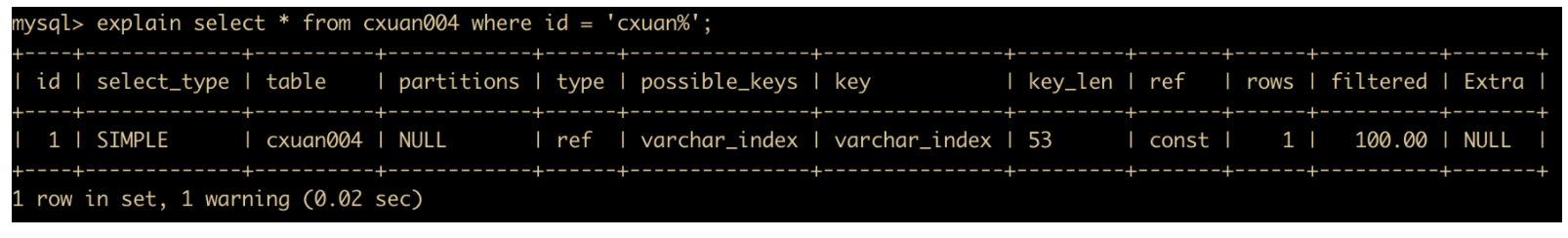

我们使用 explain 进行分析,可以看到 cxuan004 使用索引的情况

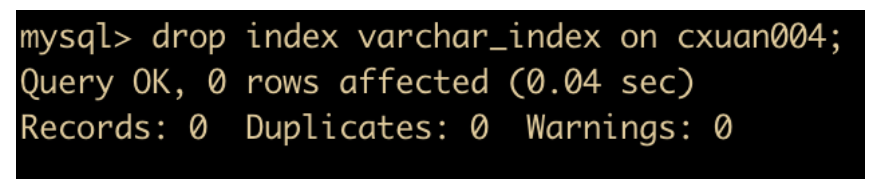

如果不想使用索引,可以删除索引,索引的删除语法是

索引使用细则

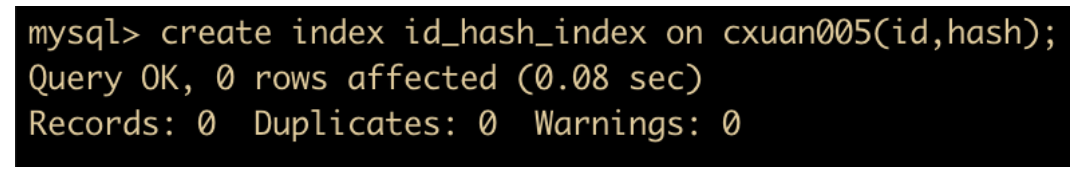

我们在 cxuan005 上根据 id 和 hash 创建一个复合索引,如下所示

create index id_hash_index on cxuan005(id,hash);

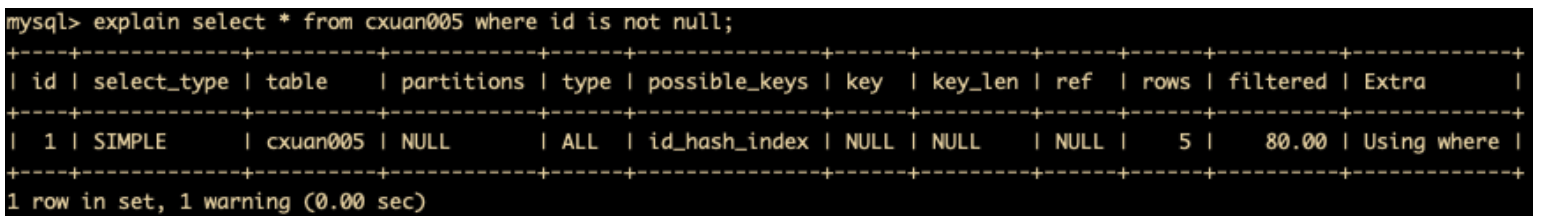

然后根据 id 进行执行计划的分析

explain select * from cxuan005 where id = '333';

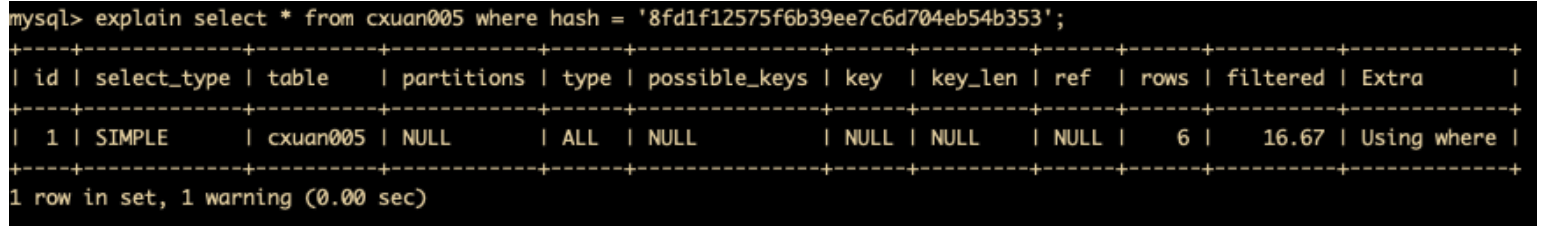

可以发现,即使 where 条件中使用的不是复合索引(Id 、hash),索引仍然能够使用,这就是索引的前缀特性。但是如果只按照 hash 进行查询的话,索引就不会用到。

explain select * from cxuan005 where hash='8fd1f12575f6b39ee7c6d704eb54b353';

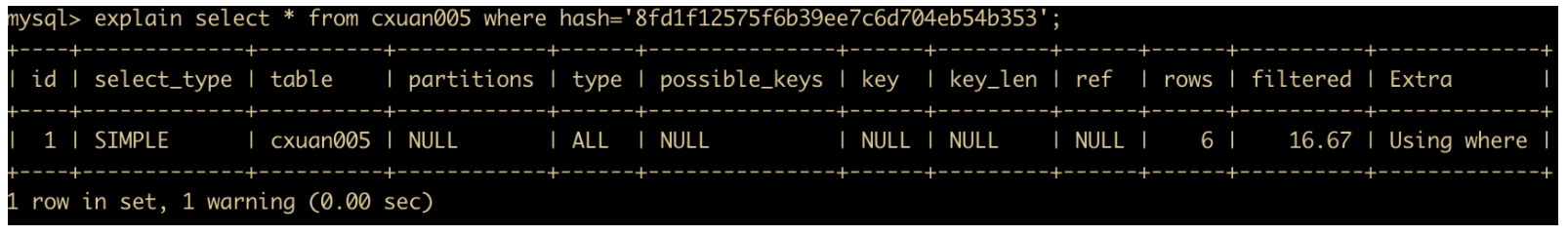

如果 where 条件使用了 like 查询,并且 % 不在第一个字符,索引才可能被使用。

对于复合索引来说,只能使用 id 进行 like 查询,因为 hash 列不管怎么查询都不会走索引。

explain select * from cxuan005 where id like '%1';

可以看到,如果第一个字符是 % ,则没有使用索引。

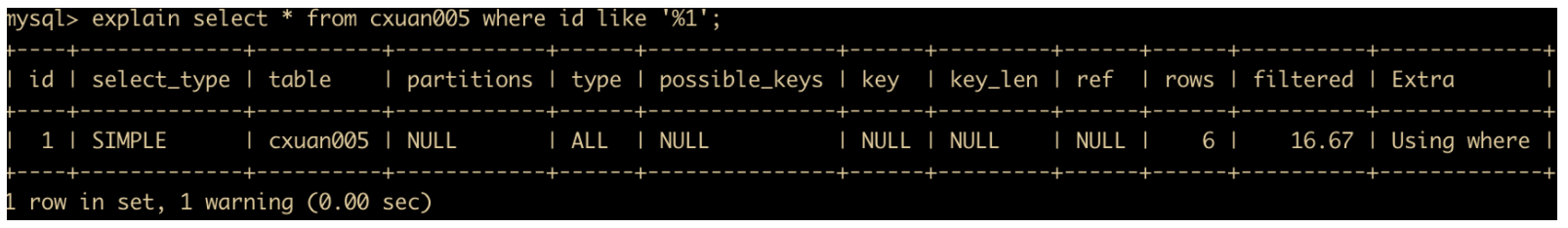

explain select * from cxuan005 where id like '1%';

如果使用了 % 号,就会触发索引。

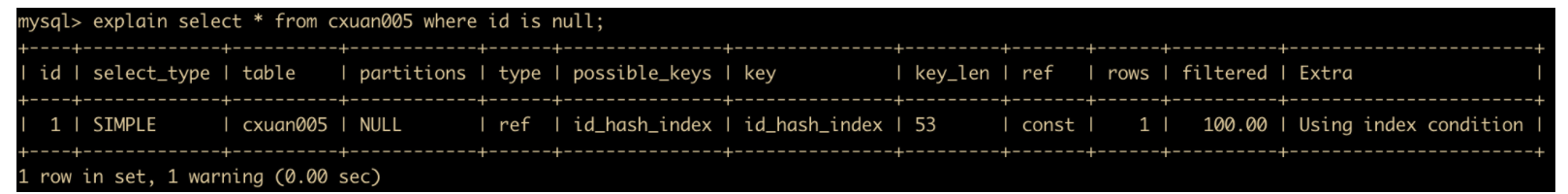

如果列名是索引的话,那么对列名进行 NULL 查询,将会触发索引。

explain select * from cxuan005 where id is null;

还有一些情况是存在索引但是 MySQL 并不会使用的情况。

最简单的,如果使用索引后比不使用索引的效率还差,那么 MySQL 就不会使用索引。

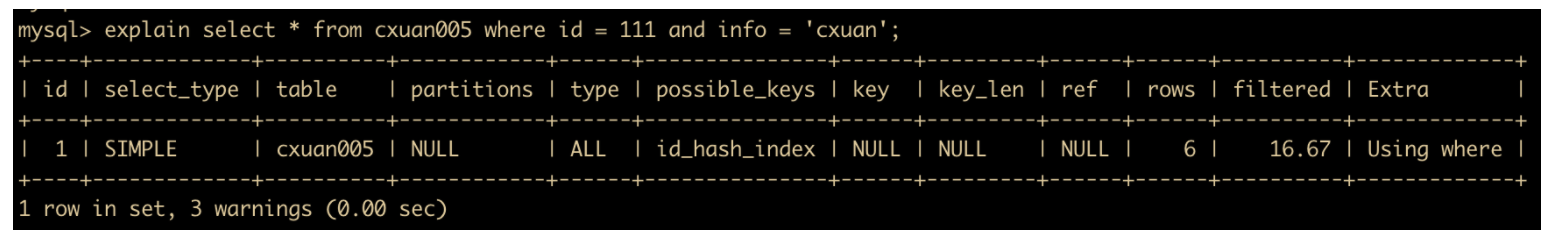

如果 SQL 中使用了 OR 条件,OR 前的条件列有索引,而后面的列没有索引的话,那么涉及到的索引都不会使用,比如 cxuan005 表中,只有 id 和 hash 字段有索引,而 info 字段没有索引,那么我们使用 or 进行查询。

explain select * from cxuan005 where id = 111 and info = 'cxuan';

我们从 explain 的执行结果可以看到,虽然 possible_keys 选项上仍然有 id_hash_index 索引,但是从 key、key_len 可以得知,这条 SQL 语句并未使用索引。

在带有复合索引的列上查询不是第一列的数据,也不会使用索引。

explain select * from cxuan005 where hash = '8fd1f12575f6b39ee7c6d704eb54b353';

如果 where 条件的列参与了计算,那么也不会使用索引

explain select * from cxuan005 where id + '111' = '666';

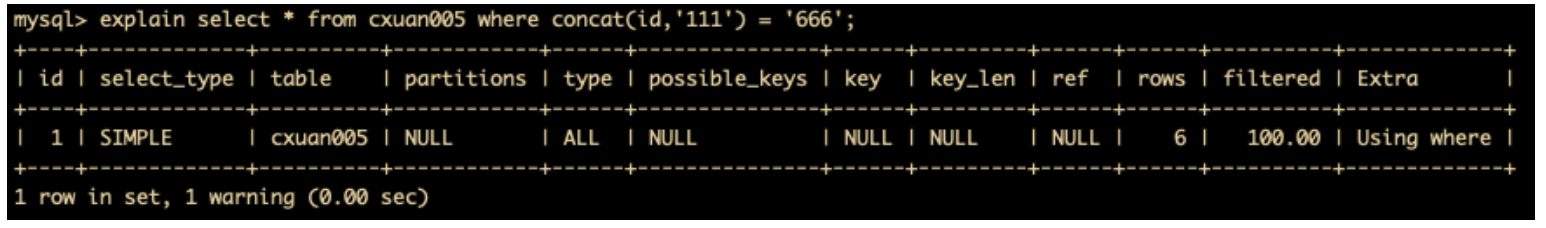

索引列使用函数,一样也不会使用索引

explain select * from cxuan005 where concat(id,'111') = '666';

索引列使用了 like ,并且

%位于第一个字符,则不会使用索引。在 order by 操作中,排序的列同时也在 where 语句中,将不会使用索引。

当数据类型出现隐式转换时,比如 varchar 不加单引号可能转换为 int 类型时,会使索引无效,触发全表扫描。比如下面这两个例子能够显而易见的说明这一点

在索引列上使用 IS NOT NULL 操作

在索引字段上使用 <>,!=。不等于操作符是永远不会用到索引的,因此对它的处理只会产生全表扫描。

关于设置索引但是索引没有生效的场景还有很多,这个需要小伙伴们工作中不断总结和完善,不过我上面总结的这些索引失效的情景,能够覆盖大多数索引失效的场景了。

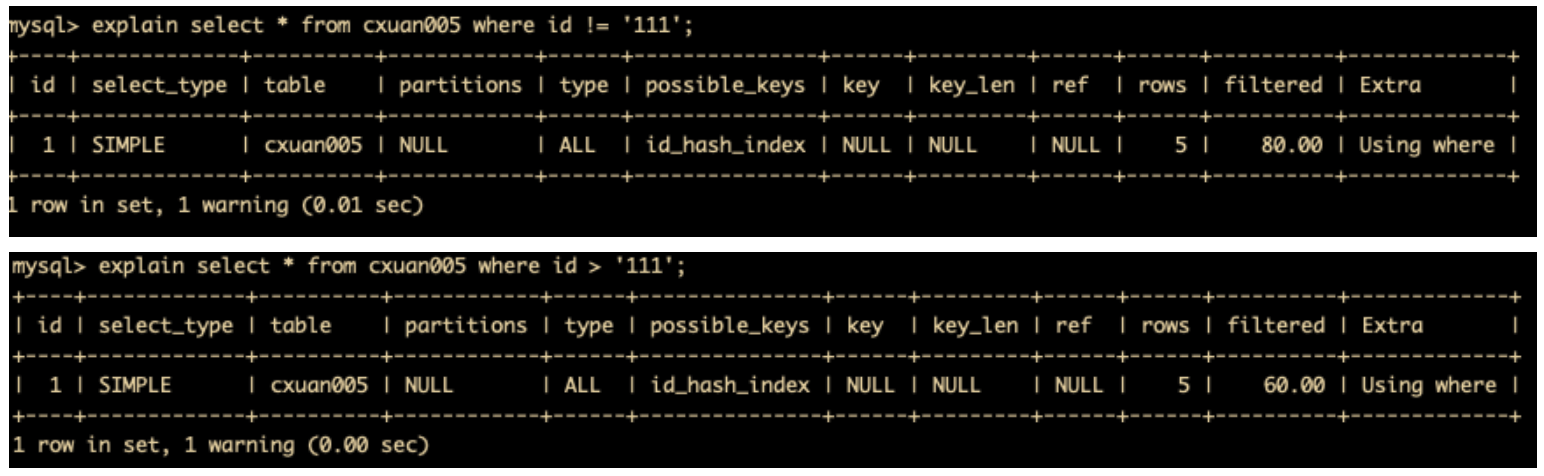

查看索引的使用情况

在 MySQL 索引的使用过程中,有一个 Handler_read_key 值,这个值表示了某一行被索引值读的次数。 Handler_read_key 的值比较低的话,则表明增加索引得到的性能改善不是很理想,可能索引使用的频率不高。

还有一个值是 Handler_read_rnd_next,这个值高则意味着查询运行效率不高,应该建立索引来进行抢救。这个值的含义是在数据文件中读下一行的请求数。如果正在进行大量的表扫描,Handler_read_rnd_next 的值比较高,就说明表索引不正确或写入的查询没有利用索引。

MySQL 分析表、检查表和优化表

对于大多数开发者来说,他们更倾向于解决简单 SQL的优化,而复杂 SQL 的优化交给了公司的 DBA 来做。

下面就从普通程序员的角度和你聊几个简单的优化方式。

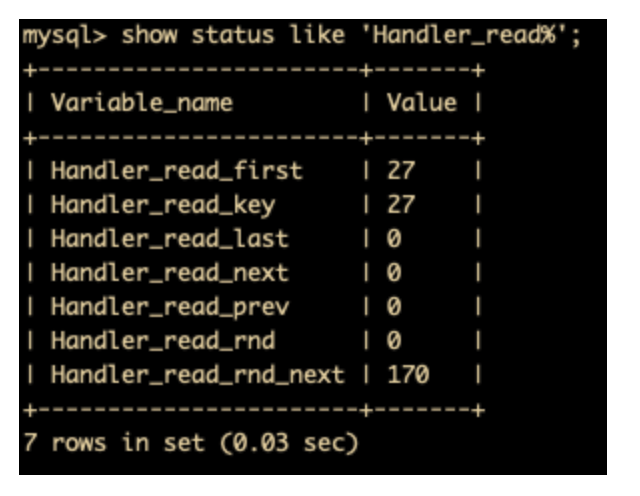

MySQL 分析表

分析表用于分析和存储表的关键字分布,分析的结果可以使得系统得到准确的统计信息,使得 SQL 生成正确的执行计划。如果用于感觉实际执行计划与预期不符,可以执行分析表来解决问题,分析表语法如下

analyze table cxuan005;

分析结果涉及到的字段属性如下

Table:表示表的名称;

Op:表示执行的操作,analyze 表示进行分析操作,check 表示进行检查查找,optimize 表示进行优化操作;

Msg_type:表示信息类型,其显示的值通常是状态、警告、错误和信息这四者之一;

Msg_text:显示信息。

对表的定期分析可以改善性能,应该成为日常工作的一部分。因为通过更新表的索引信息对表进行分析,可改善数据库性能。

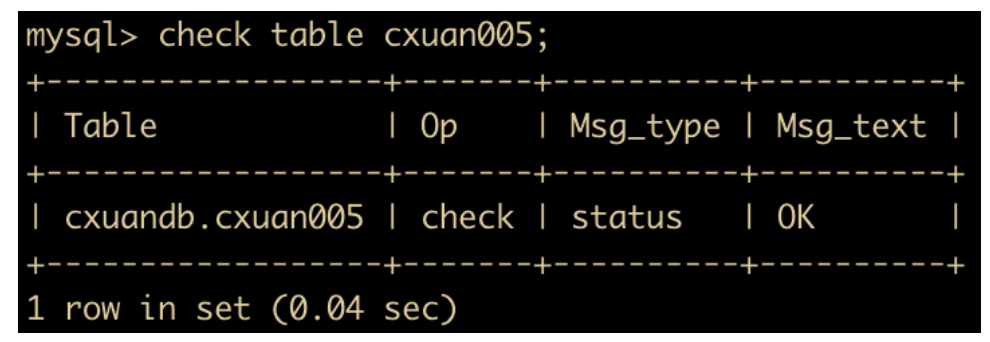

MySQL 检查表

数据库经常可能遇到错误,比如数据写入磁盘时发生错误,或是索引没有同步更新,或是数据库未关闭 MySQL 就停止了。遇到这些情况,数据就可能发生错误: Incorrect key file for table: ‘ ‘. Try to repair it. 此时,我们可以使用 Check Table 语句来检查表及其对应的索引。

check table cxuan005;

检查表的主要目的就是检查一个或者多个表是否有错误。Check Table 对 MyISAM 和 InnoDB 表有作用。Check Table 也可以检查视图的错误。

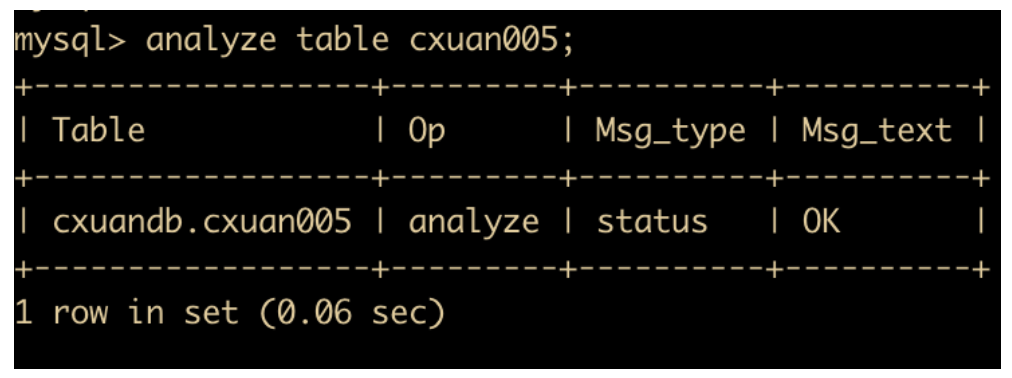

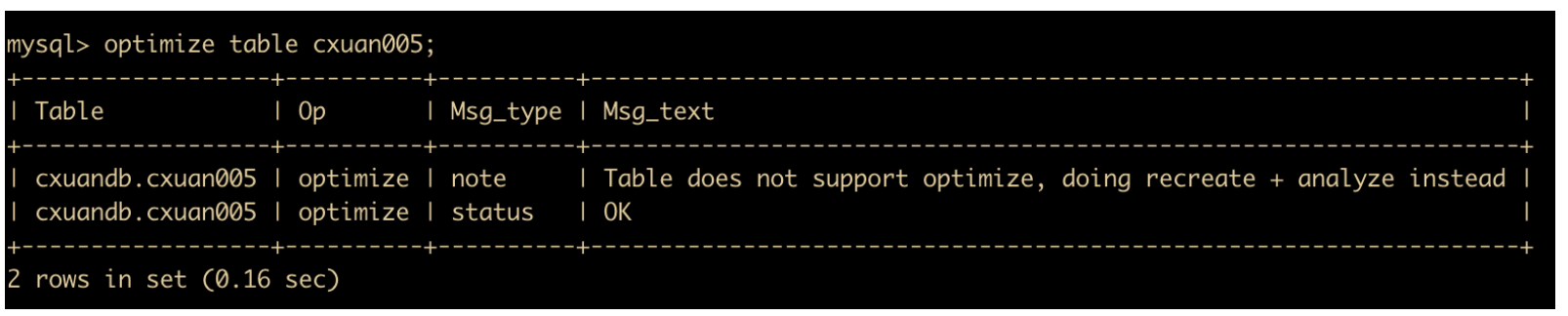

MySQL 优化表

MySQL 优化表适用于删除了大量的表数据,或者对包含 VARCHAR、BLOB 或则 TEXT 命令进行大量修改的情况。MySQL 优化表可以将大量的空间碎片进行合并,消除由于删除或者更新造成的空间浪费情况。它的命令如下

optimize table cxuan005;

我的存储引擎是 InnoDB 引擎,但是从图可以知道,InnoDB 不支持使用 optimize 优化,建议使用 recreate + analyze 进行优化。optimize 命令只对 MyISAM 、BDB 表起作用。

常用 SQL 优化

前面我们介绍了使用索引来优化 MySQL ,那么对于 SQL 的各种语法,句法来说,应该怎样优化呢?下面,我会从 SQL 命令的角度来聊一波 SQL 优化。

导入的优化

对于 MyISAM 类型的表,可以通过下面这种方式导入大量的数据

ALTER TABLE tblname DISABLE KEYS; loading the data ALTER TABLE tblname ENABLE KEYS;

这两个命令用来打开或者关闭 MyISAM 表非唯一索引的更新。在导入大量的数据到一个非空的 MyISAM 表时,通过设置这两个命令,可以提高导入的效率。对于导入大量数据到一个空的 MyISAM 表,默认就是先导入数据然后才创建索引,所以不用进行设置。

但是对于 InnoDB 搜索引擎的表来说,这样做不能提高导入效率,我们有以下几种方式可以提高导入的效率:

- 因为 InnoDB 类型的表是按照主键的顺序保存的,所以将导入的数据按照主键的顺序排列,可以有效的提高导入数据的效率。如果 InnoDB 表没有主键,那么系统会默认创建一个内部列作为主键,所以如果可以给表创建一个主键,将可以利用这个优势提高导入数据的效率。

- 在导入数据前执行 SET UNIQUE_CHECKS = 0,关闭唯一性校验,在导入结束后执行SETUNIQUE_CHECKS = 1,恢复唯一性校验,可以提高导入的效率。

- 如果应用使用自动提交的方式,建议在导入前执行 SET AUTOCOMMIT = 0,关闭自动提交,导入结束后再执行 SET AUTOCOMMIT = 1,打开自动提交,也可以提高导入的效率。

insert 的优化

当进行插入语句的时候,可以考虑采用下面这几种方式进行优化

- 如果向同一张表插入多条数据的话,最好一次性插入,这样可以减少数据库建立连接 -> 断开连接的时间,如下所示

insert into test values(1,2),(1,3),(1,4)

- 如果向不同的表插入多条数据,可以使用 insert delayed 语句提高执行效率。delayed 的含义是让 insert 语句马上执行,要么数据都会放在内存的队列中,并没有真正写入磁盘。

- 对于 MyISAM 表来说,可以增加 bulk_insert_buffer_size 的值提高插入效率。

- 最好将索引和数据文件在不同的磁盘上存放。

group by 的优化

在使用分组和排序的场景下,如果先进行 Group By 再进行 Order By 的话,可以指定 order by null 禁止排序,因为 order by null 可以避免 filesort ,filesort 往往很耗费时间。如下所示

explain select id,sum(moneys) from sales2 group by id order by null;

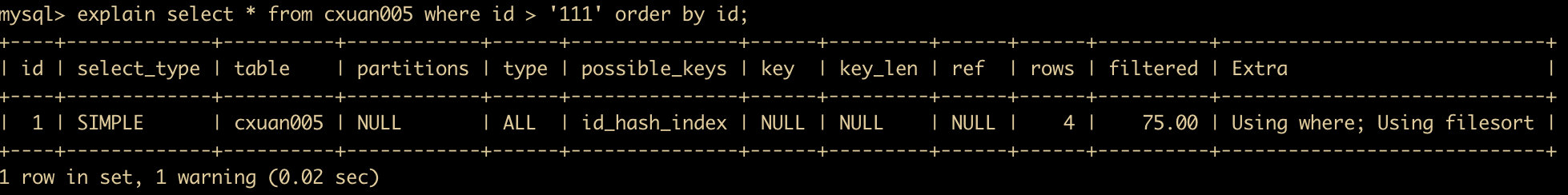

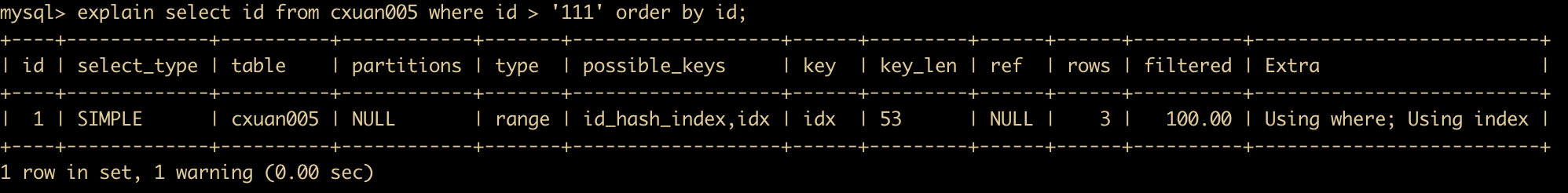

order by 的优化

在执行计划中,经常可以看到 Extra 列出现了 filesort,filesort 是一种文件排序,这种排序方式比较慢,我们认为是不好的排序,需要进行优化。

优化的方式是要使用索引。

我们在 cxuan005 上创建一个索引。

create index idx on cxuan005(id);

然后我们使用查询字段和排序相同的顺序进行查询。

explain select id from cxuan005 where id > '111' order by id;

可以看到,在这次查询中,使用的是 Using index。这表明我们使用的是索引。

如果创建索引和 order by 的顺序不一致,将会使用 Using filesort。

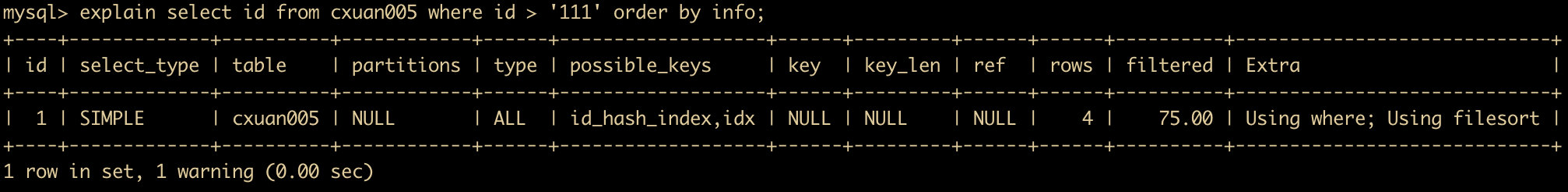

explain select id from cxuan005 where id > '111' order by info;

MySQL 支持两种方式的排序,filesort 和 index,Using index 是指 MySQL 扫描索引本身完成排序。index 效率高,filesort 效率低。

order by 在满足下面这些情况下才会使用 index

- order by 语句使用索引最左前列。

- 使用 where 子句与 order by 子句条件列组合满足索引最左前列。

优化嵌套查询

嵌套查询是我们经常使用的一种查询方式,这种查询方式可以使用 SELECT 语句来创建一个单独的查询结果,然后把这个结果当作嵌套语句的查询范围用在另一个查询语句中。使用时子查询可以将一个复杂的查询拆分成一个个独立的部分,逻辑上更易于理解以及代码的维护和重复使用。

但是某些情况下,子查询的效率不高,一般使用 join 来替代子查询。

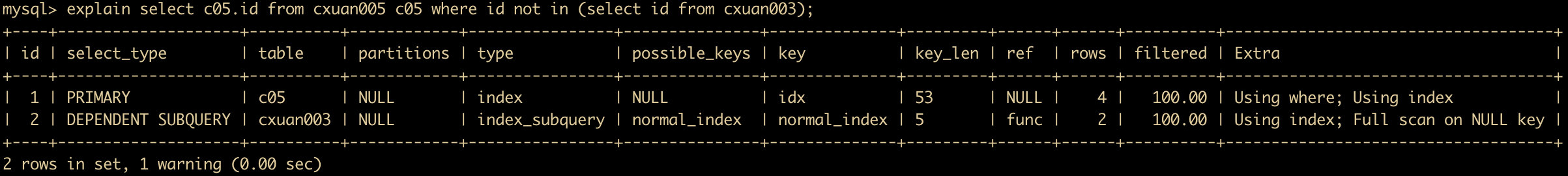

使用嵌套查询的 SQL 语句进行 explain 分析如下

explain select c05.id from cxuan005 c05 where id not in (select id from cxuan003);

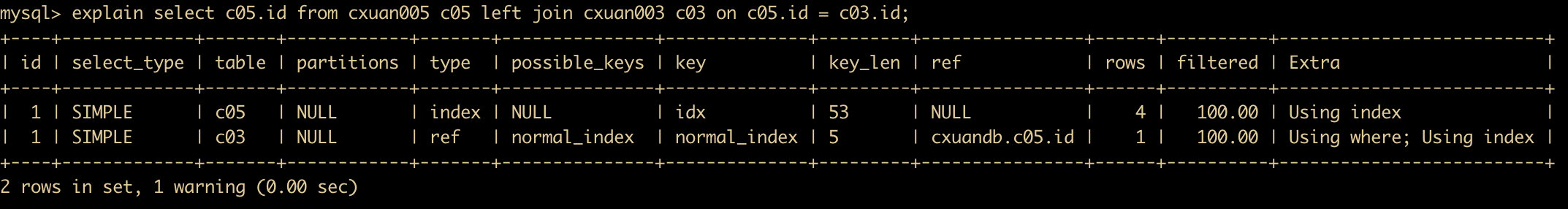

从 explain 的结果可以看出,主表的查询是 index ,子查询是 index_subquery ,这两个执行效率都不高。我们使用 join 来优化后的分析计划如下。

explain select c05.id from cxuan005 c05 left join cxuan003 c03 on c05.id = c03.id;

从 explain 分析结果可以看到,主表查询和子查询分别是 index 和 ref,而 ref 的执行效率相对较高,一般 type 的效率由高到低是 System–>const–>eq_ref–>ref–> fulltext–>ref_or_null–>index_merge–>unique_subquery–>index_subquery–>range–>index–>all 。

count 的优化

count 我们大家用的太多了,一般都用来统计某一列结果集的行数,当 MySQL 确认括号内的表达式不可能为空时,实际上就是在统计行数。

其实 count 还有另一层统计方式:统计某个列值的数量,在统计列值数量的时候,它默认不会统计 NULL 值。

我们经常犯的一个错误就是,在括号内指定一个列但是却希望统计结果集的行数。如果想要知道结果集行数的话,最好使用 count(*)。

limit 分页的优化

通常我们的系统会进行分页,一般情况下我们会使用 limit 加上偏移量来实现。同时还会加上 order by 语句进行排序。如果使用索引的情况下,效率一般不会有什么问题,如果没有使用索引的话,MySQL 就可能会做大量的文件排序操作。

通常我们可能会遇到比如 limit 1000 , 50 这种情况,抛弃 1000 条,只取 50 条,这样的代价非常高,如果所有页面被访问的频率相同,那么这样的查询平均需要访问半个表的数据。

要优化这种查询,要么限制分页的数量,要么优化大偏移量的性能。

SQL 中 IN 包含的值不应该太多

MySQL 中对 IN 做了相应的优化,MySQL 会将全部的常量存储在一个数组里面,如果数值较多,产生的消耗也会变大,比如

select name from dual where num in(4,5,6)

像这种 SQL 语句的话,能用 between 使用就不要再使用 in 了。

只需要一条数据的情况

如果只需要一条数据的情况下,推荐使用 limit 1,这样会使执行计划中的 type 变为 const。

如果没有使用索引,就尽量减少排序

尽量用 union all 来代替 union

union 和 union all 的差异主要是前者需要将结果集合并后再进行唯一性过滤操作,这就会涉及到排序,增加大量的 CPU 运算,加大资源消耗及延迟。当然,union all 的前提条件是两个结果集没有重复数据。

where 条件优化

避免在 WHERE 字句中对字段进行 NULL 判断

避免在 WHERE 中使用 != 或 <> 操作符

不建议使用 % 前缀模糊查询,例如 LIKE “%name”或者LIKE “%name%”,这种查询会导致索引失效而进行全表扫描。但是可以使用LIKE “name%”。

避免在 where 中对字段进行表达式操作,比如 *select user_id,user_project from table_name where age2=36 就是一种表达式操作,建议改为 select user_id,user_project from table_name where age=36/2 **

建议在 where 子句中确定 column 的类型,避免 column 字段的类型和传入的参数类型不一致的时候发生的类型转换。

查询时,尽量指定查询的字段名

我们在日常使用 select 查询时,尽量使用 select 字段名 这种方式,避免直接 *select **,这样增加很多不必要的消耗(cpu、io、内存、网络带宽);而且查询效率比较低。

# MySQL入门大全-Java面试题

SQL 基础使用

MySQL 是一种关系型数据库,说到关系,那么就离不开表与表之间的关系,而最能体现这种关系的其实就是我们接下来需要介绍的主角 SQL,SQL 的全称是 Structure Query Language ,结构化的查询语言,它是一种针对表关联关系所设计的一门语言,也就是说,学好 MySQL,SQL 是基础和重中之重。SQL 不只是 MySQL 中特有的一门语言,大多数关系型数据库都支持这门语言。

下面我们就来一起学习一下这门非常重要的语言。

查询语言分类

在了解 SQL 之前我们需要知道下面这几个概念

数据定义语言: 简称

DDL(Data Definition Language),用来定义数据库对象:数据库、表、列等;数据操作语言: 简称

DML(Data Manipulation Language),用来对数据库中表的记录进行更新。关键字: insert、update、delete等数据控制语言: 简称

DCL(Data Control Language),用来定义数据库访问权限和安全级别,创建用户等。关键字: grant等数据查询语言: 简称

DQL(Data Query Language),用来查询数据库中表的记录,关键字: select from where等

DDL 语句

创建数据库

下面就开始我们的 SQL 语句学习之旅,首先你需要启动 MySQL 服务,我这里是 mac 电脑,所以我直接可以启动

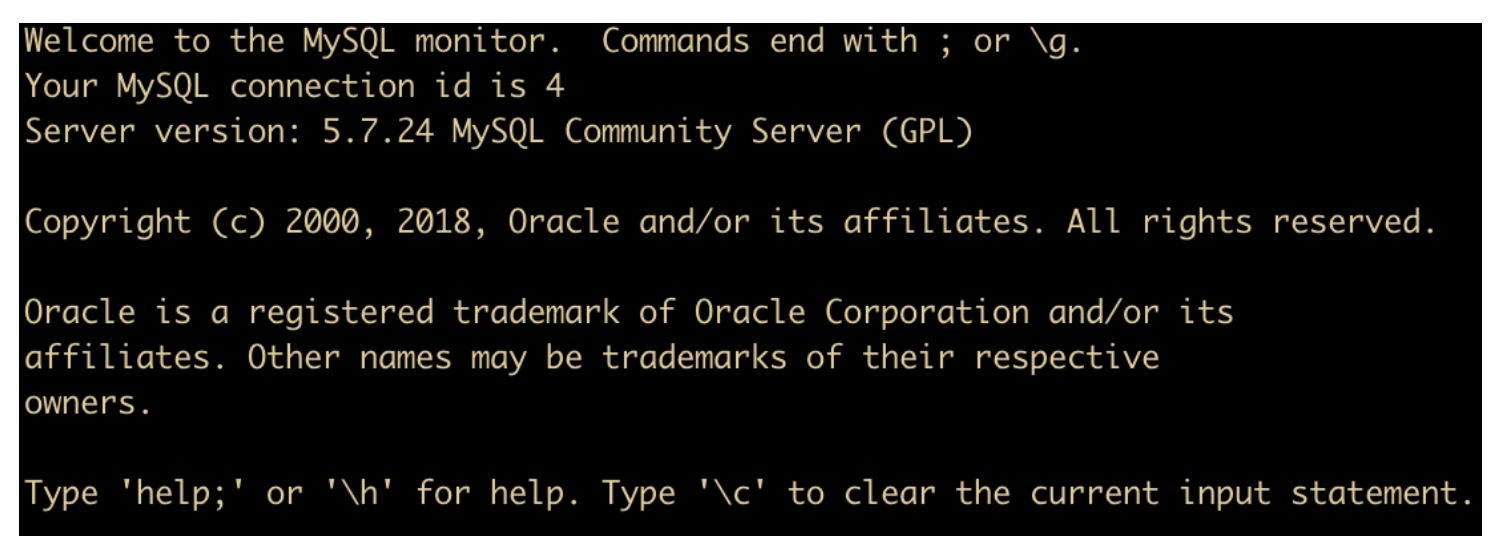

然后我们使用命令行的方式连接数据库,打开 iterm,输入下面

MacBook:~ mr.l$ mysql -uroot -p

就可以连接到数据库了

在上面命令中,mysql 代表客户端命令,- u 表示后面需要连接的用户,-p 表示需要输入此用户的密码。在你输入用户名和密码后,如果成功登陆,会显示一个欢迎界面(如上图 )和 mysql> 提示符。

欢迎界面主要描述了这些东西

- 每一行的结束符,这里用

;或者\g来表示每一行的结束 - Your MySQL connection id is 4,这个记录了 MySQL 服务到目前为止的连接数,每个新链接都会自动增加 1 ,上面显示的连接次数是 4 ,说明我们只连接了四次

- 然后下面是 MySQL 的版本,我们使用的是 5.7

- 通过

help或者\h命令来显示帮助内容,通过\c命令来清除命令行 buffer。

然后需要做的事情是什么?我们最终想要学习 SQL 语句,SQL 语句肯定是要查询数据,通过数据来体现出来表的关联关系,所以我们需要数据,那么数据存在哪里呢?数据存储的位置被称为 表(table),表存储的位置被称为 数据库(database),所以我们需要先建数据库后面再建表然后插入数据,再进行查询。

所以我们首先要做的就是创建数据库,创建数据库可以直接使用指令

CREATE DATABASE dbname;

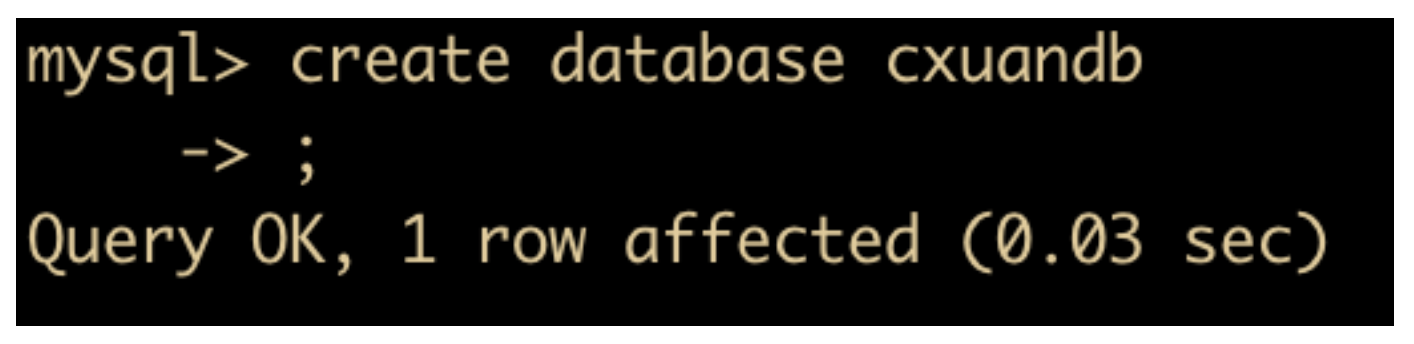

进行创建,比如我们创建数据库 cxuandb

create database cxuandb;

注意最后的 ; 结束语法一定不要丢掉,否则 MySQL 会认为你的命令没有输出完,敲 enter 后会直接换行输出

创建完成后,会提示 Query OK, 1 row affected,这段语句什么意思呢? Query OK 表示的就是查询完成,为什么会显示这个?因为所有的 DDL 和 DML 操作执行完成后都会提示这个, 也可以理解为操作成功。后面跟着的 1 row affected 表示的是影响的行数,() 内显示的是你执行这条命令所耗费的时间,也就是 0.03 秒。

上图我们成功创建了一个 cxuandb 的数据库,此时我们还想创建一个数据库,我们再执行相同的指令,结果提示

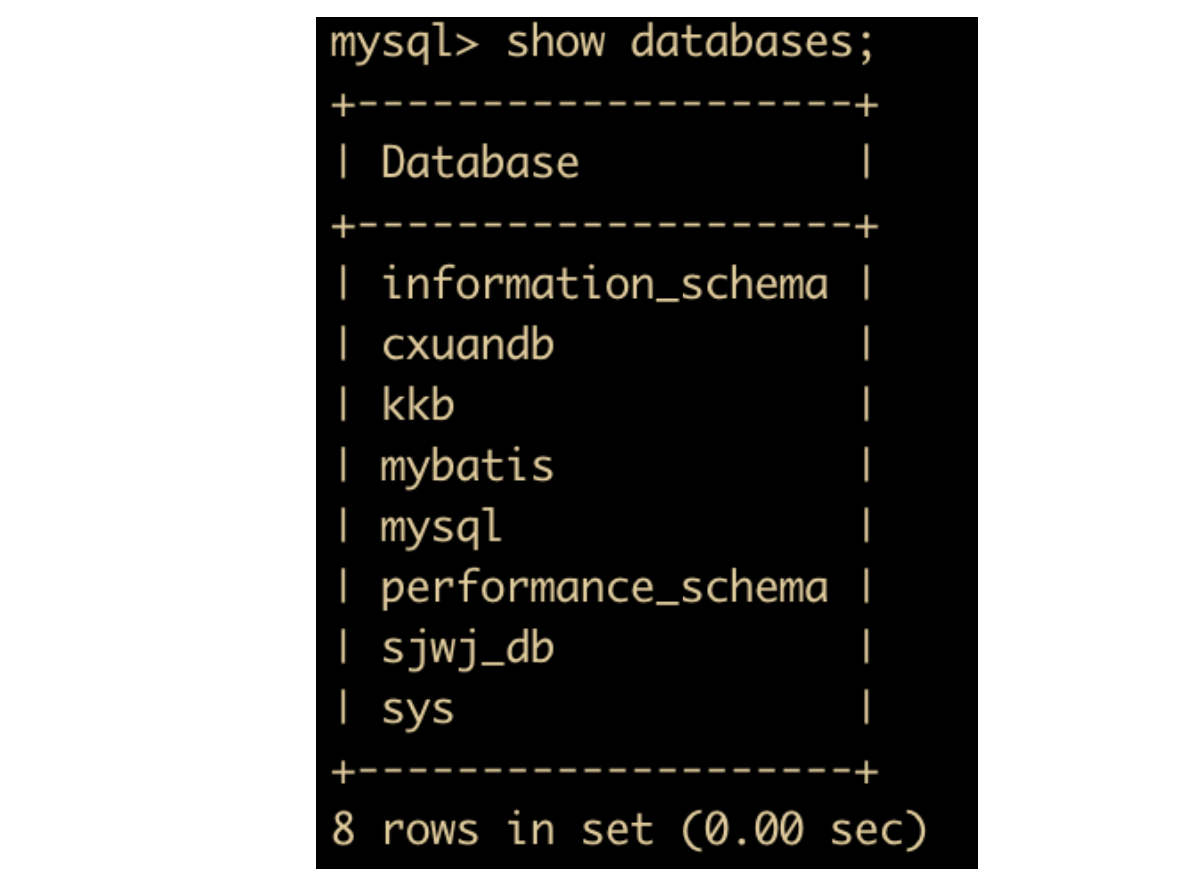

提示我们不能再创建数据库了,数据库已经存在。这时候我就有疑问了,我怎么知道都有哪些数据库呢?别我再想创建一个数据库又告诉我已经存在,这时候可以使用 show databases 命令来查看你的 MySQL 已有的数据库

show databases;

执行完成后的结果如下

因为数据库我之前已经使用过,这里就需要解释一下,除了刚刚新创建成功的 cxuandb 外,informationn_schema 、performannce_schema 和 sys 都是系统自带的数据库,是安装 MySQL 默认创建的数据库。它们各自表示

- informationn_schema: 主要存储一些数据库对象信息,比如用户表信息、权限信息、分区信息等

- performannce_schema: MySQL 5.5 之后新增加的数据库,主要用于收集数据库服务器性能参数。

- sys: MySQL 5.7 提供的数据库,sys 数据库里面包含了一系列的存储过程、自定义函数以及视图来帮助我们快速的了解系统的元数据信息。

其他所有的数据库都是作者自己创建的,可以忽略他们。

在创建完数据库之后,可以用如下命令选择要操作的数据库

use cxuandb

这样就成功切换为了 cxuandb 数据库,我们可以在此数据库下进行建表、查看基本信息等操作。

比如想要看康康我们新建的数据库里面有没有其他表

show tables;

果然,我们新建的数据库下面没有任何表,但是现在,我们还不进行建表操作,我们还是先来认识一下数据库层面的命令,也就是其他 DDL 指令

删除数据库

如果一个数据库我们不想要了,那么该怎么办呢?直接删掉数据库不就好了吗?删表语句是

drop database dbname;

比如 cxuandb 我们不想要他了,可以通过使用

drop database cxuandb;

进行删除,这里我们就不进行演示了,因为 cxuandb 我们后面还会使用。

但是这里注意一点,你删除数据库成功后会出现 0 rows affected,这个可以不用理会,因为在 MySQL 中,drop 语句操作的结果都是 0 rows affected。

创建表

下面我们就可以对表进行操作了,我们刚刚 show tables 发现还没有任何表,所以我们现在进行建表语句

CREATE TABLE 表名称 ( 列名称1 数据类型 约束, 列名称2 数据类型 约束, 列名称3 数据类型 约束, .... )

这样就很清楚了吧,列名称就是列的名字,紧跟着列名后面就是数据类型,然后是约束,为什么要这么设计?举个例子你就清楚了,比如 cxuan 刚被生出来就被打印上了标签

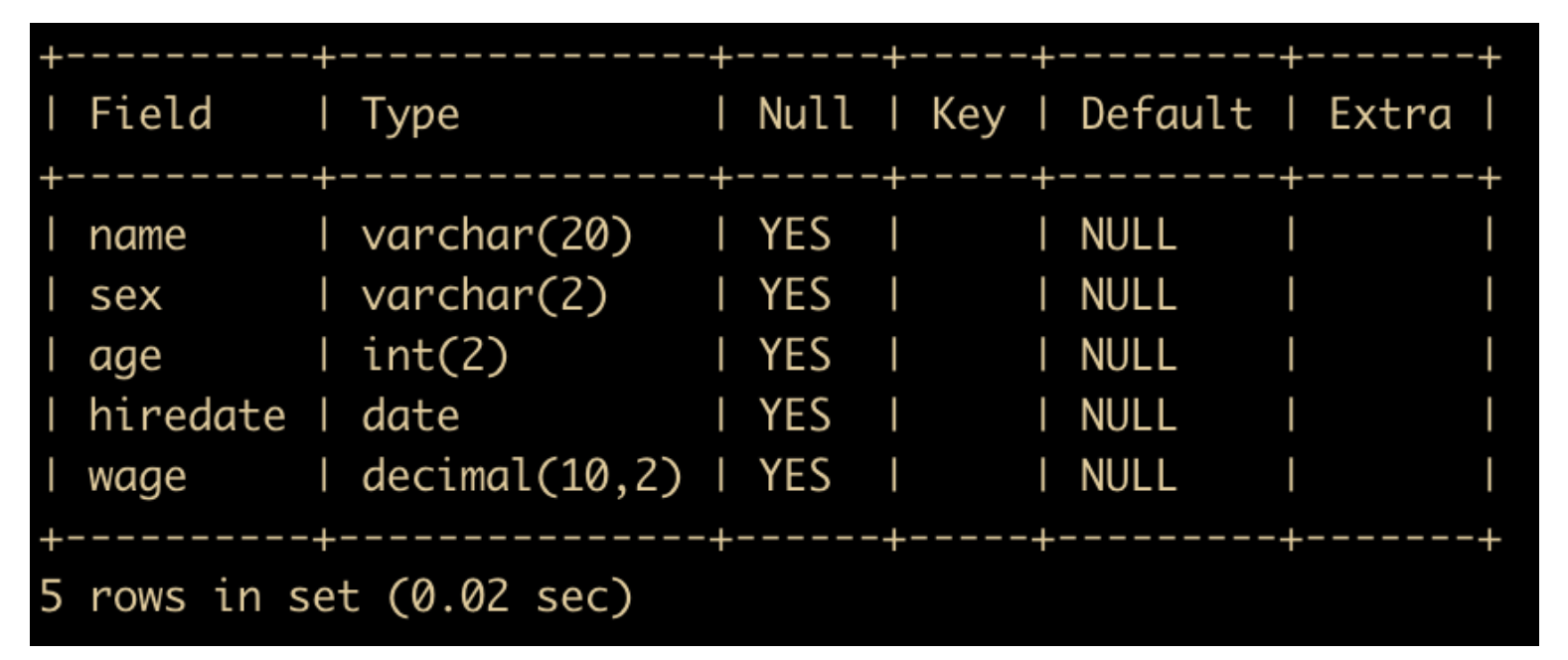

比如我们创建一个表,里面有 5 个字段,姓名(name)、性别(sex)、年龄(age)、何时雇佣(hiredate)、薪资待遇(wage),建表语句如下

create table job(name varchar(20), sex varchar(2), age int(2), hiredate date, wage decimal(10,2));

事实证明这条建表语句还是没问题的,建表完成后可以使用 DESC tablename 查看表的基本信息

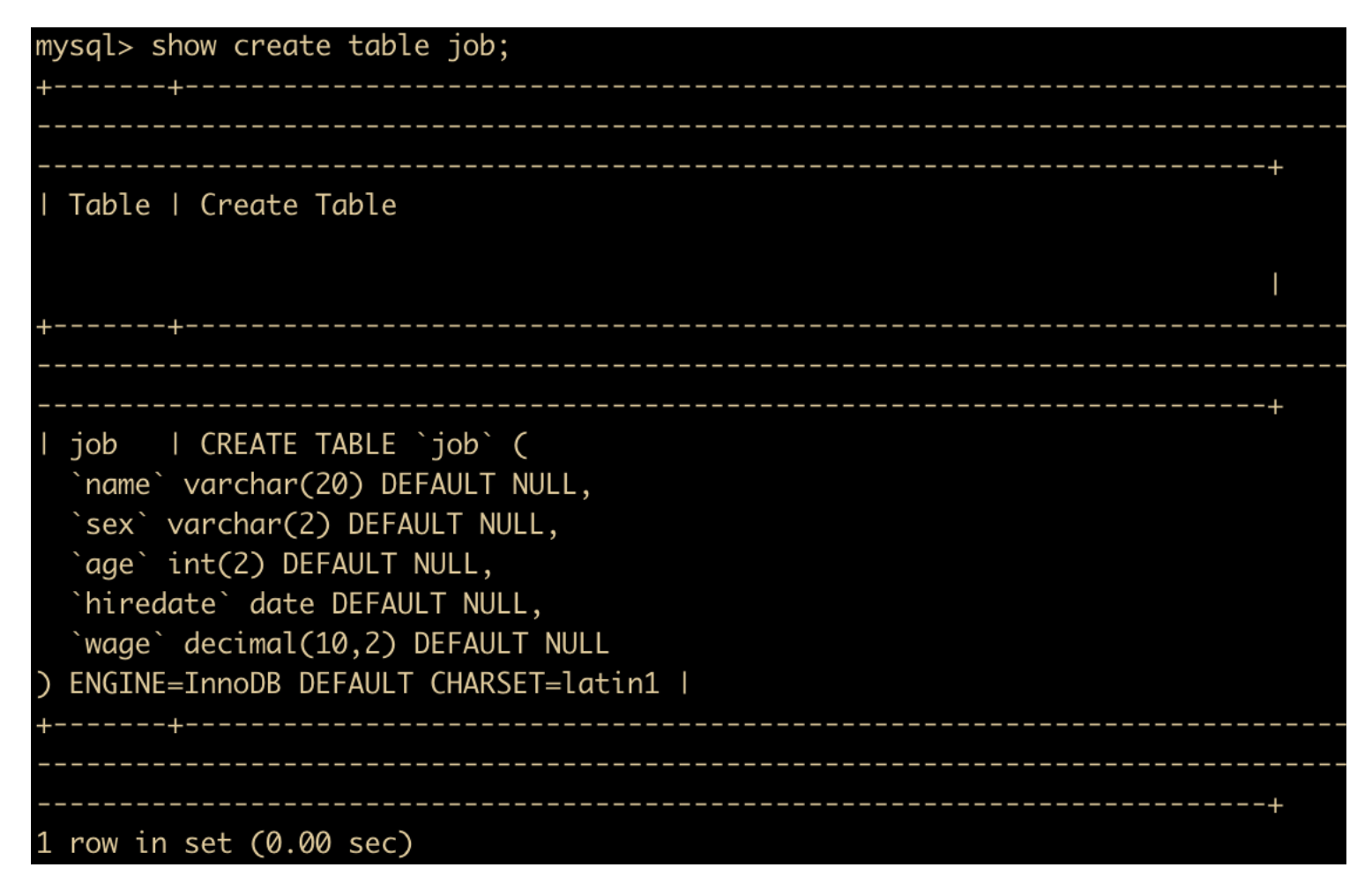

DESC 命令会查看表的定义,但是输出的信息还不够全面,所以,如果想要查看更全的信息,还要通过查看表的创建语句的 SQL 来得到

show create table job \G;

可以看到,除了看到表定义之外,还看到了表的 engine(存储引擎) 为 InnoDB 存储引擎,\G 使得记录能够竖着排列,如果不用 \G 的话,效果如下

删除表

表的删除语句有两种,一种是 drop 语句,SQL 语句如下

drop table job

一种是 truncate 语句,SQL 语句如下

truncate table job

这两者的区别简单理解就是 drop 语句删除表之后,可以通过日志进行回复,而 truncate 删除表之后永远恢复不了,所以,一般不使用 truncate 进行表的删除。‘

修改表

对于已经创建好的表,尤其是有大量数据的表,如果需要对表做结构上的改变,可以将表删除然后重新创建表,但是这种效率会产生一些额外的工作,数据会重新加载近来,如果此时有服务正在访问的话,也会影响服务读取表中数据,所以此时,我们需要表的修改语句来对已经创建好的表的定义进行修改。

修改表结构一般使用 alter table 语句,下面是常用的命令

ALTER TABLE tb MODIFY [COLUMN] column_definition [FIRST | AFTER col_name];

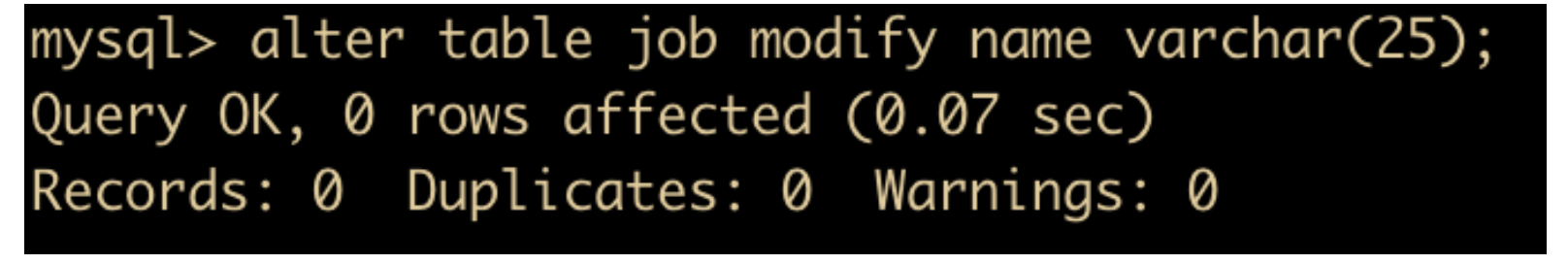

比如我们想要将 job 表中的 name 由 varchar(20) 改为 varchar(25),可以使用如下语句

alter table job modify name varchar(25);

也可以对表结构进行修改,比如增加一个字段

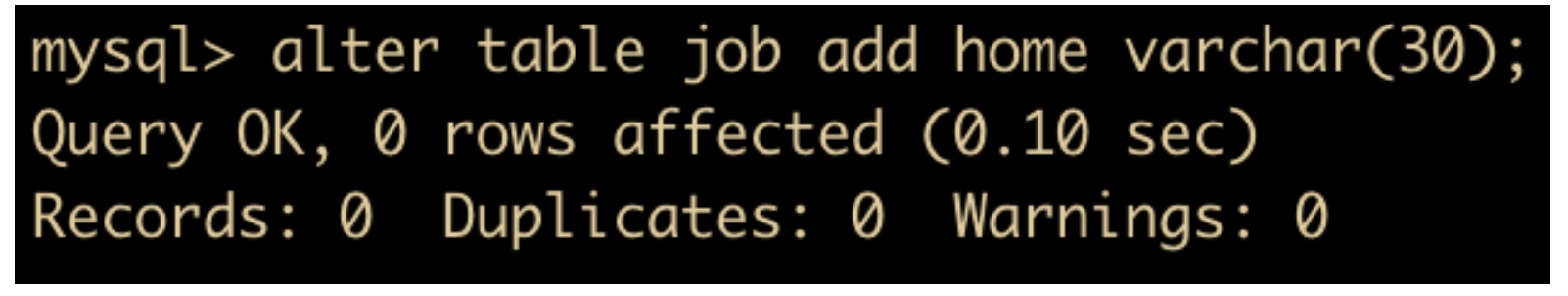

alter table job add home varchar(30);

将新添加的表的字段进行删除

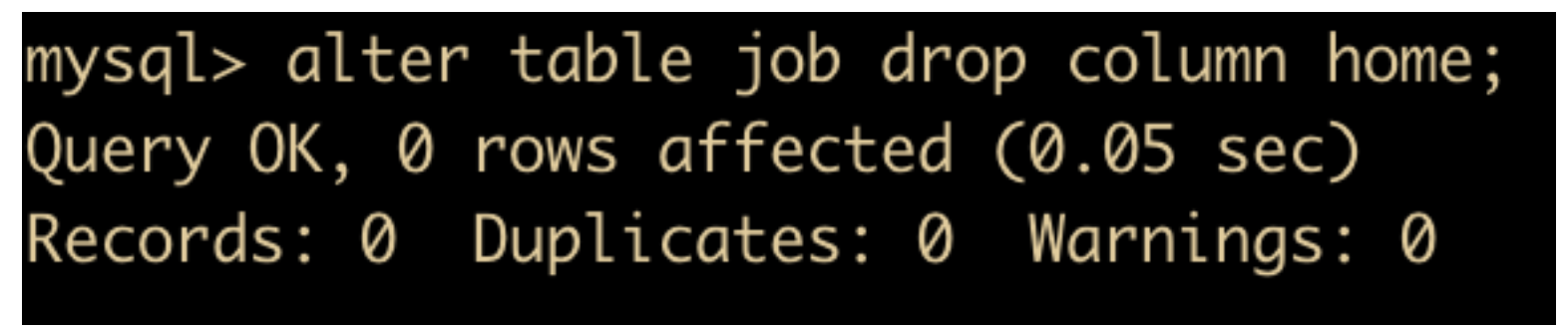

alter table job drop column home;

可以对表中字段的名称进行修改,比如吧 wage 改为 salary

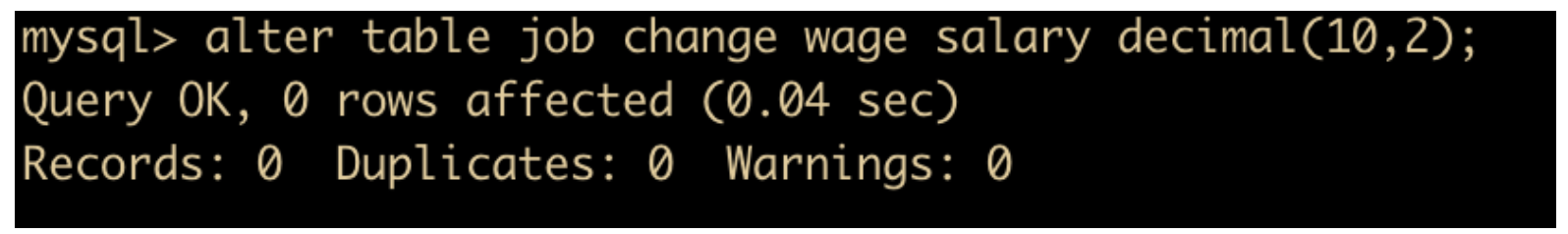

alter table job change wage salary decimal(10,2);

修改字段的排列顺序,我们前面介绍过修改语法涉及到一个顺序问题,都有一个可选项 first | after column_name,这个选项可以用来修改表中字段的位置,默认 ADD 是在添加为表中最后一个字段,而 CHANGE/MODIFY 不会改变字段位置。比如

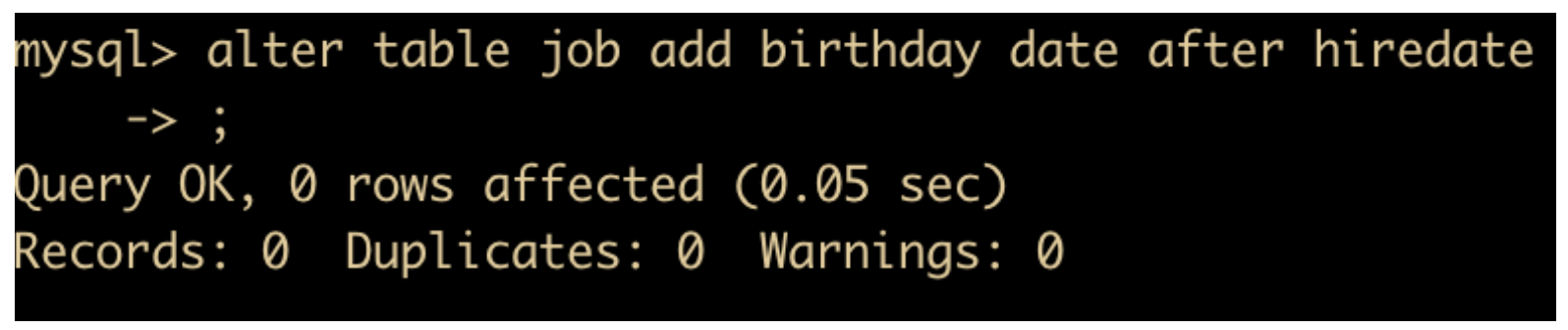

alter table job add birthday after hiredate;

可以对表名进行修改,例如将 job 表改为 worker

alter table job rename worker;

DML 语句

有的地方把 DML 语句(增删改)和 DQL 语句(查询)统称为 DML 语句,有的地方分开,我们目前使用分开称呼的方式

插入

表创建好之后,我们就可以向表里插入数据了,插入记录的基本语法如下

INSERT INTO tablename (field1,field2) VALUES(value1,value2);

例如,向中插入以下记录

insert into job(name,sex,age,hiredate,birthday,salary) values("cxuan","男",24,"2020-04-27","1995-08-22",8000);

也可以不用指定要插入的字段,直接插入数据即可

insert into job values("cxuan02","男",25,"2020-06-01","1995-04-23",12000);

这里就有一个问题,如果插入的顺序不一致的话会怎么样呢?

对于含可空字段、非空但是含有默认值的字段、自增字段可以不用在 insert 后的字段列表出现,values 后面只需要写对应字段名称的 value 即可,没有写的字段可以自动的设置为 NULL、默认值或者自增的下一个值,这样可以缩短要插入 SQL 语句的长度和复杂性。

比如我们设置一下 hiredate、age 可以为 null,来试一下

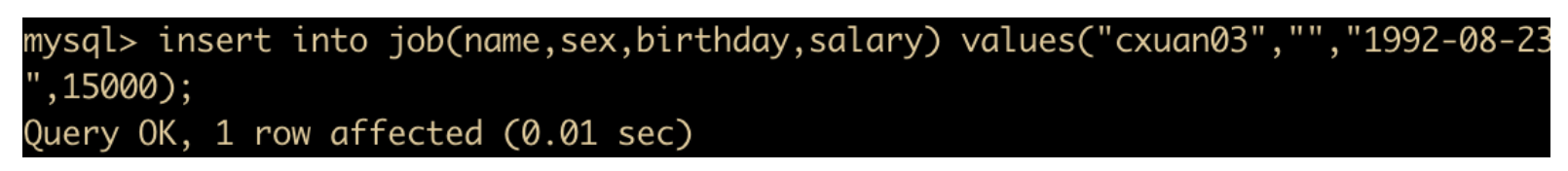

insert into job(name,sex,birthday,salary) values("cxuan03","男","1992-08-23",15000);

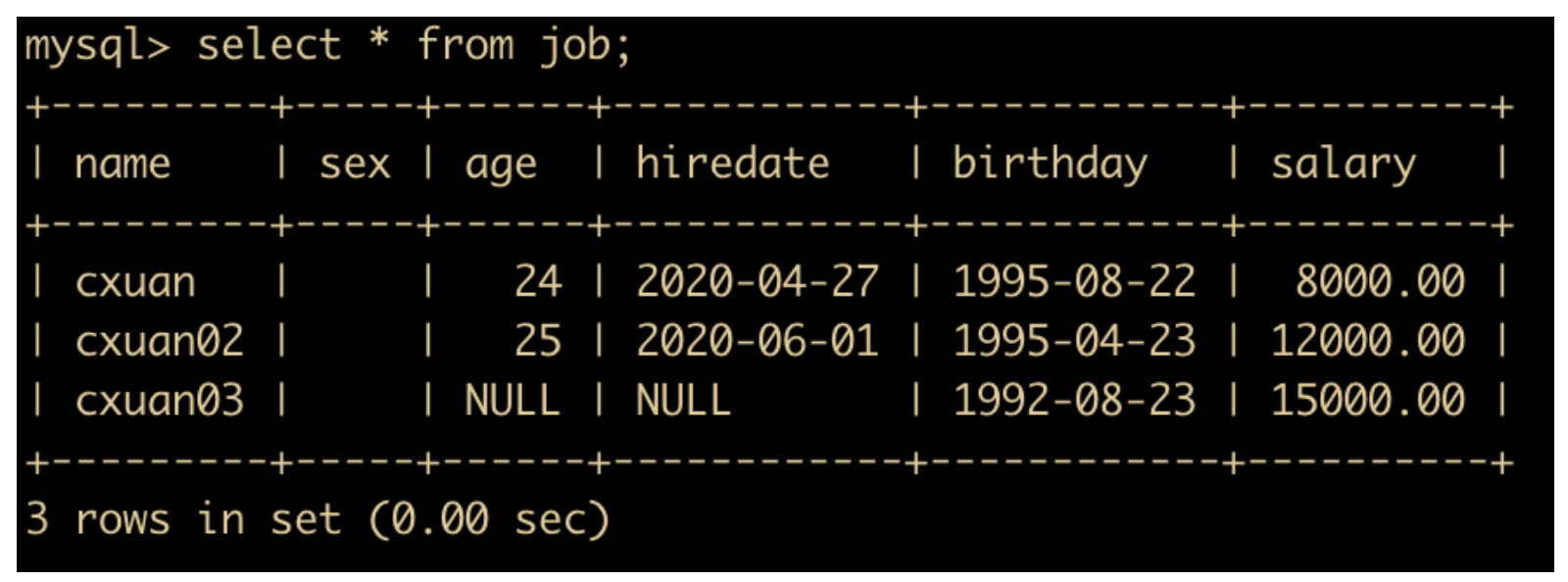

我们看一下实际插入的数据

我们可以看到有一行两个字段显示 NULL。在 MySQL 中,insert 语句还有一个很好的特性,就是一次可以插入多条记录

INSERT INTO tablename (field1,field2) VALUES (value1,value2), (value1,value2), (value1,value2), ...;

可以看出,每条记录之间都用逗号进行分割,这个特性可以使得 MySQL 在插入大量记录时,节省很多的网络开销,大大提高插入效率。

更新记录

对于表中已经存在的数据,可以通过 update 命令对其进行修改,语法如下

UPDATE tablename SET field1 = value1, field2 = value2 ;

例如,将 job 表中的 cxuan03 中 age 的 NULL 改为 26,SQL 语句如下

update job set age = 26 where name = 'cxuan03';

SQL 语句中出现了一个 where 条件,我们会在后面说到 where 条件,这里简单理解一下它的概念就是根据哪条记录进行更新,如果不写 where 的话,会对整个表进行更新

删除记录

如果记录不再需要,可以使用 delete 命令进行删除

DELETE FROM tablename [WHERE CONDITION]

例如,在 job 中删除名字是 cxuan03 的记录

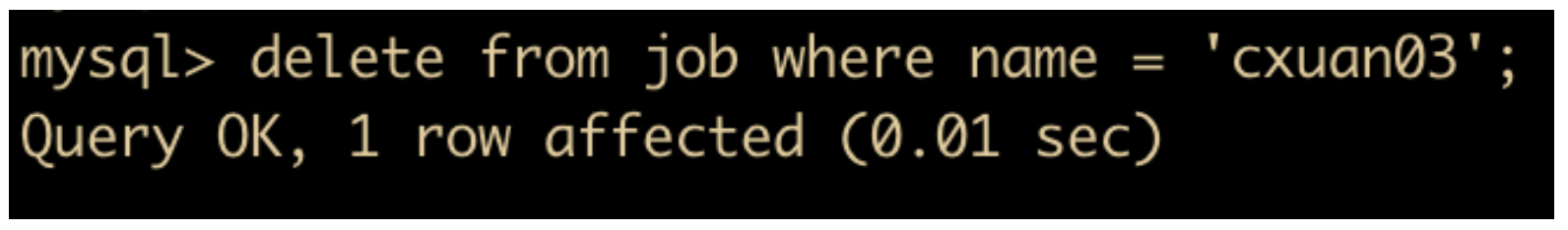

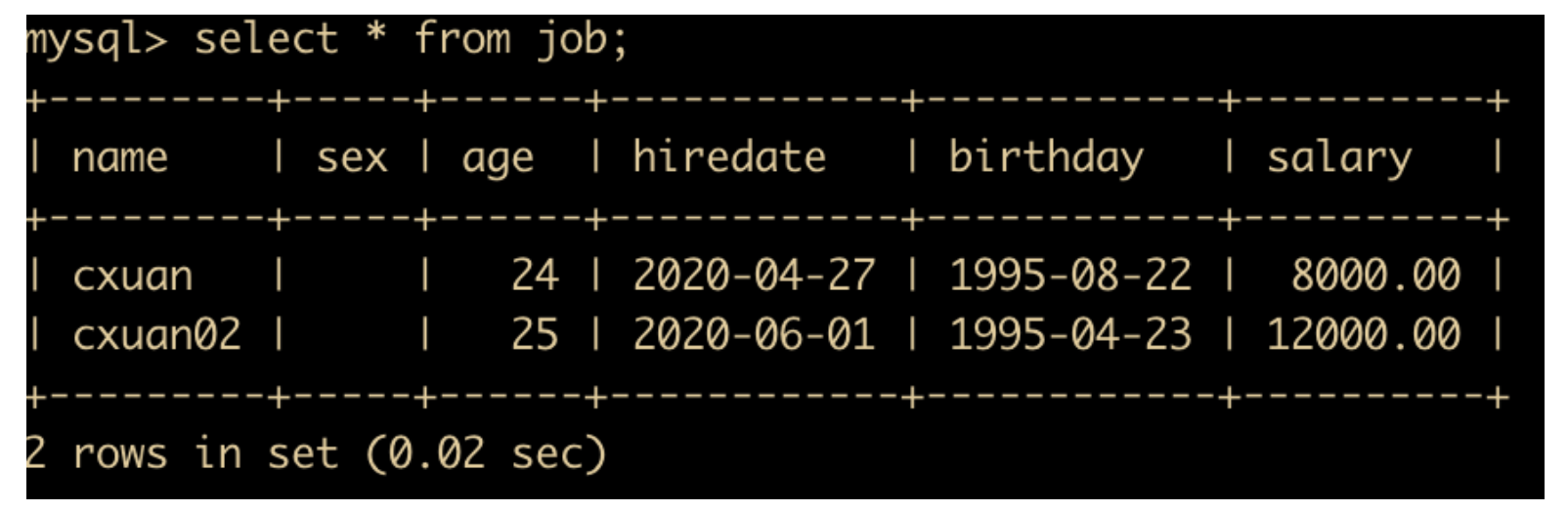

delete from job where name = 'cxuan03';

在 MySQL 中,删除语句也可以不指定 where 条件,直接使用

delete from job

这种删除方式相当于是清楚表的操作,表中所有的记录都会被清除。

DQL 语句

下面我们一起来认识一下 DQL 语句,数据被插入到 MySQL 中,就可以使用 SELECT 命令进行查询,来得到我们想要的结果。

SELECT 查询语句可以说是最复杂的语句了,这里我们只介绍一下基本语法

一种最简单的方式就是从某个表中查询出所有的字段和数据,简单粗暴,直接使用 SELECT *

SELECT * FROM tablename;

例如我们将 job 表中的所有数据查出来

select * from job;

其中 * 是查询出所有的数据,当然,你也可以查询出指定的数据项

select name,sex,age,hiredate,birthday,salary from job;

上面这条 SQL 语句和 select * from job 表是等价的,但是这种直接查询指定字段的 SQL 语句效率要高。

上面我们介绍了基本的 SQL 查询语句,但是实际的使用场景会会比简单查询复杂太多,一般都会使用各种 SQL 的函数和查询条件等,下面我们就来一起认识一下。

去重

使用非常广泛的场景之一就是 去重,去重可以使用 distinct 关键字来实现

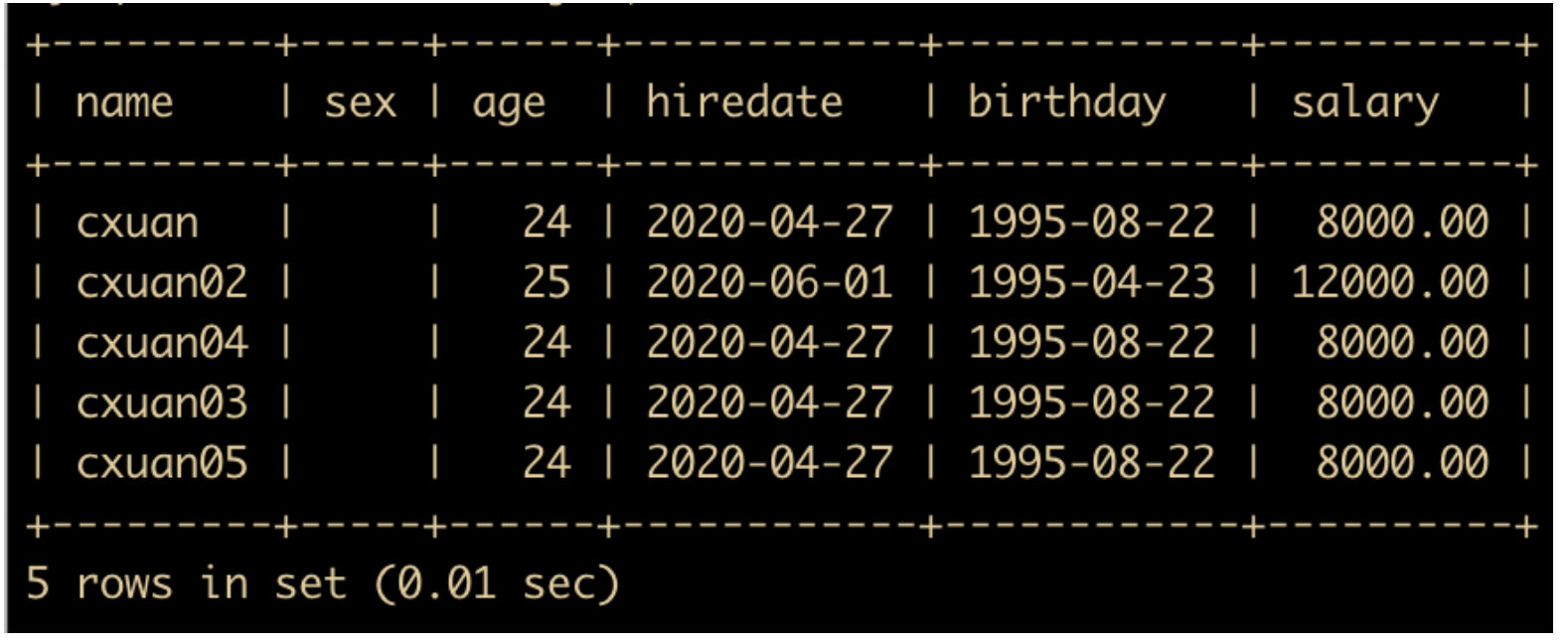

为了演示效果,我们先向数据库中插入批量数据,插入完成后的表结构如下

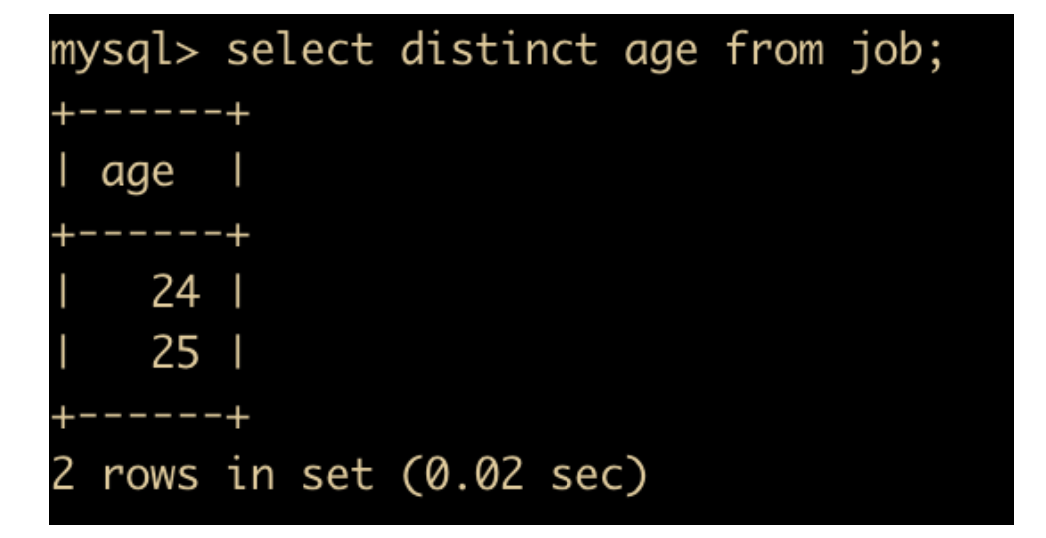

下面我们使用 distinct 来对 age 去重来看一下效果

你会发现只有两个不同的值,其他和 25 重复的值被过滤掉了,所以我们使用 distinct 来进行去重

条件查询

我们之前的所有例子都是查询全部的记录,如果我们只想查询指定的记录呢?这里就会用到 where 条件查询语句,条件查询可以对指定的字段进行查询,比如我们想查询所有年龄为 24 的记录,如下

select * from job where age = 24;

where 条件语句后面会跟一个判断的运算符 =,除了 = 号比较外,还可以使用 >、<、>=、<=、!= 等比较运算符;例如

select * from job where age >= 24;

就会从 job 表中查询出 age 年龄大于或等于 24 的记录

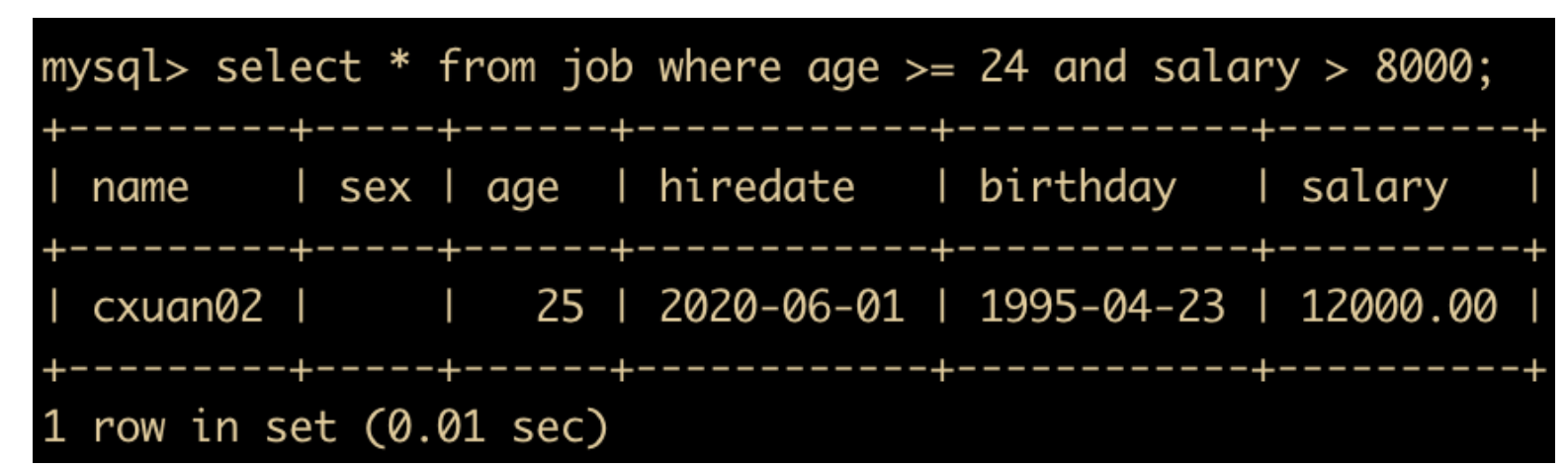

除此之外,在 where 条件查询中还可以有多个并列的查询条件,比如我们可以查询年龄大于等于 24,并且薪资大雨 8000 的记录

select * from job where age >= 24 and salary > 8000;

多个条件之间还可以使用 or、and 等逻辑运算符进行多条件联合查询,运算符会在以后章节中详细讲解。

排序

我们会经常有这样的需求,按照某个字段进行排序,这就用到了数据库的排序功能,使用关键字 order by 来实现,语法如下

SELECT * FROM tablename [WHERE CONDITION] [ORDER BY field1 [DESC|ASC] , field2 [DESC|ASC],……fieldn [DESC|ASC]]

其中 DESC 和 ASC 就是顺序排序的关键字,DESC 会按照字段进行降序排列,ASC 会按照字段进行升序排列,默认会使用升序排列,也就是说,你不写 order by 具体的排序的话,默认会使用升序排列。order by 后面可以跟多个排序字段,并且每个排序字段可以有不同的排序顺序。

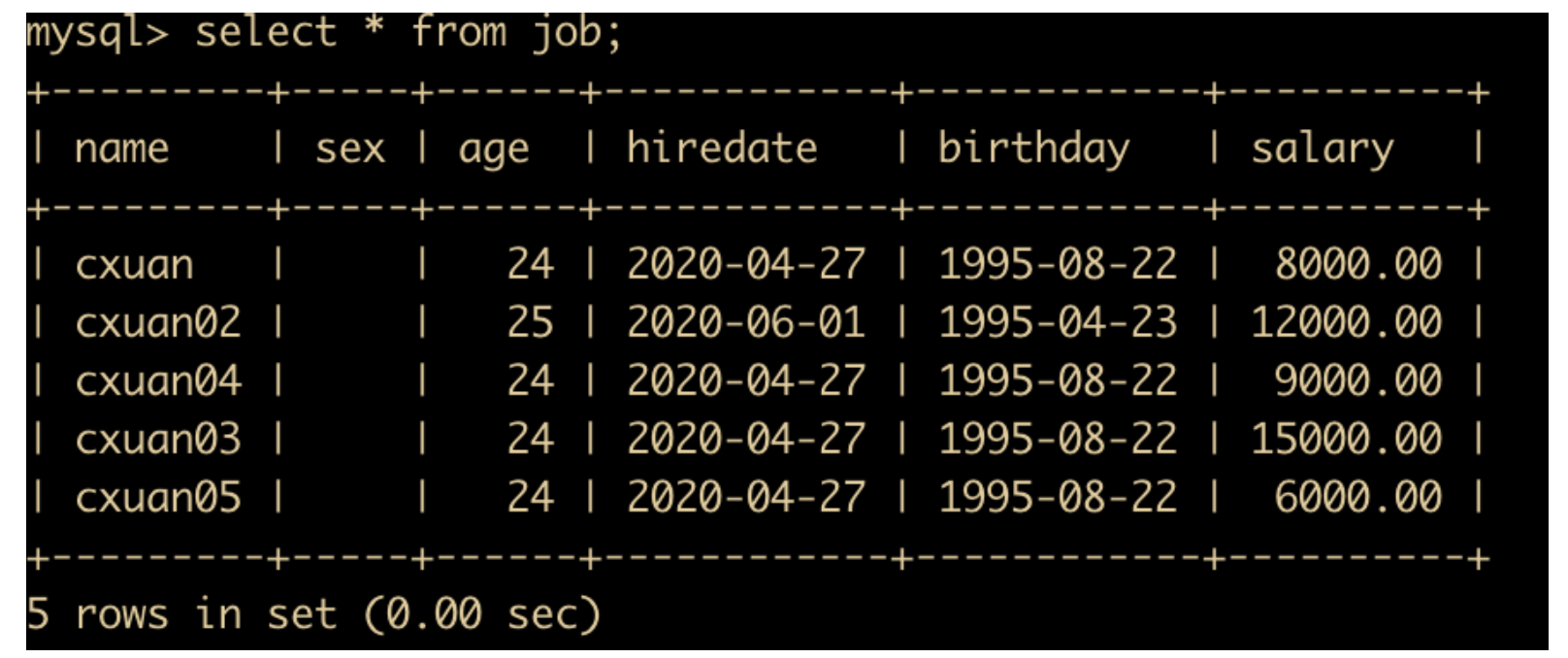

为了演示功能,我们先把表中的 salary 工资列进行修改,修改完成后的表记录如下

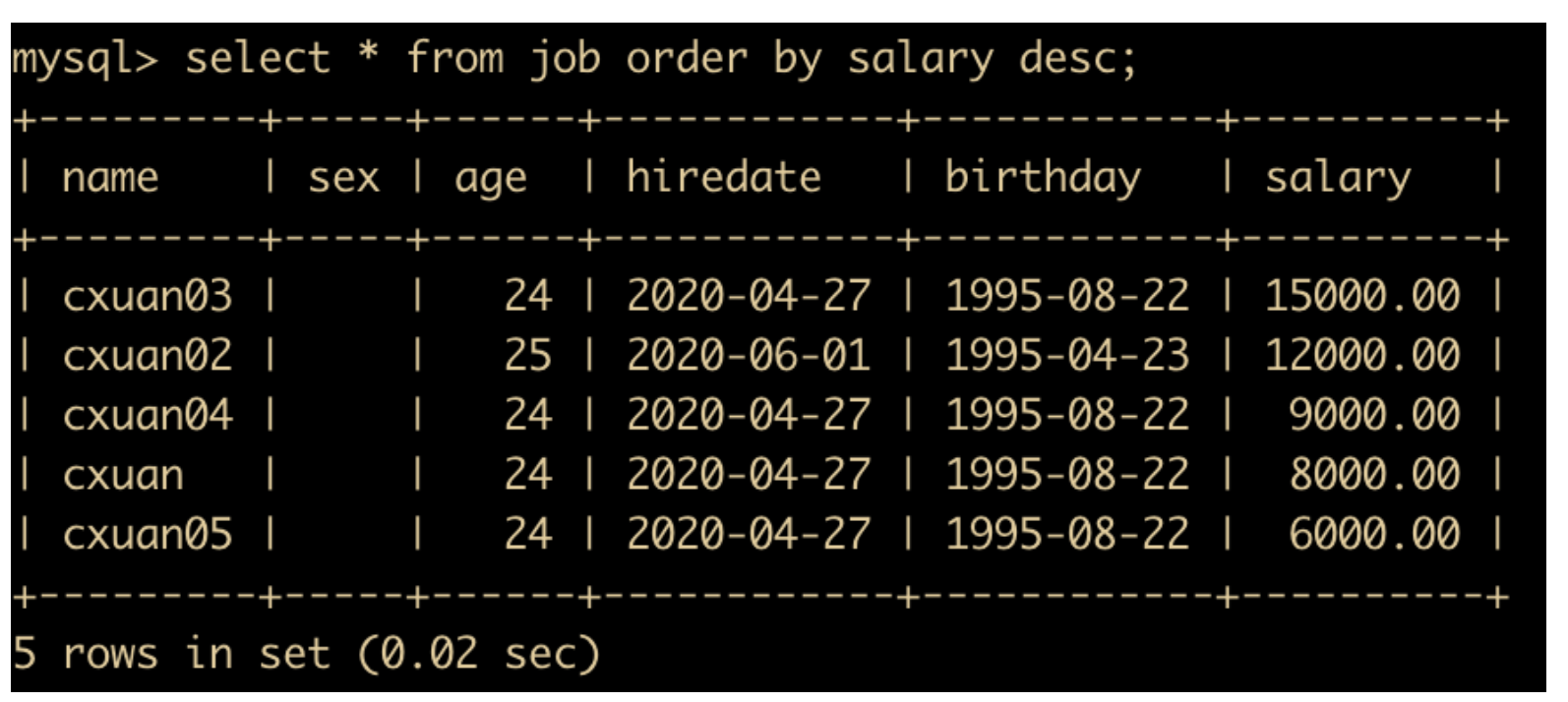

下面我们按照工资进行排序,SQL 语句如下

select * from job order by salary desc;

语句执行完成后的结果如下

这是对一个字段进行排序的结果,也可以对多个字段进行排序,但是需要注意一点

根据 order by 后面声名的顺序进行排序,如果有三个排序字段 A、B、C 的话,如果 A 字段排序字段的值一样,则会根据第二个字段进行排序,以此类推。

如果只有一个排序字段,那么这些字段相同的记录将会无序排列。

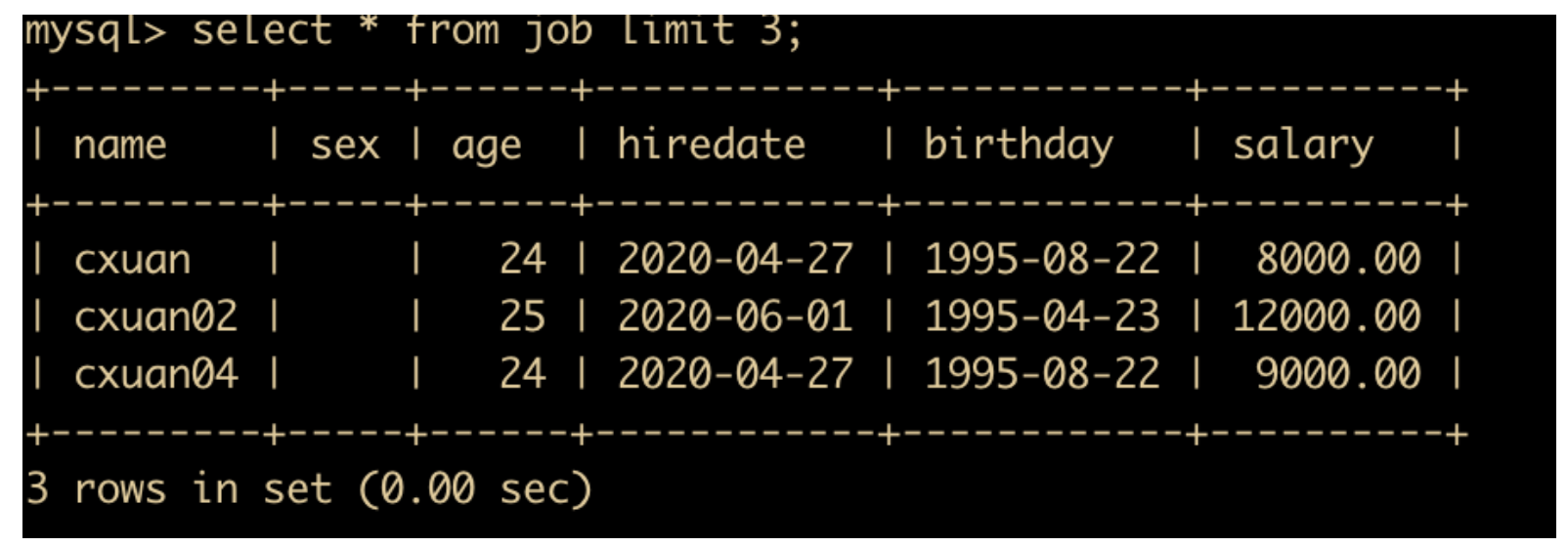

限制

对于排序后的字段,或者不排序的字段,如果只希望显示一部分的话,就会使用 LIMIT 关键字来实现,比如我们只想取前三条记录

select * from job limit 3;

或者我们对排序后的字段取前三条记录

select * from job order by salary limit 3;

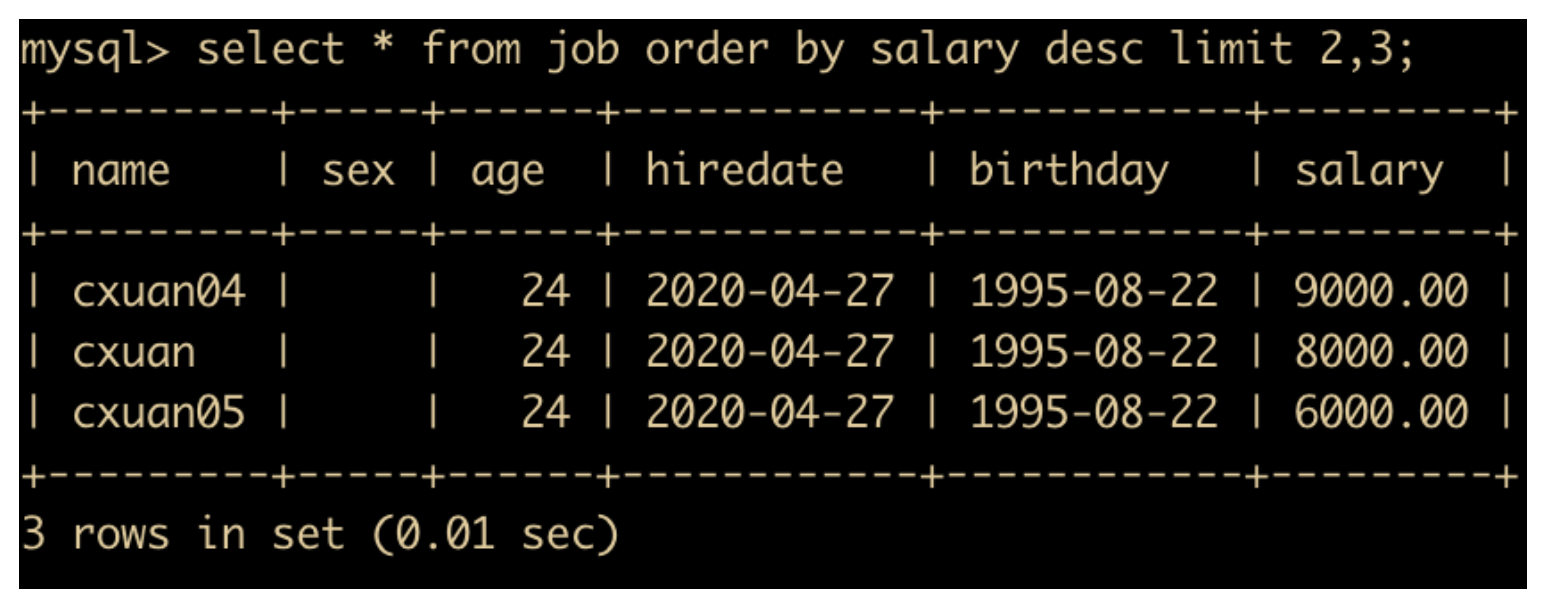

上面这种 limit 是从表记录的第 0 条开始取,如果从指定记录开始取,比如从第二条开始取,取三条记录,SQL 如下

select * from job order by salary desc limit 2,3;

limit 一般经常和 order by 语法一起实现分页查询。

注意:limit 是 MySQL 扩展 SQL92 之后的语法,在其他数据库比如 Oracle 上就不通用,我犯过一个白痴的行为就是在 Oracle 中使用 limit 查询语句。。。

聚合

下面我们来看一下对记录进行汇总的操作,这类操作主要有

汇总函数,比如 sum 求和、count 统计数量、max 最大值、min 最小值等group by,关键字表示对分类聚合的字段进行分组,比如按照部门统计员工的数量,那么 group by 后面就应该跟上部门with是可选的语法,它表示对汇总之后的记录进行再次汇总having关键字表示对分类后的结果再进行条件的过滤。

看起来 where 和 having 意思差不多,不过它们用法不一样,where 是使用在统计之前,对统计前的记录进行过滤,having 是用在统计之后,是对聚合之后的结果进行过滤。也就是说 where 永远用在 having 之前,我们应该先对筛选的记录进行过滤,然后再对分组的记录进行过滤。

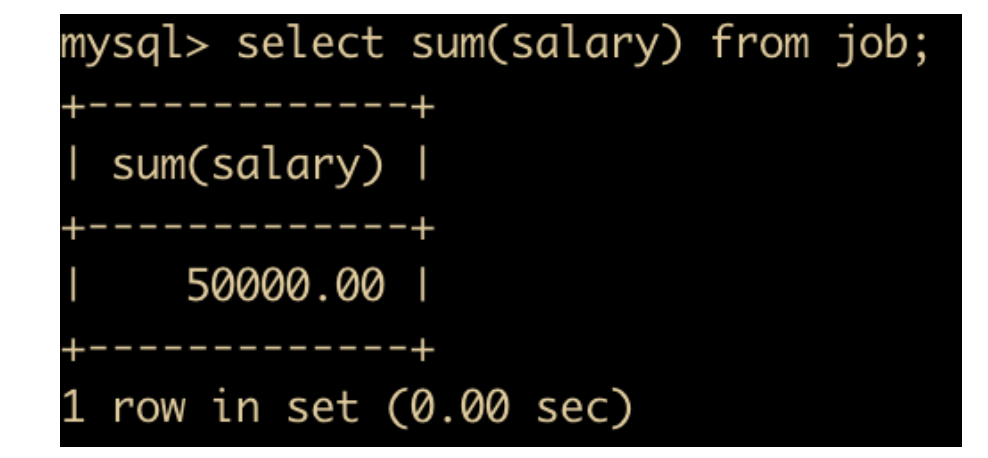

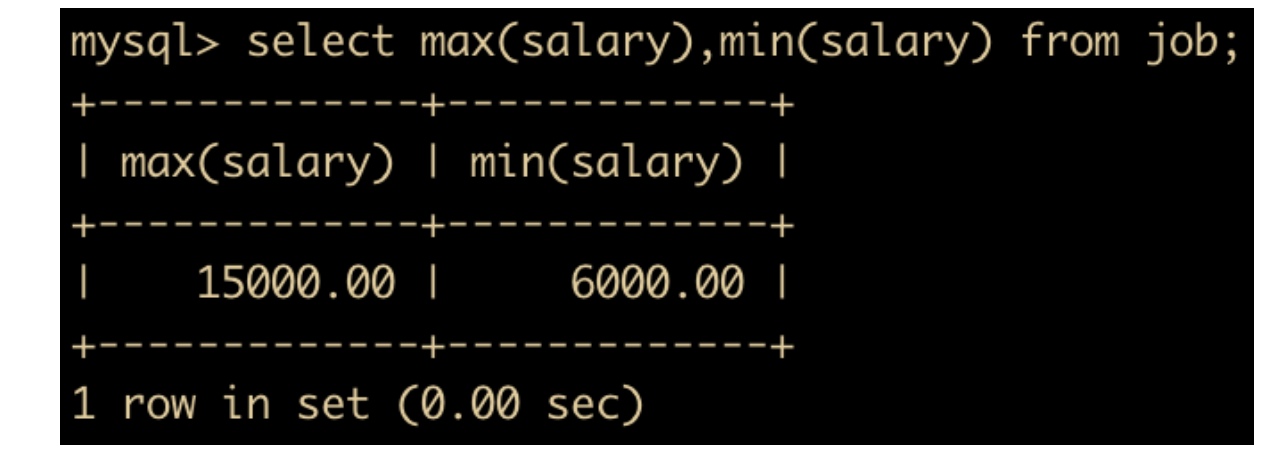

可以对 job 表中员工薪水进行统计,选出总共的薪水、最大薪水、最小薪水

select sum(salary) from job;

select max(salary),min(salary) from job;

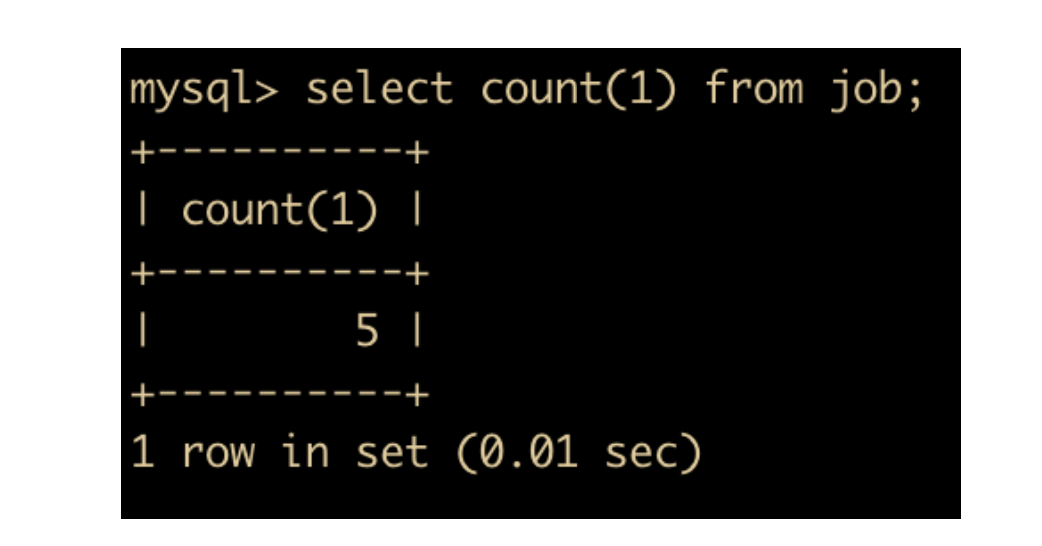

比如我们要统计 job 表中人员的数量

select count(1) from job;

统计完成后的结果如下

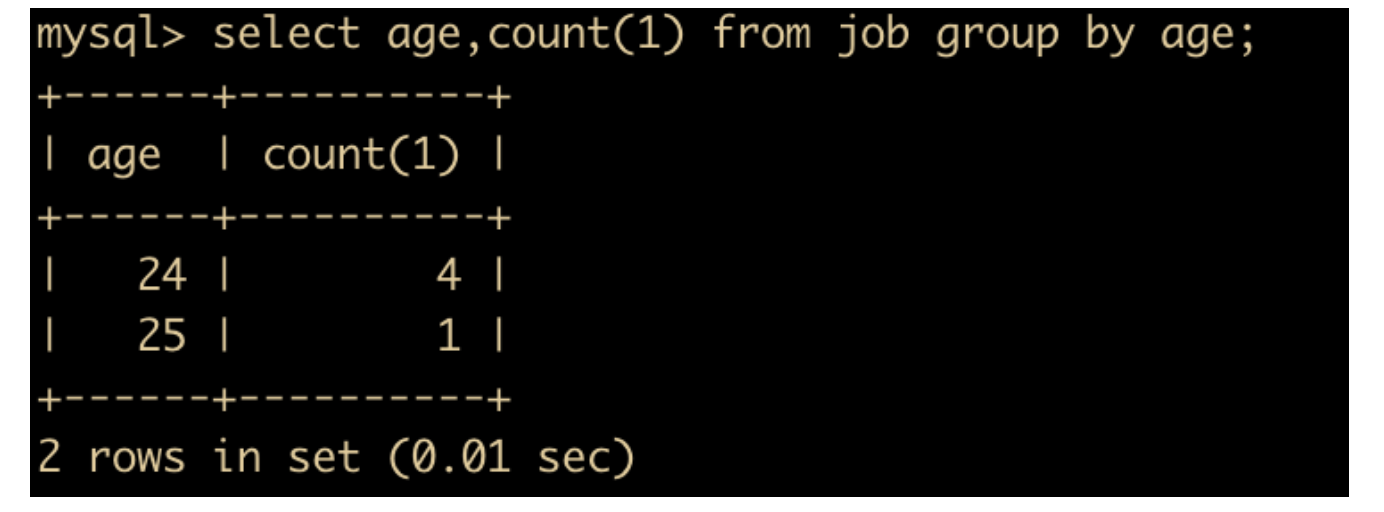

我们可以按照 job 表中的年龄来进行对应的统计

select age,count(1) from job group by age;

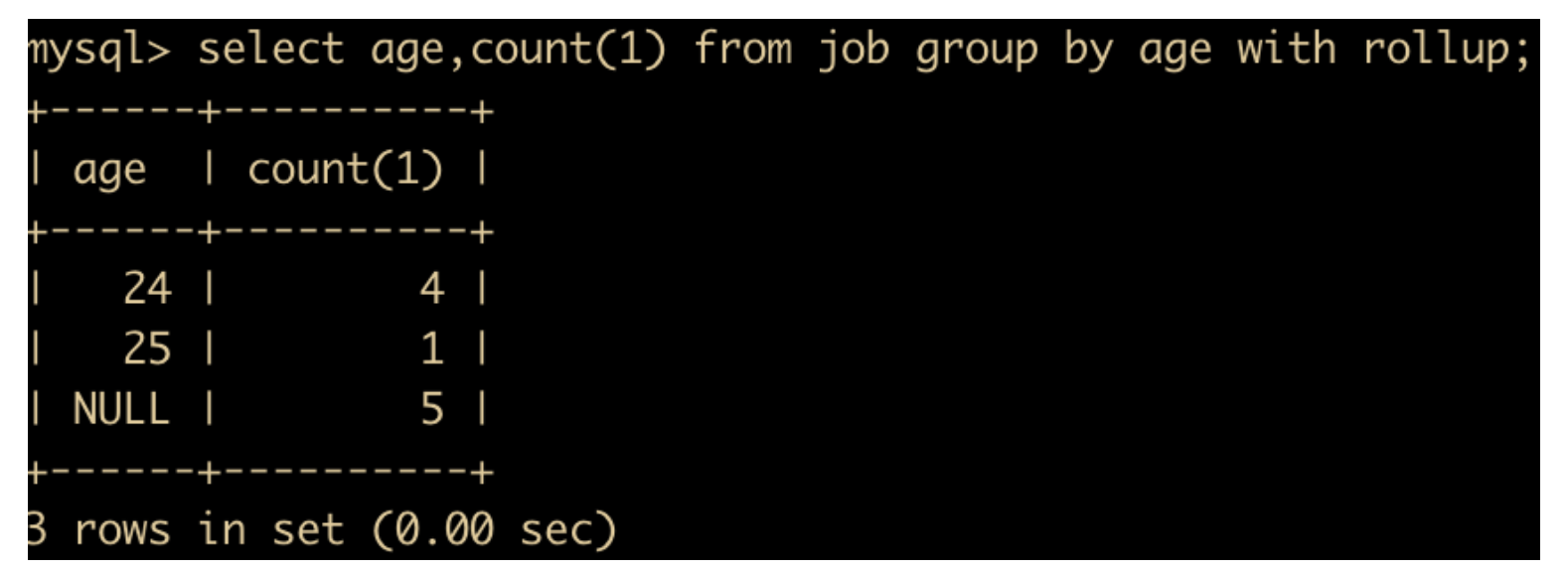

既要统计各年龄段的人数,又要统计总人数

select age,count(1) from job group by age with rollup;

在此基础上进行分组,统计数量大于 1 的记录

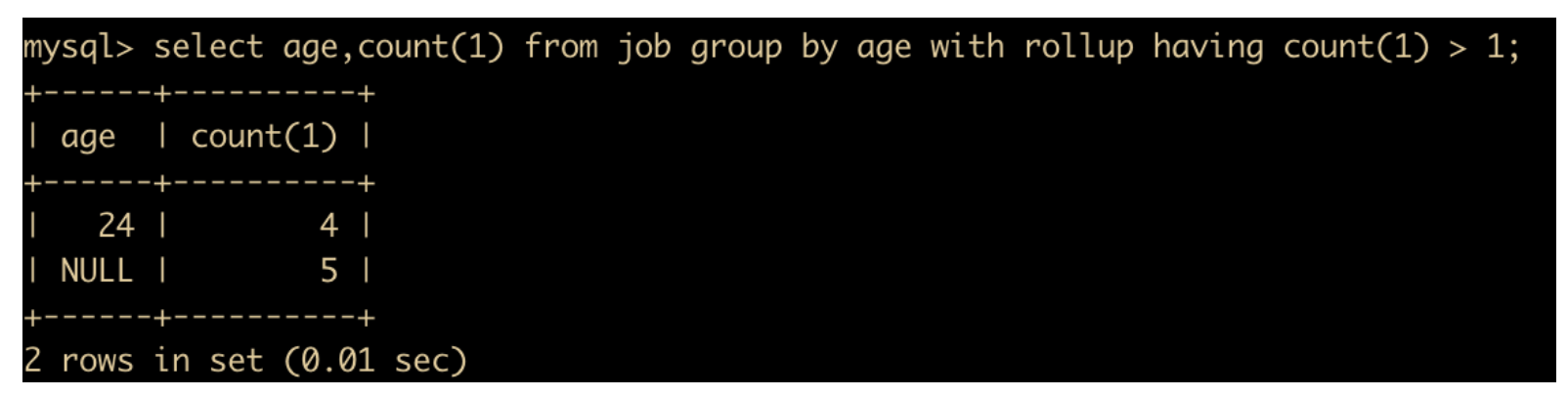

select age,count(1) from job group by age with rollup having count(1) > 1;

表连接

表连接一直是笔者比较痛苦的地方,曾经因为一个表连接挂了面试,现在来认真撸一遍。

表连接一般体现在表之间的关系上。当需要同时显示多个表中的字段时,就可以用表连接来实现。

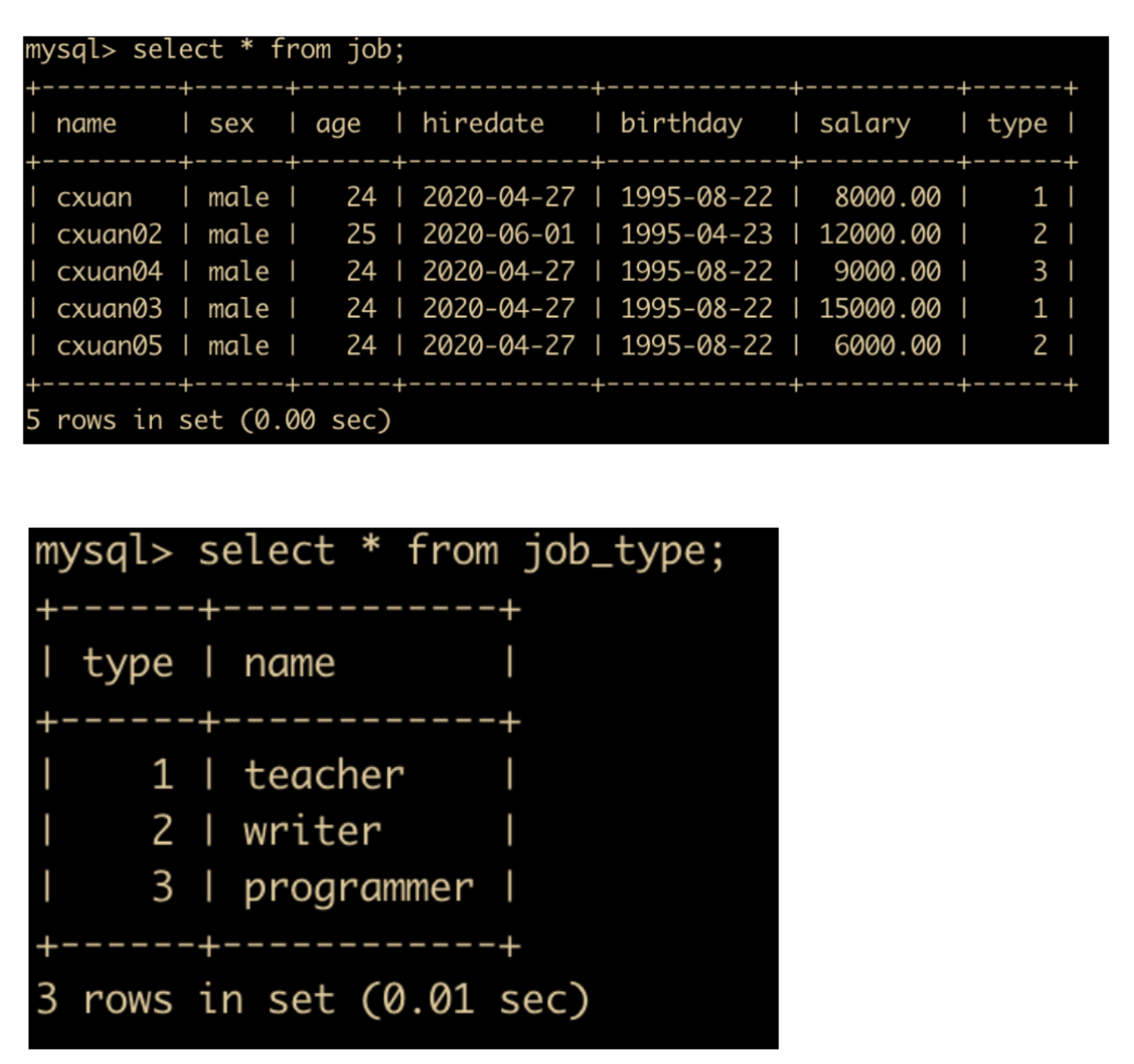

为了演示表连接的功能,我们为 job 表加一个 type 字段表示工作类型,增加一个 job_type 表表示具体的工作种类,如下所示

下面开始我们的演示

查询出 job 表中的 type 和 job_type 表中的 type 匹配的姓名和工作类型

select job.name,job_type.name from job,job_type where job.type = job_type.type;

上面这种连接使用的是内连接,除此之外,还有外连接。那么它们之间的区别是啥呢?

内连接:选出两张表中互相匹配的记录;

外连接:不仅选出匹配的记录,也会选出不匹配的记录;

外连接分为两种

- 左外连接:筛选出包含左表的记录并且右表没有和它匹配的记录

- 右外连接:筛选出包含右表的记录甚至左表没有和它匹配的记录

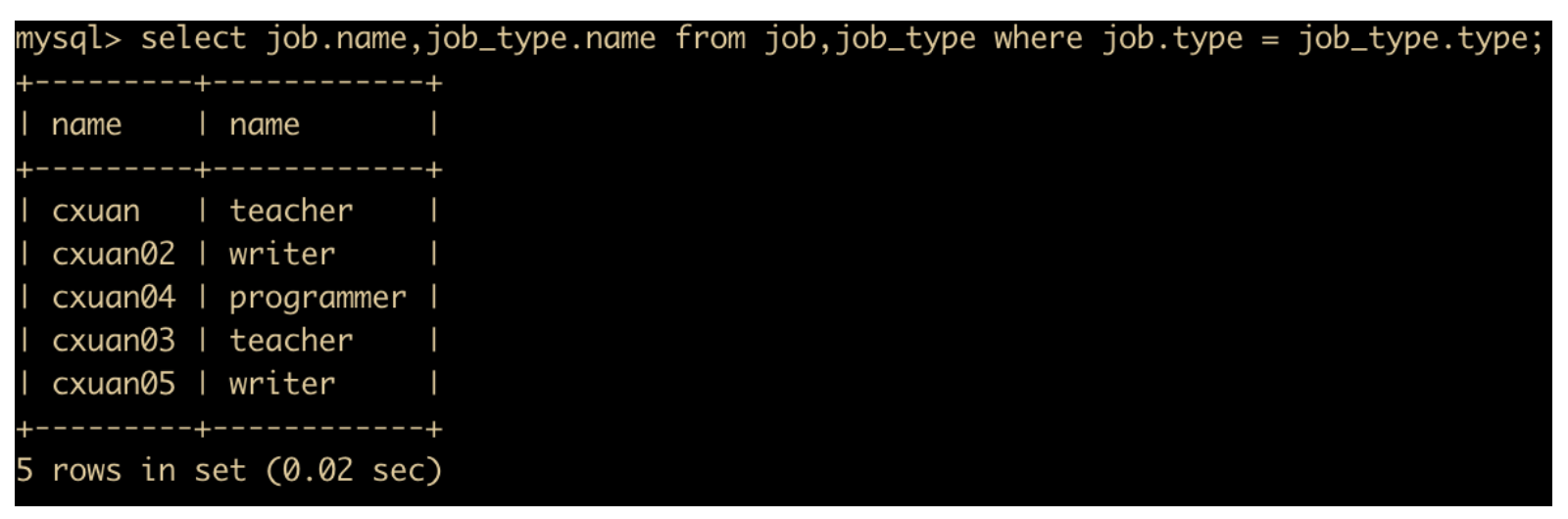

为了演示效果我们在 job 表和 job_type 表中分别添加记录,添加完成后的两表如下

下面我们进行左外连接查询:查询出 job 表中的 type 和 job_type 表中的 type 匹配的姓名和工作类型

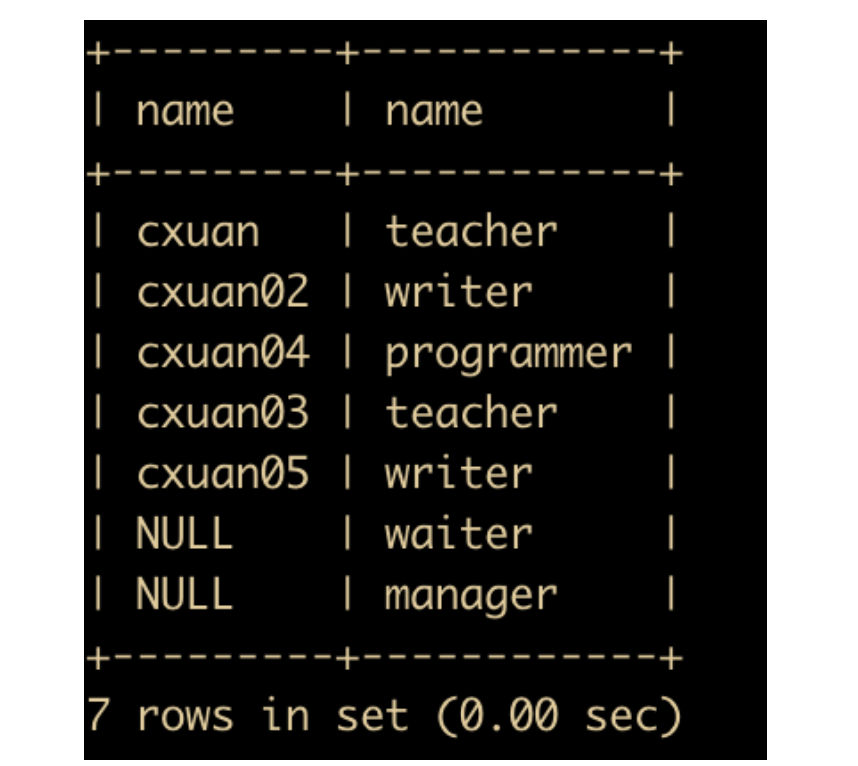

select job.name,job_type.name from job left join job_type on job.type = job_type.type;

查询出来的结果如下

可以看出 cxuan06 也被查询出来了,而 cxuan06 他没有具体的工作类型。

使用右外连接查询

select job.name,job_type.name from job right join job_type on job.type = job_type.type;

可以看出,job 表中并没有 waiter 和 manager 的角色,但是也被查询出来了。

子查询

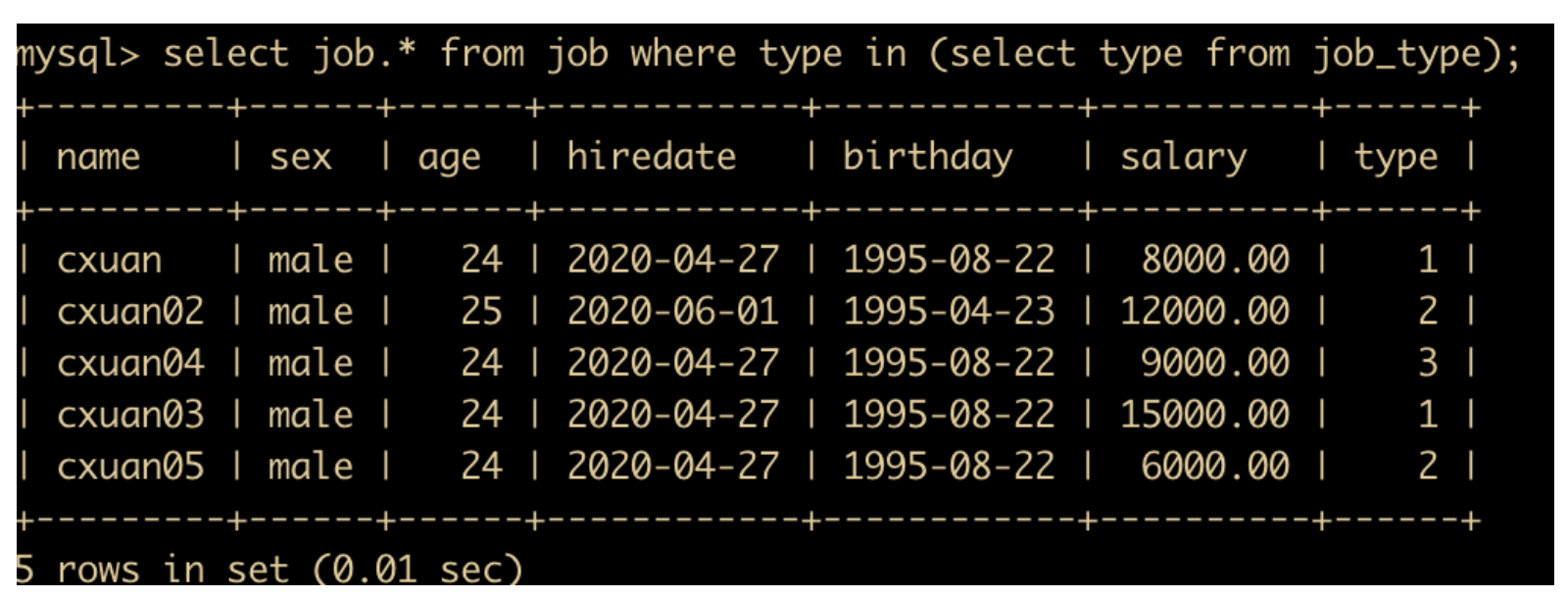

有一些情况,我们需要的查询条件是另一个 SQL 语句的查询结果,这种查询方式就是子查询,子查询有一些关键字比如 in、not in、=、!=、exists、not exists 等,例如我们可以通过子查询查询出每个人的工作类型

select job.* from job where type in (select type from job_type);

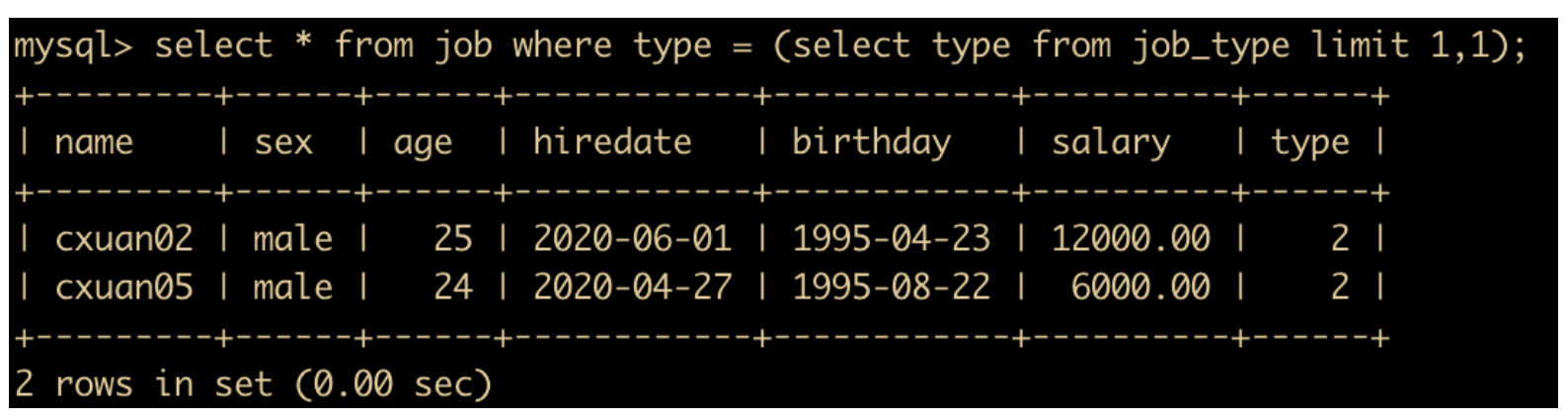

如果自查询数量唯一的话,还可以用 = 来替换 in

select * from job where type = (select type from job_type);

意思是自查询不唯一,我们使用 limit 限制一下返回的记录数

select * from job where type = (select type from job_type limit 1,1);

在某些情况下,子查询可以转换为表连接

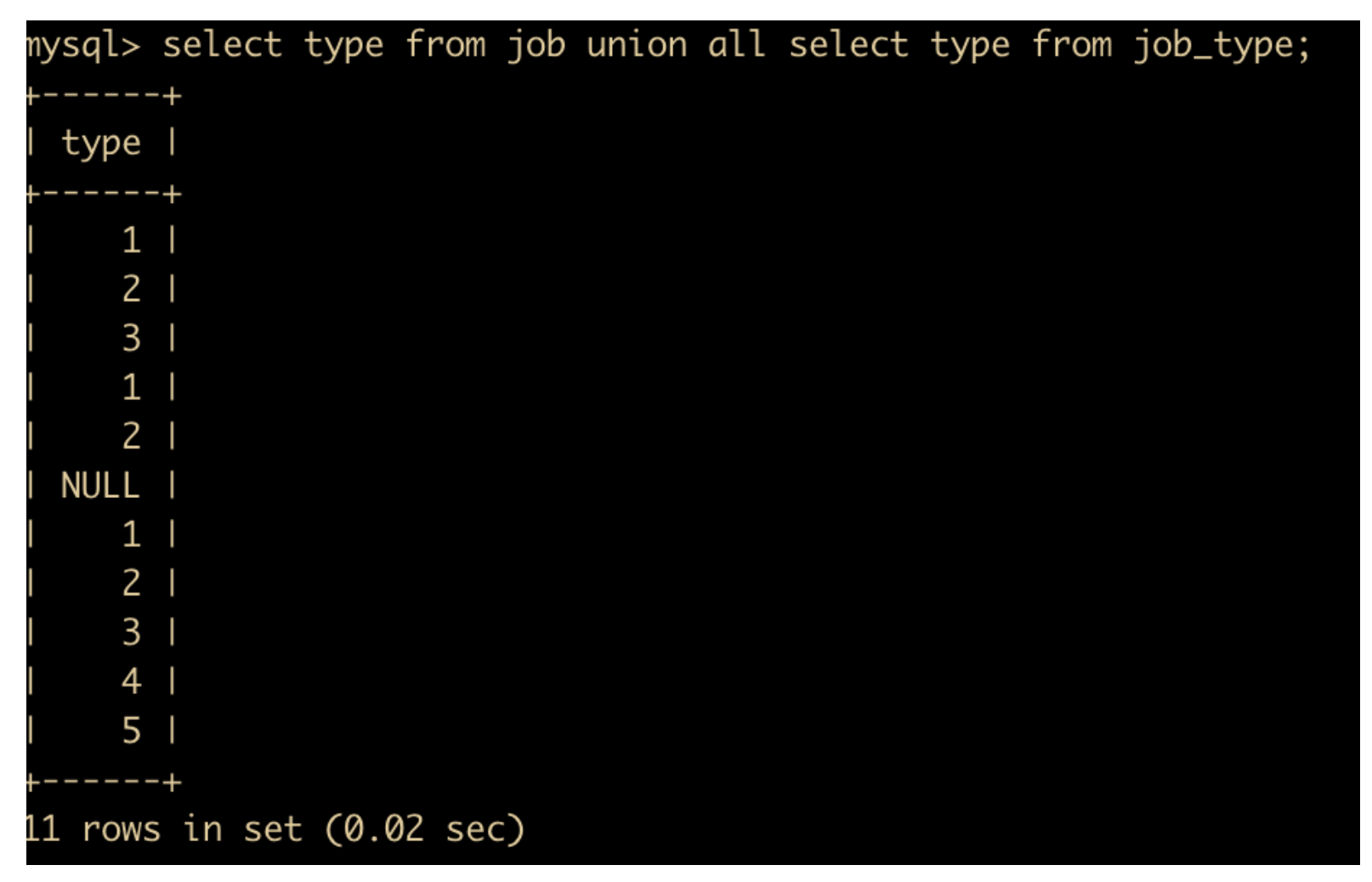

联合查询

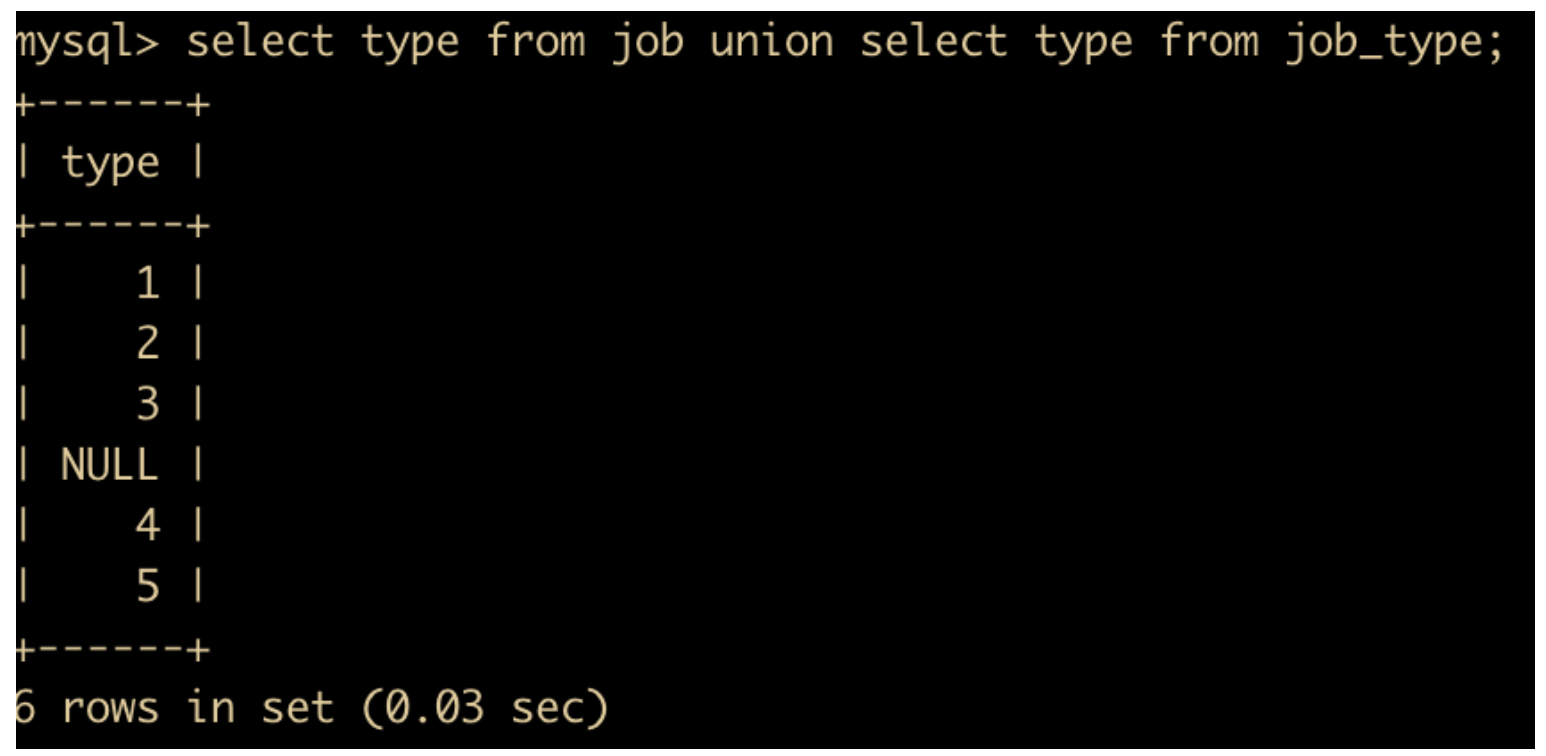

我们还经常会遇到这样的场景,将两个表的数据单独查询出来之后,将结果合并到一起进行显示,这个时候就需要 UNION 和 UNION ALL 这两个关键字来实现这样的功能,UNION 和 UNION ALL 的主要区别是 UNION ALL 是把结果集直接合并在一起,而 UNION 是将 UNION ALL 后的结果进行一次 DISTINCT 去除掉重复数据。

比如

select type from job union all select type from job_type;

它的结果如下

上述结果是查询 job 表中的 type 字段和 job_type 表中的 type 字段,并把它们进行汇总,可以看出 UNION ALL 只是把所有的结果都列出来了

使用 UNION 的 SQL 语句如下

select type from job union select type from job_type;

可以看出 UNION 是对 UNION ALL 使用了 distinct 去重处理。

DCL 语句

DCL 语句主要是管理数据库权限的时候使用,这类操作一般是 DBA 使用的,开发人员不会使用 DCL 语句。

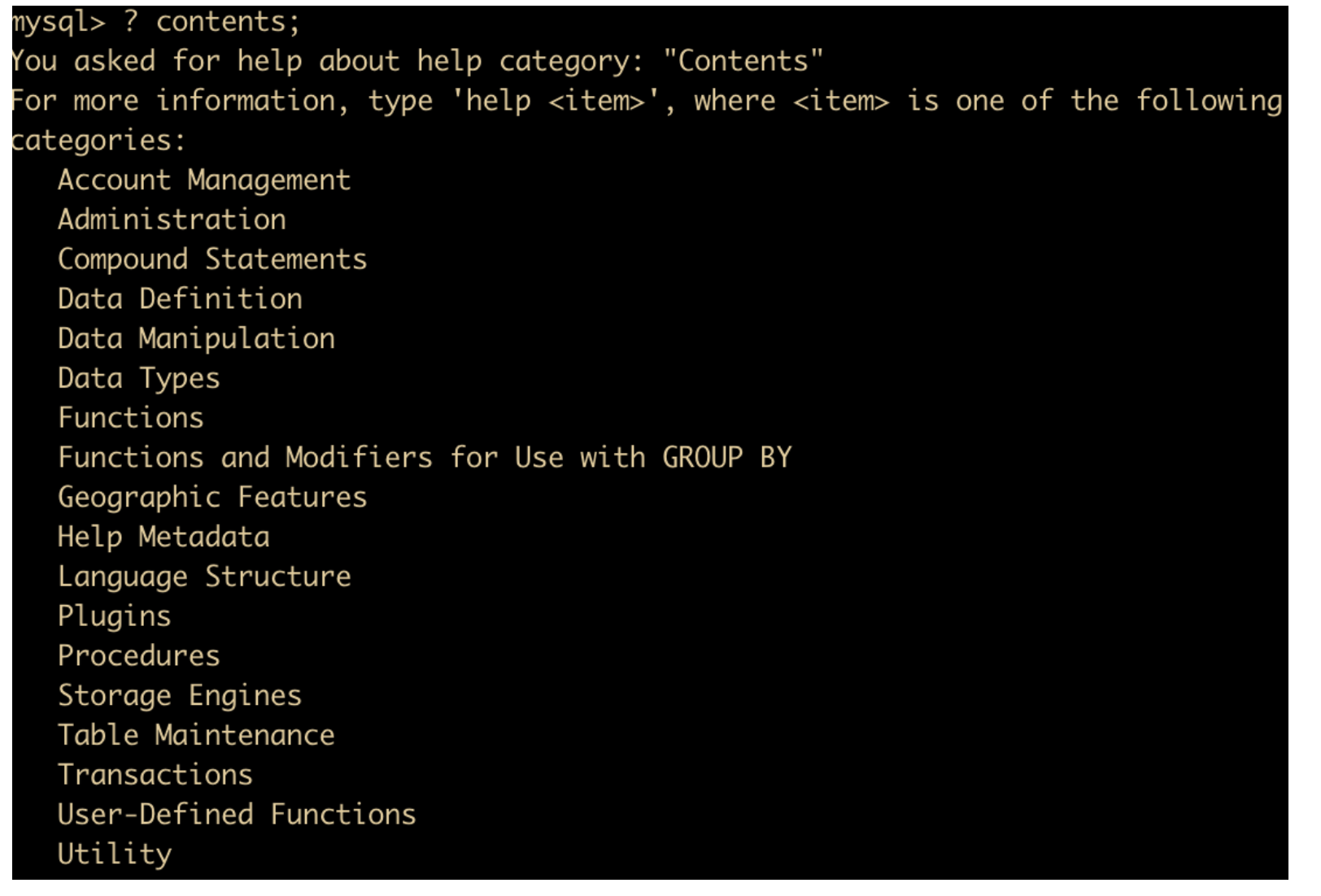

关于帮助文档的使用

我们一般使用 MySQL 遇到不会的或者有疑问的东西经常要去查阅网上资料,甚至可能需要去查 MySQL 官发文档,这样会耗费大量的时间和精力。

下面教你一下在 MySQL 命令行就能直接查询资料的语句

按照层次查询

可以使用 ? contents 来查询所有可供查询的分类,如下所示

? contents;

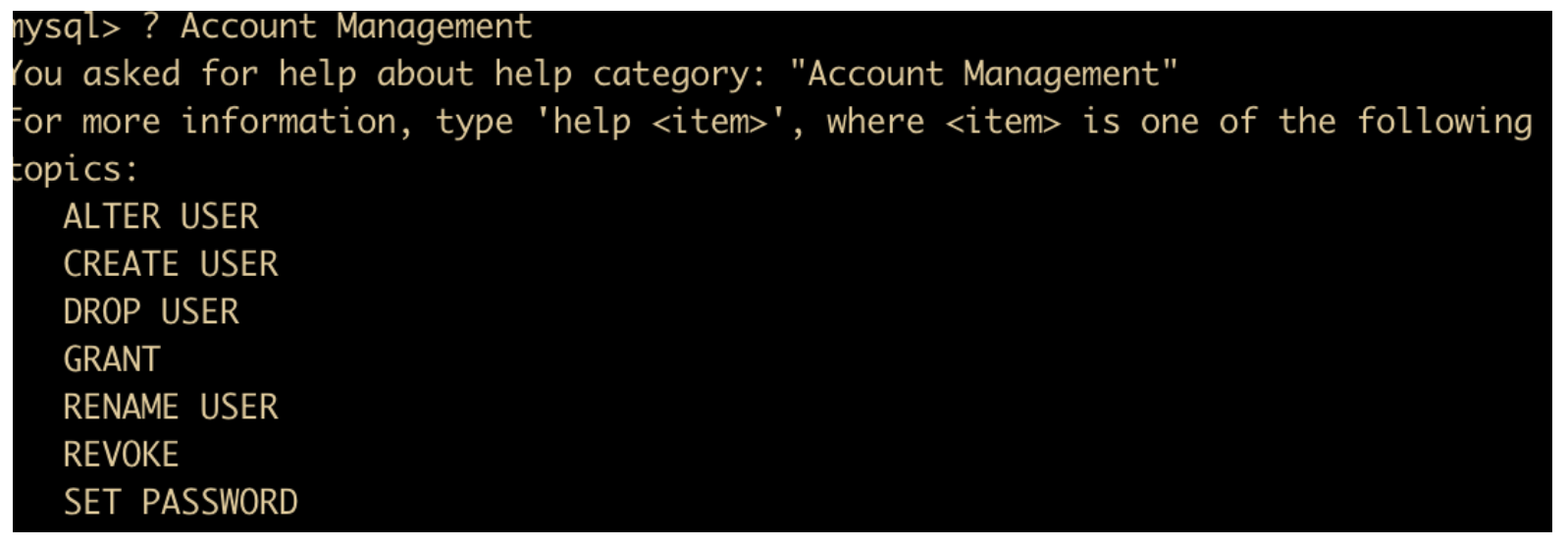

我们输入

? Account Management

可以查询具体关于权限管理的命令

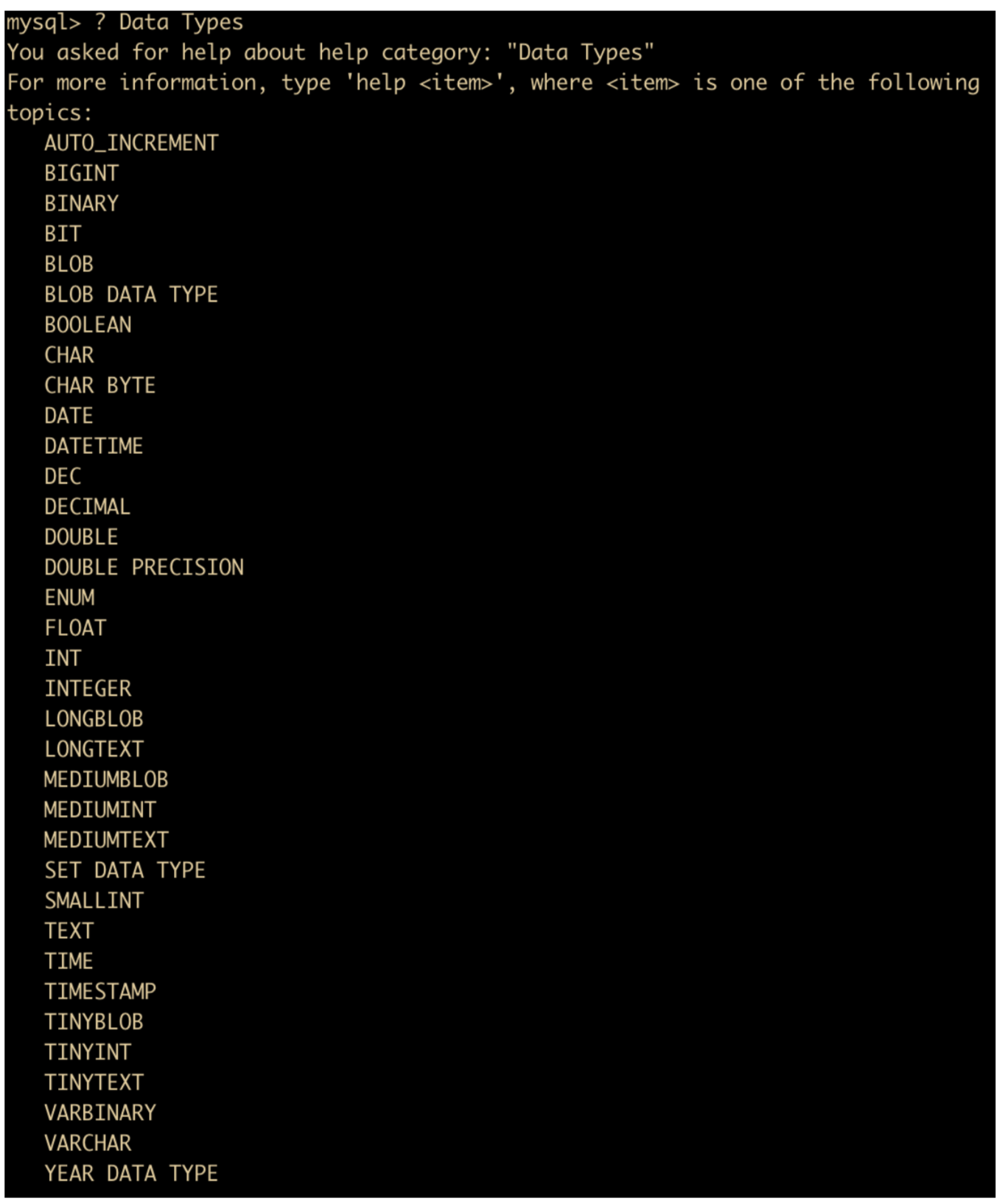

比如我们想了解一下数据类型

? Data Types

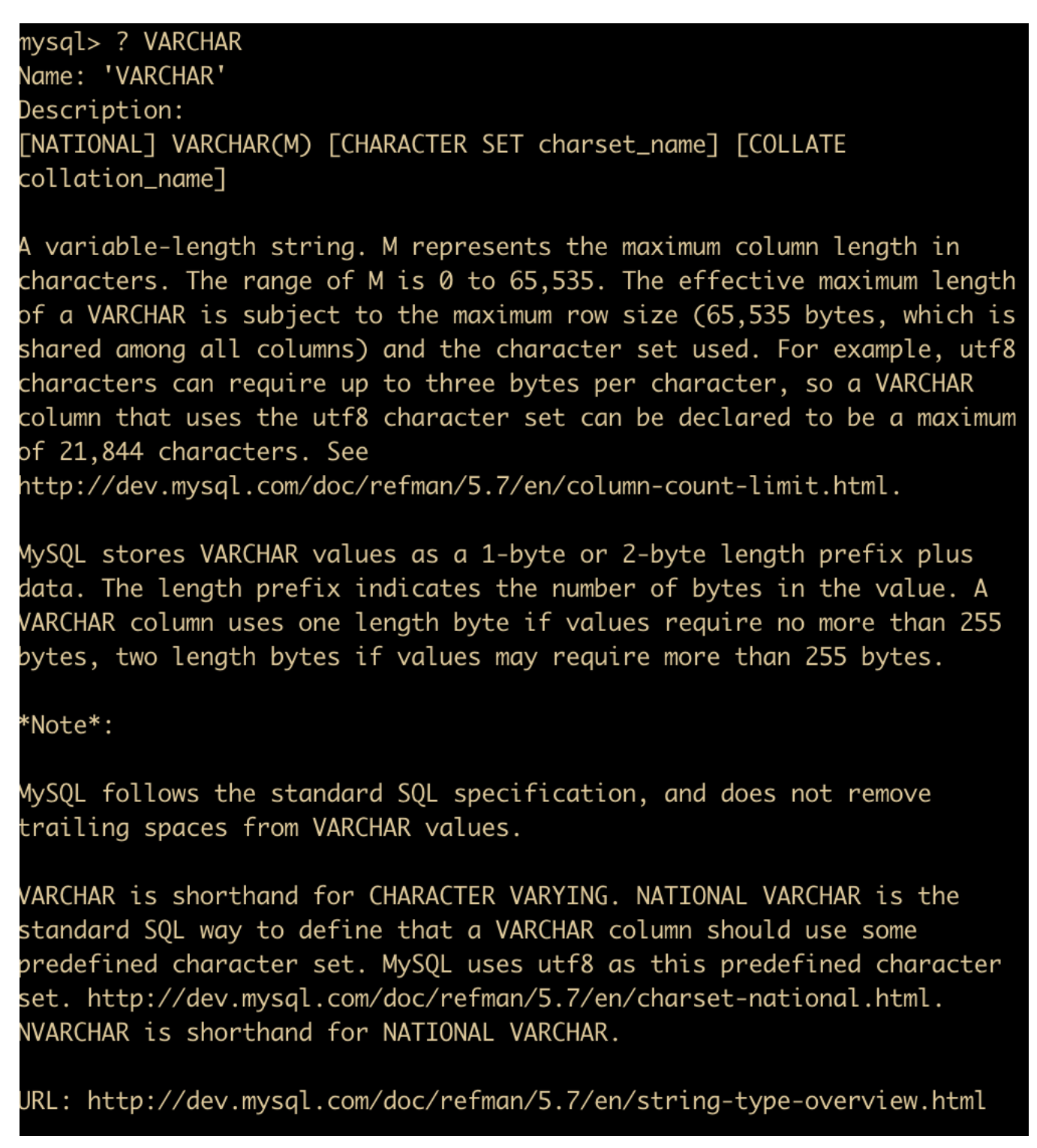

然后我们想了解一下 VARCHAR 的基本定义,可以直接使用

? VARCHAR

可以看到有关于 VARCHAR 数据类型的详细信息,然后在最下面还有 MySQL 的官方文档,方便我们快速查阅。

快速查阅

在实际应用过程中,如果要快速查询某个语法时,可以使用关键字进行快速查询,比如我们使用

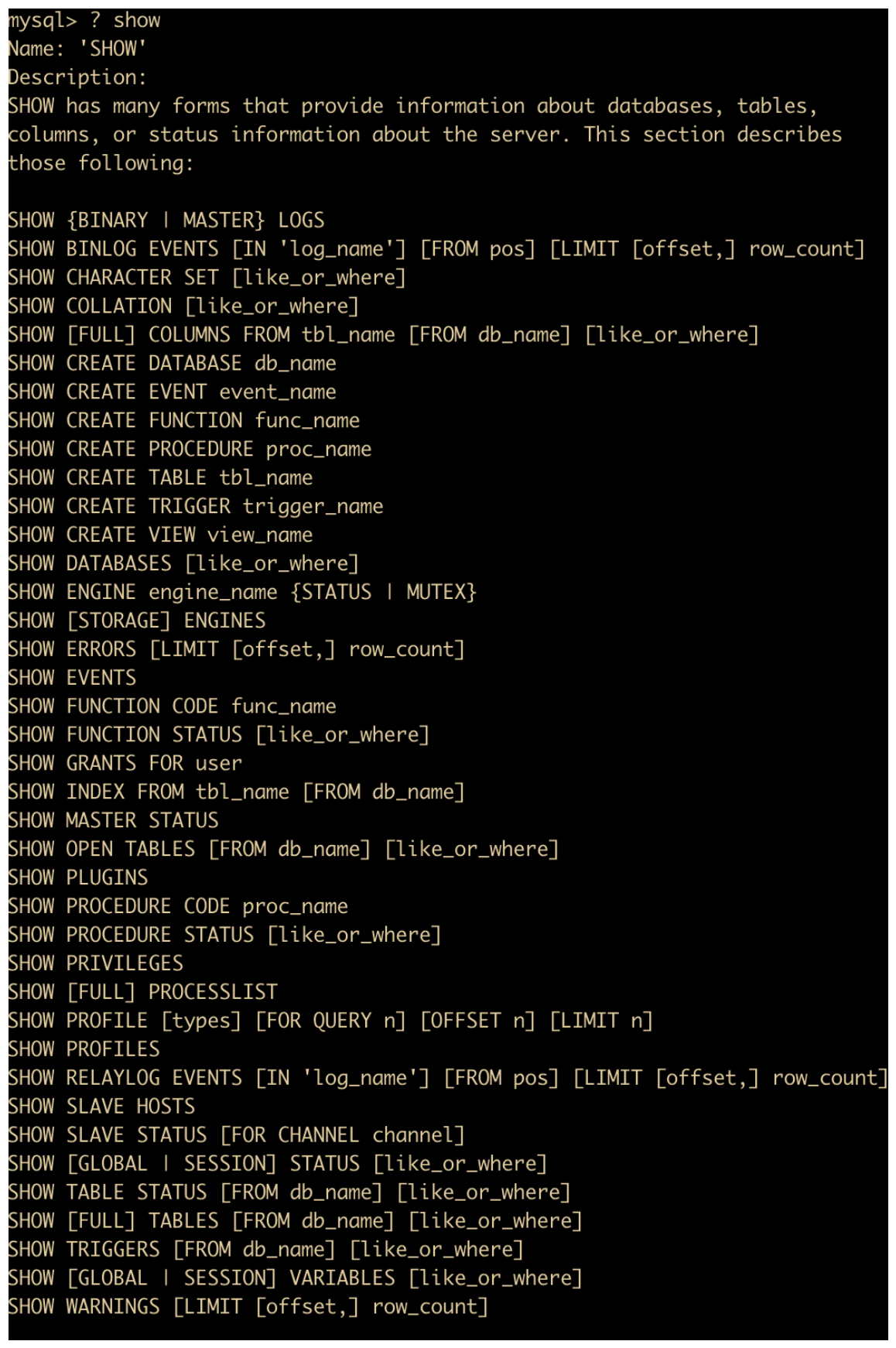

? show

能够快速列出一些命令

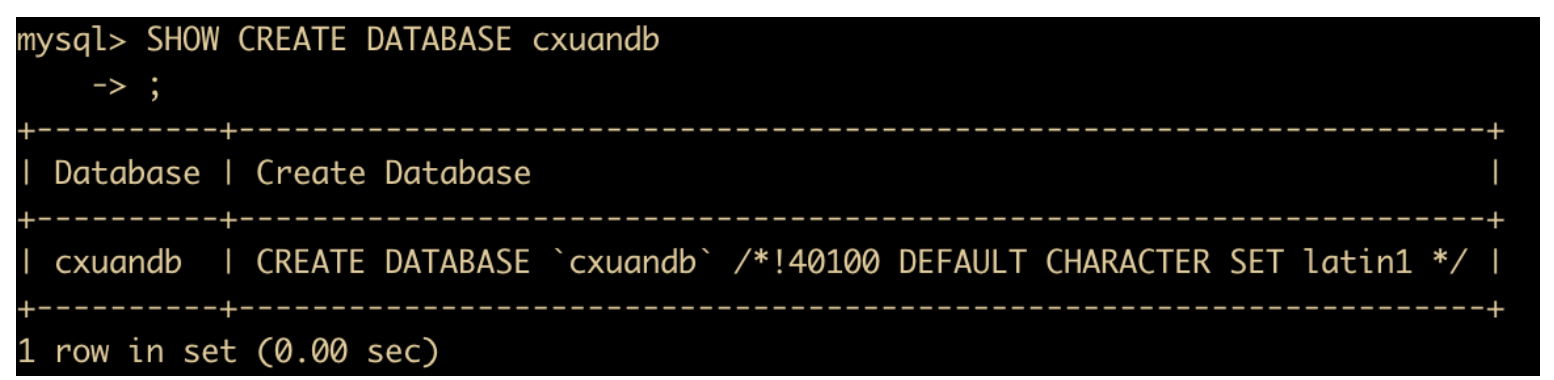

比如我们想要查阅 database 的信息,使用

SHOW CREATE DATABASE cxuandb;

MySQL 数据类型

MySQL 提供很多种数据类型来对不同的常量、变量进行区分,MySQL 中的数据类型主要是 数值类型、日期和时间类型、字符串类型 选择合适的数据类型进行数据的存储非常重要,在实际开发过程中,选择合适的数据类型也能够提高 SQL 性能,所以有必要认识一下这些数据类型。

数值类型

MySQL 支持所有标准的 SQL 数据类型,这些数据类型包括严格数据类型的严格数值类型,这些数据类型有

- INTEGER

- SMALLINT

- DECIMAL

- NUMERIC。

近似数值数据类型 并不用严格按照指定的数据类型进行存储,这些有

- FLOAT

- REAL

- DOUBLE PRECISION

还有经过扩展之后的数据类型,它们是

- TINYINT

- MEDIUMINT

- BIGINT

- BIT

其中 INT 是 INTEGER 的缩写,DEC 是 DECIMAL 的缩写。

下面是所有数据类型的汇总

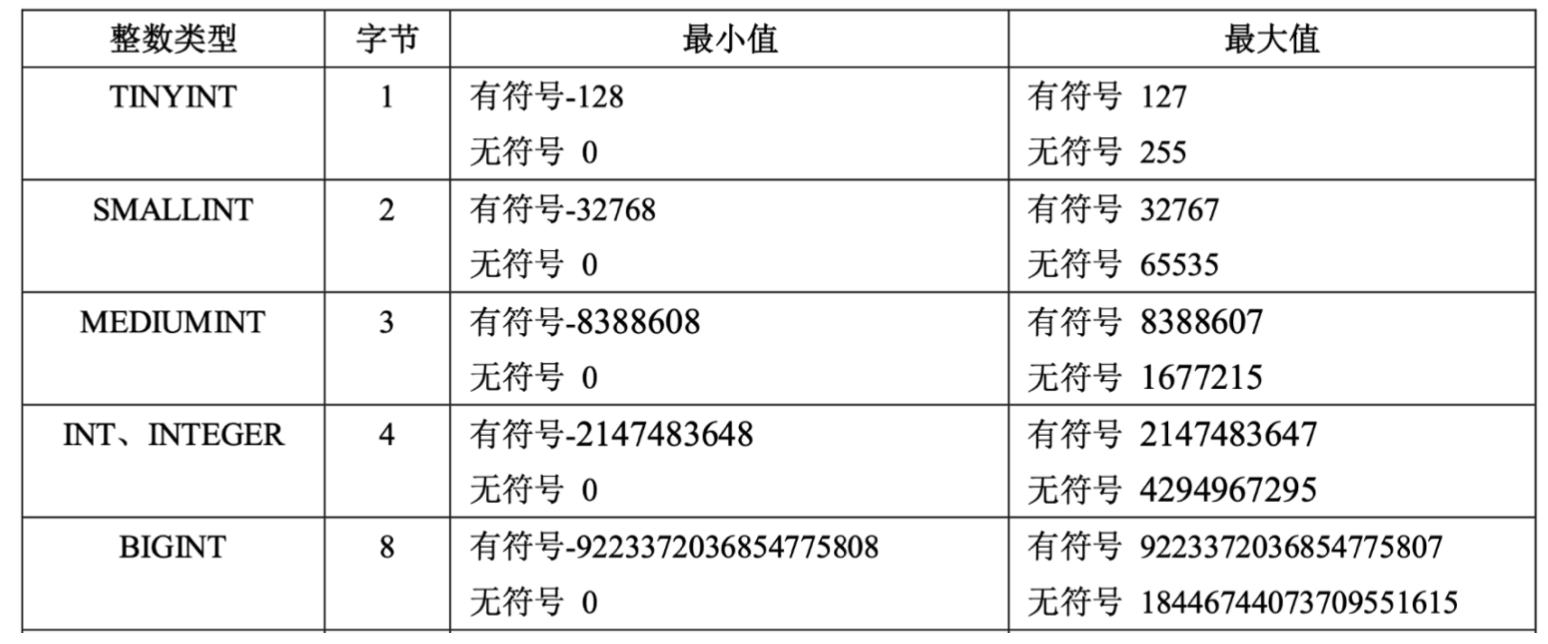

整数

在整数类型中,按照取值范围和存储方式的不同,分为

- TINYINT ,占用 1 字节

- SMALLINT,占用 2 字节

- MEDIUMINT,占用 3 字节

- INT、INTEGER,占用 4 字节

- BIGINT,占用 8 字节

五个数据类型,如果超出类型范围的操作,会发生错误提示,所以选择合适的数据类型非常重要。

还记得我们上面的建表语句么

我们一般会在 SQL 语句的数据类型后面加上指定长度来表示数据类型许可的范围,例如

int(7)

表示 int 类型的数据最大长度为 7,如果填充不满的话会自动填满,如果不指定 int 数据类型的长度的话,默认是 int(11)。

我们创建一张表来演示一下

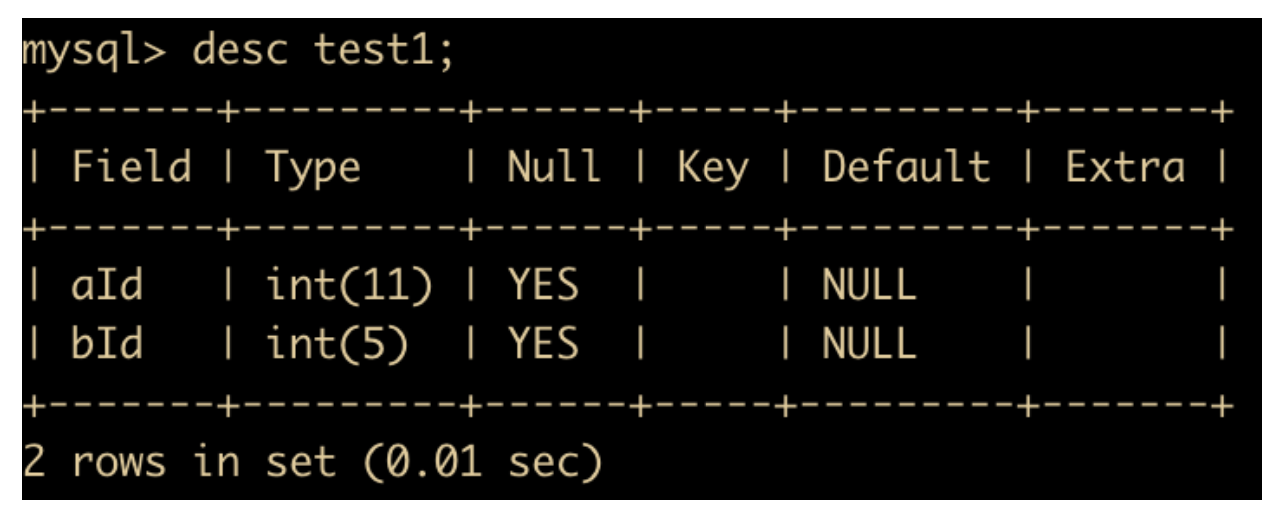

create table test1(aId int, bId int(5));

/* 然后我们查看一下表结构 */ desc test1;

整数类型一般配合 zerofill 来使用,顾名思义,就是用 0 进行填充,也就是数字位数不够的空间使用 0 进行填充。

分别修改 test1 表中的两个字段

alter table test1 modify aId int zerofill;

alter table test1 modify bId int(5) zerofill;

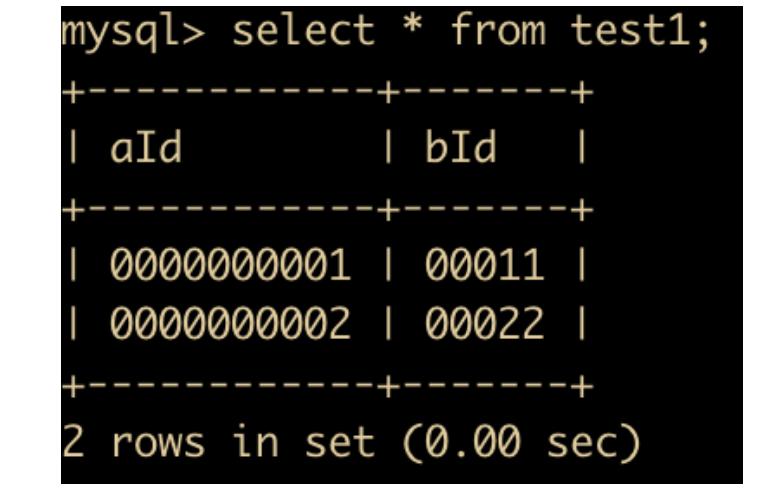

然后插入两条数据,执行查询操作

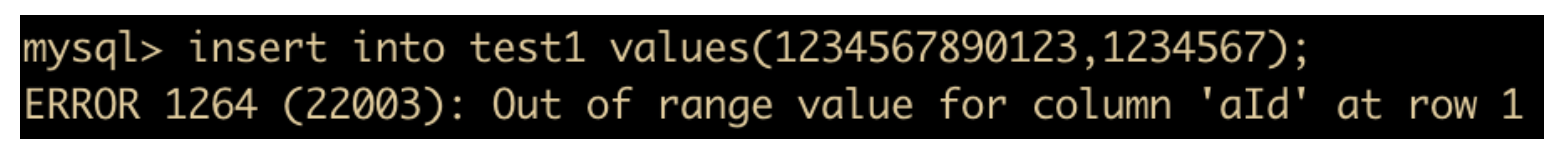

如上图所示,使用zerofill 可以在数字前面使用 0 来进行填充,那么如果宽度超过指定长度后会如何显示?我们来试验一下,向 aId 和 bId 分别插入超过字符限制的数字

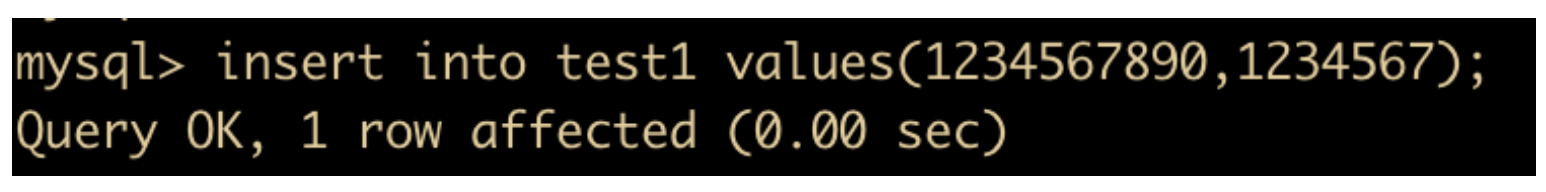

会发现 aId 已经超出了指定范围,那么我们对 aId 插入一个在其允许范围之内的数据

会发现,aId 已经插进去了,bId 也插进去了,为什么 bId 显示的是 int(5) 却能够插入 7 位长度的数值呢?

所有的整数都有一个可选属性 UNSIGNED(无符号),如果需要在字段里面保存非负数或者是需要较大上限值时,可以使用此选项,它的取值范围是正常值的下限取 0 ,上限取原值的 2 倍。如果一个列为 zerofill ,会自动为该列添加 UNSIGNED 属性。

除此之外,整数还有一个类型就是 AUTO_INCREMENT,在需要产生唯一标识符或者顺序值时,可利用此属性,这个属性只用于整数字符。一个表中最多只有一个 AUTO_INCREMENT 属性,一般用于自增主键,而且 NOT NULL,并且是 PRIMARY KEY 和 UNIQUE 的,主键必须保证唯一性而且不为空。

小数

小数说的是啥?它其实有两种类型;一种是浮点数类型,一种是定点数类型;

浮点数有两种

- 单精度浮点型 – float 型

- 双精度浮点型 – double 型

定点数只有一种 decimal。定点数在 MySQL 内部中以字符串的形式存在,比浮点数更为准确,适合用来表示精度特别高的数据。

浮点数和定点数都可以使用 (M,D) 的方式来表示,M 表示的就是 整数位 + 小数位 的数字,D 表示位于 . 后面的小数。M 也被称为精度 ,D 被称为标度。

下面通过示例来演示一下

首先建立一个 test2 表

CREATE TABLE test2 (aId float(6,2) default NULL, bId double(6,2) default NULL,cId decimal(6,2) default NULL)

然后向表中插入几条数据

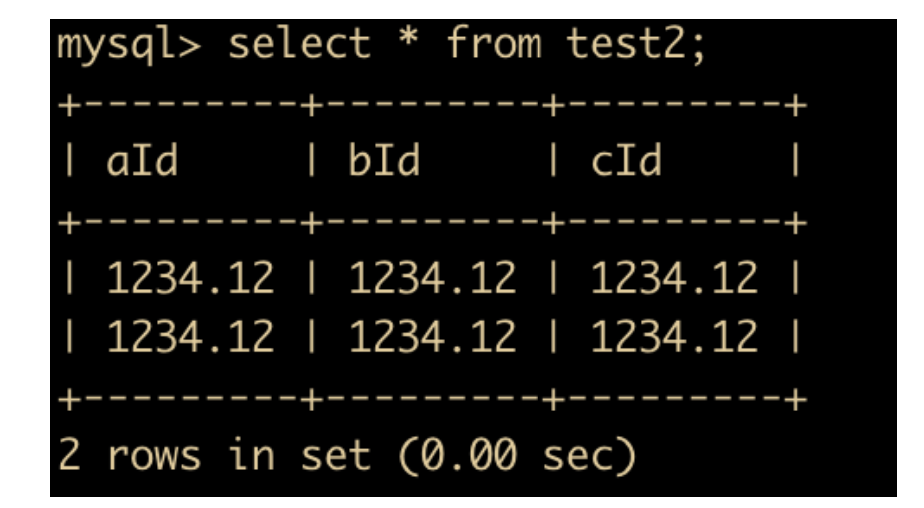

insert into test2 values(1234.12,1234.12,1234.12);

这个时候显示的数据就是

然后再向表中插入一些约束之外的数据

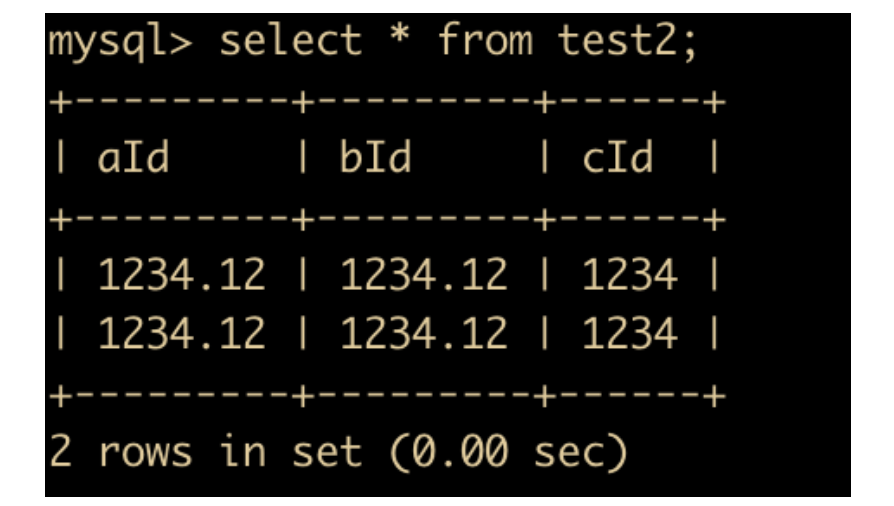

insert into test2 values(1234.123,1234.123,1234.123);

发现插入完成后还显示的是 1234.12,小数位第三位的值被舍去了。

现在我们把 test2 表中的精度全部去掉,再次插入

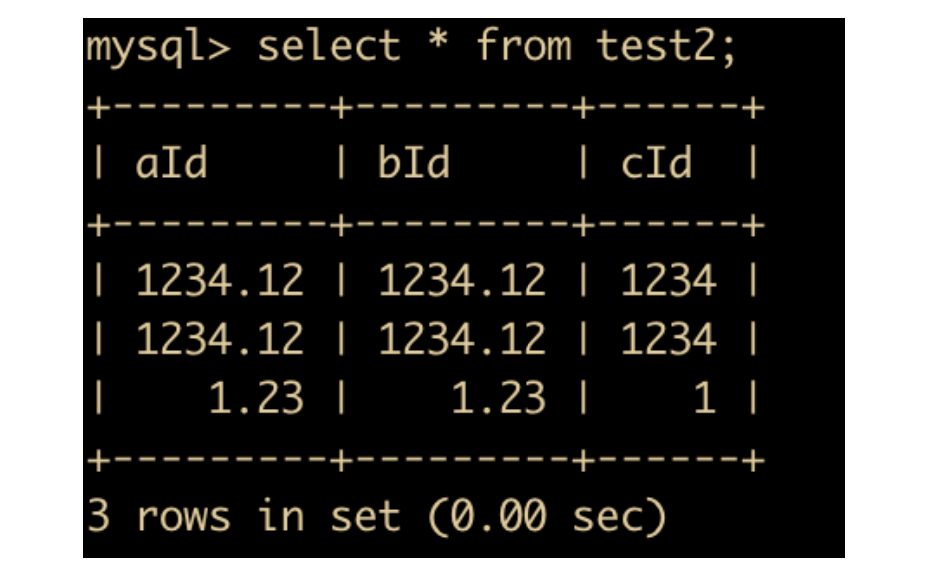

alter table test2 modify aId float;

alter table test2 modify bId double;

alter table test2 modify cId decimal;

先查询一下,发现 cId 舍去了小数位。

然后再次插入 1.23,SQL 语句如下

insert into test2 values(1.23,1.23,1.23);

结果如下

这个时候可以验证

- 浮点数如果不写精度和标度,会按照实际的精度值进行显示

- 定点数如果不写精度和标度,会按照

decimal(10,0)来进行操作,如果数据超过了精度和标题,MySQL 会报错

位类型

对于位类型,用于存放字段值,BIT(M) 可以用来存放多位二进制数,M 的范围是 1 – 64,如果不写的话默认为 1 位。

下面我们来掩饰一下位类型

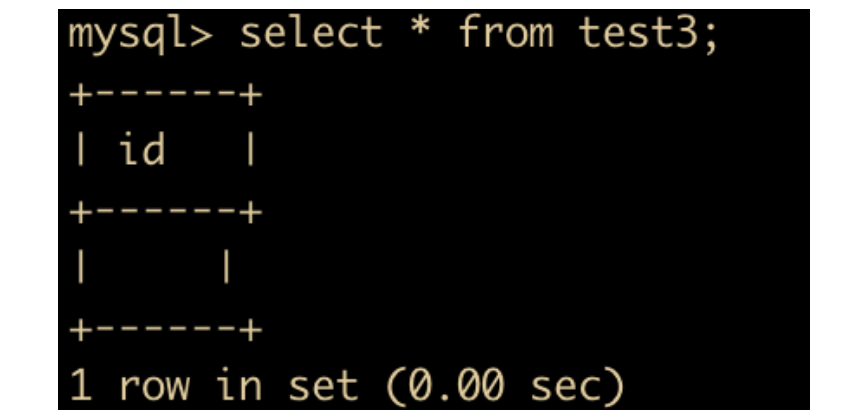

新建一个 test3 表,表中只有一个位类型的字段

create table test3(id bit(1));

然后随意插入一条数据

insert into test3 values(1);

发现无法查询出对应结果。

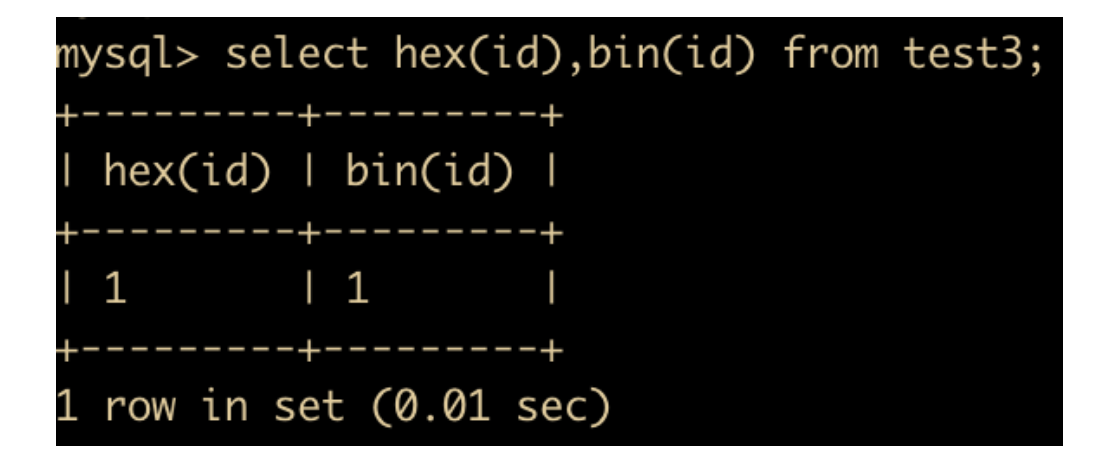

然后我们使用 hex() 和 bin() 函数进行查询

发现能够查询出对应结果。

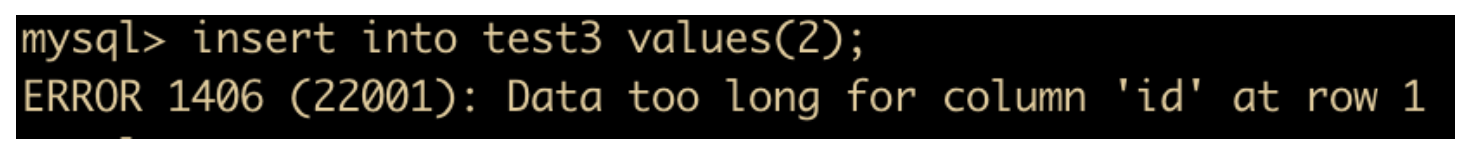

也就是说当数据插入 test3 时,会首先把数据转换成为二进制数,如果位数允许,则将成功插入;如果位数小于实际定义的位数,则插入失败。如果我们像表中插入数据 2

insert into test3 values(2);

那么会报错

因为 2 的二进制数表示是 10,而表中定义的是 bit(1) ,所以无法插入。

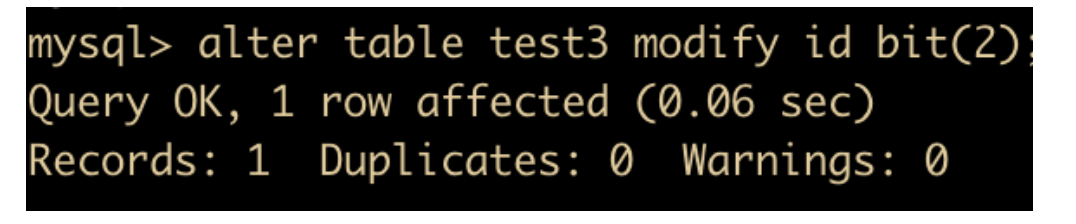

那么我们将表字段修改一下

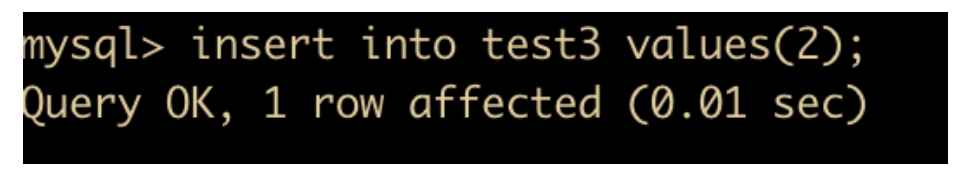

然后再进行插入,发现已经能够插入了

日期时间类型

MySQL 中的日期与时间类型,主要包括:YEAR、TIME、DATE、DATETIME、TIMESTAMP,每个版本可能不同。下表中列出了这几种类型的属性。

下面分别来介绍一下

YEAR

YEAR 可以使用三种方式来表示

- 用 4 位的数字或者字符串表示,两者效果相同,表示范围 1901 – 2155,插入超出范围的数据会报错。

- 以 2 位字符串格式表示,范围为 ‘00’~‘99’。‘00’~‘69’ 表示 2000~2069,‘70’~‘99’ 表示1970~1999。‘0’ 和 ‘00’ 都会被识别为 2000,超出范围的数据也会被识别为 2000。

- 以 2 位数字格式表示,范围为 1~99。1~69 表示 2001~2069, 70~99 表示 1970~1999。但 0 值会被识别为0000,这和 2 位字符串被识别为 2000 有所不同

下面我们来演示一下 YEAR 的用法,创建一个 test4 表

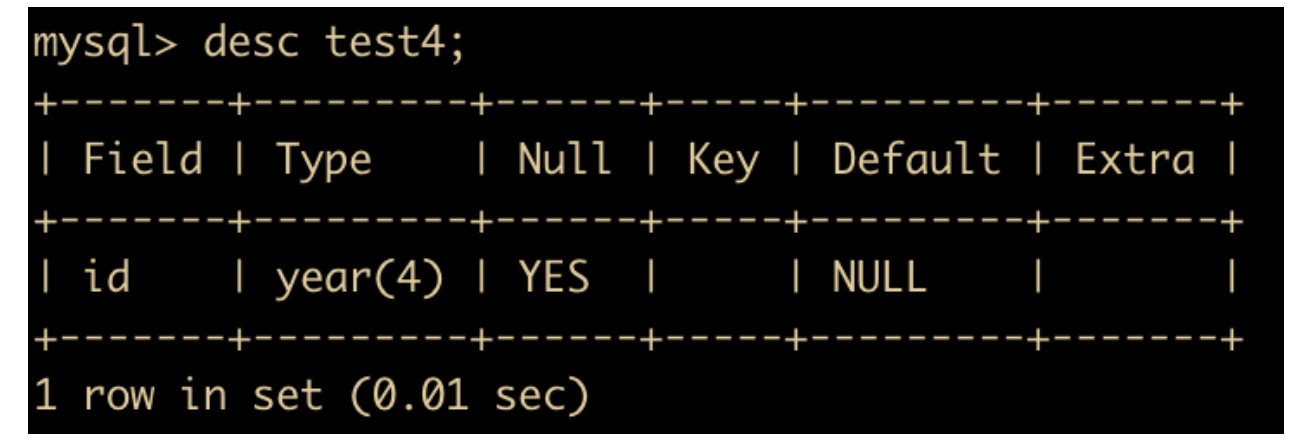

create table test4(id year);

然后我们看一下 test4 的表结构

默认创建的 year 就是 4 位,下面我们向 test4 中插入数据

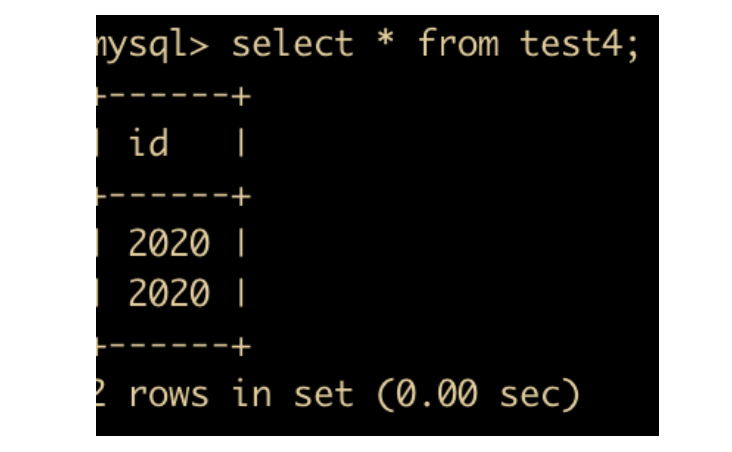

insert into test4 values(2020),('2020');

然后进行查询,发现表示形式是一样的

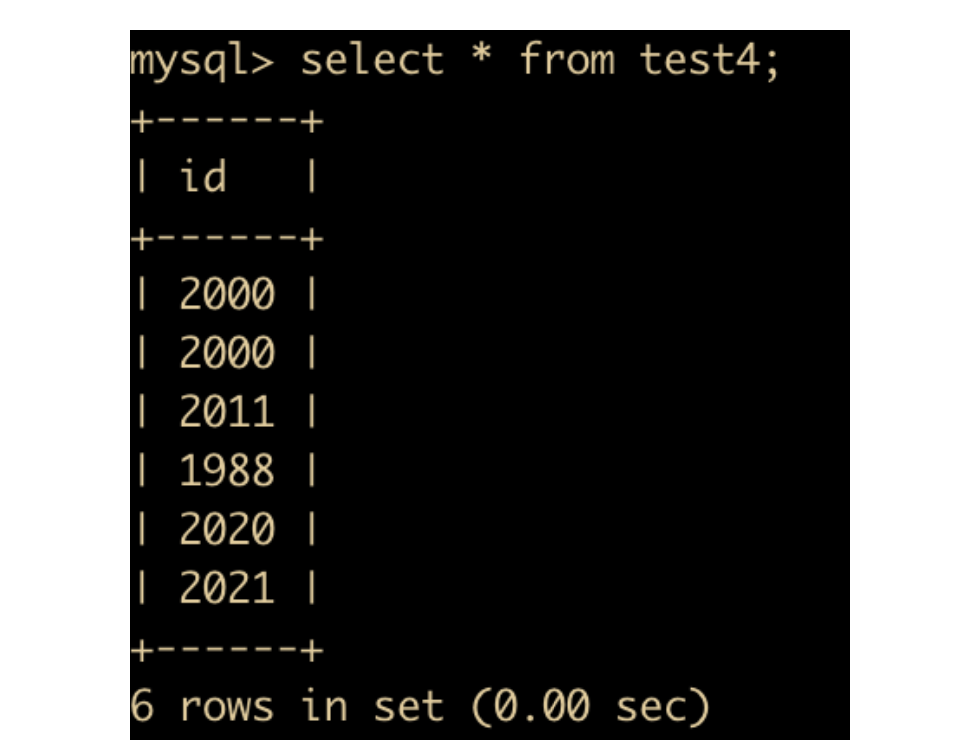

使用两位字符串来表示

delete from test4;

insert into test4 values ('0'),('00'),('11'),('88'),('20'),('21');

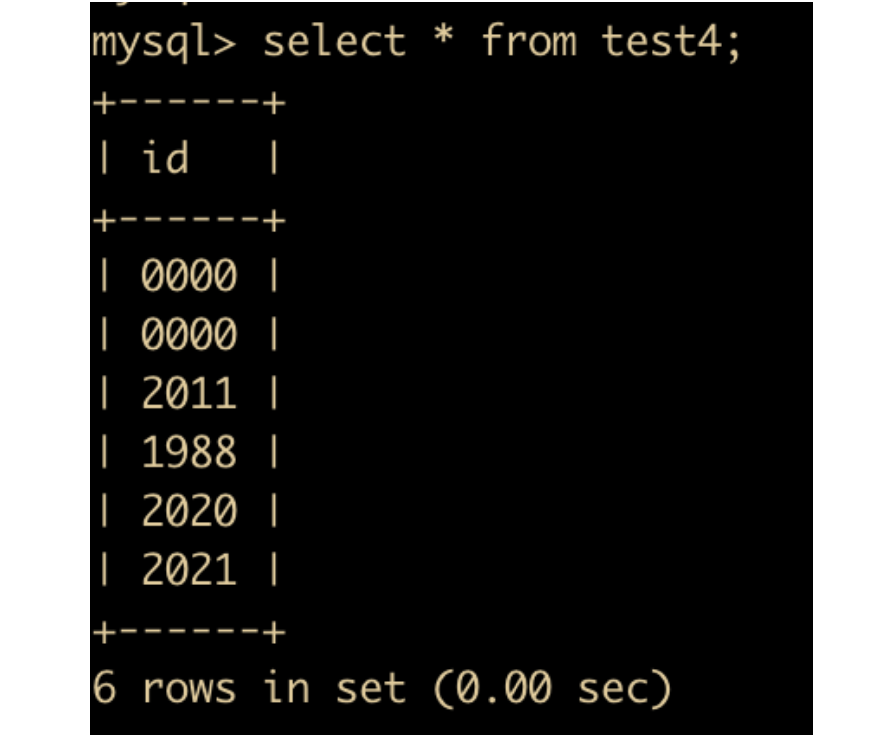

使用两位数字来表示

delete from test4;

insert into test4 values (0),(00),(11),(88),(20),(21);

发现只有前两项不一样。

TIME

TIME 所表示的范围和我们预想的不一样

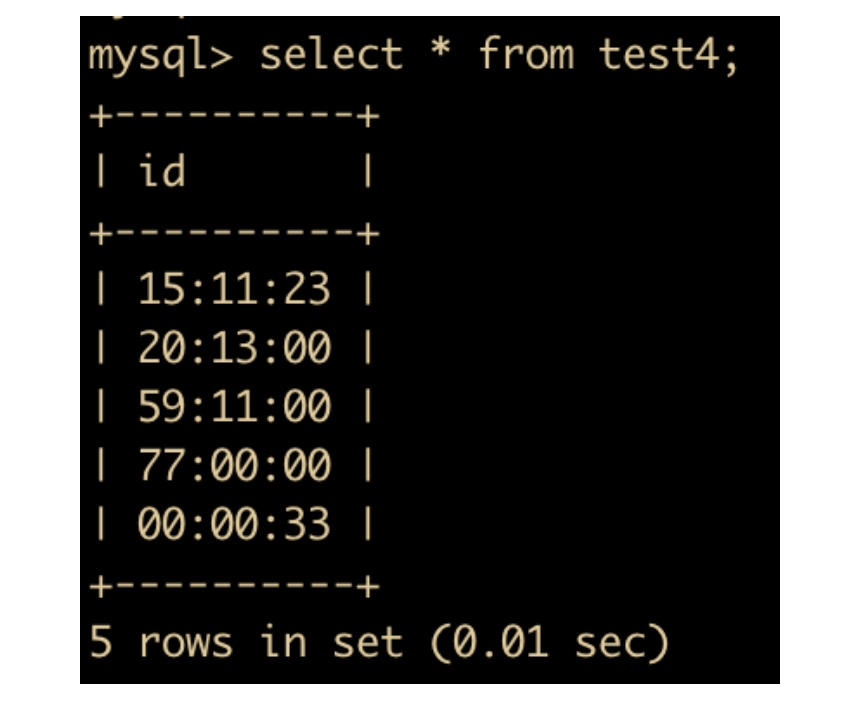

我们把 test4 改为 TIME 类型,下面是 TIME 的示例

alter table test4 modify id TIME;

insert into test4 values ('15:11:23'),('20:13'),('2 11:11'),('3 05'),('33');

结果如下

DATE

DATE 表示的类型有很多种,下面是 DATE 的几个示例

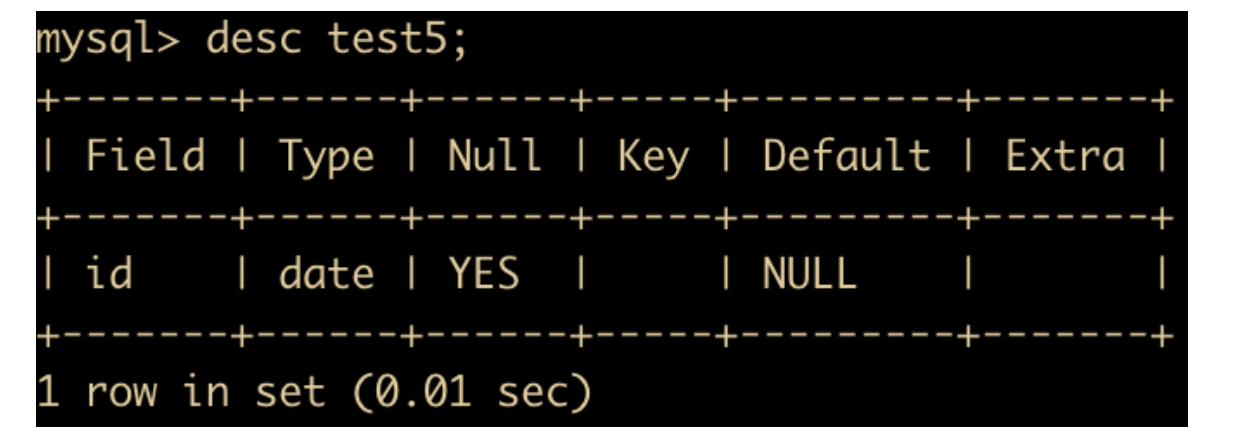

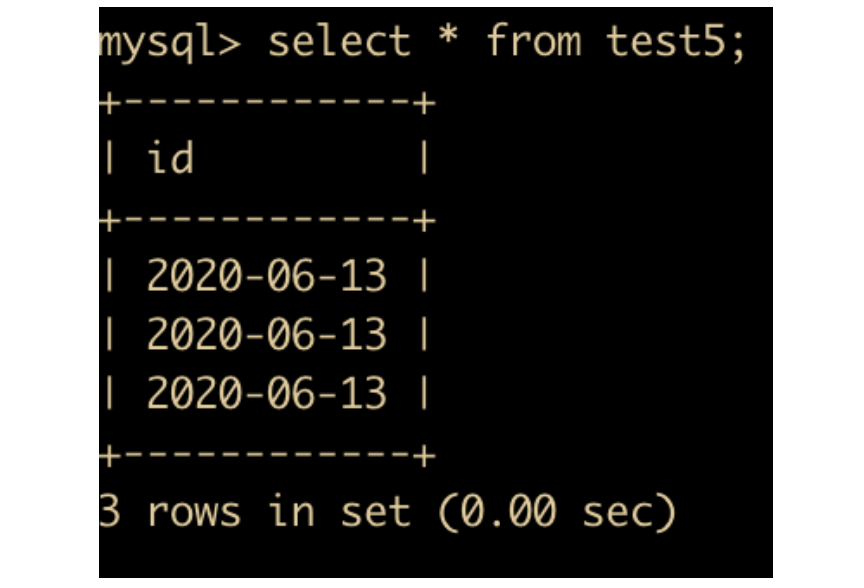

create table test5 (id date);

查看一下 test5 表

然后插入部分数据

insert into test5 values ('2020-06-13'),('20200613'),(20200613);

DATE 的表示一般很多种,如下所示 DATE 的所有形式

- ‘YYYY-MM-DD’

- ‘YYYYMMDD’

- YYYYMMDD

- ‘YY-MM-DD’

- ‘YYMMDD’

- YYMMDD

DATETIME

DATETIME 类型,包含日期和时间部分,可以使用引用字符串或者数字,年份可以是 4 位也可以是 2 位。

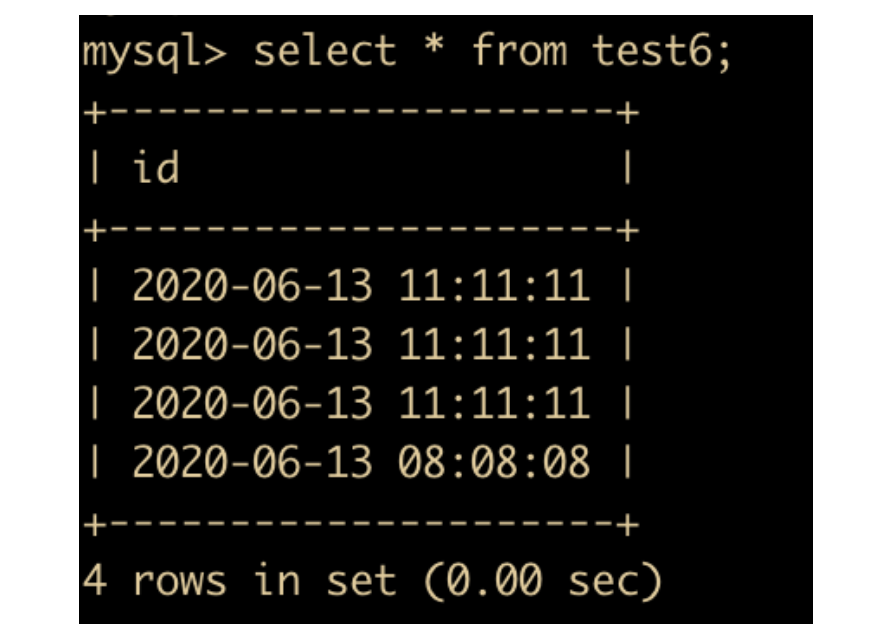

下面是 DATETIME 的示例

create table test6 (id datetime);

insert into test4 values ('2020-06-13 11:11:11'),(20200613111111),('20200613111111'),(20200613080808);

TIMESTAMP

TIMESTAMP 类型和 DATETIME 类型的格式相同,存储 4 个字节(比DATETIME少),取值范围比 DATETIME 小。

下面来说一下各个时间类型的使用场景

一般表示

年月日,通常用DATE类型;用来表示

时分秒,通常用TIME表示;年月日时分秒,通常用DATETIME来表示;如果需要插入的是当前时间,通常使用

TIMESTAMP来表示,TIMESTAMP 值返回后显示为YYYY-MM-DD HH:MM:SS格式的字符串,如果只表示年份、则应该使用 YEAR,它比 DATE 类型需要更小的空间。

每种日期类型都有一个范围,如果超出这个范围,在默认的 SQLMode 下,系统会提示错误,并进行零值存储。

下面来解释一下 SQLMode 是什么

MySQL 中有一个环境变量是 sql_mode ,sql_mode 支持了 MySQL 的语法、数据校验,我们可以通过下面这种方式来查看当前数据库使用的 sql_mode

select @@sql_mode;

一共有下面这几种模式

来源于 https://www.cnblogs.com/Zender/p/8270833.html

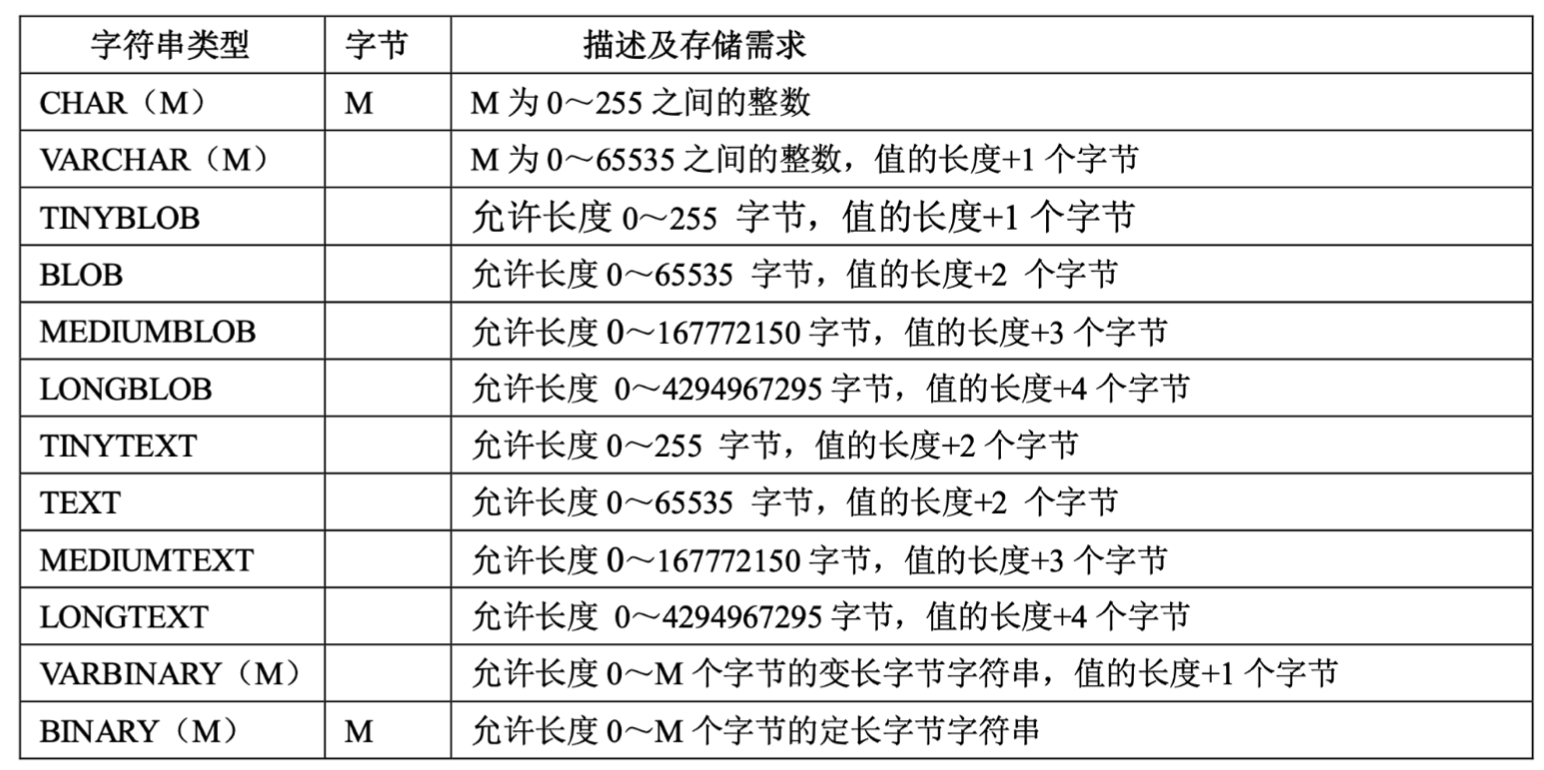

字符串类型

MySQL 提供了很多种字符串类型,下面是字符串类型的汇总

下面我们对这些数据类型做一个详细的介绍

CHAR 和 VARCHAR 类型

CHAR 和 VARCHAR 类型很相似,导致很多同学都会忽略他们之间的差别,首先他俩都是用来保存字符串的数据类型,他俩的主要区别在于存储方式不同。CHAR 类型的长度就是你定义多少显示多少。占用 M 字节,比如你声明一个 CHAR(20) 的字符串类型,那么每个字符串占用 20 字节,M 的取值范围时 0 – 255。VARCHAR 是可变长的字符串,范围是 0 – 65535,在字符串检索的时候,CHAR 会去掉尾部的空格,而 VARCHAR 会保留这些空格。下面是演示例子

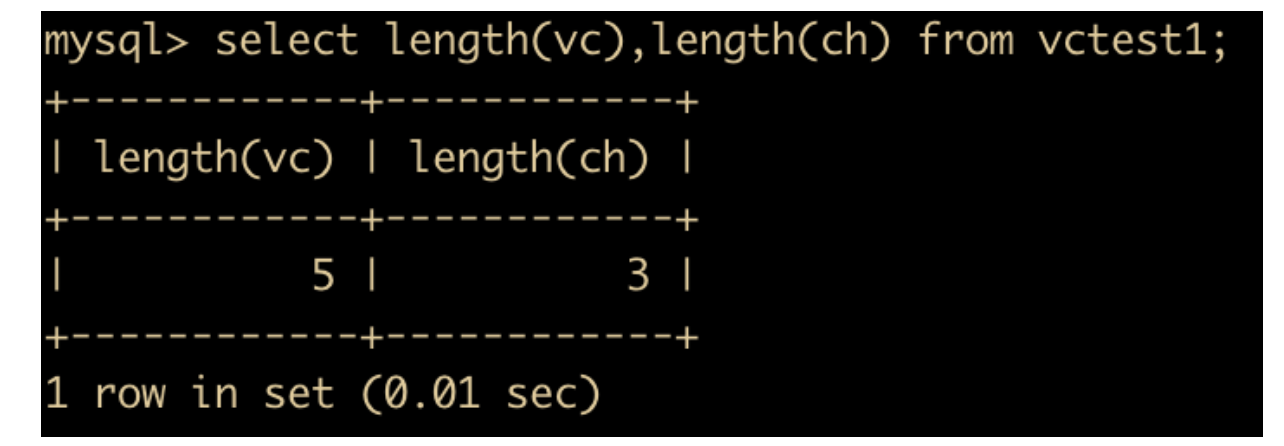

create table vctest1 (vc varchar(6),ch char(6));

insert into vctest1 values("abc ","abc ");

select length(vc),length(ch) from vctest1;

结果如下

可以看到 vc 的字符串类型是 varchar ,长度是 5,ch 的字符串类型是 char,长度是 3。可以得出结论,varchar 会保留最后的空格,char 会去掉最后的空格。

BINARY 和 VARBINARY 类型

BINARY 和 VARBINARY 与 CHAR 和 VARCHAR 非常类似,不同的是它们包含二进制字符串而不包含非二进制字符串。BINARY 与 VARBINARY 的最大长度和 CHAR 与 VARCHAR 是一样的,只不过他们是定义字节长度,而 CHAR 和 VARCHAR 对应的是字符长度。

BLOB 类型

BLOB 是一个二进制大对象,可以容纳可变数量的数据。有 4 种 BLOB 类型:TINYBLOB、BLOB、MEDIUMBLOB 和 LONGBLOB。它们区别在于可容纳存储范围不同。

TEXT 类型

有 4 种 TEXT 类型:TINYTEXT、TEXT、MEDIUMTEXT 和 LONGTEXT。对应的这 4 种 BLOB 类型,可存储的最大长度不同,可根据实际情况选择。

ENUM 类型

ENUM 我们在 Java 中经常会用到,它表示的是枚举类型。它的范围需要在创建表时显示指定,对 1 – 255 的枚举需要 1 个字节存储;对于 255 – 65535 的枚举需要 2 个字节存储。ENUM 会忽略大小写,在存储时都会转换为大写。

SET 类型

SET 类型和 ENUM 类型有两处不同

- 存储方式

SET 对于每 0 – 8 个成员,分别占用 1 个字节,最大到 64 ,占用 8 个字节

- Set 和 ENUM 除了存储之外,最主要的区别在于 Set 类型一次可以选取多个成员,而 ENUM 则只能选一个。

MySQL 运算符

MySQL 中有多种运算符,下面对 MySQL 运算符进行分类

- 算术运算符

- 比较运算符

- 逻辑运算符

- 位运算符

下面那我们对各个运算符进行介绍

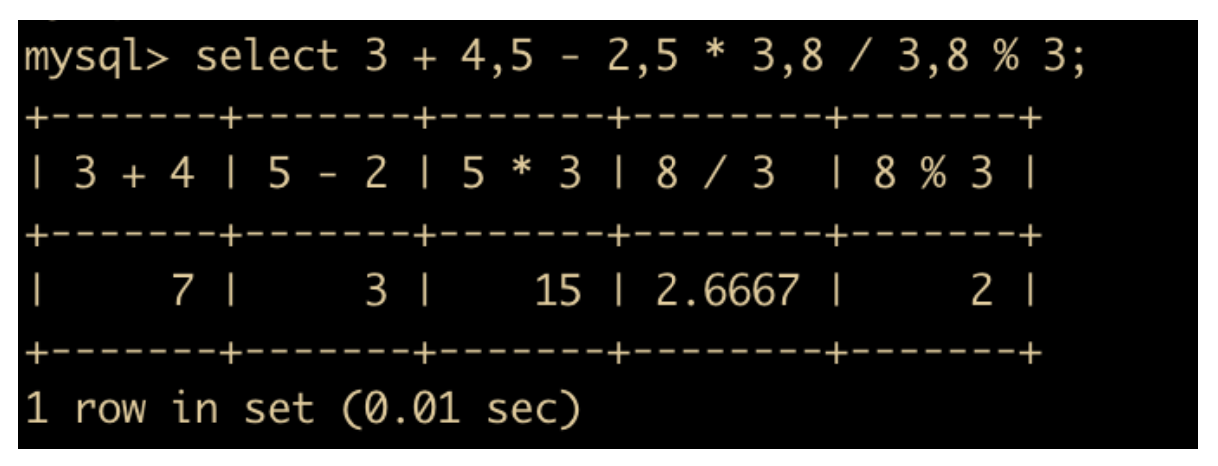

算术运算符

MySQL 支持的算术运算符包括加、减、乘、除和取余,这类运算符的使用频率比较高

下面是运算符的分类

| 运算符 | 作用 |

|---|---|

| + | 加法 |

| – | 减法 |

| x | 乘法 |

| /, DIV | 除法,返回商 |

| %, MOD | 除法,返回余数 |

下面简单描述了这些运算符的使用方法

+用于获得一个或多个值的和-用于从一个值减去另一个值x用于两数相乘,得到两个或多个值的乘积/用一个值除以另一个值得到商%用于一个值除以另一个值得到余数

在除法和取余需要注意一点,如果除数是 0 ,将是非法除数,返回结果为 NULL。

比较运算符

熟悉了运算符,下面来聊一聊比较运算符,使用 SELECT 语句进行查询时,MySQL 允许用户对表达式的两侧的操作数进行比较,比较结果为真,返回 1, 比较结果为假,返回 0 ,比较结果不确定返回 NULL。下面是所有的比较运算符

| 运算符 | 描述 |

|---|---|

| = | 等于 |

| <> 或者是 != | 不等于 |

| <=> | NULL 安全的等于,也就是 NULL-safe |

| < | 小于 |

| <= | 小于等于 |

| > | 大于 |

| >= | 大于等于 |

| BETWEEN | 在指定范围内 |

| IS NULL | 是否为 NULL |

| IS NOT NULL | 是否为 NULL |

| IN | 存在于指定集合 |

| LIKE | 通配符匹配 |

| REGEXP 或 RLIKE | 正则表达式匹配 |

比较运算符可以用来比较数字、字符串或者表达式。数字作为浮点数进行比较,字符串以不区分大小写的方式进行比较。

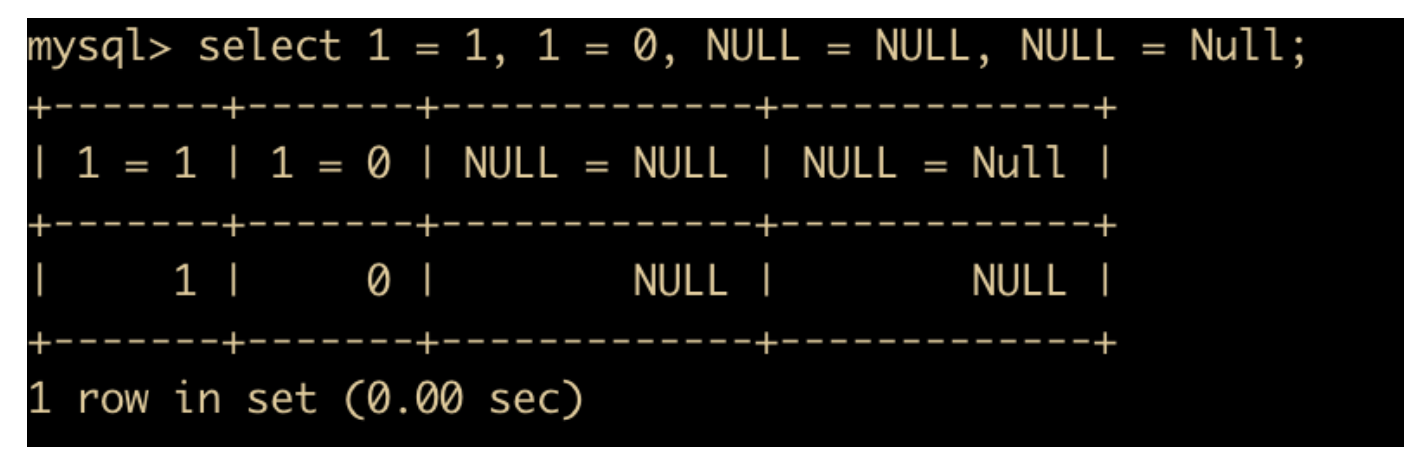

- = 号运算符,用于比较运算符两侧的操作数是否相等,如果相等则返回 1, 如果不相等则返回 0 ,下面是具体的示例,NULL 不能用于比较,会直接返回 NULL

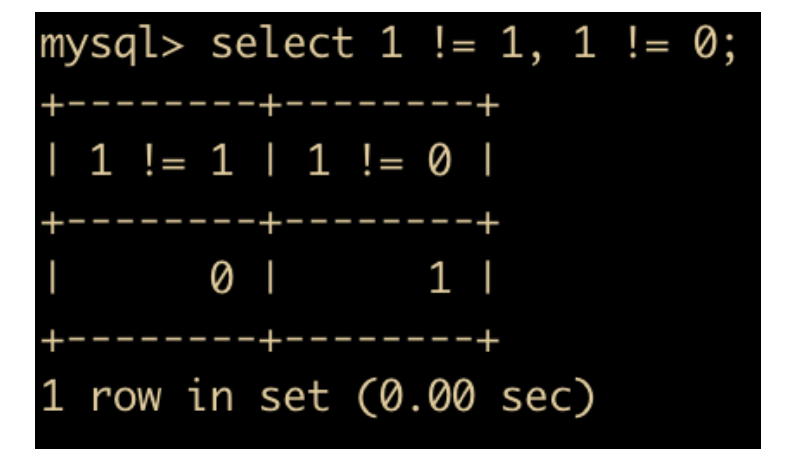

<>号用于表示不等于,和=号相反,示例如下

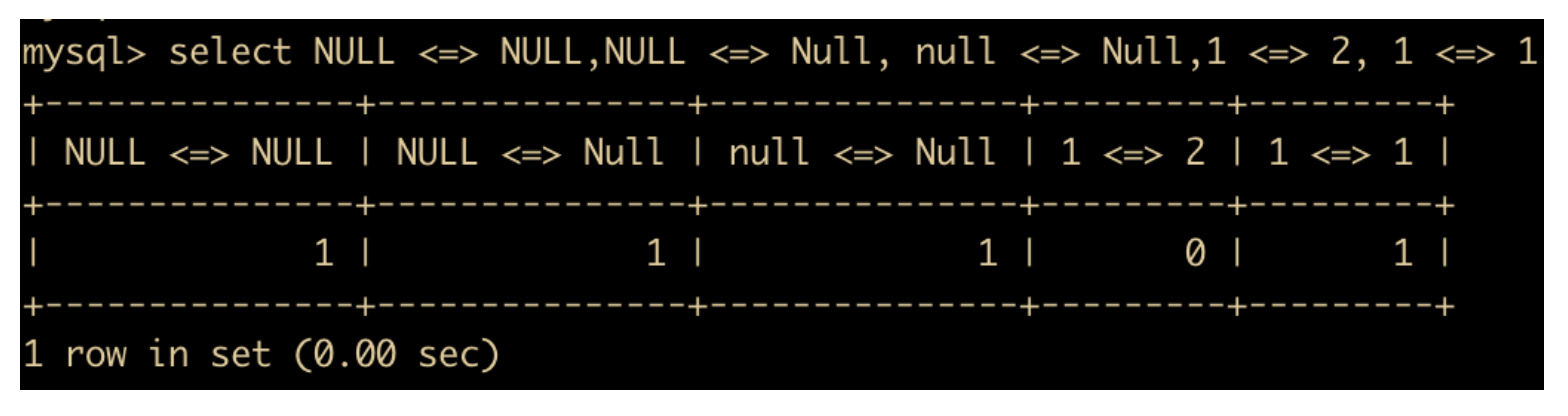

<=>NULL-safe 的等于运算符,与 = 号最大的区别在于可以比较 NULL 值

<号运算符,当左侧操作数小于右侧操作数时,返回值为 1, 否则其返回值为 0。

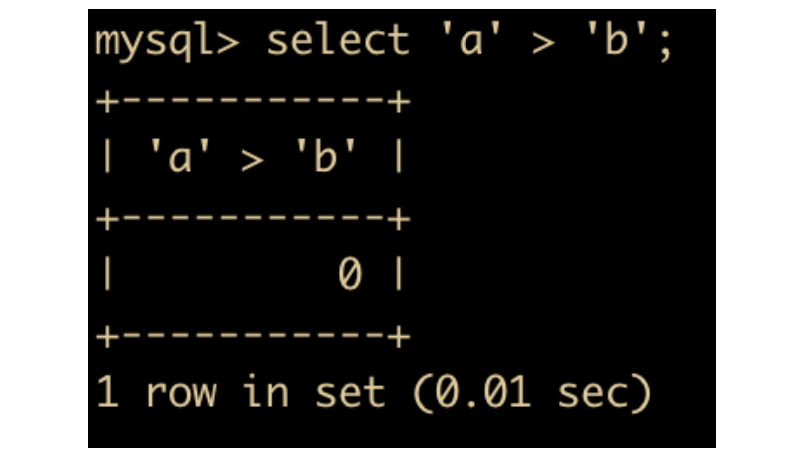

- 和上面同理,只不过是满足 <= 的时候返回 1 ,否则 > 返回 0。这里我有个疑问,为什么

select 'a' <= 'b'; /* 返回 1 */

/而/

select 'a' >= 'b'; /* 返回 0 呢*/

关于

>和>=是同理BETWEEN运算符的使用格式是 a BETWEEN min AND max ,当 a 大于等于 min 并且小于等于 max 时,返回 1,否则返回 0 。操作数类型不同的时候,会转换成相同的数据类型再进行处理。比如

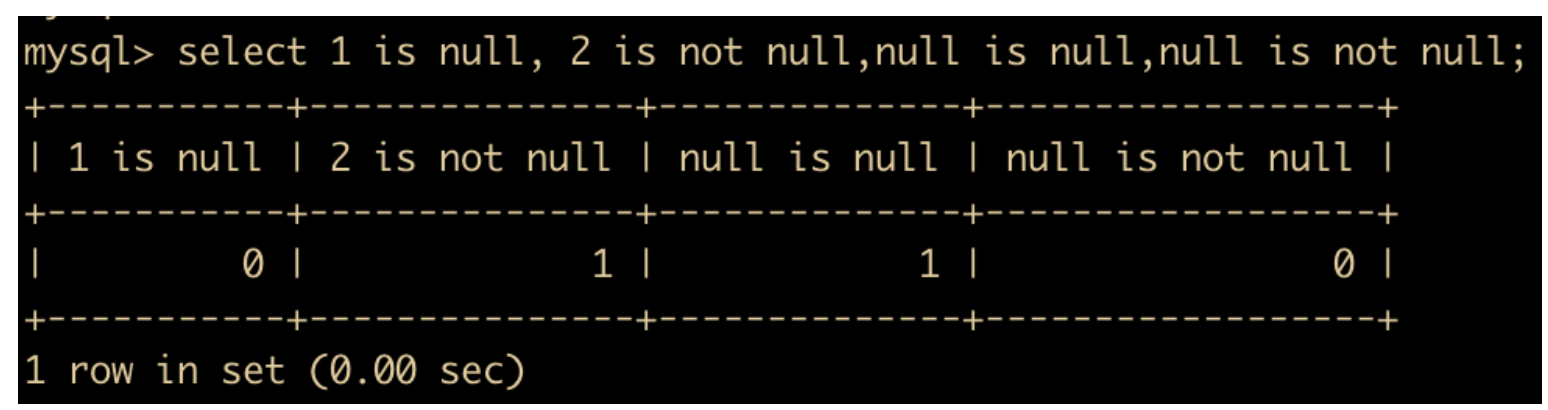

IS NULL和IS NOT NULL表示的是是否为 NULL,ISNULL 为 true 返回 1,否则返回 0 ;IS NOT NULL 同理

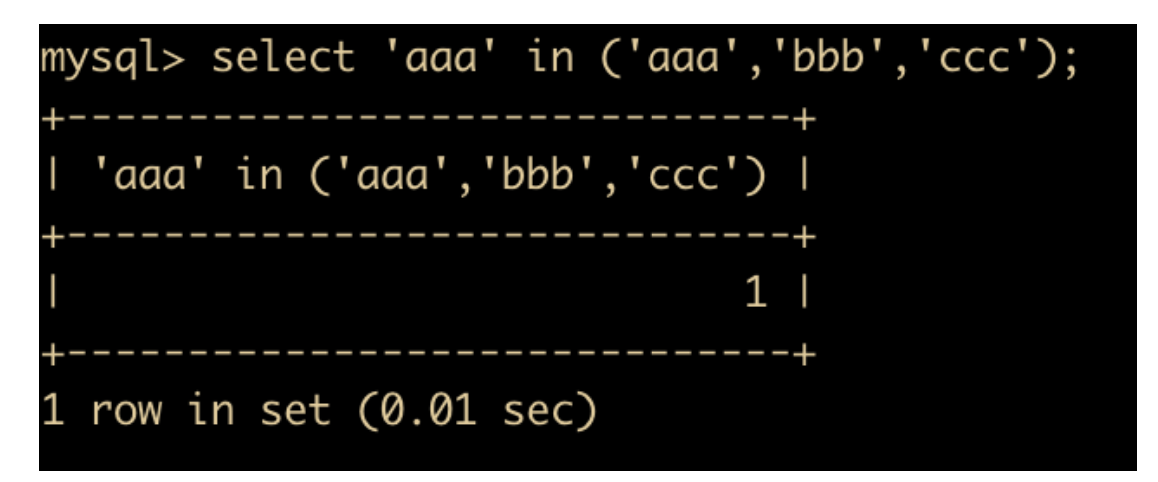

IN这个比较操作符判断某个值是否在一个集合中,使用方式是 xxx in (value1,value2,value3)

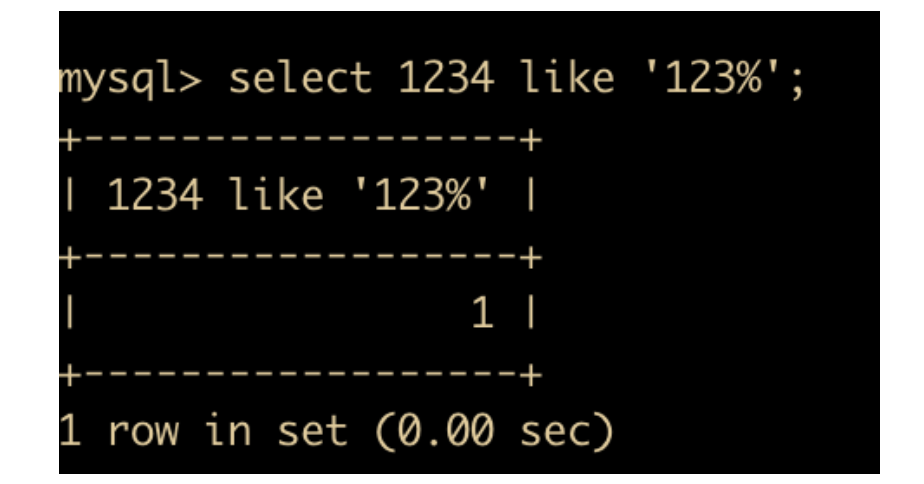

LIKE运算符的格式是xxx LIKE %123%,比如如下

当 like 后面跟的是 123% 的时候, xxx 如果是 123 则返回 1,如果是 123xxx 也返回 1,如果是 12 或者 1 就返回 0 。123 是一个整体。

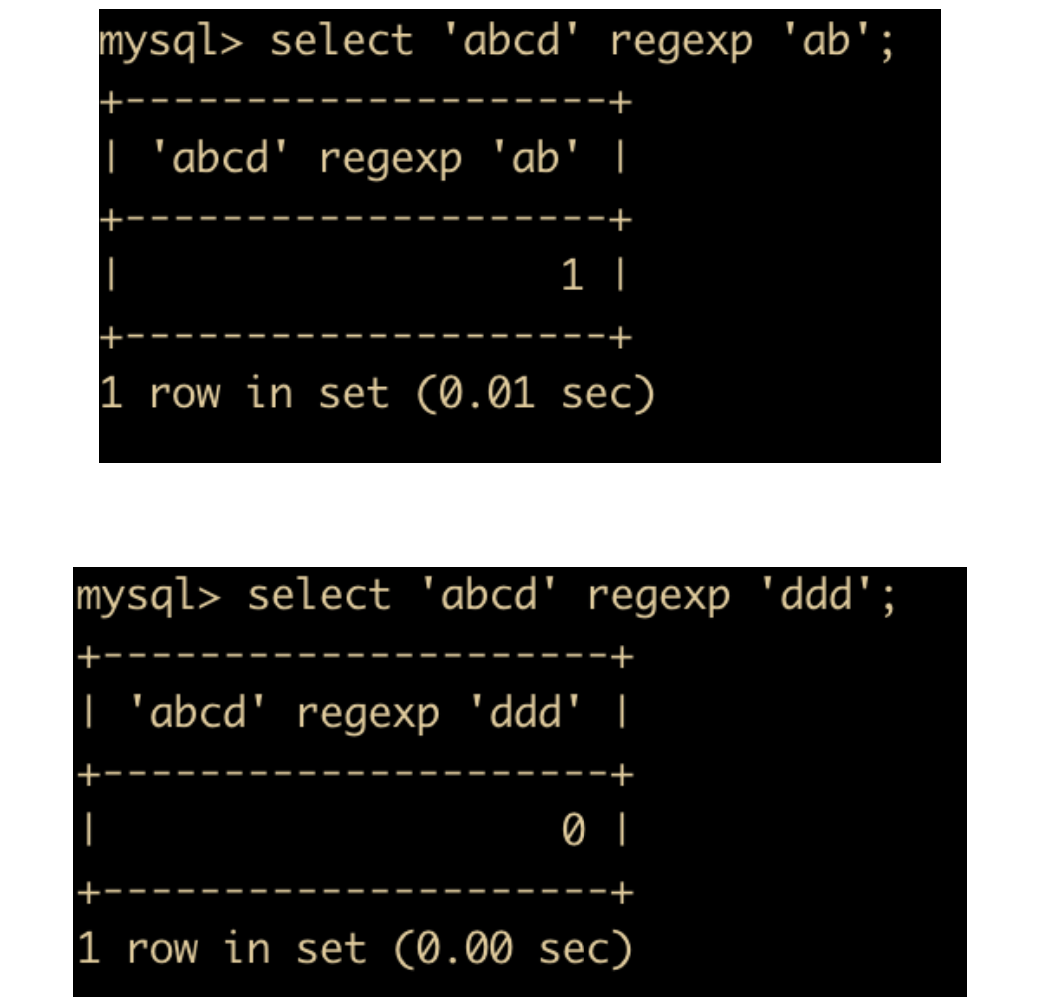

REGEX运算符的格式是s REGEXP str,匹配时返回值为 1,否则返回 0 。

后面会详细介绍 regexp 的用法。

逻辑运算符

逻辑运算符指的就是布尔运算符,布尔运算符指返回真和假。MySQL 支持四种逻辑运算符

| 运算符 | 作用 |

|---|---|

| NOT 或 ! | 逻辑非 |

| AND 或者是 && | 逻辑与 |

| OR 或者是 || | 逻辑或 |

| XOR | 逻辑异或 |

下面分别来介绍一下

NOT或者是!表示的是逻辑非,当操作数为 0(假) ,则返回值为 1,否则值为 0。但是有一点除外,那就是 NOT NULL 的返回值为 NULL

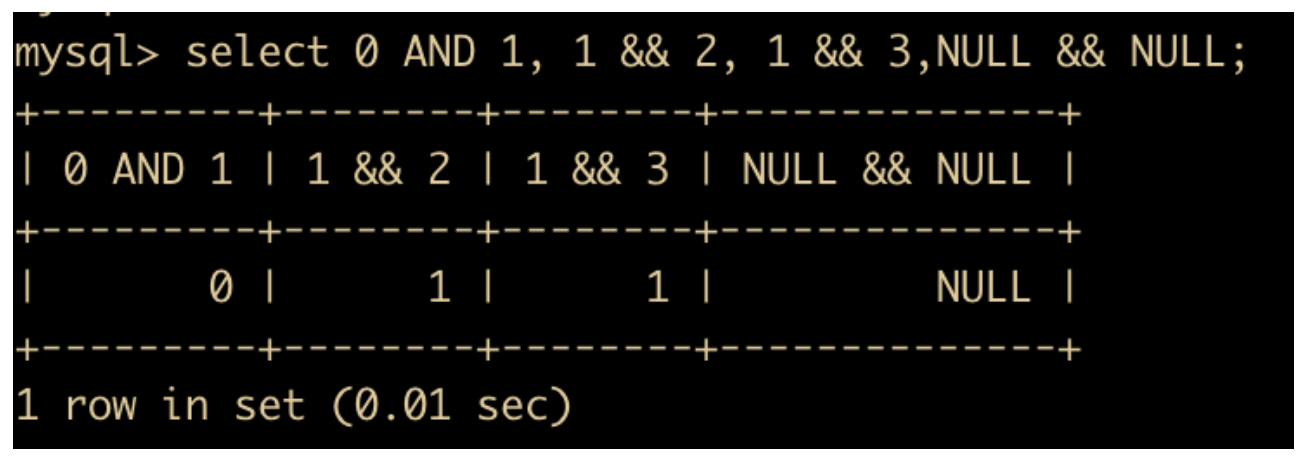

AND和&&表示的是逻辑与的逻辑,当所有操作数为非零值并且不为 NULL 时,结果为 1,但凡是有一个 0 则返回 0,操作数中有一个 null 则返回 null

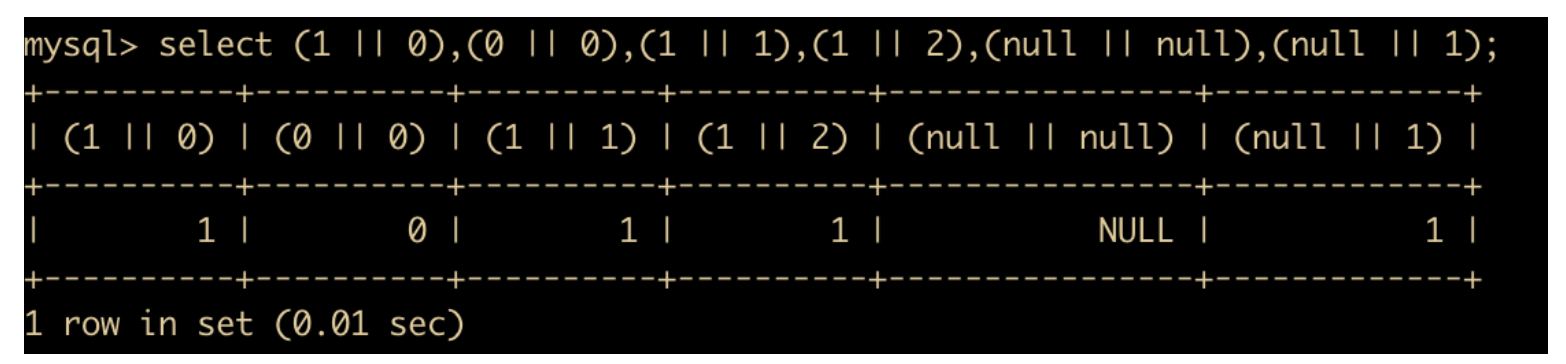

OR和||表示的是逻辑或,当两个操作数均为非 NULL 值时,如有任意一个操作数为非零值,则结果为 1,否则结果为 0。

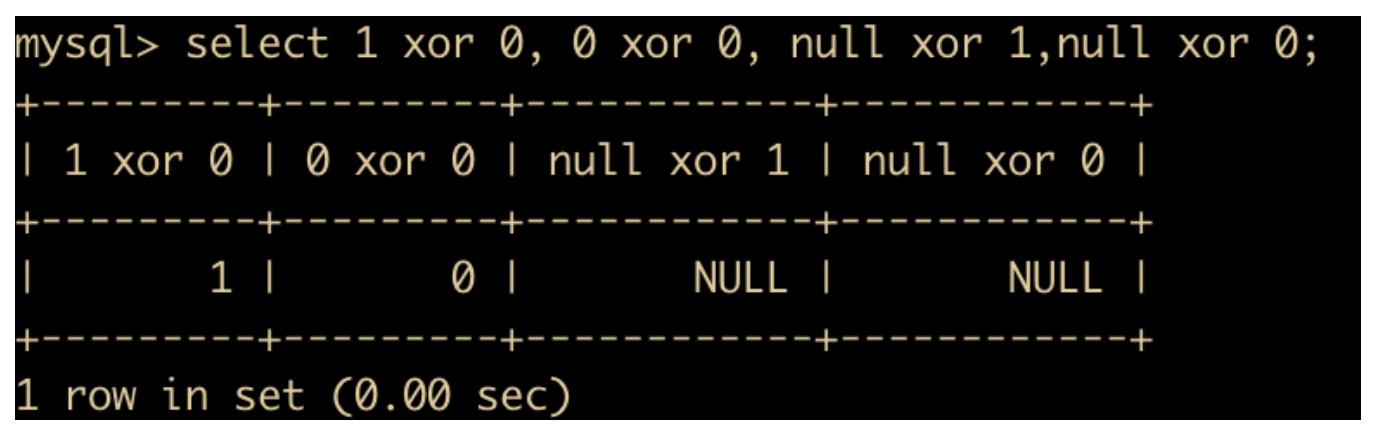

XOR表示逻辑异或,当任意一个操作数为 NULL 时,返回值为 NULL。对于非 NULL 的操作数,如果两个的逻辑真假值相异,则返回结果 1;否则返回 0。

位运算符

一听说位运算,就知道是和二进制有关的运算符了,位运算就是将给定的操作数转换为二进制后,对各个操作数的每一位都进行指定的逻辑运算,得到的二进制结果转换为十进制后就说是位运算的结果,下面是所有的位运算。

| 运算符 | 作用 |

|---|---|

| & | 位与 |

| | | 位或 |

| ^ | 位异或 |

| ~ | 位取反 |

| >> | 位右移 |

| << | 位左移 |

下面分别来演示一下这些例子

位与指的就是按位与,把 & 双方转换为二进制再进行 & 操作

按位与是一个数值减小的操作

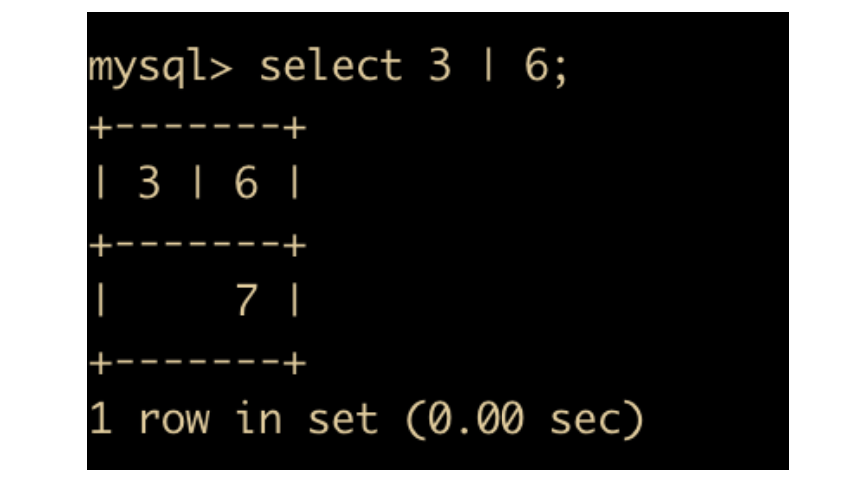

位或指的就是按位或,把 | 双方转换为二进制再进行 | 操作

位或是一个数值增大的操作

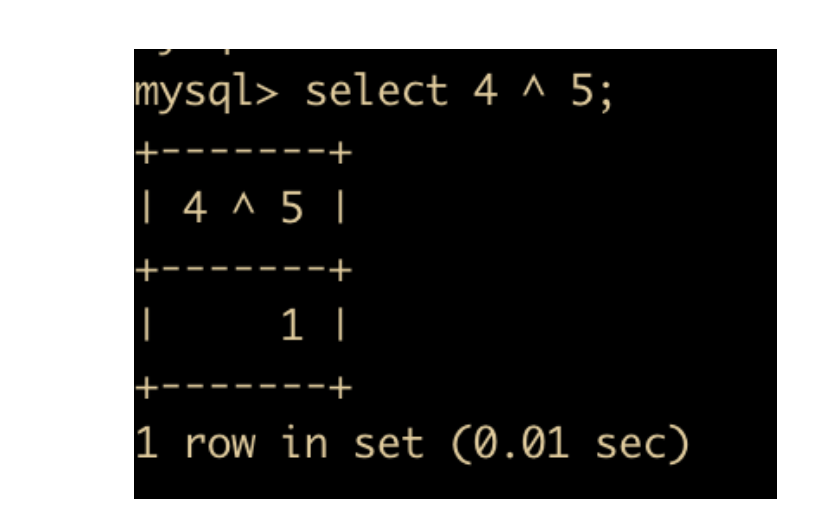

位异或指的就是对操作数的二进制位做异或操作

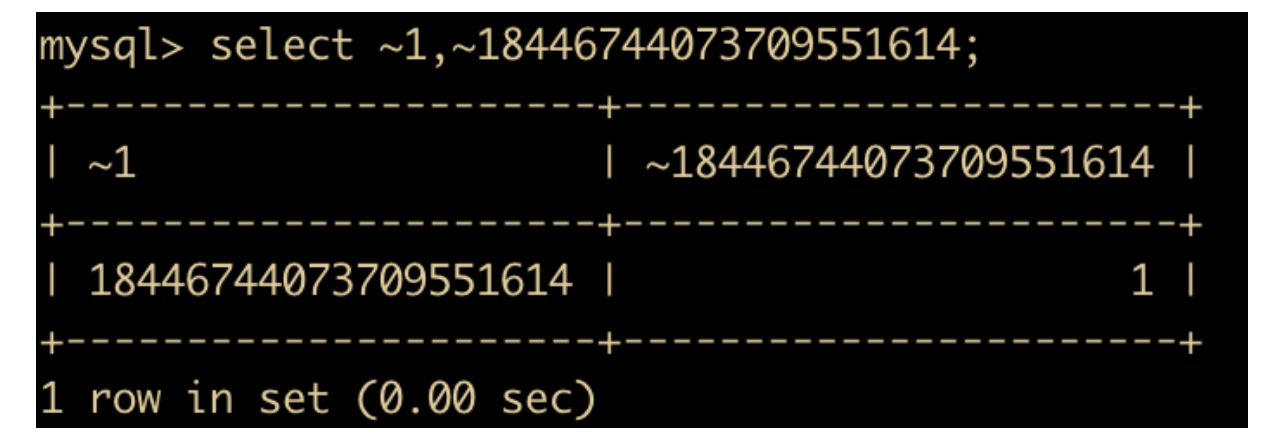

位取反指的就是对操作数的二进制位做NOT操作,这里的操作数只能是一位,下面看一个经典的取反例子:对 1 做位取反,具体如下所示:

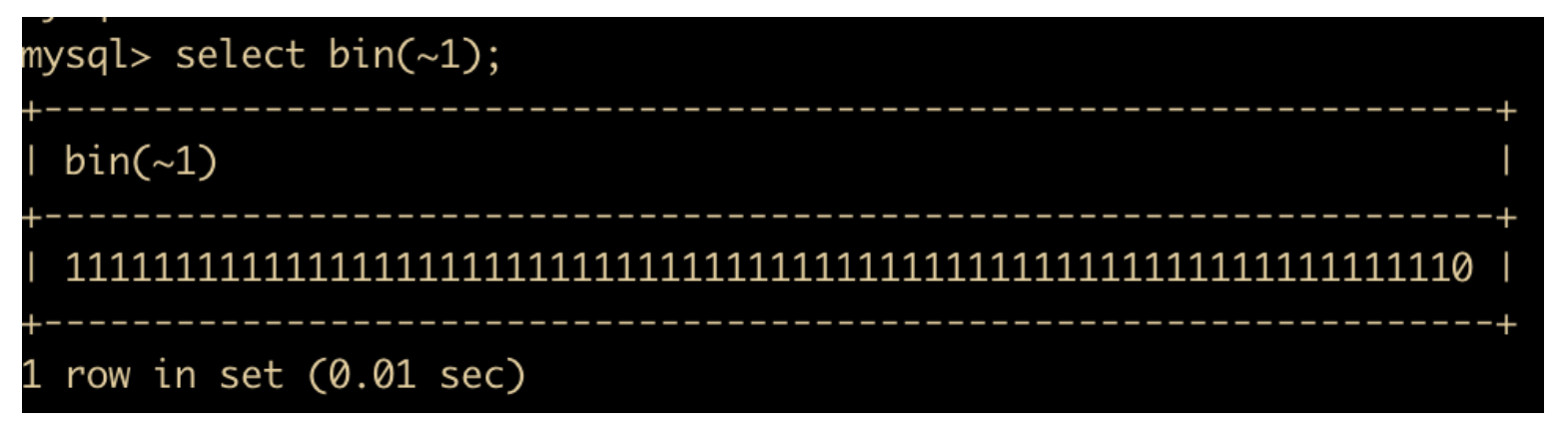

为什么会有这种现象,因为在 MySQL 中,常量数字默认会以 8 个字节来显示,8 个字节就是 64 位,常量 1 的二进制表示 63 个 0,加 1 个 1 , 位取反后就是 63 个 1 加一个 0 , 转换为二进制后就是 18446744073709551614,我们可以使用 select bin() 查看一下

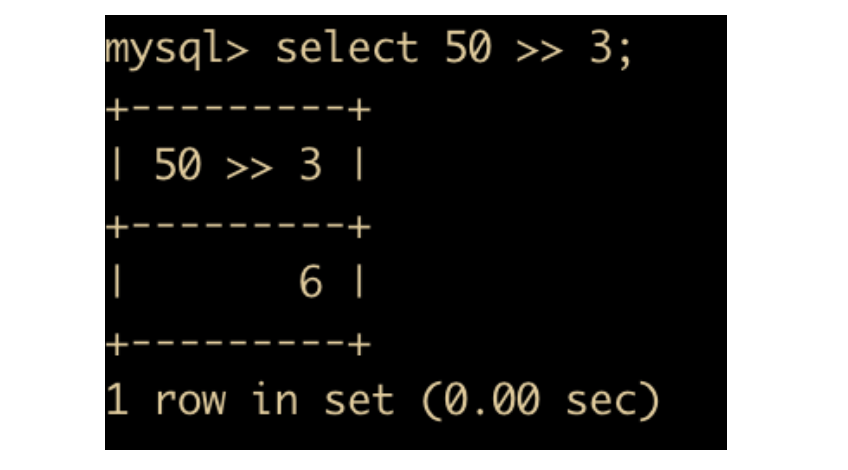

位右移是对左操作数向右移动指定位数,例如 50 >> 3,就是对 50 取其二进制然后向右移三位,左边补上 0 ,转换结果如下

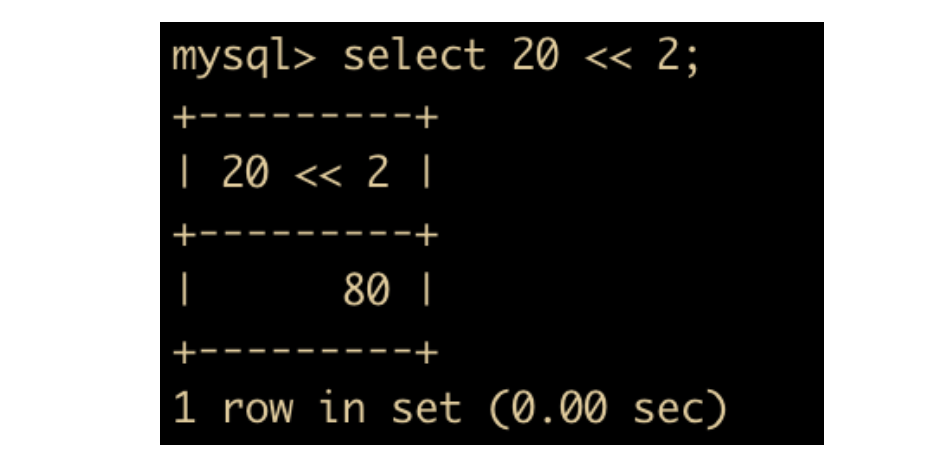

位左移与位右移相反,是对左操作数向左移动指定位数,例如 20 << 2

MySQL 常用函数

下面我们来了解一下 MySQL 函数,MySQL 函数也是我们日常开发过程中经常使用的,选用合适的函数能够提高我们的开发效率,下面我们就来一起认识一下这些函数

字符串函数

字符串函数是最常用的一种函数了,MySQL 也是支持很多种字符串函数,下面是 MySQL 支持的字符串函数表

| 函数 | 功能 |

|---|---|

| LOWER | 将字符串所有字符变为小写 |

| UPPER | 将字符串所有字符变为大写 |

| CONCAT | 进行字符串拼接 |

| LEFT | 返回字符串最左边的字符 |

| RIGHT | 返回字符串最右边的字符 |

| INSERT | 字符串替换 |

| LTRIM | 去掉字符串左边的空格 |

| RTRIM | 去掉字符串右边的空格 |

| REPEAT | 返回重复的结果 |

| TRIM | 去掉字符串行尾和行头的空格 |

| SUBSTRING | 返回指定的字符串 |

| LPAD | 用字符串对最左边进行填充 |

| RPAD | 用字符串对最右边进行填充 |

| STRCMP | 比较字符串 s1 和 s2 |

| REPLACE | 进行字符串替换 |

下面通过具体的示例演示一下每个函数的用法

- LOWER(str) 和 UPPER(str) 函数:用于转换大小写

- CONCAT(s1,s2 … sn) :把传入的参数拼接成一个字符串

上面把 c xu an 拼接成为了一个字符串,另外需要注意一点,任何和 NULL 进行字符串拼接的结果都是 NULL。

- LEFT(str,x) 和 RIGHT(str,x) 函数:分别返回字符串最左边的 x 个字符和最右边的 x 个字符。如果第二个参数是 NULL,那么将不会返回任何字符串

- INSERT(str,x,y,instr) : 将字符串 str 从指定 x 的位置开始, 取 y 个长度的字串替换为 instr。

- LTRIM(str) 和 RTRIM(str) 分别表示去掉字符串 str 左侧和右侧的空格

- REPEAT(str,x) 函数:返回 str 重复 x 次的结果

- TRIM(str) 函数:用于去掉目标字符串的空格

- SUBSTRING(str,x,y) 函数:返回从字符串 str 中第 x 位置起 y 个字符长度的字符串

- LPAD(str,n,pad) 和 RPAD(str,n,pad) 函数:用字符串 pad 对 str 左边和右边进行填充,直到长度为 n 个字符长度

- STRCMP(s1,s2) 用于比较字符串 s1 和 s2 的 ASCII 值大小。如果 s1 < s2,则返回 -1;如果 s1 = s2 ,返回 0 ;如果 s1 > s2 ,返回 1。

- REPLACE(str,a,b) : 用字符串 b 替换字符串 str 种所有出现的字符串 a

数值函数

MySQL 支持数值函数,这些函数能够处理很多数值运算。下面我们一起来学习一下 MySQL 中的数值函数,下面是所有的数值函数

| 函数 | 功能 |

|---|---|

| ABS | 返回绝对值 |

| CEIL | 返回大于某个值的最大整数值 |

| MOD | 返回模 |

| ROUND | 四舍五入 |

| FLOOR | 返回小于某个值的最大整数值 |

| TRUNCATE | 返回数字截断小数的结果 |

| RAND | 返回 0 – 1 的随机值 |

下面我们还是以实践为主来聊一聊这些用法

- ABS(x) 函数:返回 x 的绝对值

- CEIL(x) 函数: 返回大于 x 的整数

- MOD(x,y),对 x 和 y 进行取模操作

- ROUND(x,y) 返回 x 四舍五入后保留 y 位小数的值;如果是整数,那么 y 位就是 0 ;如果不指定 y ,那么 y 默认也是 0 。

- FLOOR(x) : 返回小于 x 的最大整数,用法与 CEIL 相反

- TRUNCATE(x,y): 返回数字 x 截断为 y 位小数的结果, TRUNCATE 知识截断,并不是四舍五入。

- RAND() :返回 0 到 1 的随机值

日期和时间函数

日期和时间函数也是 MySQL 中非常重要的一部分,下面我们就来一起认识一下这些函数

| 函数 | 功能 |

|---|---|

| NOW | 返回当前的日期和时间 |

| WEEK | 返回一年中的第几周 |

| YEAR | 返回日期的年份 |

| HOUR | 返回小时值 |

| MINUTE | 返回分钟值 |

| MONTHNAME | 返回月份名 |

| CURDATE | 返回当前日期 |

| CURTIME | 返回当前时间 |

| UNIX_TIMESTAMP | 返回日期 UNIX 时间戳 |

| DATE_FORMAT | 返回按照字符串格式化的日期 |

| FROM_UNIXTIME | 返回 UNIX 时间戳的日期值 |

| DATE_ADD | 返回日期时间 + 上一个时间间隔 |

| DATEDIFF | 返回起始时间和结束时间之间的天数 |

下面结合示例来讲解一下每个函数的使用

- NOW(): 返回当前的日期和时间

- WEEK(DATE) 和 YEAR(DATE) :前者返回的是一年中的第几周,后者返回的是给定日期的哪一年

- HOUR(time) 和 MINUTE(time) : 返回给定时间的小时,后者返回给定时间的分钟

- MONTHNAME(date) 函数:返回 date 的英文月份

- CURDATE() 函数:返回当前日期,只包含年月日

- CURTIME() 函数:返回当前时间,只包含时分秒

- UNIX_TIMESTAMP(date) : 返回 UNIX 的时间戳

- FROM_UNIXTIME(date) : 返回 UNIXTIME 时间戳的日期值,和 UNIX_TIMESTAMP 相反

- DATE_FORMAT(date,fmt) 函数:按照字符串 fmt 对 date 进行格式化,格式化后按照指定日期格式显示

具体的日期格式可以参考这篇文章 https://blog.csdn.net/weixin_38703170/article/details/82177837

我们演示一下将当前日期显示为年月日的这种形式,使用的日期格式是 %M %D %Y。

- DATE_ADD(date, interval, expr type) 函数:返回与所给日期 date 相差 interval 时间段的日期

interval 表示间隔类型的关键字,expr 是表达式,这个表达式对应后面的类型,type 是间隔类型,MySQL 提供了 13 种时间间隔类型

| 表达式类型 | 描述 | 格式 |

|---|---|---|

| YEAR | 年 | YY |

| MONTH | 月 | MM |

| DAY | 日 | DD |

| HOUR | 小时 | hh |

| MINUTE | 分 | mm |

| SECOND | 秒 | ss |

| YEAR_MONTH | 年和月 | YY-MM |

| DAY_HOUR | 日和小时 | DD hh |

| DAY_MINUTE | 日和分钟 | DD hh : mm |

| DAY_SECOND | 日和秒 | DD hh :mm :ss |

| HOUR_MINUTE | 小时和分 | hh:mm |

| HOUR_SECOND | 小时和秒 | hh:ss |

| MINUTE_SECOND | 分钟和秒 | mm:ss |

- DATE_DIFF(date1, date2) 用来计算两个日期之间相差的天数

查看离 2021 – 01 – 01 还有多少天

流程函数

流程函数也是很常用的一类函数,用户可以使用这类函数在 SQL 中实现条件选择。这样做能够提高查询效率。下表列出了这些流程函数

| 函数 | 功能 |

|---|---|

| IF(value,t f) | 如果 value 是真,返回 t;否则返回 f |

| IFNULL(value1,value2) | 如果 value1 不为 NULL,返回 value1,否则返回 value2。 |

| CASE WHEN[value1] THEN[result1] …ELSE[default] END | 如果 value1 是真,返回 result1,否则返回 default |

| CASE[expr] WHEN[value1] THEN [result1]… ELSE[default] END | 如果 expr 等于 value1, 返回 result1, 否则返回 default |

其他函数

除了我们介绍过的字符串函数、日期和时间函数、流程函数,还有一些函数并不属于上面三类函数,它们是

| 函数 | 功能 |

|---|---|

| VERSION | 返回当前数据库的版本 |

| DATABASE | 返回当前数据库名 |

| USER | 返回当前登陆用户名 |

| PASSWORD | 返回字符串的加密版本 |

| MD5 | 返回 MD5 值 |

| INET_ATON(IP) | 返回 IP 地址的数字表示 |

| INET_NTOA(num) | 返回数字代表的 IP 地址 |

下面来看一下具体的使用

- VERSION: 返回当前数据库版本

- DATABASE: 返回当前的数据库名

- USER : 返回当前登录用户名

- PASSWORD(str) : 返回字符串的加密版本,例如

- MD5(str) 函数:返回字符串 str 的 MD5 值

- INET_ATON(IP): 返回 IP 的网络字节序列

- INET_NTOA(num)函数:返回网络字节序列代表的 IP 地址,与 INET_ATON 相对

# MyBatis二级缓存全详解-Java面试题

MyBatis 二级缓存介绍

上一篇文章中我们介绍到了 MyBatis 一级缓存其实就是 SqlSession 级别的缓存,什么是 SqlSession 级别的缓存呢?一级缓存的本质是什么呢? 以及一级缓存失效的原因?我希望你在看下文之前能够回想起来这些内容。

MyBatis 一级缓存最大的共享范围就是一个SqlSession内部,那么如果多个 SqlSession 需要共享缓存,则需要开启二级缓存,开启二级缓存后,会使用 CachingExecutor 装饰 Executor,进入一级缓存的查询流程前,先在CachingExecutor 进行二级缓存的查询,具体的工作流程如下所示

当二级缓存开启后,同一个命名空间(namespace) 所有的操作语句,都影响着一个共同的 cache,也就是二级缓存被多个 SqlSession 共享,是一个全局的变量。当开启缓存后,数据的查询执行的流程就是 二级缓存 -> 一级缓存 -> 数据库。

二级缓存开启条件

二级缓存默认是不开启的,需要手动开启二级缓存,实现二级缓存的时候,MyBatis要求返回的POJO必须是可序列化的。开启二级缓存的条件也是比较简单,通过直接在 MyBatis 配置文件中通过

<settings> <setting name = "cacheEnabled" value = "true" /> </settings>

来开启二级缓存,还需要在 Mapper 的xml 配置文件中加入 <cache> 标签

设置 cache 标签的属性

cache 标签有多个属性,一起来看一些这些属性分别代表什么意义

eviction: 缓存回收策略,有这几种回收策略- LRU – 最近最少回收,移除最长时间不被使用的对象

- FIFO – 先进先出,按照缓存进入的顺序来移除它们

- SOFT – 软引用,移除基于垃圾回收器状态和软引用规则的对象

- WEAK – 弱引用,更积极的移除基于垃圾收集器和弱引用规则的对象

默认是 LRU 最近最少回收策略

flushinterval缓存刷新间隔,缓存多长时间刷新一次,默认不清空,设置一个毫秒值readOnly: 是否只读;true 只读,MyBatis 认为所有从缓存中获取数据的操作都是只读操作,不会修改数据。MyBatis 为了加快获取数据,直接就会将数据在缓存中的引用交给用户。不安全,速度快。读写(默认):MyBatis 觉得数据可能会被修改size: 缓存存放多少个元素type: 指定自定义缓存的全类名(实现Cache 接口即可)blocking: 若缓存中找不到对应的key,是否会一直blocking,直到有对应的数据进入缓存。

探究二级缓存

我们继续以 MyBatis 一级缓存文章中的例子为基础,搭建一个满足二级缓存的例子,来对二级缓存进行探究,例子如下(对 一级缓存的例子部分源码进行修改):

Dept.java

//存放在共享缓存中数据进行序列化操作和反序列化操作 //因此数据对应实体类必须实现【序列化接口】 public class Dept implements Serializable {

private Integer deptNo;

private String dname;

private String loc;

public Dept() {}

public Dept(Integer deptNo, String dname, String loc) {

this.deptNo = deptNo;

this.dname = dname;

this.loc = loc;

}

get and set... @Override public String toString() { return "Dept{" + "deptNo=" + deptNo + ", dname='" + dname + ''' + ", loc='" + loc + ''' + '}'; } }

myBatis-config.xml

在myBatis-config 中添加开启二级缓存的条件

<!-- 通知 MyBatis 框架开启二级缓存 --> <settings> <setting name="cacheEnabled" value="true"/> </settings>

DeptDao.xml

还需要在 Mapper 对应的xml中添加 cache 标签,表示对哪个mapper 开启缓存

<!-- 表示DEPT表查询结果保存到二级缓存(共享缓存) --> <cache/>

对应的二级缓存测试类如下:

public class MyBatisSecondCacheTest {

private SqlSession sqlSession;

SqlSessionFactory factory;

@Before

public void start() throws IOException {

InputStream is = Resources.getResourceAsStream("myBatis-config.xml");

SqlSessionFactoryBuilder builderObj = new SqlSessionFactoryBuilder();

factory = builderObj.build(is);

sqlSession = factory.openSession();

}

@After

public void destory(){

if(sqlSession!=null){

sqlSession.close();

}

}

@Test

public void testSecondCache(){

//会话过程中第一次发送请求,从数据库中得到结果

//得到结果之后,mybatis自动将这个查询结果放入到当前用户的一级缓存

DeptDao dao = sqlSession.getMapper(DeptDao.class);

Dept dept = dao.findByDeptNo(1);

System.out.println("第一次查询得到部门对象 = "+dept);

//触发MyBatis框架从当前一级缓存中将Dept对象保存到二级缓存

sqlSession.commit();

// 改成 sqlSession.close(); 效果相同

SqlSession session2 = factory.openSession();

DeptDao dao2 = session2.getMapper(DeptDao.class);

Dept dept2 = dao2.findByDeptNo(1);

System.out.println("第二次查询得到部门对象 = "+dept2);

}

}

测试二级缓存效果,提交事务,

sqlSession查询完数据后,sqlSession2相同的查询是否会从缓存中获取数据。

测试结果如下:

通过结果可以得知,首次执行的SQL语句是从数据库中查询得到的结果,然后第一个 SqlSession 执行提交,第二个 SqlSession 执行相同的查询后是从缓存中查取的。

用一下这幅图能够比较直观的反映两次 SqlSession 的缓存命中

二级缓存失效的条件

与一级缓存一样,二级缓存也会存在失效的条件的,下面我们就来探究一下哪些情况会造成二级缓存失效

第一次SqlSession 未提交

SqlSession 在未提交的时候,SQL 语句产生的查询结果还没有放入二级缓存中,这个时候 SqlSession2 在查询的时候是感受不到二级缓存的存在的,修改对应的测试类,结果如下:

@Test public void testSqlSessionUnCommit(){ //会话过程中第一次发送请求,从数据库中得到结果 //得到结果之后,mybatis自动将这个查询结果放入到当前用户的一级缓存 DeptDao dao = sqlSession.getMapper(DeptDao.class); Dept dept = dao.findByDeptNo(1); System.out.println("第一次查询得到部门对象 = "+dept); //触发MyBatis框架从当前一级缓存中将Dept对象保存到二级缓存

SqlSession session2 = factory.openSession(); DeptDao dao2 = session2.getMapper(DeptDao.class); Dept dept2 = dao2.findByDeptNo(1); System.out.println("第二次查询得到部门对象 = "+dept2); }

产生的输出结果:

更新对二级缓存影响

与一级缓存一样,更新操作很可能对二级缓存造成影响,下面用三个 SqlSession来进行模拟,第一个 SqlSession 只是单纯的提交,第二个 SqlSession 用于检验二级缓存所产生的影响,第三个 SqlSession 用于执行更新操作,测试如下:

@Test public void testSqlSessionUpdate(){ SqlSession sqlSession = factory.openSession(); SqlSession sqlSession2 = factory.openSession(); SqlSession sqlSession3 = factory.openSession();

// 第一个 SqlSession 执行更新操作 DeptDao deptDao = sqlSession.getMapper(DeptDao.class); Dept dept = deptDao.findByDeptNo(1); System.out.println("dept = " + dept); sqlSession.commit();

// 判断第二个 SqlSession 是否从缓存中读取 DeptDao deptDao2 = sqlSession2.getMapper(DeptDao.class); Dept dept2 = deptDao2.findByDeptNo(1); System.out.println("dept2 = " + dept2);

// 第三个 SqlSession 执行更新操作 DeptDao deptDao3 = sqlSession3.getMapper(DeptDao.class); deptDao3.updateDept(new Dept(1,"ali","hz")); sqlSession3.commit();

// 判断第二个 SqlSession 是否从缓存中读取 dept2 = deptDao2.findByDeptNo(1); System.out.println("dept2 = " + dept2); }

对应的输出结果如下

探究多表操作对二级缓存的影响

现有这样一个场景,有两个表,部门表dept(deptNo,dname,loc)和 部门数量表deptNum(id,name,num),其中部门表的名称和部门数量表的名称相同,通过名称能够联查两个表可以知道其坐标(loc)和数量(num),现在我要对部门数量表的 num 进行更新,然后我再次关联dept 和 deptNum 进行查询,你认为这个 SQL 语句能够查询到的 num 的数量是多少?来看一下代码探究一下

DeptNum.java

public class DeptNum {

private int id;

private String name;

private int num;

get and set...

}

DeptVo.java

public class DeptVo {

private Integer deptNo;

private String dname;

private String loc;

private Integer num;

public DeptVo(Integer deptNo, String dname, String loc, Integer num) {

this.deptNo = deptNo;

this.dname = dname;

this.loc = loc;

this.num = num;

}

public DeptVo(String dname, Integer num) {

this.dname = dname;

this.num = num;

}

get and set

@Override

public String toString() {

return "DeptVo{" +

"deptNo=" + deptNo +

", dname='" + dname + '\'' +

", loc='" + loc + '\'' +

", num=" + num +

'}';

}

}

DeptDao.java

public interface DeptDao {

...

DeptVo selectByDeptVo(String name);

DeptVo selectByDeptVoName(String name);

int updateDeptVoNum(DeptVo deptVo);

}

DeptDao.xml

<select id="selectByDeptVo" resultType="com.mybatis.beans.DeptVo"> select d.deptno,d.dname,d.loc,dn.num from dept d,deptNum dn where dn.name = d.dname and d.dname = #{name} </select>

<select id="selectByDeptVoName" resultType="com.mybatis.beans.DeptVo"> select * from deptNum where name = #{name} </select>

<update id="updateDeptVoNum" parameterType="com.mybatis.beans.DeptVo"> update deptNum set num = #{num} where name = #{dname} </update>

DeptNum 数据库初始值:

测试类对应如下:

/** * 探究多表操作对二级缓存的影响 */ @Test public void testOtherMapper(){

// 第一个mapper 先执行联查操作 SqlSession sqlSession = factory.openSession(); DeptDao deptDao = sqlSession.getMapper(DeptDao.class); DeptVo deptVo = deptDao.selectByDeptVo("ali"); System.out.println("deptVo = " + deptVo); // 第二个mapper 执行更新操作 并提交 SqlSession sqlSession2 = factory.openSession(); DeptDao deptDao2 = sqlSession2.getMapper(DeptDao.class); deptDao2.updateDeptVoNum(new DeptVo("ali",1000)); sqlSession2.commit(); sqlSession2.close(); // 第一个mapper 再次进行查询,观察查询结果 deptVo = deptDao.selectByDeptVo("ali"); System.out.println("deptVo = " + deptVo); }

测试结果如下:

在对DeptNum 表执行了一次更新后,再次进行联查,发现数据库中查询出的还是 num 为 1050 的值,也就是说,实际上 1050 -> 1000 ,最后一次联查实际上查询的是第一次查询结果的缓存,而不是从数据库中查询得到的值,这样就读到了脏数据。

解决办法

如果是两个mapper命名空间的话,可以使用 <cache-ref>来把一个命名空间指向另外一个命名空间,从而消除上述的影响,再次执行,就可以查询到正确的数据

二级缓存源码解析

源码模块主要分为两个部分:二级缓存的创建和二级缓存的使用,首先先对二级缓存的创建进行分析:

二级缓存的创建

二级缓存的创建是使用 Resource 读取 XML 配置文件开始的

InputStream is = Resources.getResourceAsStream("myBatis-config.xml"); SqlSessionFactoryBuilder builder = new SqlSessionFactoryBuilder(); factory = builder.build(is);

读取配置文件后,需要对XML创建 Configuration并初始化

XMLConfigBuilder parser = new XMLConfigBuilder(inputStream, environment, properties); return build(parser.parse());

调用 parser.parse() 解析根目录 /configuration 下面的标签,依次进行解析

public Configuration parse() { if (parsed) { throw new BuilderException("Each XMLConfigBuilder can only be used once."); } parsed = true; parseConfiguration(parser.evalNode("/configuration")); return configuration; }

private void parseConfiguration(XNode root) { try { //issue #117 read properties first propertiesElement(root.evalNode("properties")); Properties settings = settingsAsProperties(root.evalNode("settings")); loadCustomVfs(settings); typeAliasesElement(root.evalNode("typeAliases")); pluginElement(root.evalNode("plugins")); objectFactoryElement(root.evalNode("objectFactory")); objectWrapperFactoryElement(root.evalNode("objectWrapperFactory")); reflectorFactoryElement(root.evalNode("reflectorFactory")); settingsElement(settings); // read it after objectFactory and objectWrapperFactory issue #631 environmentsElement(root.evalNode("environments")); databaseIdProviderElement(root.evalNode("databaseIdProvider")); typeHandlerElement(root.evalNode("typeHandlers")); mapperElement(root.evalNode("mappers")); } catch (Exception e) { throw new BuilderException("Error parsing SQL Mapper Configuration. Cause: " + e, e); } }

其中有一个二级缓存的解析就是

mapperElement(root.evalNode("mappers"));

然后进去 mapperElement 方法中

XMLMapperBuilder mapperParser = new XMLMapperBuilder(inputStream, configuration, resource, configuration.getSqlFragments()); mapperParser.parse();

继续跟 mapperParser.parse() 方法

public void parse() { if (!configuration.isResourceLoaded(resource)) { configurationElement(parser.evalNode("/mapper")); configuration.addLoadedResource(resource); bindMapperForNamespace(); }

parsePendingResultMaps(); parsePendingCacheRefs(); parsePendingStatements(); }

这其中有一个 configurationElement 方法,它是对二级缓存进行创建,如下

private void configurationElement(XNode context) { try { String namespace = context.getStringAttribute("namespace"); if (namespace == null || namespace.equals("")) { throw new BuilderException("Mapper's namespace cannot be empty"); } builderAssistant.setCurrentNamespace(namespace); cacheRefElement(context.evalNode("cache-ref")); cacheElement(context.evalNode("cache")); parameterMapElement(context.evalNodes("/mapper/parameterMap")); resultMapElements(context.evalNodes("/mapper/resultMap")); sqlElement(context.evalNodes("/mapper/sql")); buildStatementFromContext(context.evalNodes("select|insert|update|delete")); } catch (Exception e) { throw new BuilderException("Error parsing Mapper XML. Cause: " + e, e); } }

有两个二级缓存的关键点

cacheRefElement(context.evalNode("cache-ref")); cacheElement(context.evalNode("cache"));

也就是说,mybatis 首先进行解析的是 cache-ref 标签,其次进行解析的是 cache 标签。

根据上面我们的 — 多表操作对二级缓存的影响 一节中提到的解决办法,采用 cache-ref 来进行命名空间的依赖能够避免二级缓存,但是总不能每次写一个 XML 配置都会采用这种方式吧,最有效的方式还是避免多表操作使用二级缓存

然后我们再来看一下cacheElement(context.evalNode("cache")) 这个方法

private void cacheElement(XNode context) throws Exception { if (context != null) { String type = context.getStringAttribute("type", "PERPETUAL"); Class<? extends Cache> typeClass = typeAliasRegistry.resolveAlias(type); String eviction = context.getStringAttribute("eviction", "LRU"); Class<? extends Cache> evictionClass = typeAliasRegistry.resolveAlias(eviction); Long flushInterval = context.getLongAttribute("flushInterval"); Integer size = context.getIntAttribute("size"); boolean readWrite = !context.getBooleanAttribute("readOnly", false); boolean blocking = context.getBooleanAttribute("blocking", false); Properties props = context.getChildrenAsProperties(); builderAssistant.useNewCache(typeClass, evictionClass, flushInterval, size, readWrite, blocking, props); } }

认真看一下其中的属性的解析,是不是感觉很熟悉?这不就是对 cache 标签属性的解析吗?!!!

上述最后一句代码

builderAssistant.useNewCache(typeClass, evictionClass, flushInterval, size, readWrite, blocking, props);

public Cache useNewCache(Class<? extends Cache> typeClass, Class<? extends Cache> evictionClass, Long flushInterval, Integer size, boolean readWrite, boolean blocking, Properties props) { Cache cache = new CacheBuilder(currentNamespace) .implementation(valueOrDefault(typeClass, PerpetualCache.class)) .addDecorator(valueOrDefault(evictionClass, LruCache.class)) .clearInterval(flushInterval) .size(size) .readWrite(readWrite) .blocking(blocking) .properties(props) .build(); configuration.addCache(cache); currentCache = cache; return cache; }

这段代码使用了构建器模式,一步一步构建Cache 标签的所有属性,最终把 cache 返回。

二级缓存的使用

在 mybatis 中,使用 Cache 的地方在 CachingExecutor中,来看一下 CachingExecutor 中缓存做了什么工作,我们以查询为例

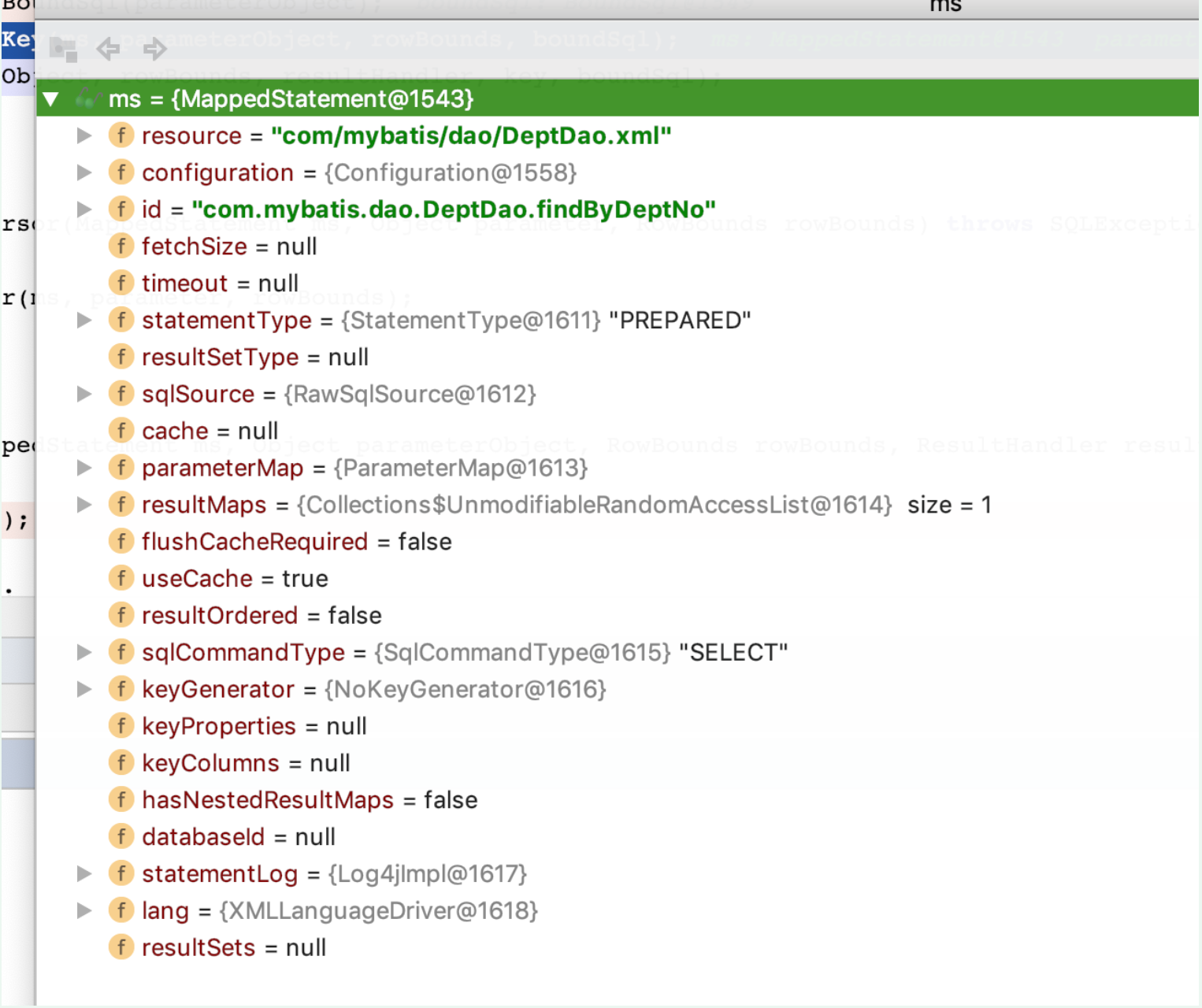

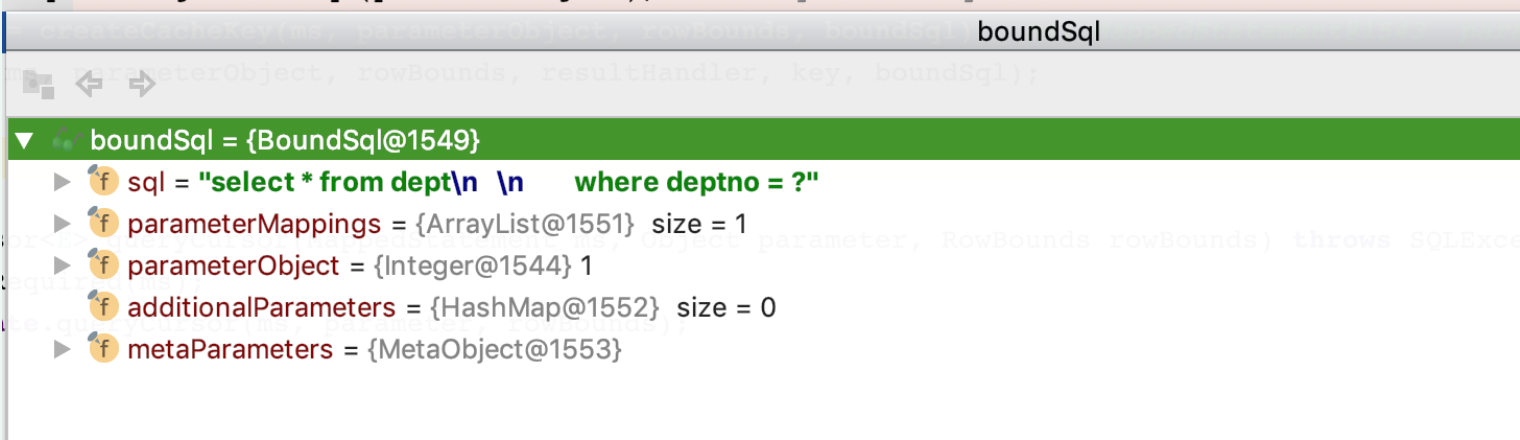

@Override public <E> List<E> query(MappedStatement ms, Object parameterObject, RowBounds rowBounds, ResultHandler resultHandler, CacheKey key, BoundSql boundSql) throws SQLException { // 得到缓存 Cache cache = ms.getCache(); if (cache != null) { // 如果需要的话刷新缓存 flushCacheIfRequired(ms); if (ms.isUseCache() && resultHandler == null) { ensureNoOutParams(ms, parameterObject, boundSql); @SuppressWarnings("unchecked") List<E> list = (List<E>) tcm.getObject(cache, key); if (list == null) { list = delegate.<E> query(ms, parameterObject, rowBounds, resultHandler, key, boundSql); tcm.putObject(cache, key, list); // issue #578 and #116 } return list; } } // 委托模式,交给SimpleExecutor等实现类去实现方法。 return delegate.<E> query(ms, parameterObject, rowBounds, resultHandler, key, boundSql); }

其中,先从 MapperStatement 取出缓存。只有通过<cache/>,<cache-ref/>或@CacheNamespace,@CacheNamespaceRef标记使用缓存的Mapper.xml或Mapper接口(同一个namespace,不能同时使用)才会有二级缓存。

如果缓存不为空,说明是存在缓存。如果cache存在,那么会根据sql配置(<insert>,<select>,<update>,<delete>的flushCache属性来确定是否清空缓存。

flushCacheIfRequired(ms);

然后根据xml配置的属性useCache来判断是否使用缓存(resultHandler一般使用的默认值,很少会null)。

if (ms.isUseCache() && resultHandler == null)

确保方法没有Out类型的参数,mybatis不支持存储过程的缓存,所以如果是存储过程,这里就会报错。

private void ensureNoOutParams(MappedStatement ms, Object parameter, BoundSql boundSql) { if (ms.getStatementType() == StatementType.CALLABLE) { for (ParameterMapping parameterMapping : boundSql.getParameterMappings()) { if (parameterMapping.getMode() != ParameterMode.IN) { throw new ExecutorException("Caching stored procedures with OUT params is not supported. Please configure useCache=false in " + ms.getId() + " statement."); } } } }

然后根据在 TransactionalCacheManager 中根据 key 取出缓存,如果没有缓存,就会执行查询,并且将查询结果放到缓存中并返回取出结果,否则就执行真正的查询方法。